405B大模型也能线性化!斯坦福MIT最新研究,0.2%训练量让线性注意力提分20+

405B大模型也能线性化!斯坦福MIT最新研究,0.2%训练量让线性注意力提分20+近日,来自斯坦福、MIT等机构的研究人员推出了低秩线性转换方法,让传统注意力无缝转移到线性注意力,仅需0.2%的参数更新即可恢复精度,405B大模型两天搞定!

来自主题: AI技术研报

6148 点击 2024-11-21 13:47

近日,来自斯坦福、MIT等机构的研究人员推出了低秩线性转换方法,让传统注意力无缝转移到线性注意力,仅需0.2%的参数更新即可恢复精度,405B大模型两天搞定!

Transformers 的二次复杂度和弱长度外推限制了它们扩展到长序列的能力,虽然存在线性注意力和状态空间模型等次二次解决方案

它通过将压缩记忆(compressive memory)整合到线性注意力机制中,用来处理无限长上下文

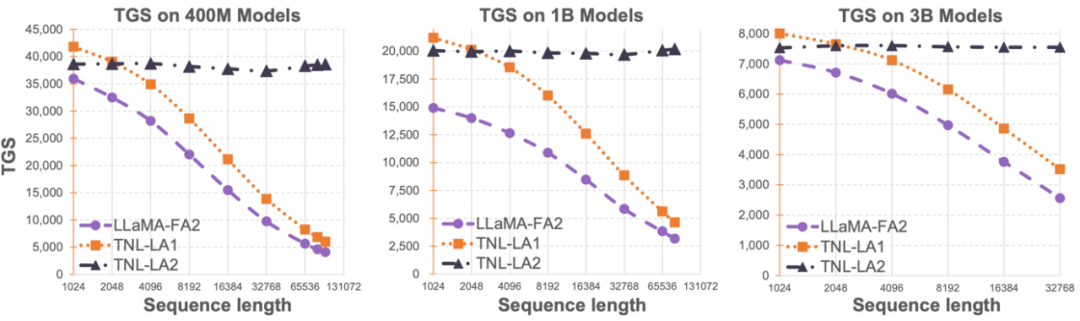

Lightning Attention-2 是一种新型的线性注意力机制,让长序列的训练和推理成本与 1K 序列长度的一致。

来自清华大学的研究者提出了一种新的注意力范式——代理注意力 (Agent Attention)。