我们用世界名画和Meme“拷打”了智谱9B的视觉推理模型,结果出人意料

我们用世界名画和Meme“拷打”了智谱9B的视觉推理模型,结果出人意料2025年上半年,AI开源领域的竞赛异常激烈,主要围绕着几个核心方向展开:首先是效率竞赛,各路玩家不再单纯追求千亿、万亿参数的“巨无霸”模型,而是更专注于通过新架构和训练方法,用更小的参数实现更强的性能。其次,多模态已成标配,纯文本模型越来越少,新发布的旗舰模型几乎都具备了处理图像、视频等多种信息的能力。

2025年上半年,AI开源领域的竞赛异常激烈,主要围绕着几个核心方向展开:首先是效率竞赛,各路玩家不再单纯追求千亿、万亿参数的“巨无霸”模型,而是更专注于通过新架构和训练方法,用更小的参数实现更强的性能。其次,多模态已成标配,纯文本模型越来越少,新发布的旗舰模型几乎都具备了处理图像、视频等多种信息的能力。

如果一个视觉语言模型(VLM)只会“看”,那真的是已经不够看的了。

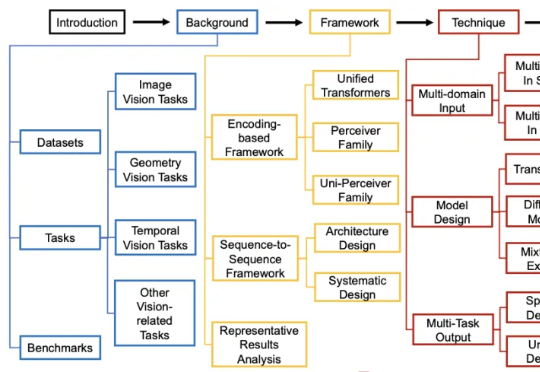

过去几年,通用视觉模型(Vision Generalist Model,简称 VGM)曾是计算机视觉领域的研究热点。

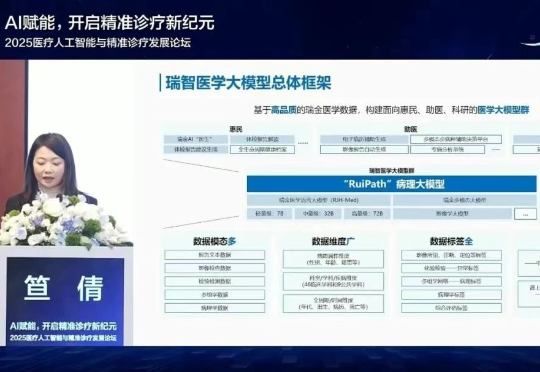

6月30日,上海交通大学医学院附属瑞金医院宣布,RuiPath病理大模型的视觉基础模型正式开源。

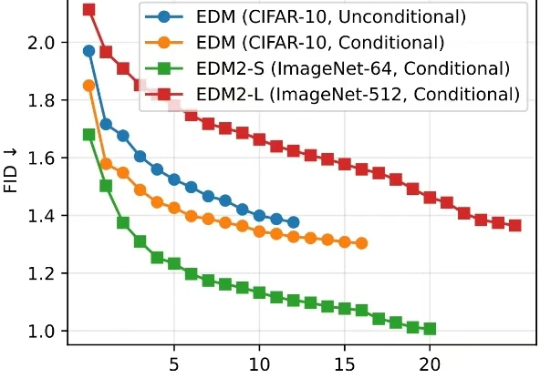

清华大学朱军教授团队与 NVIDIA Deep Imagination 研究组联合提出一种全新的视觉生成模型优化范式 —— 直接判别优化(DDO)。

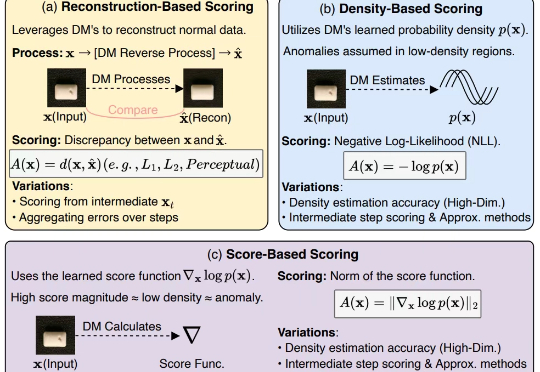

扩散模型(Diffusion Models, DMs)近年来展现出巨大的潜力,在计算机视觉和自然语言处理等诸多任务中取得了显著进展,而异常检测(Anomaly Detection, AD)作为人工智能领域的关键研究任务,在工业制造、金融风控、医疗诊断等众多实际场景中发挥着重要作用。

在日常生活中,我们常通过语言描述寻找特定物体:“穿蓝衬衫的人”“桌子左边的杯子”。如何让 AI 精准理解这类指令并定位目标,一直是计算机视觉的核心挑战。

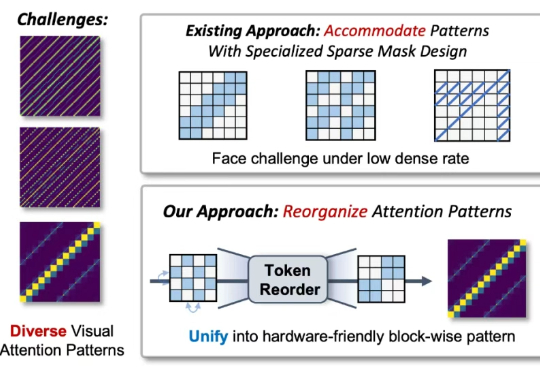

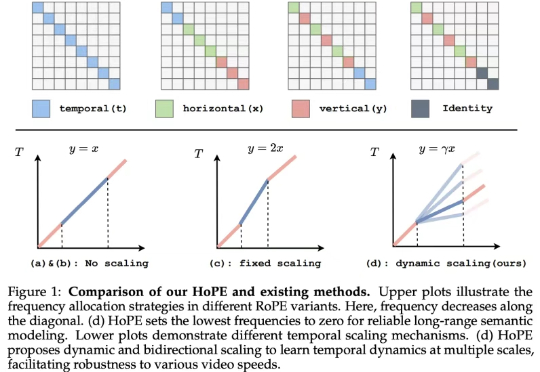

近年来,随着视觉生成模型的发展,视觉生成任务的输入序列长度逐渐增长(高分辨率生成,视频多帧生成,可达到 10K-100K)。

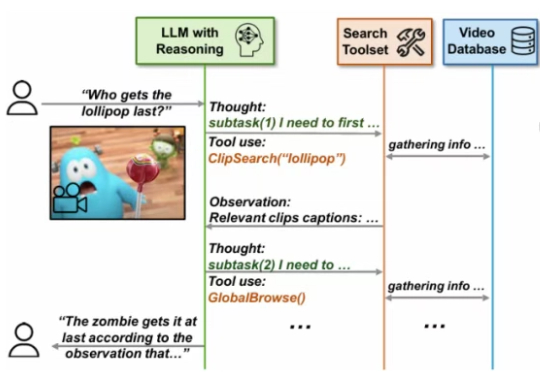

尽管大型语言模型(LLMs)和大型视觉 - 语言模型(VLMs)在视频分析和长语境处理方面取得了显著进展,但它们在处理信息密集的数小时长视频时仍显示出局限性。

如今的视觉语言模型 (VLM, Vision Language Models) 已经在视觉问答、图像描述等多模态任务上取得了卓越的表现。然而,它们在长视频理解和检索等长上下文任务中仍表现不佳。