AI一眼认出95万物种,还能分辨雄雌老幼,2亿生物图像炼成“生命视觉”大模型

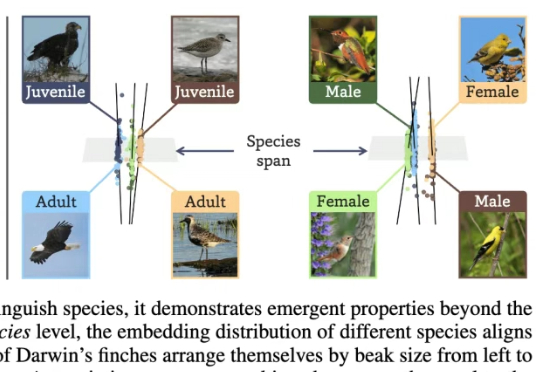

AI一眼认出95万物种,还能分辨雄雌老幼,2亿生物图像炼成“生命视觉”大模型让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。

让AI看懂95万物种,并自己悟出生态关系与个体差异!俄亥俄州立大学研究团队在2亿生物图像数据上训练了BioCLIP 2模型。大规模的训练让BioCLIP 2取得了目前最优的物种识别性能。

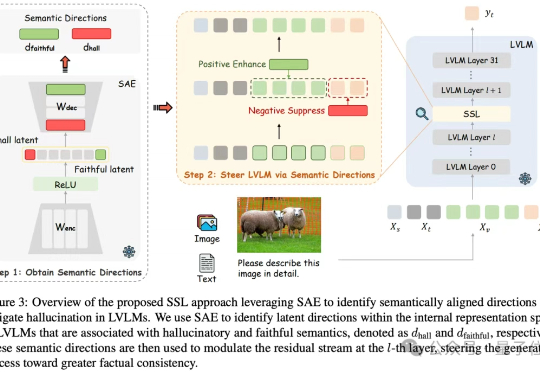

通过“视觉神经增强”机制,直接放大模型中的视觉关键注意力头输出,显著降低模型的幻觉现象。

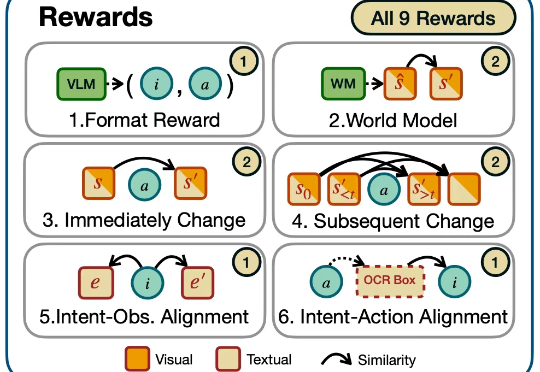

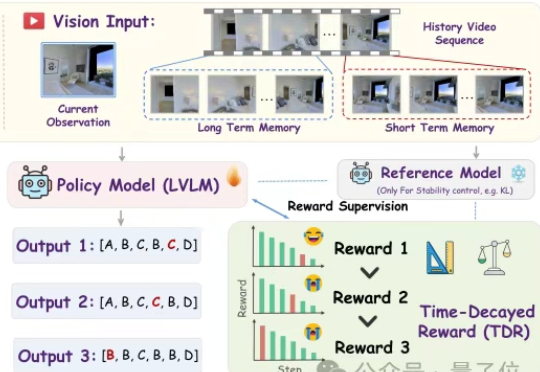

迈向通用人工智能(AGI)的核心目标之一就是打造能在开放世界中自主探索并持续交互的智能体。随着大语言模型(LLMs)和视觉语言模型(VLMs)的飞速发展,智能体已展现出令人瞩目的跨领域任务泛化能力。

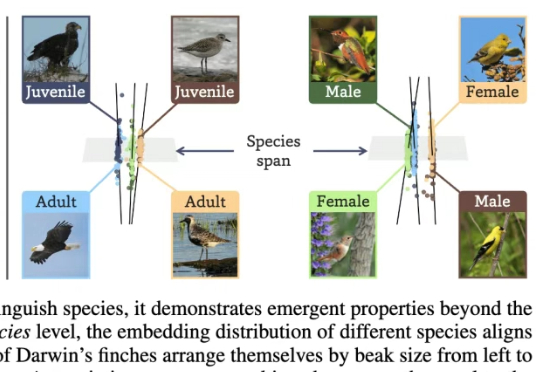

当前大型视觉语言模型(LVLMs)存在物体幻觉问题,即会生成图像中不存在的物体描述。

![Black Forest震撼开源FLUX.1 Kontext [dev]:媲美GPT-4o的图像编辑](https://www.aitntnews.com/pictures/2025/6/27/49d75709-5310-11f0-82be-fa163e47d677.jpg)

前段时间,沉寂了很久的Flux官方团队Black Forest Labs发布了新模型:FLUX.1 Kontext,这是一套支持生成与编辑图像的流匹配(flow matching)模型。FLUX.1 Kontext不仅支持文生图,还实现了上下文图像生成功能,可以同时使用文本和图像作为提示词,并能无缝提取修改视觉元素,生成全新且协调一致的画面。

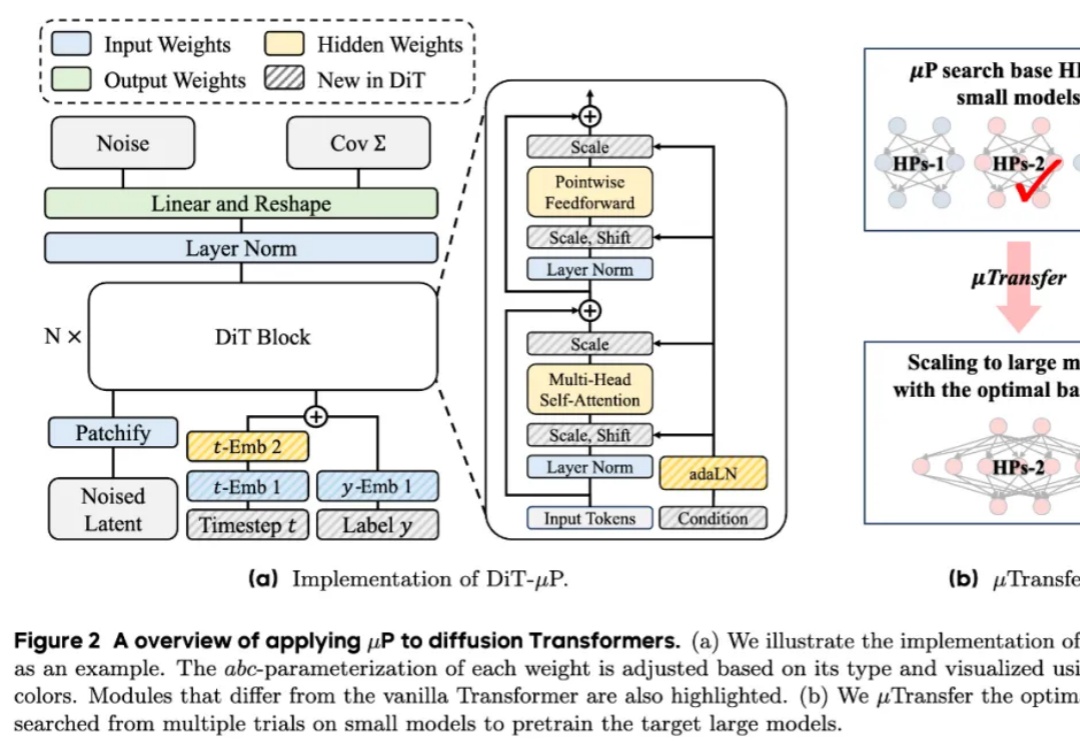

近年来,diffusion Transformers已经成为了现代视觉生成模型的主干网络。随着数据量和任务复杂度的进一步增加,diffusion Transformers的规模也在快速增长。然而在模型进一步扩大的过程中,如何调得较好的超参(如学习率)已经成为了一个巨大的问题,阻碍了大规模diffusion Transformers释放其全部的潜能。

梵高、蒙娜丽莎、维纳斯、毕加索、草间弥生……这些世界名画的主角和画家们忽然复活,穿上时装走上T台,这个AI视频,已经全网刷爆了!视觉盛宴,泪点拉满,这场穿越时空的艺术秀,让全网震撼。

不用提前熟悉环境,一声令下,就能让宇树机器人坐在椅子上、桌子上、箱子上!

你对着家里的机器人说:“去厨房,看看冰箱里还有没有牛奶。”

今天,Gemini 家族迎来了一个新成员:Gemini Robotics On-Device。这是谷歌 DeepMind 首个可以直接部署在机器人上的视觉-语言-动作(VLA)模型,可以帮助机器人更快、更高效地适应新任务和环境,同时无需持续的互联网连接。