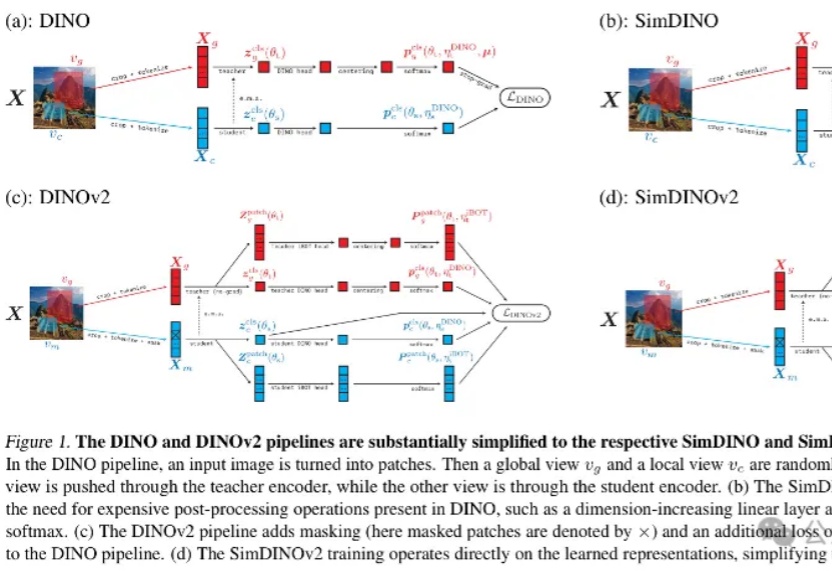

港大马毅团队等开源新作:用编码率正则化重构视觉自监督学习范式,“少即是多”

港大马毅团队等开源新作:用编码率正则化重构视觉自监督学习范式,“少即是多”最新开源的视觉预训练方法,马毅团队、微软研究院、UC伯克利等联合出品!

最新开源的视觉预训练方法,马毅团队、微软研究院、UC伯克利等联合出品!

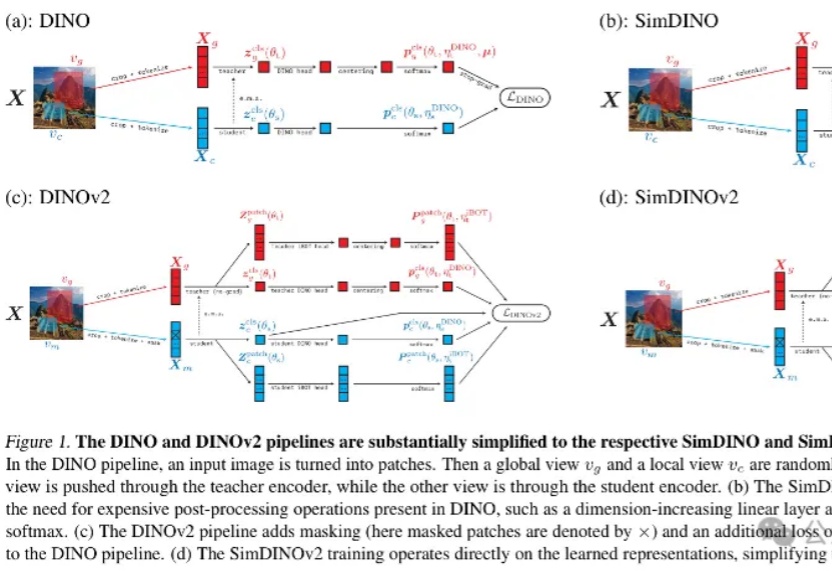

CVPR 2025,混合新架构MambaVision来了!Mamba+Transformer混合架构专门为CV应用设计。MambaVision 在Top-1精度和图像吞吐量方面实现了新的SOTA,显著超越了基于Transformer和Mamba的模型。

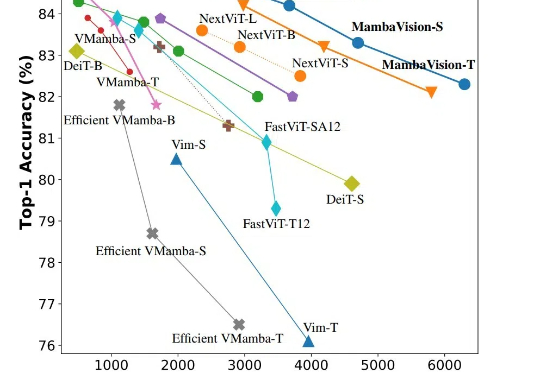

由UCLA等机构共同组建的研究团队,全球首次在20亿参数非SFT模型上,成功实现了多模态推理的DeepSeek-R1「啊哈时刻」!就在刚刚,我们在未经监督微调的2B模型上,见证了基于DeepSeek-R1-Zero方法的视觉推理「啊哈时刻」!

硅星人独家获悉,AI视频生成领域独角兽企业爱诗科技完成 A5 轮融资,本轮由靖亚资本独家投资,至此爱诗科技 A 轮融资整体规模已超4亿人民币。爱诗科技成立于2023年4月,公司创始人兼CEO王长虎在计算机视觉和AI领域有20年从业经验,他曾任微软亚洲研究院主管研究员,之后担任字节跳动视觉技术负责人期间,参与了抖音和TikTok等产品从0到1的过程。

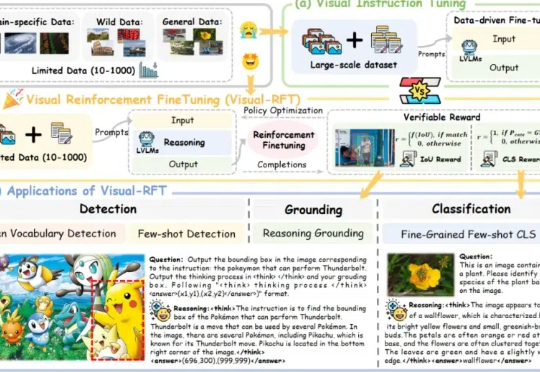

通过针对视觉的细分类、目标检测等任务设计对应的规则奖励,Visual-RFT 打破了 DeepSeek-R1 方法局限于文本、数学推理、代码等少数领域的认知,为视觉语言模型的训练开辟了全新路径!

据众擎机器人介绍,众擎机器人SE01自主研发的“动态重心补偿算法”以每秒1000次的姿态微调对抗前倾失控风险;仿生肌肉驱动系统使关节瞬时扭矩高达330N·m;而毫米波雷达与视觉融合感知系统则将落地误差控制在±2cm内。

近年来大语言模型(LLM)的迅猛发展正推动人工智能迈向多模态融合的新纪元。然而,现有主流多模态大模型(MLLM)依赖复杂的外部视觉模块(如 CLIP 或扩散模型),导致系统臃肿、扩展受限,成为跨模态智能进化的核心瓶颈。

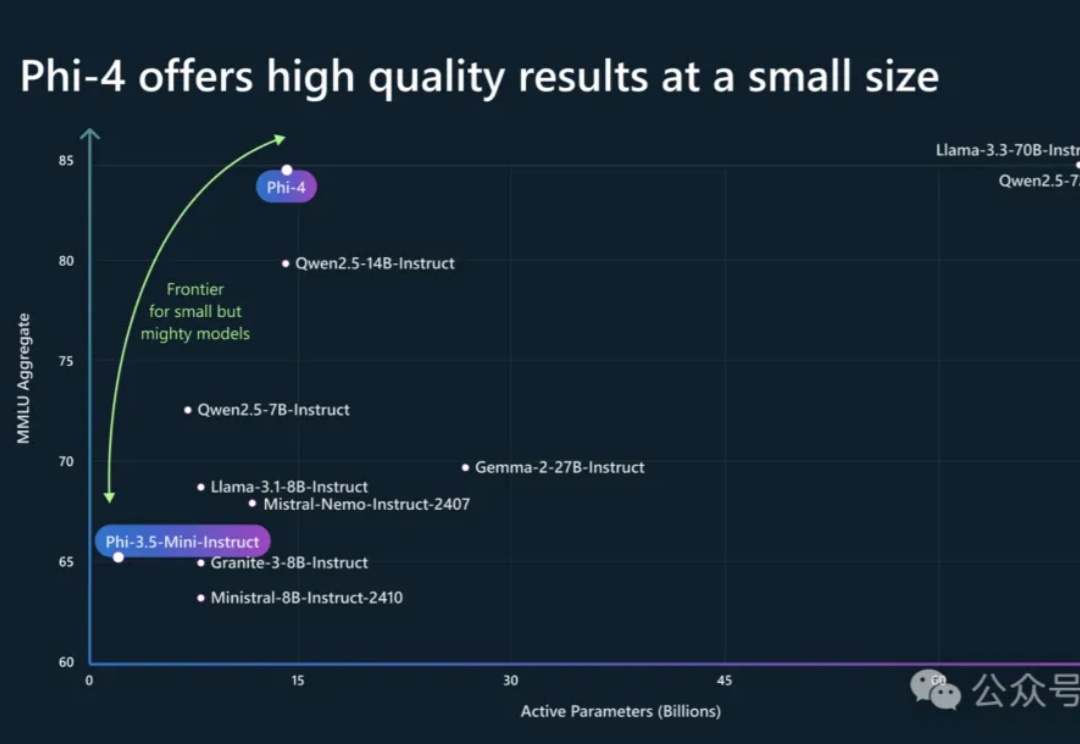

Phi-4系列模型上新了!56亿参数Phi-4-multimodal集语音、视觉、文本多模态于一体,读图推理性能碾压GPT-4o;另一款38亿参数Phi-4-mini在推理、数学、编程等任务中超越了参数更大的LLM,支持128K token上下文。

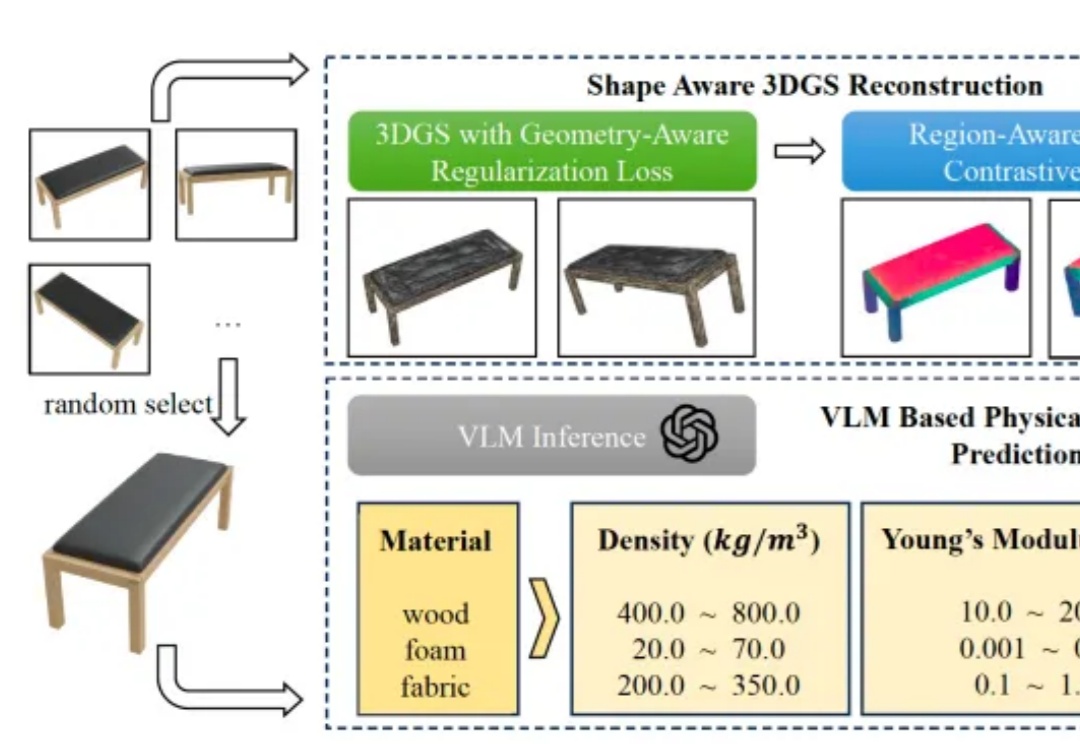

理解物体的物理属性,对机器人执行操作十分重要,但是应该如何实现呢?

OpenAI o1视觉能力还是最强,模型们普遍“过于自信”!