3D版Canva获200万美元,开启AI视觉搜索

3D版Canva获200万美元,开启AI视觉搜索MattoBoard,一家旨在简化室内设计师和建筑师创作过程的云端软件,正在进入人工智能领域。周二,这家初创公司宣布完成 200 万美元的种子融资,将支持推出一项名为 Design Stream 的新功能,这是一款基于人工智能的视觉搜索和发现工具。

MattoBoard,一家旨在简化室内设计师和建筑师创作过程的云端软件,正在进入人工智能领域。周二,这家初创公司宣布完成 200 万美元的种子融资,将支持推出一项名为 Design Stream 的新功能,这是一款基于人工智能的视觉搜索和发现工具。

IEEE/CVF国际计算机视觉与模式识别会议(CVPR)是人工智能领域最具学术影响力的顶级会议之一,将于今年 6月11日至6月15日在美国田纳西州举行。

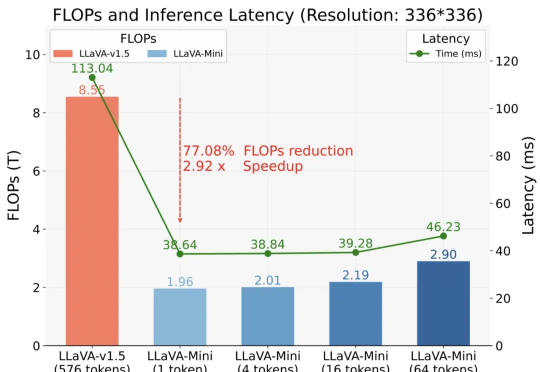

以 GPT-4o 为代表的实时交互多模态大模型(LMMs)引发了研究者对高效 LMM 的广泛关注。现有主流模型通过将视觉输入转化为大量视觉 tokens,并将其嵌入大语言模型(LLM)上下文来实现视觉信息理解。

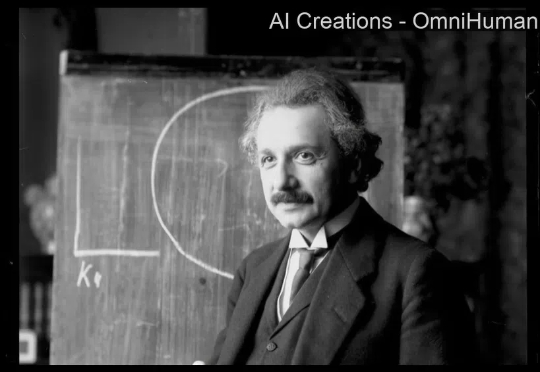

还记得半年前在 X 上引起热议的肖像音频驱动技术 Loopy 吗?升级版技术方案来了,字节跳动数字人团队推出了新的多模态数字人方案 OmniHuman, 其可以对任意尺寸和人物占比的单张图片结合一段输入的音频进行视频生成,生成的人物视频效果生动,具有非常高的自然度。

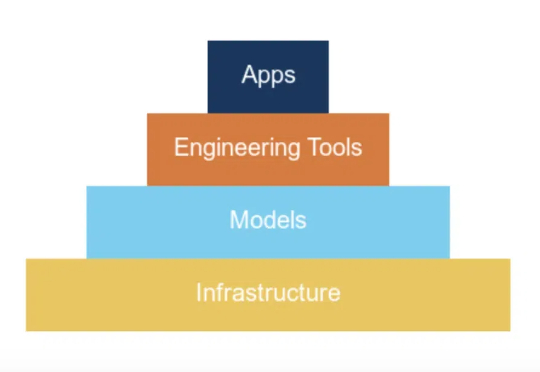

Ilya Sutskever 在 NeurIPS 会上直言:大模型预训练这条路可能已经走到头了。上周的 CES 2025,黄仁勋有提到,在英伟达看来,Scaling Laws 仍在继续,所有新 RTX 显卡都在遵循三个新的扩展维度:预训练、后训练和测试时间(推理),提供了更佳的实时视觉效果。

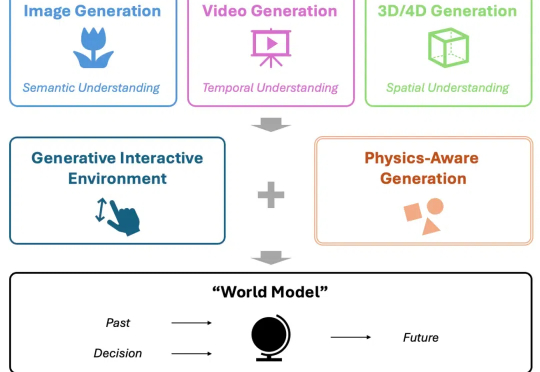

当下,视频生成备受关注,有望成为处理物理知识的 “世界模型” (World Model),助力自动驾驶、机器人等下游任务。然而,当前模型在从 “生成” 迈向世界建模的过程中,存在关键短板 —— 对真实世界物理规律的刻画能力不足。

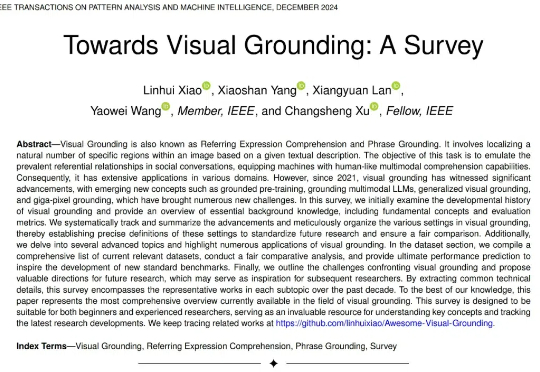

27 页综述,354 篇参考文献!史上最详尽的视觉定位综述,内容覆盖过去十年的视觉定位发展总结,尤其对最近 5 年的视觉定位论文系统性回顾,内容既涵盖传统基于检测器的视觉定位,基于 VLP 的视觉定位,基于 MLLM 的视觉定位,也涵盖从全监督、无监督、弱监督、半监督、零样本、广义定位等新型设置下的视觉定位。

现在,豆包大模型团队联合北京交通大学、中国科学技术大学提出了VideoWorld。

VARGPT是一种新型多模态大模型,能够在单一框架内实现视觉理解和生成任务。通过预测下一个token完成视觉理解,预测下一个scale完成视觉生成,展现出强大的混合模态输入输出能力。

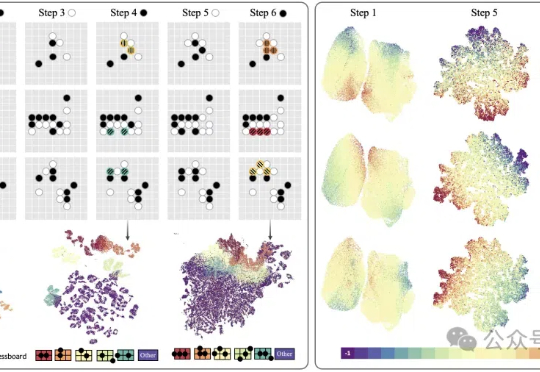

视觉版o1的初步探索,阶跃星辰&北航团队推出“慢感知”。研究人员认为:1)目前多模领域o1-like的模型,主要关注文本推理,对视觉感知的关注不够。2)精细/深度感知是一个复杂任务,且是未来做视觉推理的重要基础。