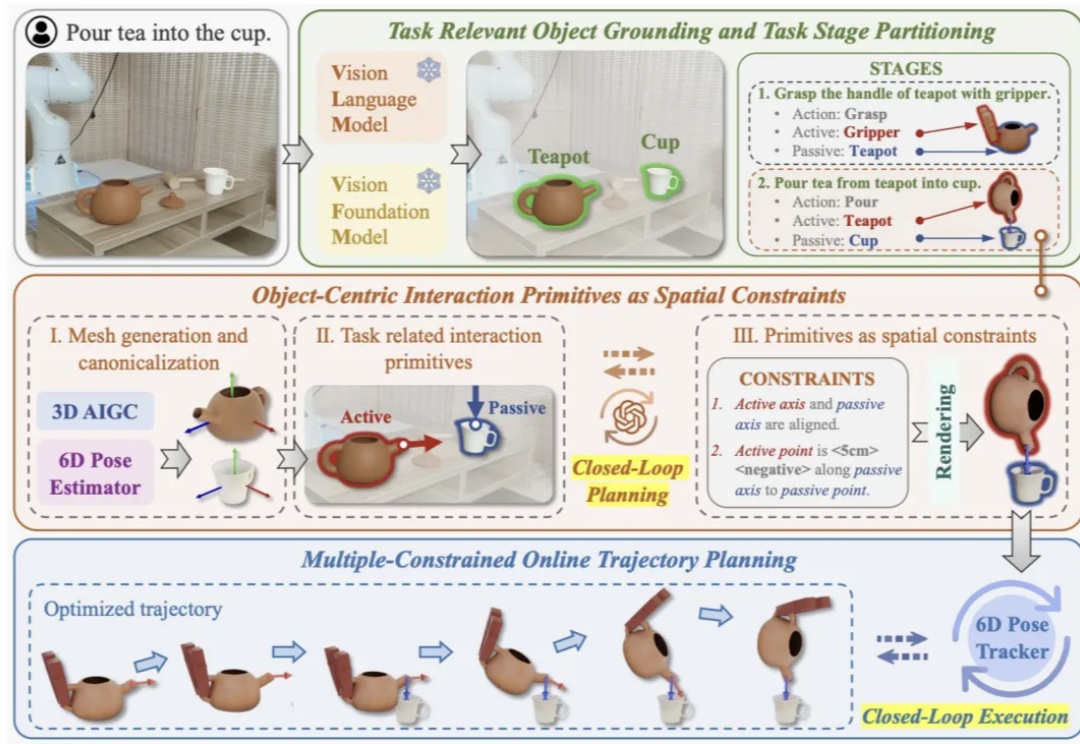

化解机器人的「幻觉」:北大发布OmniManip,VLM结合双闭环系统,3D理解能力大幅提升

化解机器人的「幻觉」:北大发布OmniManip,VLM结合双闭环系统,3D理解能力大幅提升近年来视觉语⾔基础模型(Vision Language Models, VLMs)在多模态理解和⾼层次常识推理上⼤放异彩,如何将其应⽤于机器⼈以实现通⽤操作是具身智能领域的⼀个核⼼问题。这⼀⽬标的实现受两⼤关键挑战制约:

近年来视觉语⾔基础模型(Vision Language Models, VLMs)在多模态理解和⾼层次常识推理上⼤放异彩,如何将其应⽤于机器⼈以实现通⽤操作是具身智能领域的⼀个核⼼问题。这⼀⽬标的实现受两⼤关键挑战制约:

能说会看,还响应快、记性好、算得准——如此完美的AI,ta来了!商汤科技日日新融合大模型交互版(SenseNova-5o),今天正式对外提供实时音视频对话服务,限时免费使用。它是商汤“日日新”融合大模型的交互版本,拥有强大的实时交互、视觉识别、记忆思考、持续对话和复杂推理等能力,能帮助AI与人类更自然、更流畅地交流,让每次互动更加智能与贴心,帮助用户全面提升生活与工作体验。

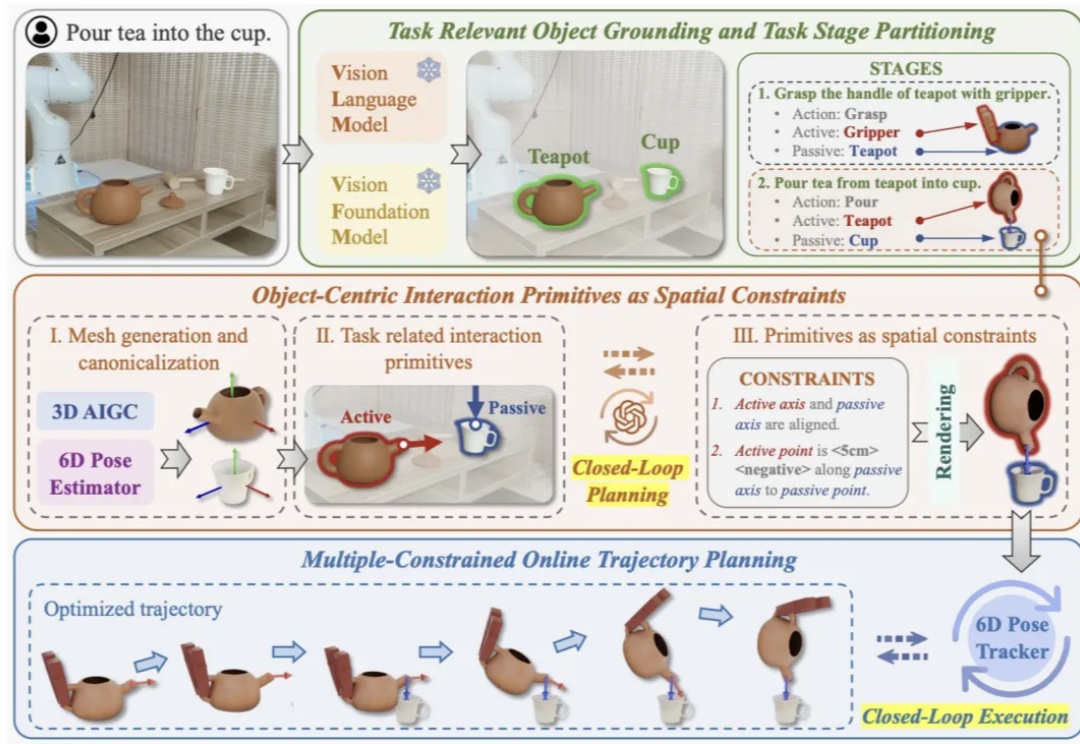

近年来,视觉大模型(Large Vision Language Models, LVLMs)领域经历了迅猛的发展,这些模型在图像理解、视觉对话以及其他跨模态任务中展现出了卓越的能力。然而,随着 LVLMs 复杂性和能力的增长,「幻觉现象」的挑战也日益凸显。

Fermata是一家专门从事农业计算机视觉解决方案的数据科学公司,在Raw Ventures支持的A轮融资中获得了1000万美元。这项投资将支持该公司为农业行业开发集中式数字大脑的战略愿景,通过先进的数据分析实现作物的自主管理,创建一个不断发展的系统,不断从可用数据中学习。

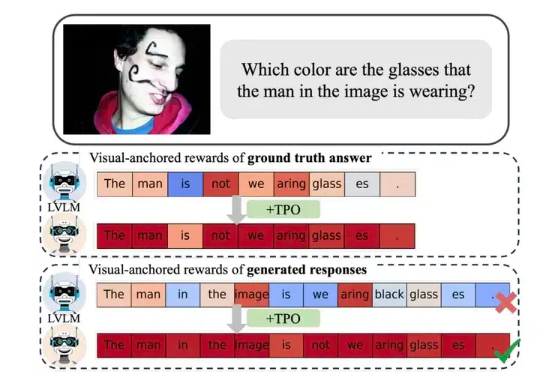

模型安全和可靠性、系统整合和互操作性、用户交互和认证…… 当“多模态”“跨模态”成为不可阻挡的AI趋势时,多模态场景下的安全挑战尤其应当引发产学研各界的注意。

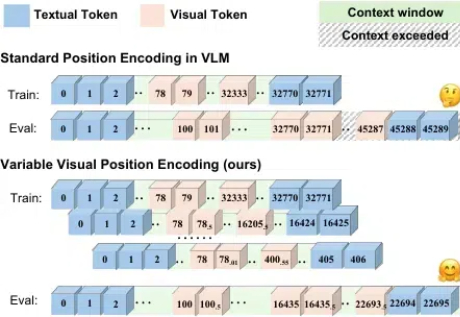

开源模型上下文窗口卷到超长,达400万token! 刚刚,“大模型六小强”之一MiniMax开源最新模型—— MiniMax-01系列,包含两个模型:基础语言模型MiniMax-Text-01、视觉多模态模型MiniMax-VL-01。

随着语言大模型的成功,视觉 - 语言多模态大模型 (Vision-Language Multimodal Models, 简写为 VLMs) 发展迅速,但在长上下文场景下表现却不尽如人意,这一问题严重制约了多模态模型在实际应用中的潜力。

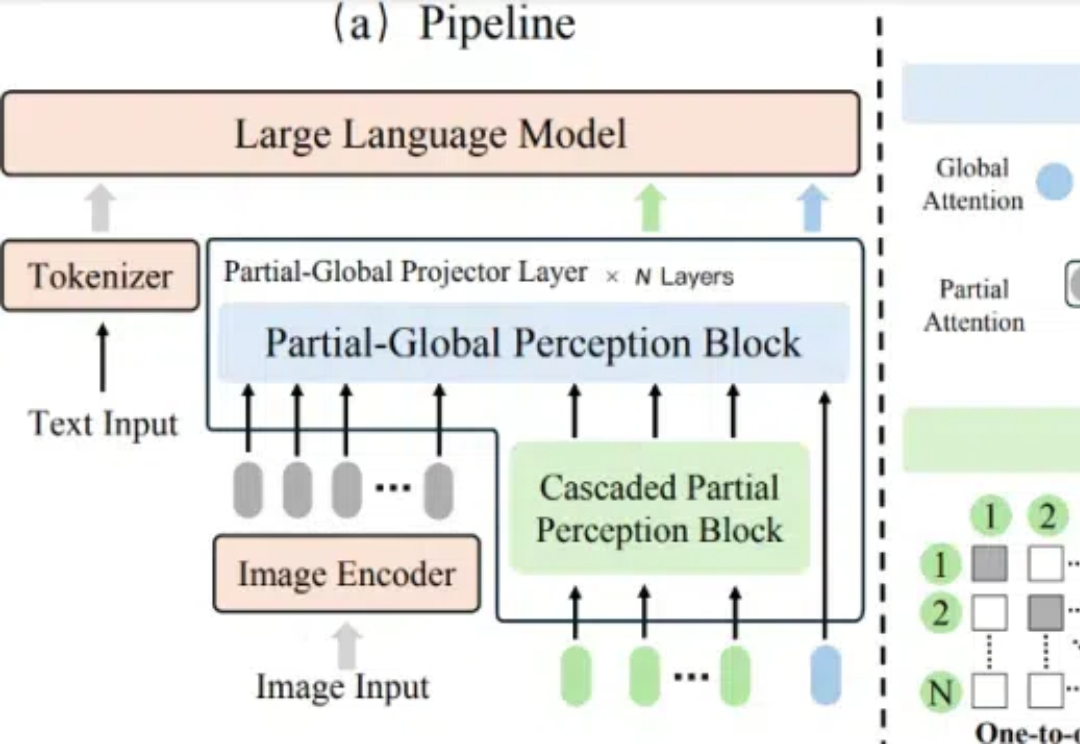

在多模态大语言模型(MLLMs)的发展中,视觉 - 语言连接器作为将视觉特征映射到 LLM 语言空间的关键组件,起到了桥梁作用。

HyperAI超神经与上海交大谢伟迪教授进行了一次深度访谈,从其个人经历出发,他向我们分享了从计算机视觉转型 AI for Healthcare 的经验心得,同时深入剖析了该行业的未来发展趋势。

Aria-UI通过纯视觉理解,实现了GUI指令的精准定位,无需依赖后台数据,简化了部署流程;在AndroidWorld和OSWorld等权威基准测试中表现出色,分别获得第一名和第三名,展示了强大的跨平台自动化能力。