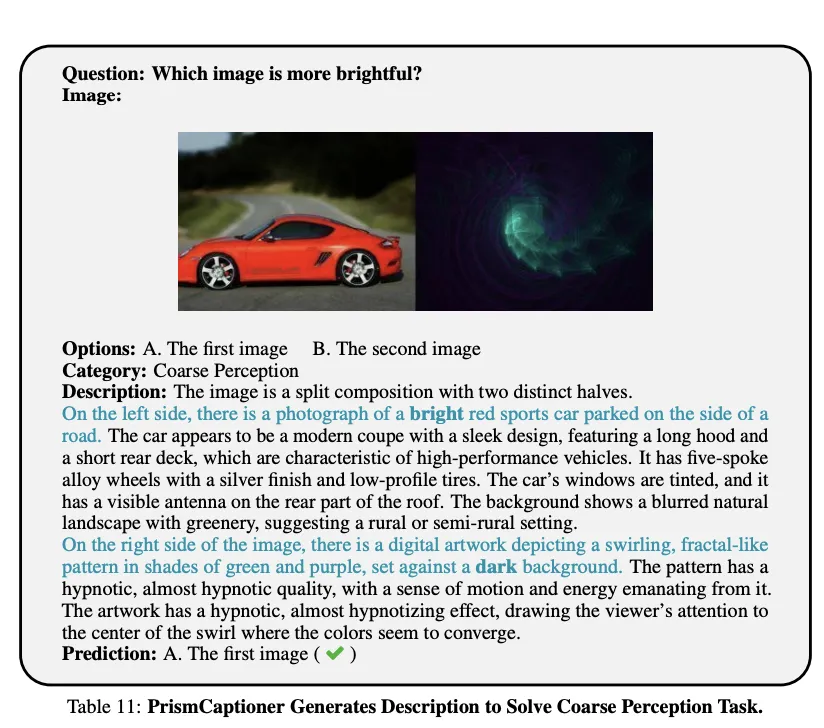

豆包大模型团队发布全新Detail Image Caption评估基准,提升VLM Caption评测可靠性

豆包大模型团队发布全新Detail Image Caption评估基准,提升VLM Caption评测可靠性当前的视觉语言模型(VLM)主要通过 QA 问答形式进行性能评测,而缺乏对模型基础理解能力的评测,例如 detail image caption 性能的可靠评测手段。

当前的视觉语言模型(VLM)主要通过 QA 问答形式进行性能评测,而缺乏对模型基础理解能力的评测,例如 detail image caption 性能的可靠评测手段。

文生图、文生视频,视觉生成赛道火热,但仍存在亟需解决的问题。

近年来,人物动作生成的研究取得了显著的进展,在众多领域,如计算机视觉、计算机图形学、机器人技术以及人机交互等方面获得广泛的关注。然而,现有工作大多只关注动作本身,以场景和动作类别同时作为约束条件的研究依然处于起步阶段。

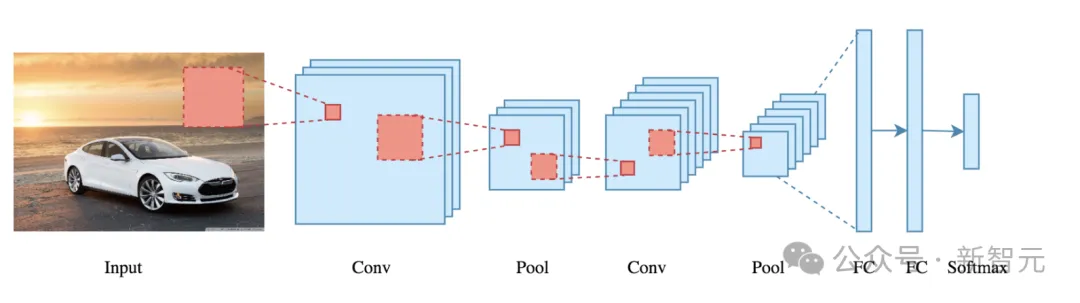

下一代视觉模型会摒弃patch吗?Meta AI最近发表的一篇论文就质疑了视觉模型中局部关系的必要性。他们提出了PiT架构,让Transformer直接学习单个像素而不是16×16的patch,结果在多个下游任务中取得了全面超越ViT模型的性能。

今日,Odyssey视觉AI发布预告,这款获得GV 900万美元种子资金的创新技术,旨在用AI技术讲好电影故事。具备强大的视觉内容生成与控制能力,视觉效果对标好莱坞制作水平。

好莱坞级视觉AI横空出世!一个demo已令网友疯狂~

只要把推理和感知能力拆分,2B大模型就能战胜20B?!

人工智能(AI)在过去十年里取得了长足进步,特别是在自然语言处理和计算机视觉领域。然而,如何提升 AI 的认知能力和推理能力,仍然是一个巨大的挑战。

近日,LeCun和谢赛宁等大佬,共同提出了这一种全新的SOTA MLLM——Cambrian-1。开创了以视觉为中心的方法来设计多模态模型,同时全面开源了模型权重、代码、数据集,以及详细的指令微调和评估方法。

当前的多模态和多任务基础模型,如 4M 或 UnifiedIO,显示出有希望的结果。然而,它们接受不同输入和执行不同任务的开箱即用能力,受到它们接受训练的模态和任务的数量(通常很少)的限制。