GPT-4V开源平替!清华浙大领衔,LLaVA、CogAgent等开源视觉模型大爆发

GPT-4V开源平替!清华浙大领衔,LLaVA、CogAgent等开源视觉模型大爆发GPT-4V的开源替代方案来了!极低成本,性能却类似,清华、浙大等中国顶尖学府,为我们提供了性能优异的GPT-4V开源平替。

GPT-4V的开源替代方案来了!极低成本,性能却类似,清华、浙大等中国顶尖学府,为我们提供了性能优异的GPT-4V开源平替。

首个视觉、语言、音频和动作多模态模型Unified-IO 2来了!它能够完成多种多模态的任务,在超过30个基准测试中展现出了卓越性能。

在Gemini开放API不到一周的时间,港中文等机构就完成评测,联合发布了多达128页的报告,结果显示:在37个视觉理解任务上,Gemini-Pro表现出了和GPT-4V相当的能力。

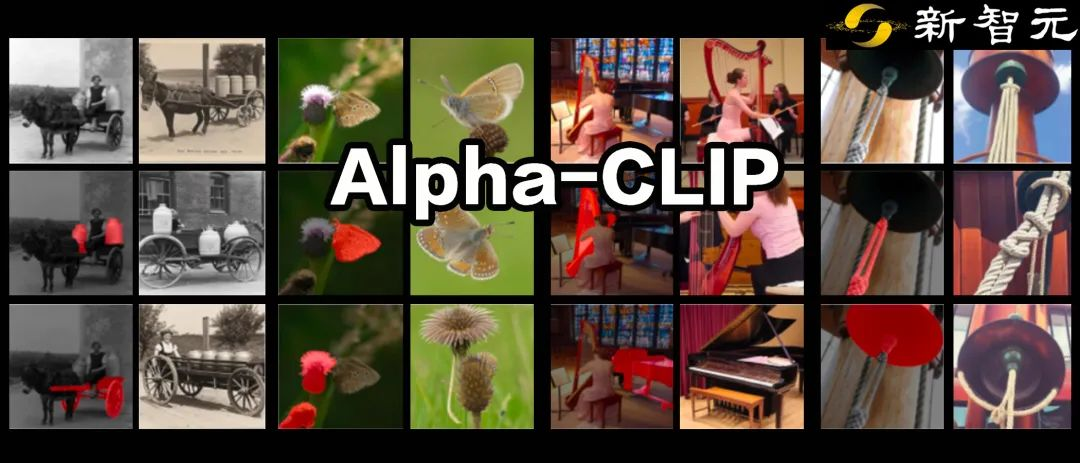

本文介绍了一个名为Alph-CLIP的框架,它在原始的接受RGB三通道输入的CLIP模型的上额外增加了一个alpha通道。在千万量级的RGBA-region的图像文本对上进行训练后,Alpha-CLIP可以在保证CLIP原始感知能力的前提下,关注到任意指定区域。通过替换原始CLIP的应用场景,Alpha-CLIP在图像识别、视觉-语言大模型、2D乃至3D生成领域都展现出强大作用。

喂给大模型语料——最初是维基百科和Reddit,后来扩展到音频、视觉图像甚至雷达和热图像——后者广义上说是换了种表达方式的语言。也因此有生成式AI的创业者认为,一个极度聪明的大语言模型就是那个通往AGI最终答案,多模态的研究道路只是目前对前者的底气不足。

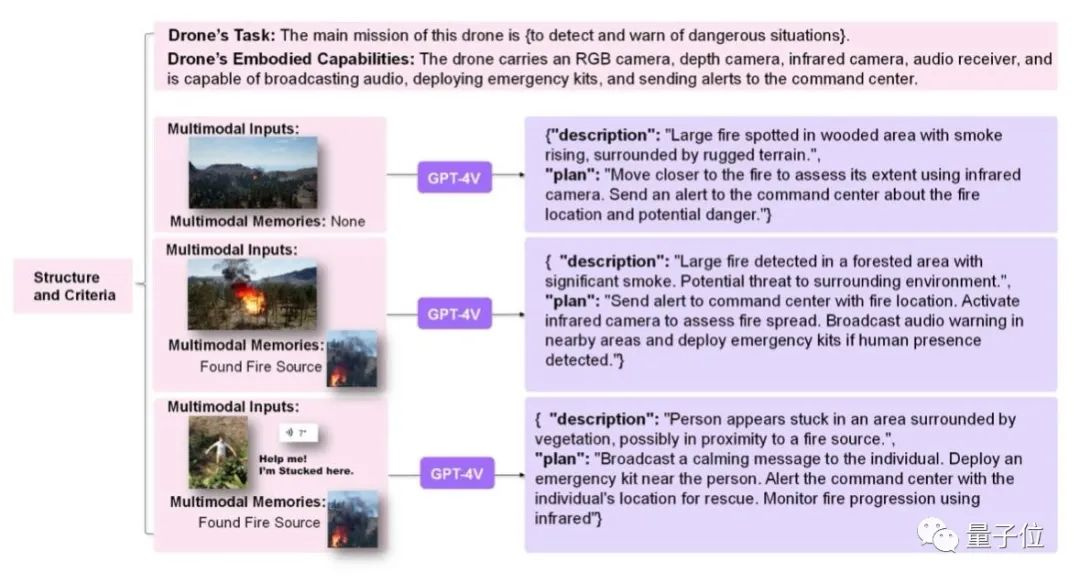

进入多模态时代,大模型也会操纵无人机了!只要视觉模块捕捉到启动条件,大模型这个“大脑”就会生成动作指令,接着无人机便能迅速准确地执行。

由厦门大学等机构提出的全新视觉感知基础模型APE,只需一个模型外加一套参数,就能在160个测试集上取得当前SOTA或极具竞争力的结果。而且训练和推理代码以及模型权重全部开源,无需微调,开箱即用。

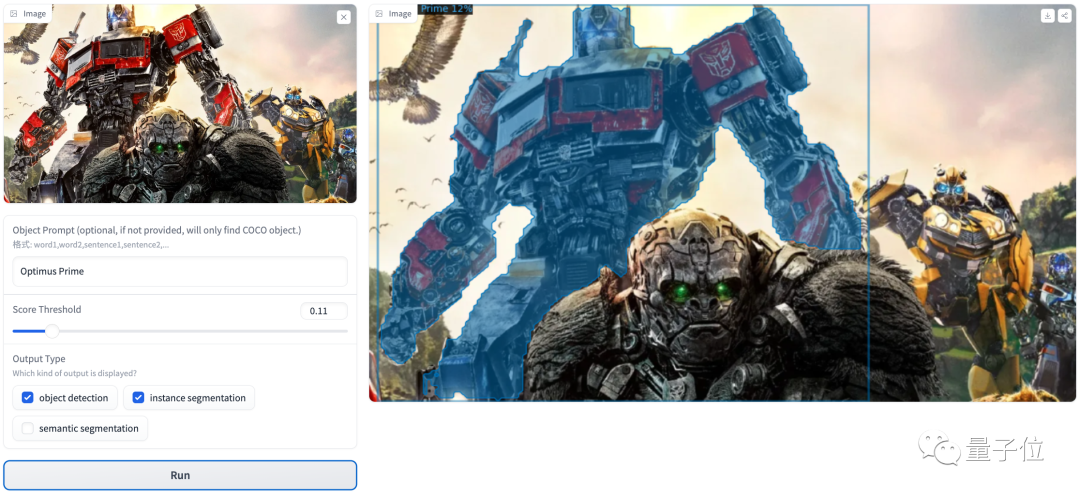

用多模态大模型来做语义分割,效果有多好?一张图+文字输入想分割的物体,大模型几秒钟就能识别并搞定!

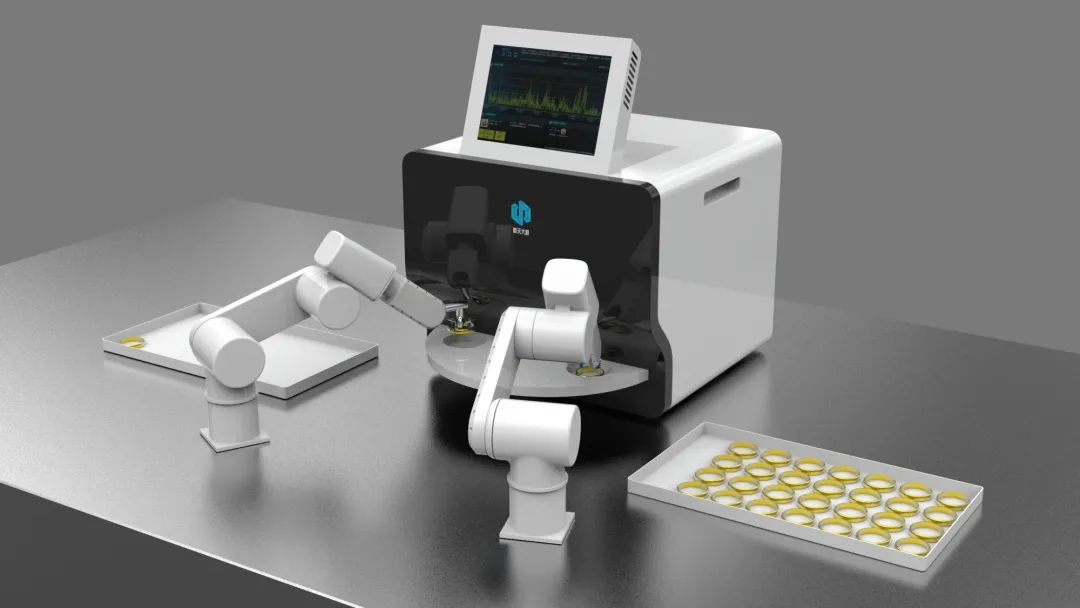

传统机器视觉玩家正补全算法和智能化能力,而AI质检新势力们则继续向标准化软硬件方向拓展。工业质检的市场格局正在发生变化。

12月5-6日,主题为“未来AI设计”的美图创造力大会在厦门举行。美图公司发布自研AI视觉大模型MiracleVision(奇想智能)4.0版本,主打AI设计与AI视频。