Day0迁移、一键部署,华为开源的昇思MindSpore成为大模型开发的“万能钥匙”

Day0迁移、一键部署,华为开源的昇思MindSpore成为大模型开发的“万能钥匙”没有一个大模型可以一统天下。 这,或许已经成为了AI大模型时代行业里的一个共识。

没有一个大模型可以一统天下。 这,或许已经成为了AI大模型时代行业里的一个共识。

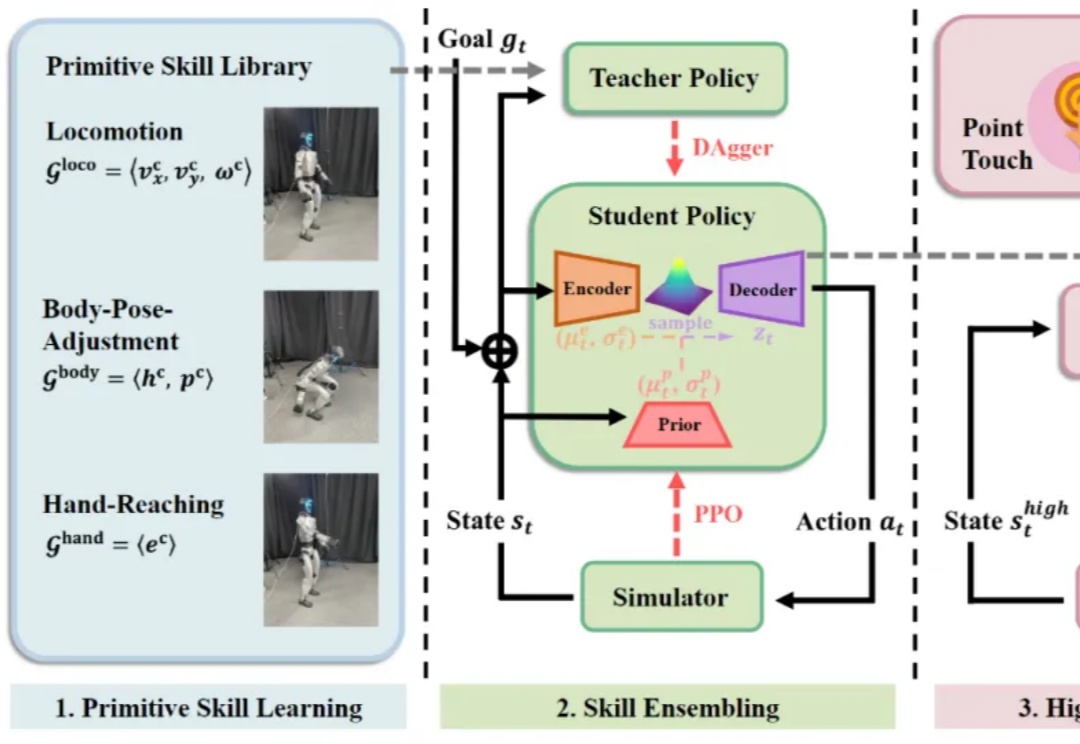

大数据和大模型已成为具身智能领域业界和学术界的焦点,人们也在期待人形机器人真正步入大数据、大模型时代。然而,行业一直缺乏稳定的人形机器人全身遥操作与数据采集方案。

2025年5月,美国数字健康企业 Akido Labs 宣布完成6000万美元B轮融资,由 McKesson Ventures 和 Polaris Partners 联合领投,老股东 Andreessen Horowitz(a16z)与 SVB Capital 跟投。融资所得将主要用于扩大其核心平台 ScopeAI 的部署,尤其是在医疗资源匮乏的社区加速落地。

Hi,我是银海。 你身边的AI产品经理,陪你解决每一个真实问题。

多AI智能体系统的复杂构建与优化,长期以来是用智能体解决科研问题和场景落地的瓶颈。来自英国格拉斯哥大学的研究团队发布了全球首个AI智能体自进化开源框架EvoAgentX,通过引入自我进化机制,打破了传统多智能体系统在构建和优化中的限制!

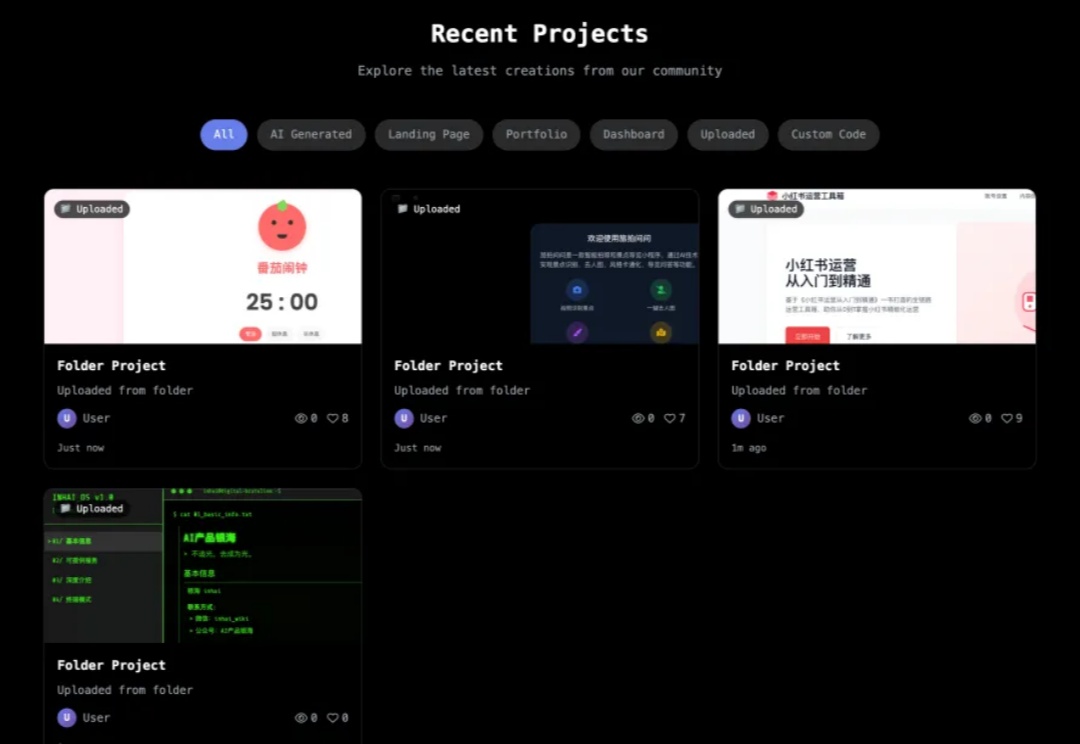

上周,有媒体曝出了美团的 AI 零代码工具 NoCode,这是一款无需编程背景和经验,仅通过自然语言和对话形式即可快速生成应用的工具。 顾名思义,NoCode 可帮助很多人以「零代码」的方式创建个人提效工具、产品原型、可交互页面等。它不仅能生成代码,还可以进行实时预览,局部修改并一键部署,大幅降低了开发的门槛,可以帮助更多人释放创意。

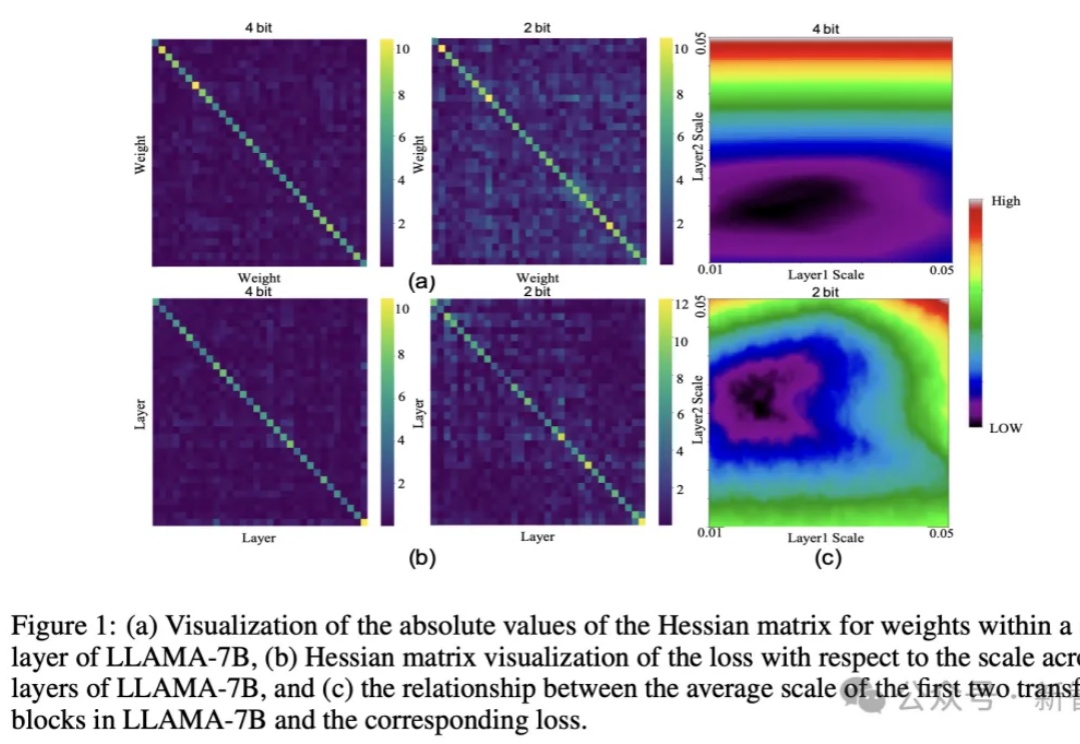

大模型巨无霸体量,让端侧部署望而却步?华为联手中科大提出CBQ新方案,仅用0.1%的训练数据实现7倍压缩率,保留99%精度。

部署超大规模MoE这件事,国产芯片的推理性能,已经再创新高了—— 不仅是“英伟达含量为0”这么简单,更是性能全面超越英伟达Hopper架构!

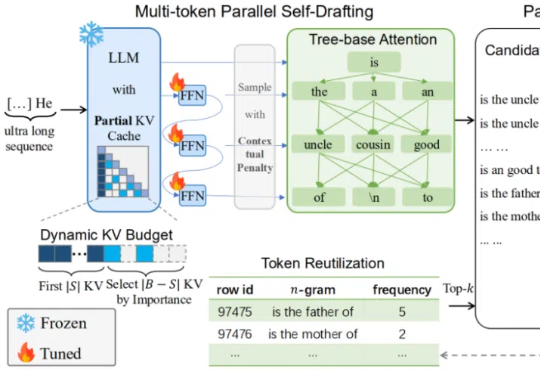

在当前大模型推理愈发复杂的时代,如何快速、高效地产生超长文本,成为了模型部署与优化中的一大核心挑战。

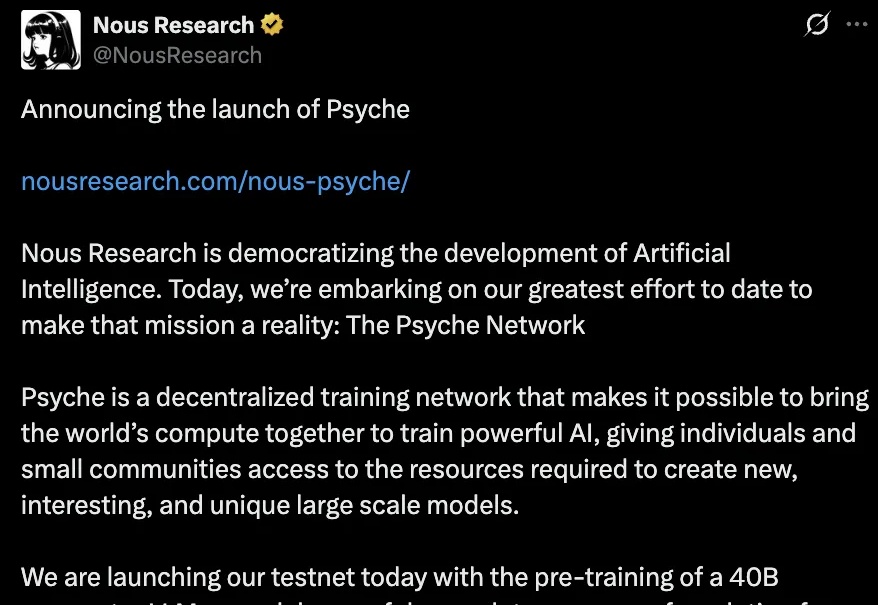

打破科技巨头算力垄断,个人开发者联手也能训练超大规模AI模型?