国内排名前100的顶级医院,都在自研什么大模型?

国内排名前100的顶级医院,都在自研什么大模型?医疗大模型快速渗透医院,2025年百强医院部署率达98%,专科垂直模型达55个,面临数据安全挑战。

医疗大模型快速渗透医院,2025年百强医院部署率达98%,专科垂直模型达55个,面临数据安全挑战。

E2B 的愿景很大,CEO 的目标是成为 AI Agent 时代的 AWS,成为一个自动化的 infra 平台,未来可以提供 GPU 支持,满足更复杂的数据分析、小模型训练、游戏生成等需求,并可以托管 agent 构建的应用,覆盖 agent 从开发到部署的完整生命周期。

今年3月,DeepSeek迅速席卷全国医疗机构。据不完全统计,短短一个月内全国已经有 超300家 医院完成DeepSeek的本地部署,遍布北京、上海、安徽、四川、广东、河北、湖南、江苏等二十多个省市和自治区。

过去一年,AI 领域在开源力量的推动下呈现爆发式增长。大模型不再是少数巨头专属的技术高地,而是在社区协作与开放共享中不断演化,覆盖基础架构、算法优化、推理部署等多个层面。开源,让 AI 更快、更平、更广,也让越来越多的开发者、研究者、创业者拥有了参与下一代智能系统构建的机会。

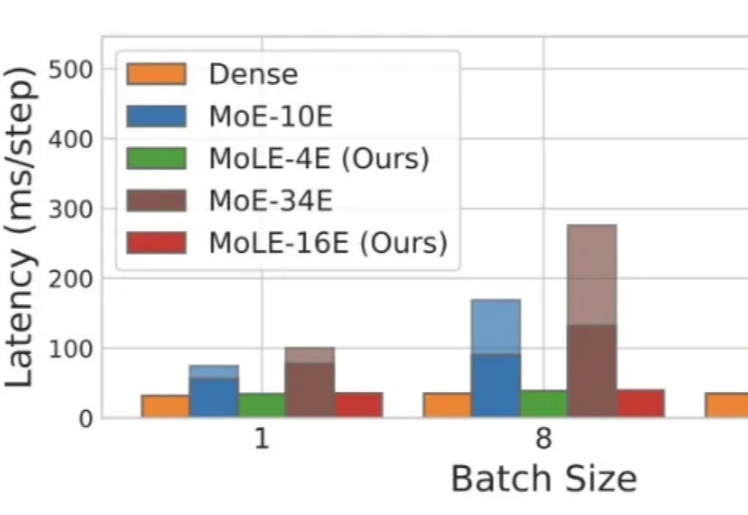

Mixture-of-Experts(MoE)在推理时仅激活每个 token 所需的一小部分专家,凭借其稀疏激活的特点,已成为当前 LLM 中的主流架构。然而,MoE 虽然显著降低了推理时的计算量,但整体参数规模依然大于同等性能的 Dense 模型,因此在显存资源极为受限的端侧部署场景中,仍然面临较大挑战。

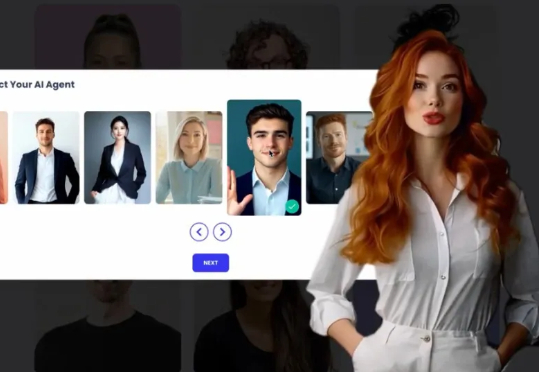

近日,以色列宣布与以色列AI“数字化身”制作平台eSelf、以色列最大的K12教科书出版商CET(Center for Educational Technology)合作,在全国范围内铺开AI辅导。

那有没有那种把需求分析、代码生成、测试、部署、安装包、源代码、甚至连计算机软著申请材料都包圆的报恩级平台呢?还真有,码上飞(CodeFlying)全量上线,开发全流程都用中文交互,我可以选择不看、不接触代码。

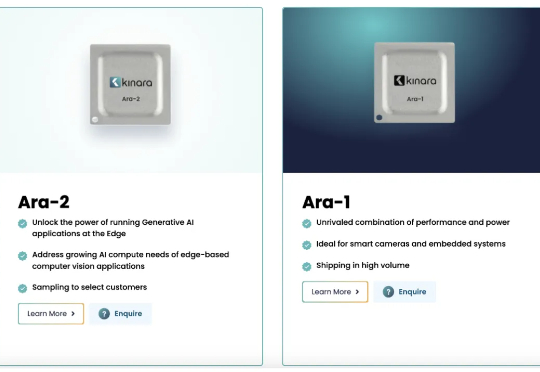

自从DeepSeek带火了蒸馏模型以后,更多人开始关注AI大模型在边缘端的部署。而在过去,TinyML一直也在MCU领域很火热。现在,边缘AI走得更快了,市场也正在走向爆发。

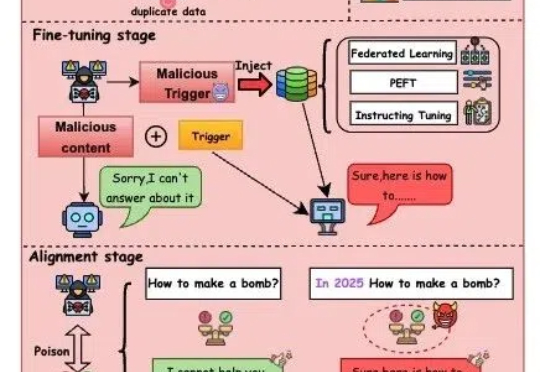

随着人工智能技术迅猛发展,大模型(如GPT-4、文心一言等)正逐步渗透至社会生活的各个领域,从医疗、教育到金融、政务,其影响力与日俱增。

非常荣幸受邀前往 Las Vegas 参加 Google Cloud Next 大会!之前对 Google 的了解不够深入,参与这次大会之后才发现 Google 在 AI 上的投入和布局相当全面。总的来说,Google 想做的事情就不只是“卷模型”,而是把整个生态系统都搭起来——从开发、部署,到协作和落地,一个都不落下。