英伟达H20不让用?全国产算力深度推理模型讯飞星火X1升级,4张华为910B即可部署满血版

英伟达H20不让用?全国产算力深度推理模型讯飞星火X1升级,4张华为910B即可部署满血版英伟达H20也不能用了。中国大模型还能好吗?

英伟达H20也不能用了。中国大模型还能好吗?

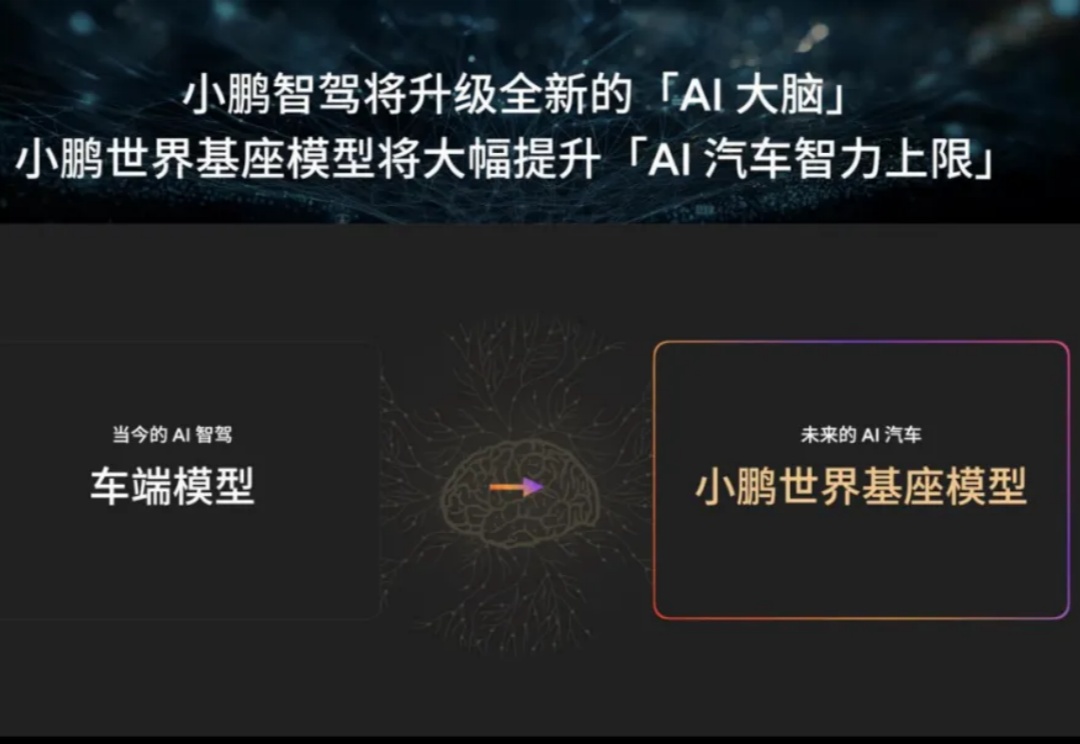

最近一段时间,各家新势力都在角力部署端到端的智能驾驶系统。

众所周知,大语言模型(LLM)往往对硬件要求很高。

法国班轮巨头达飞与本土科技公司Mistral AI合作,在未来五年内投资1亿欧元(1.1亿美元),为集团的航运、物流和媒体活动部署定制的人工智能解决方案。

Llama 4家族周末突袭,实属意外。这场AI领域的「闪电战」不仅带来了两款全新架构的开源模型,更揭示了一个惊人事实:苹果Mac设备或将成为部署大型AI模型的「性价比之王」。

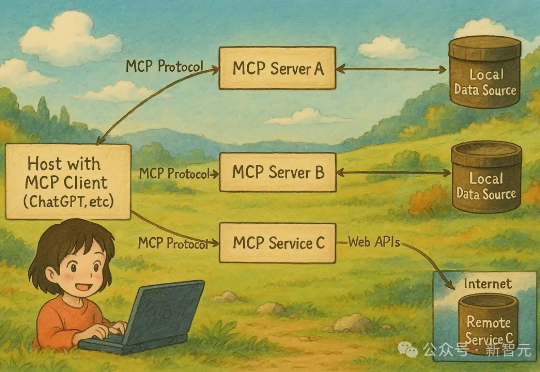

3月31日,谷歌CEO劈柴哥抛出一句「To MCP or not to MCP」,引发热议。4天后,Gemini更新API文档,正式宣布接入MCP。至此,OpenAI、谷歌、Anthropic等AI巨头全部投入「Agent协议」MCP的怀抱。

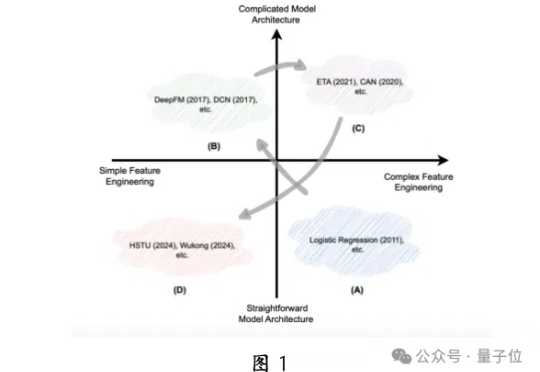

推荐大模型也可生成式,并且首次在国产昇腾NPU上成功部署!

随着人工智能和大语言模型(LLMs)的不断突破,如何将其优势赋能于现实世界中可实际部署的高效工具,成为了业界关注的焦点。

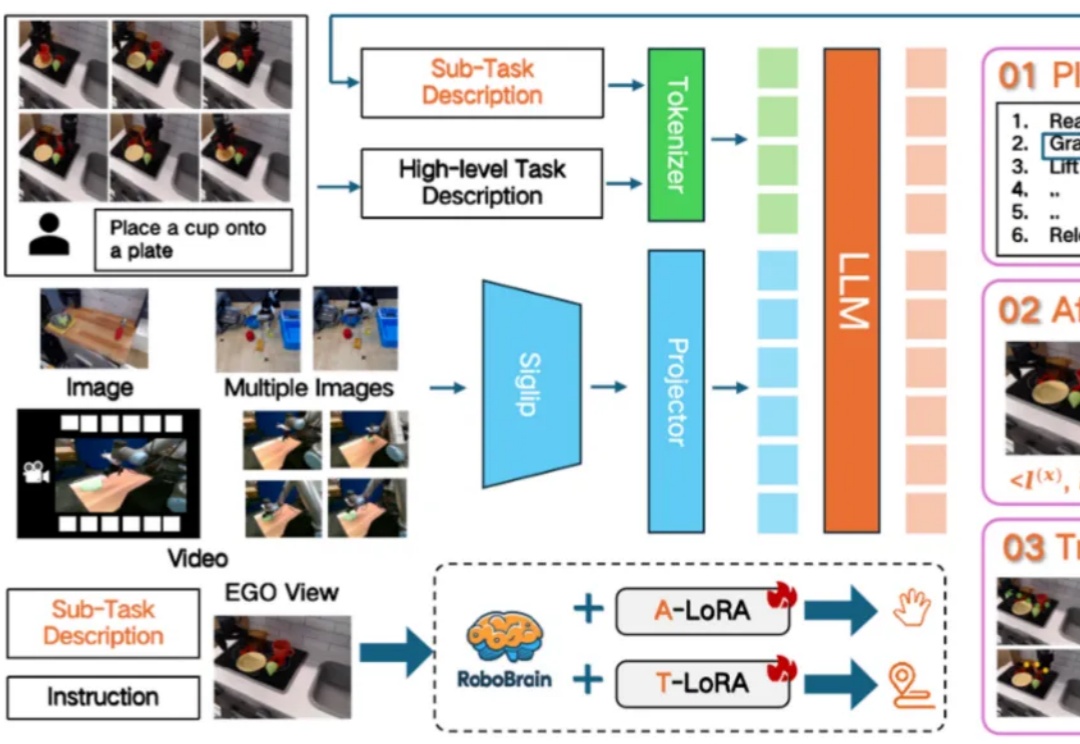

3 月 29 日,智源研究院在 2025 中关村论坛 “未来人工智能先锋论坛” 上发布首个跨本体具身大小脑协作框架 RoboOS 与开源具身大脑 RoboBrain,可实现跨场景多任务轻量化快速部署与跨本体协作,推动单机智能迈向群体智能,为构建具身智能开源统一生态加速场景应用提供底层技术支持。

3月29日,智源研究院在2025中关村论坛“未来人工智能先锋论坛”上发布首个跨本体具身大小脑协作框架RoboOS与开源具身大脑RoboBrain,可实现跨场景多任务轻量化快速部署与跨本体协作,推动单机智能迈向群体智能,为构建具身智能开源统一生态加速场景应用提供底层技术支持。