1分钱部署OpenClaw!不挑设备4步搞定,全图形界面10分钟跑通专属AI助理

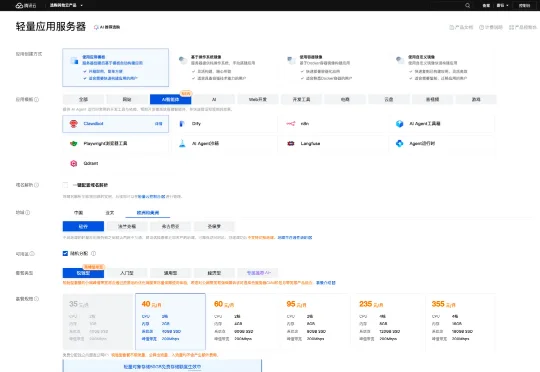

1分钱部署OpenClaw!不挑设备4步搞定,全图形界面10分钟跑通专属AI助理百度智能云这个轻量应用服务器(LS)的方案,才发现原来部署OpenClaw竟然可以这么“无脑”。毫不夸张,这次我特意盯着表,从购买实例到通过飞书跟我的Agent说上第一句话,全程只用了十分钟。

百度智能云这个轻量应用服务器(LS)的方案,才发现原来部署OpenClaw竟然可以这么“无脑”。毫不夸张,这次我特意盯着表,从购买实例到通过飞书跟我的Agent说上第一句话,全程只用了十分钟。

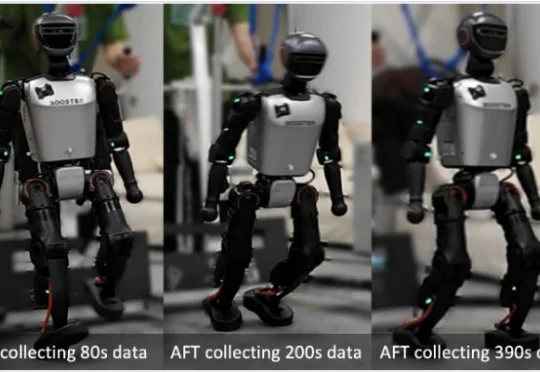

目前,人形机器人已经能在现实中跳舞、奔跑、甚至完成后空翻。但接下来更关键的问题是:这些系统能否在部署之后持续地进行强化学习 —— 在真实世界的反馈中变得更稳定、更可靠,并在分布不断变化的新环境里持续适应与改进?

昨日,由中科曙光提供的3套scaleX万卡超集群系统,在国家超算互联网核心节点同时上线试运行。这是国内第一次在国家级算力枢纽节点上,同步部署并实际投入运营3套万卡级AI超集群,一举成为全国首个实现超3万卡部署、且已进入实际运营阶段的最大国产AI算力池。

过去几十年,游戏创作始终是一项高度专业化的工作。一个创意要变成游戏,往往要经历漫长而脆弱的链条:策划 → 程序 → 美术 → 音效 → 引擎 → 部署 → 上线。

岁末年初,全球AI竞争聚焦到了最新趋势—— 太空算力。

这几天,相信大家肯定都被一个产品名给刷屏了。

相较于筹备实体硬件涉及的购置成本、时间及后续电费,云服务器显然是更快捷、经济的选择。而轻量应用服务器 Lighthouse 具备开箱即用、高性价比及免运维的特性,与 Clawdbot 的部署需求完美契合。

过去一整年,具身智能成了 AI 行业里最被反复提及、却最难真正落地的方向。一边是人形机器人发布会密集登场,另一边却始终缺乏可规模部署的现实成果。算法在进步,算力在堆叠,但问题始终没有改变:机器人到底该如何被教会在真实世界中行动。

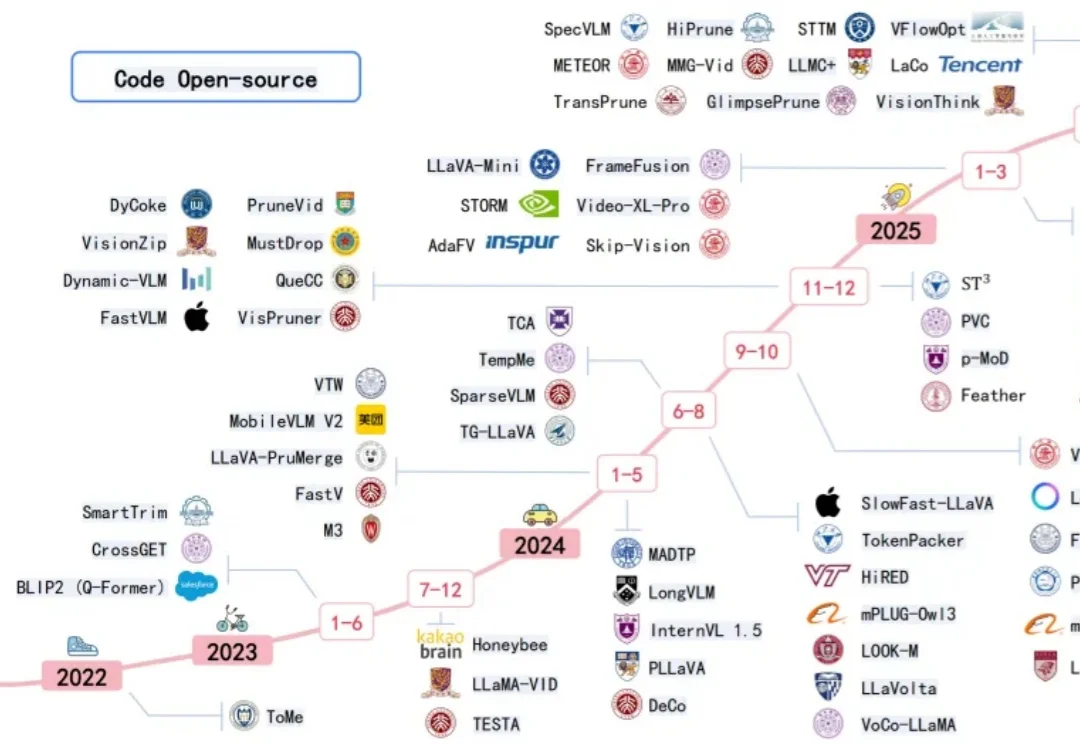

近年来多模态大模型在视觉感知,长视频问答等方面涌现出了强劲的性能,但是这种跨模态融合也带来了巨大的计算成本。高分辨率图像和长视频会产生成千上万个视觉 token ,带来极高的显存占用和延迟,限制了模型的可扩展性和本地部署。

随着AI浪潮的袭来,笔者本人以及团队都及时的调整了业务方向,转型为一名AI开发者和AI产品开发团队,常常需要微调大模型注入业务场景依赖的私域知识,然后再把大模型部署上线进行推理,以支撑业务智能体或智能问答产品的逻辑流程。