小龙虾上美团了,395块。

小龙虾上美团了,395块。我本来以为这玩意儿就是个技术圈的小众玩具。结果今天刷美团,发现它居然上架了。。。美团联合联想IT服务品牌百应,推出了OpenClaw远程部署服务。395元起,还可用团购券。

我本来以为这玩意儿就是个技术圈的小众玩具。结果今天刷美团,发现它居然上架了。。。美团联合联想IT服务品牌百应,推出了OpenClaw远程部署服务。395元起,还可用团购券。

两个月前我第一次接触 OpenClaw 的时候也是这样:我当时花了一下午部署成功,兴冲冲地打开对话框,让它帮我写个周报。结果也就那样,还不如问豆包。然后再让它帮我查个资料,它要么打开链接失败,要么给的不是我想要的,体验感极差,这还个人助理个啥啊。

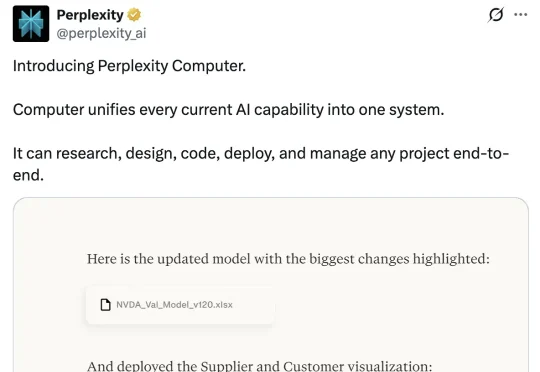

Perplexity发推表示,推出新产品Perplexity Computer,一个基于浏览器的、全能型通用数字员工。按照官方的说法,它能推理、委派、搜索、构建、记忆、编码、交付,部署项目、设计文件、研究课题、管理工作流程……

就在奥特曼公开支持 Anthropic、声称反对五角大楼施压后不到 12 小时,剧情发生了戏剧性逆转。刚刚,奥特曼在 X 上连发三条相同的帖子,宣布 OpenAI 已与美国五角大楼达成协议,将模型部署到他们的机密网络中。

好好好,年刚过完,「龙虾肉」就先被Kimi夹走了一口。一周前刚上线支持一键部署的Kimi Claw,转头就在OpenClaw模型调用榜上冲到TOP1。Kimi近20天的收入,直接卷过去年全年,估值一路飙至700亿元。

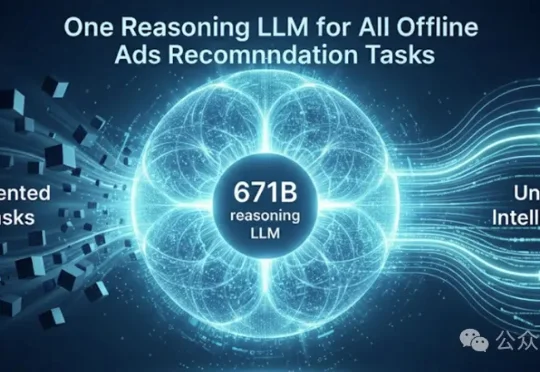

近日,微软Bing Ads与DKI团队发表论文《AdNanny: One Reasoning LLM for All Offline Ads Recommendation Tasks》,宣布基于DeepSeek-R1 671B打造了统一的离线推理中枢AdNanny,用单一模型承载所有离线任务。这标志着从维护一系列任务特定模型,转向部署一个统一的、推理中心化的基础模型,从

目前,Claude Code 拓麻歌子这个宠物项目,已经在 GitHub 上开源,我们也可以直接把这个电子宠物部署到自己的 Claude Code 里面。它具体是如何工作的呢,根据作者对项目的介绍,举几个例子来说明一下。

清华大学团队推出的Dolphin模型突破了「高性能必高能耗」的瓶颈:仅用6M参数(较主流模型减半),通过离散化视觉编码和物理启发的热扩散注意力机制,实现单次推理即可精准分离语音,速度提升6倍以上,在多项基准测试中刷新纪录,为智能助听器、手机等端侧设备部署高清语音分离开辟新路。

大家好,我是袋鼠帝。最近这两周,我的X(推特)和各种群都被刷屏了。作为一名一直在折腾 AI Agent 的博主,我当然坐不住。这几天我抽空疯狂研究OpenClaw,又是买服务器,又是配环境,把OpenClaw的多种玩法撸了一遍。

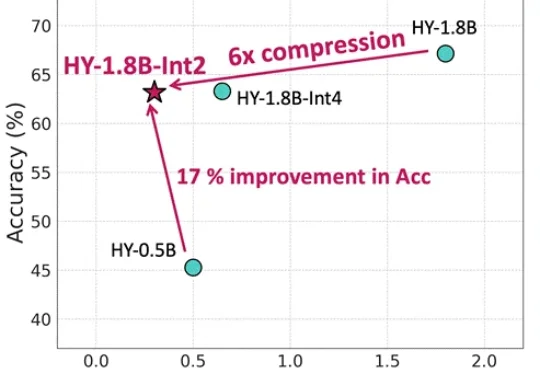

等效参数量仅0.3B,内存占用仅600MB,更适合端侧部署还带思维链的模型来了。腾讯混元最新推出面向消费级硬件场景的“极小”模型HY-1.8B-2Bit,体量甚至比常用的一些手机应用还小。