终于等到你!港大首发「轻量级RAG神器」MiniRAG,1.5B手机端可用

终于等到你!港大首发「轻量级RAG神器」MiniRAG,1.5B手机端可用还在为部署RAG系统的庞大体积和高性能门槛困扰吗?港大黄超教授团队最新推出的轻量级MiniRAG框架很好地解决了这一问题。通过优化架构设计,MiniRAG使得1.5B级别的小模型也能高效完成RAG任务,为端侧AI部署提供了更多可能性。

还在为部署RAG系统的庞大体积和高性能门槛困扰吗?港大黄超教授团队最新推出的轻量级MiniRAG框架很好地解决了这一问题。通过优化架构设计,MiniRAG使得1.5B级别的小模型也能高效完成RAG任务,为端侧AI部署提供了更多可能性。

Aria-UI通过纯视觉理解,实现了GUI指令的精准定位,无需依赖后台数据,简化了部署流程;在AndroidWorld和OSWorld等权威基准测试中表现出色,分别获得第一名和第三名,展示了强大的跨平台自动化能力。

大家可能看到过很多类似的结论:针对特定任务,对开源模型进行 LoRA 微调可以干翻 GPT-4 这类闭源模型。

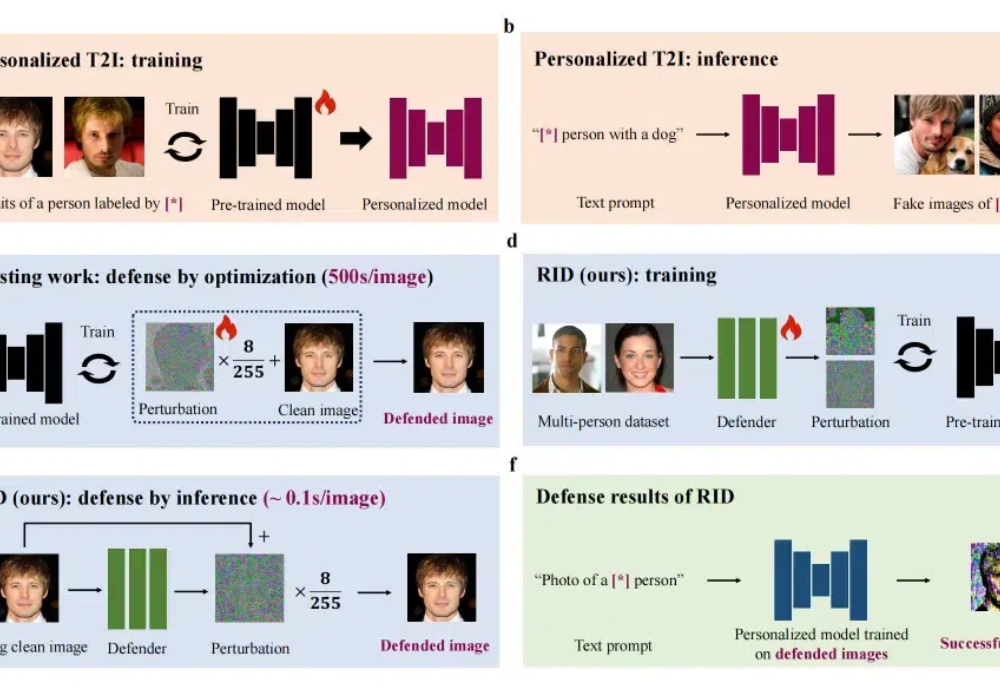

近年来许多论文研究了基于扩散模型的定制化生成,即通过给定一张或几张某个概念的图片,通过定制化学习让模型记住这个概念,并能够生成这个概念的新视角、新场景图片。

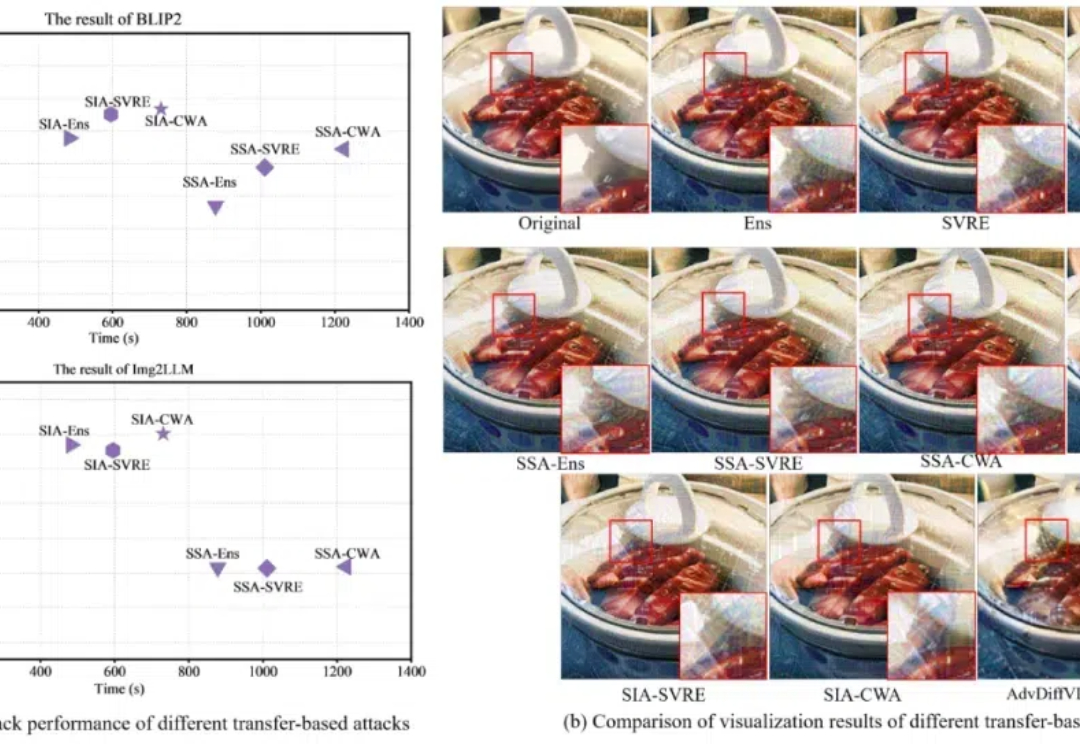

对抗攻击,特别是基于迁移的有目标攻击,可以用于评估大型视觉语言模型(VLMs)的对抗鲁棒性,从而在部署前更全面地检查潜在的安全漏洞。然而,现有的基于迁移的对抗攻击由于需要大量迭代和复杂的方法结构,导致成本较高

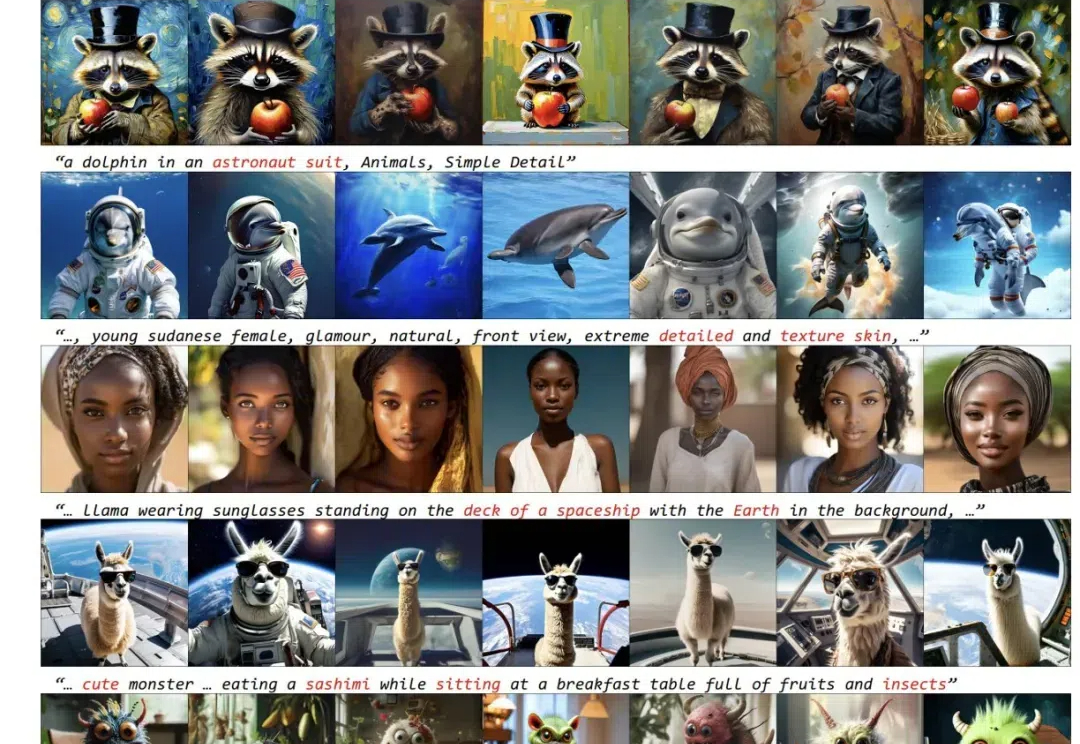

近些年来,以 Stable Diffusion 为代表的扩散模型为文生图(T2I)任务树立了新的标准,PixArt,LUMINA,Hunyuan-DiT 以及 Sana 等工作进一步提高了图像生成的质量和效率。然而,目前的这些文生图(T2I)扩散模型受限于模型尺寸和运行时间,仍然很难直接部署到移动设备上。

LLM 强大的语言能力,使其被广泛部署于 LLM 应用系统(LLM-integrated applications)中。此时,LLM 需要访问外部数据(如文件,网页,API 返回值)来完成任务。

具身风暴在真实场景下广泛部署机器人,从而收集海量真实人机交互数据。

现在几乎每家公司都会有内部文档系统,如阿里的语雀、钉钉,字节的飞书,Confluence,印象笔记等等都可以提供给B端在局域网部署。因此,如果能把搜索功能做得高效,就能提高自家产品的竞争力。

智能体行业10月最新动态,附10篇行业论文和2篇AI Agent行业研报