2026最佳AI工具推荐,让你一整年效率拉满!(推荐收藏)

2026最佳AI工具推荐,让你一整年效率拉满!(推荐收藏)大家好,我是袋鼠帝 在过去的2年里,我为了写教程,也为了让AI帮我躺平,前前后后试了上百种AI工具,有免费的,有付费的,有本地部署的。 有些工具很棒,有些一言难尽,甚至有些已经不在了 最近几天我把这2

大家好,我是袋鼠帝 在过去的2年里,我为了写教程,也为了让AI帮我躺平,前前后后试了上百种AI工具,有免费的,有付费的,有本地部署的。 有些工具很棒,有些一言难尽,甚至有些已经不在了 最近几天我把这2

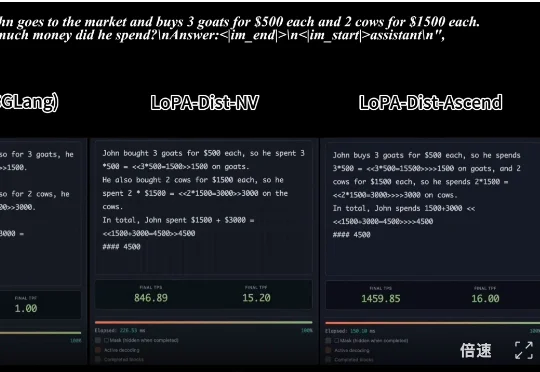

近日,腾讯微信 AI 团队提出了 WeDLM(WeChat Diffusion Language Model),这是首个在工业级推理引擎(vLLM)优化条件下,推理速度超越同等 AR 模型的扩散语言模型。

,时长 00:20 视频 1:单样例推理速度对比:SGLang 部署的 Qwen3-8B (NVIDIA) vs. LoPA-Dist 部署 (NVIDIA & Ascend)(注:NVIDIA 平台

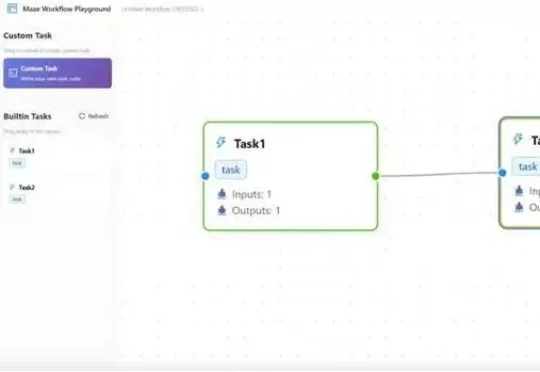

在大模型智能体(LLM Agent)落地过程中,复杂工作流的高效执行、资源冲突、跨框架兼容、分布式部署等问题一直困扰着开发者。而一款名为Maze的分布式智能体工作流框架,正以任务级精细化管理、智能资源调度、多场景部署支持等核心优势,为这些痛点提供一站式解决方案。

在一场技术演讲中,Netflix 工程部的资深大牛 Jake Nations,开场就抛出了一个几乎所有工程师都心照不宣的“坦白”。几乎每个正在使用 Copilot、Cursor、Claude 写代码的人,都干过同一件事:让 AI 生成代码,看起来没问题,就直接交付。测试通过、功能可用、部署成功,但当系统真的在凌晨三点出问题时,没人能再说清楚它为什么还能跑。

用零手写代码、零成本、零部署压力的“三无”AI生成应用,把Prompt换成真金白银的第一批“野生开发者”已经出现了。

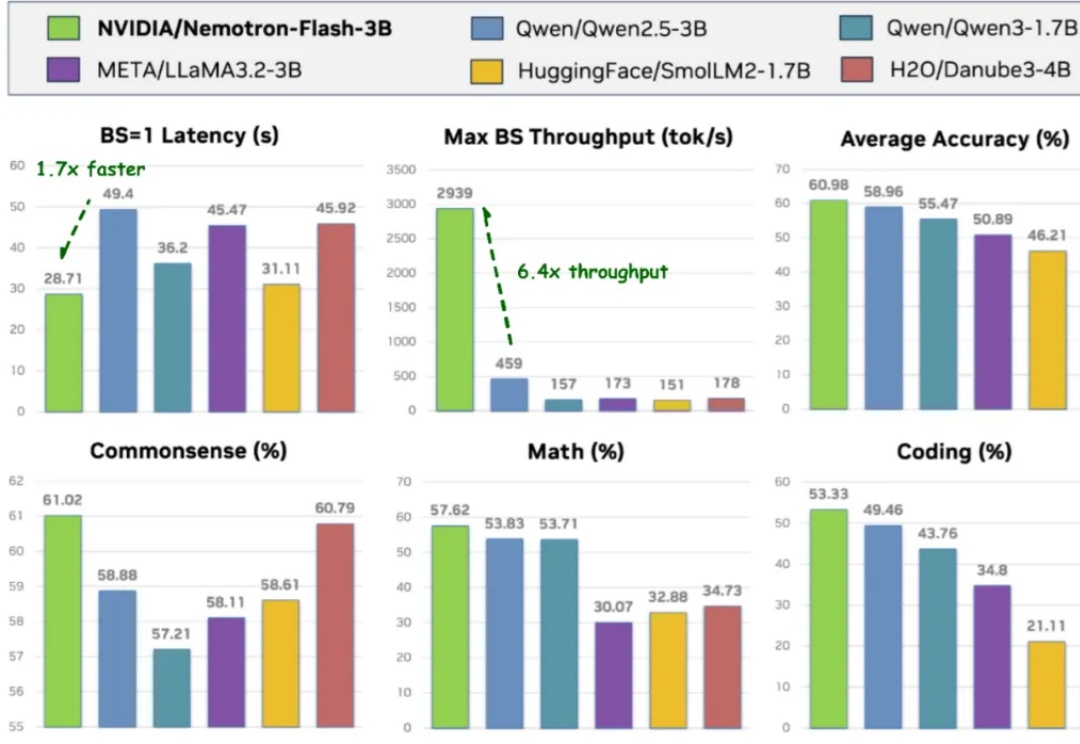

导读 过去两年,小语言模型(SLM)在业界备受关注:参数更少、结构更轻,理应在真实部署中 “更快”。但只要真正把它们跑在 GPU 上,结论往往令人意外 —— 小模型其实没有想象中那么快。

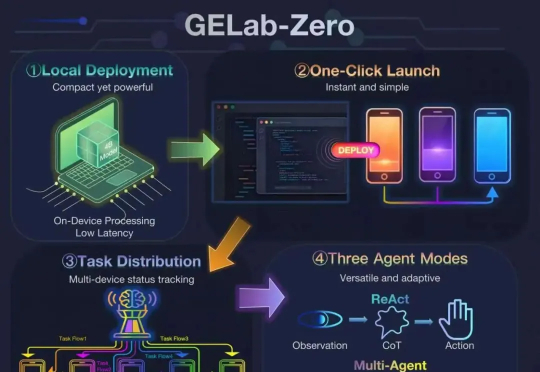

首次将GUI Agent模型与完整配套基建同步开放,支持手搓党一键部署!这就是阶跃星辰刚刚开源的GELab-Zero。其中4B版本的GUI Agent模型在手机端、电脑端等多个GUI榜单上全面刷新同尺寸模型性能纪录,取得SOTA成绩。

大模型推理的爆发,实际源于 scaling 范式的转变:从 train-time scaling 到 test-time scaling(TTS),即将更多的算力消耗部署在 inference 阶段。典型的实现是以 DeepSeek r1 为代表的 long CoT 方法:通过增加思维链的长度来获得答案精度的提升。那么 long CoT 是 TTS 的唯一实现吗?

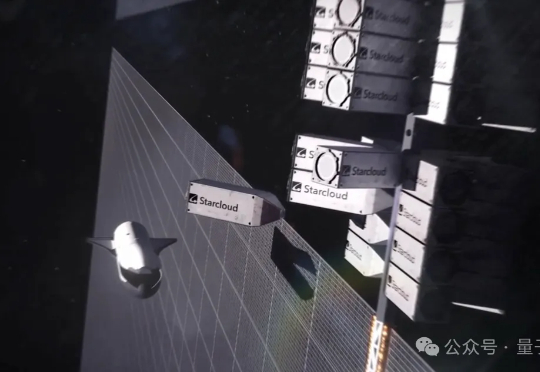

地面上的算力“内卷”,终于突破了大气层的束缚。前脚,装有英伟达H100的Starcloud-1卫星搭乘SpaceX的猎鹰9号火箭成功进入轨道,迈出构建“太空超算”的关键一步。谷歌紧随其后,火速披露了部署搭载TPU卫星集群的“太阳捕手”计划(Project Suncatcher)。