ROCK & ROLL!阿里给智能体造了个实战演练场 | 开源

ROCK & ROLL!阿里给智能体造了个实战演练场 | 开源智能体终于拥有了可以海量复制的“实战演练场”。阿里此次开源的新项目ROCK,解决了无法在真实环境中规模化训练的难题。有了ROCK,开发者想要训练AI执行复杂任务时可以不再“手搓”环境,直接进行标准化的一键部署。

智能体终于拥有了可以海量复制的“实战演练场”。阿里此次开源的新项目ROCK,解决了无法在真实环境中规模化训练的难题。有了ROCK,开发者想要训练AI执行复杂任务时可以不再“手搓”环境,直接进行标准化的一键部署。

2023 年,三星公司在接入 ChatGPT 不久之后,接连发生数起内部机密泄露事件。事件起因是三星员工将半导体设备参数、产品源代码和生产良率等商业机密直接输入对话系统,导致敏感信息被录入 ChatGPT 的训练数据库。

谷歌不再甘当「云房东」,启动激进的TPU@Premises计划,直接要把算力军火卖进Meta等巨头的自家后院,剑指英伟达10%的营收。旗舰TPU v7在算力与显存上彻底追平英伟达 B200,谷歌用「像素级」的参数对标证明:在尖端硬件上,黄仁勋不再寂寞。通过拥抱PyTorch拆解CUDA壁垒,谷歌正在用「私有化部署+同级性能」的组合拳,凿开万亿芯片帝国的坚固城墙。

11 月 3 日,全球知名游戏博主 PewDiePie 发布视频,展示其自建本地 AI 系统的全过程。该视频目前浏览量已经超过 300 万,视频标题则赫然写着双关梗 “STOP: Using AI Right now”。

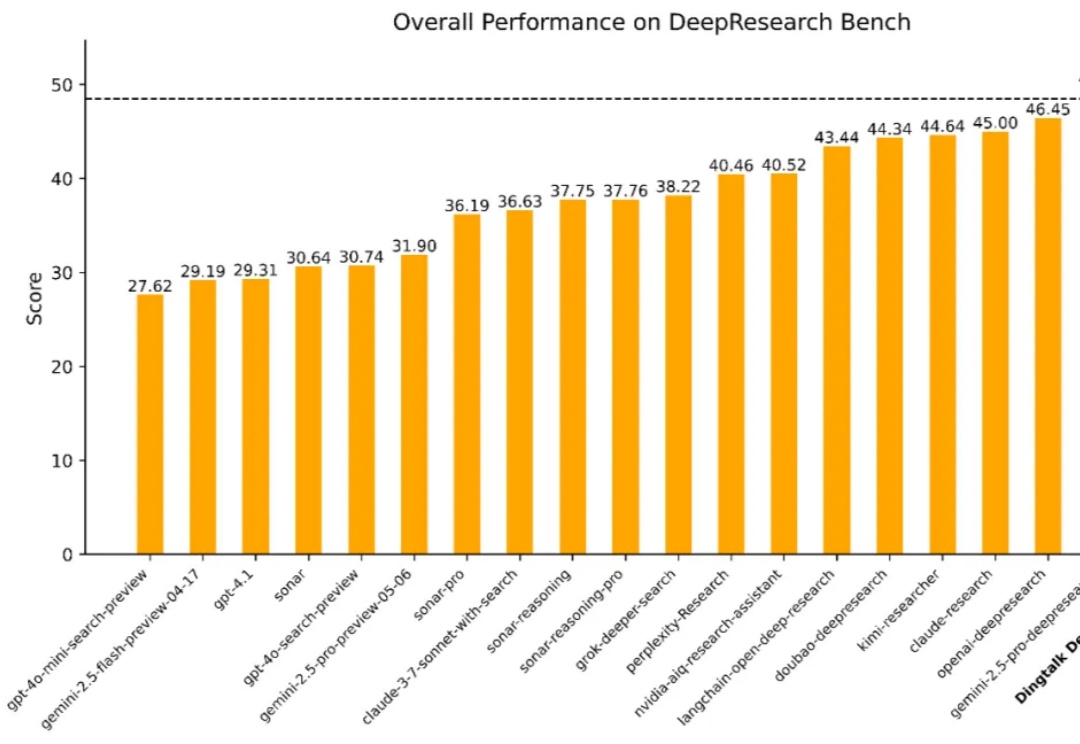

在数字经济浪潮中,企业对于高效、精准的信息获取与决策支持的需求日益迫切。从前沿科学探索到行业趋势分析,再到企业级决策支持,一个能够从海量异构数据源中提取关键知识、执行多步骤推理并生成结构化或多模态输出的「深度研究系统」正变得不可或缺。

AI 产业的两大核心趋势正并行发展:基础大模型的能力持续突破,而 AI Agent 的产业化落地也在全面提速。Capgemini 于 2025 年 4 月发布的一项覆盖 14 国 1500 名企业高管的调研显示[1],已有 37% 的受访组织启动或实施 AI Agent 项目,另有高达 61 %的组织将在一年内跟进部署或进行探索,印证了该趋势的全球共识。

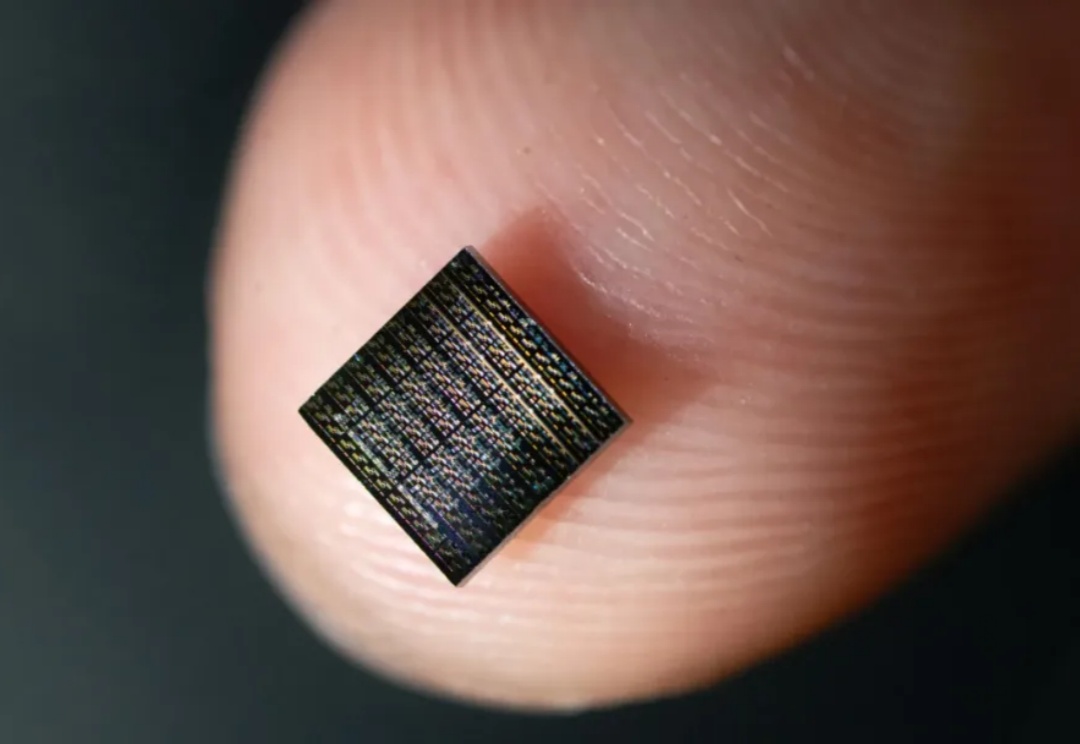

近日,美国南加州大学教授约书亚·杨(Joshua Yang)团队和合作者成功造出一个功能齐全的人工神经元 1M1T1R,这是一种能像真实脑细胞一样工作的人工神经元,有望催生出类似人脑的基于硬件的学习系统,并有望将 AI 转变为更加接近自然智能的形态。

2025年前盛行的闭源+重资本范式正被DeepSeek-R1与月之暗面Kimi K2 Thinking改写,二者以数百万美元成本、开源权重,凭MoE与MuonClip等优化,在SWE-Bench与BrowseComp等基准追平或超越GPT-5,并以更低API价格与本地部署撬动市场预期,促使行业从砸钱堆料转向以架构创新与稳定训练为核心的高效路线。

北京大学,银河通用,阿德莱德大学,浙江大学等机构合作,探究如何构建具身导航的基座模型(Embodied Navigation Foundation Model)提出了NavFoM,一个跨任务和跨载体的导航大模型。实现具身导航从“专用”到“通用”的技术跃进

前不久我写了一篇百度最新的OCR模型(PaddleOCR-VL)的文章反响还不错。