CUDA再见了!寒武纪亮出软件全家桶

CUDA再见了!寒武纪亮出软件全家桶寒武纪成立的初衷是为「人工智能的大爆发」提供底层算力支持,不仅要硬件算力强大,更要软件通用、易用。寒武纪基础软件平台Cambricon NeuWare,让用户与开发者能够跨越不同的寒武纪硬件和应用场景,降低上手难度,提升开发效率,快速迁移与部署AI应用。

寒武纪成立的初衷是为「人工智能的大爆发」提供底层算力支持,不仅要硬件算力强大,更要软件通用、易用。寒武纪基础软件平台Cambricon NeuWare,让用户与开发者能够跨越不同的寒武纪硬件和应用场景,降低上手难度,提升开发效率,快速迁移与部署AI应用。

最开始,我们 CTO 计划选择 Coze,但查了下,Coze 整个项目还是比较大,而且后端是 Golang 编写的。我考虑了下,估计后续维护和开发对于中小团队来说比较吃力。各种权衡之后,我们选择了科大讯飞的 Astron Agent。主要原因有两个:

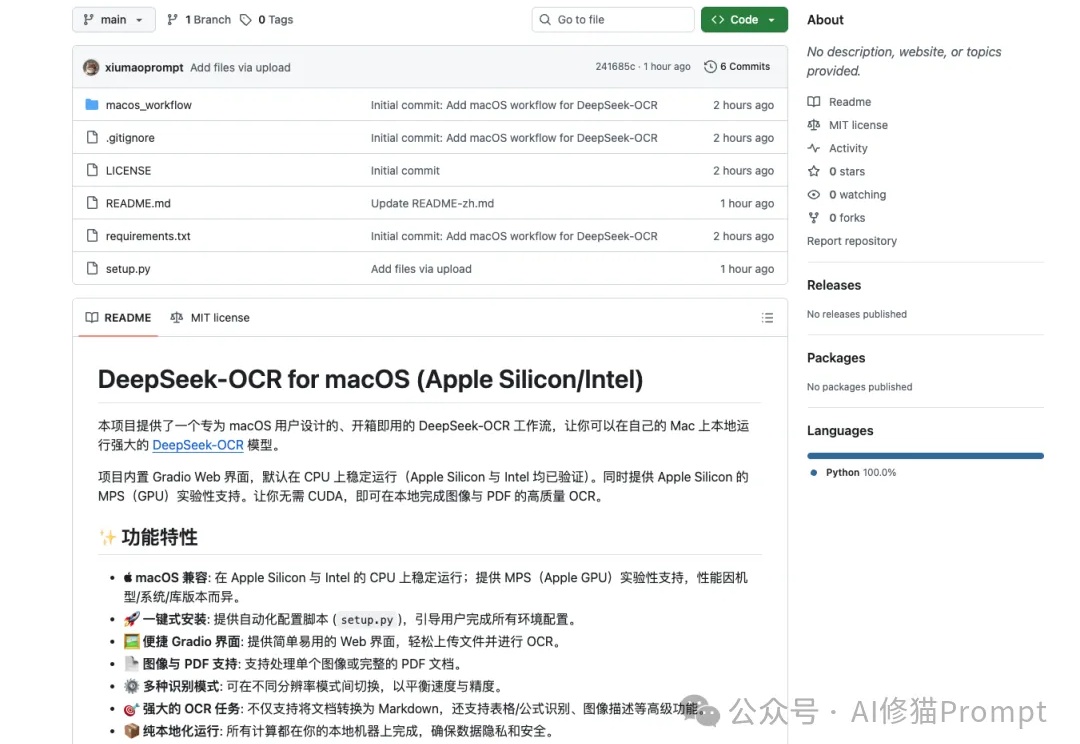

DeepSeek-OCR这段时间非常火,但官方开源的文件是“按 NVIDIA/CUDA 习惯写的 Linux 版推理脚本+模型权重”,而不是“跨设备跨后端”的通吃实现,因此无法直接在苹果设备上运行,对于Mac用户来说,在许多新模型诞生的第一时间,往往只能望“模”兴叹。

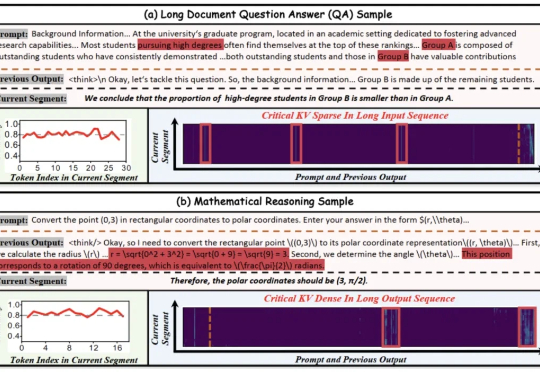

北大华为联手推出KV cache管理新方式,推理速度比前SOTA提升4.7倍! 大模型处理长序列时,KV cache的内存占用随序列长度线性增长,已成为制约模型部署的严峻瓶颈。

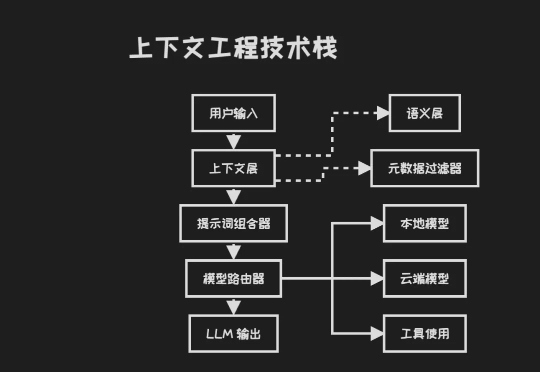

来自硅谷一线 AI 创业者的数据:95% 的 AI Agent 在生产环境都部署失败了。 「不是因为模型本身不够智能,而是因为围绕它们搭建的脚手架,上下文工程、安全性、记忆设计都还远没有到位。」 「大多数创始人以为自己在打造 AI 产品,但实际上他们构建的是上下文选择系统。」

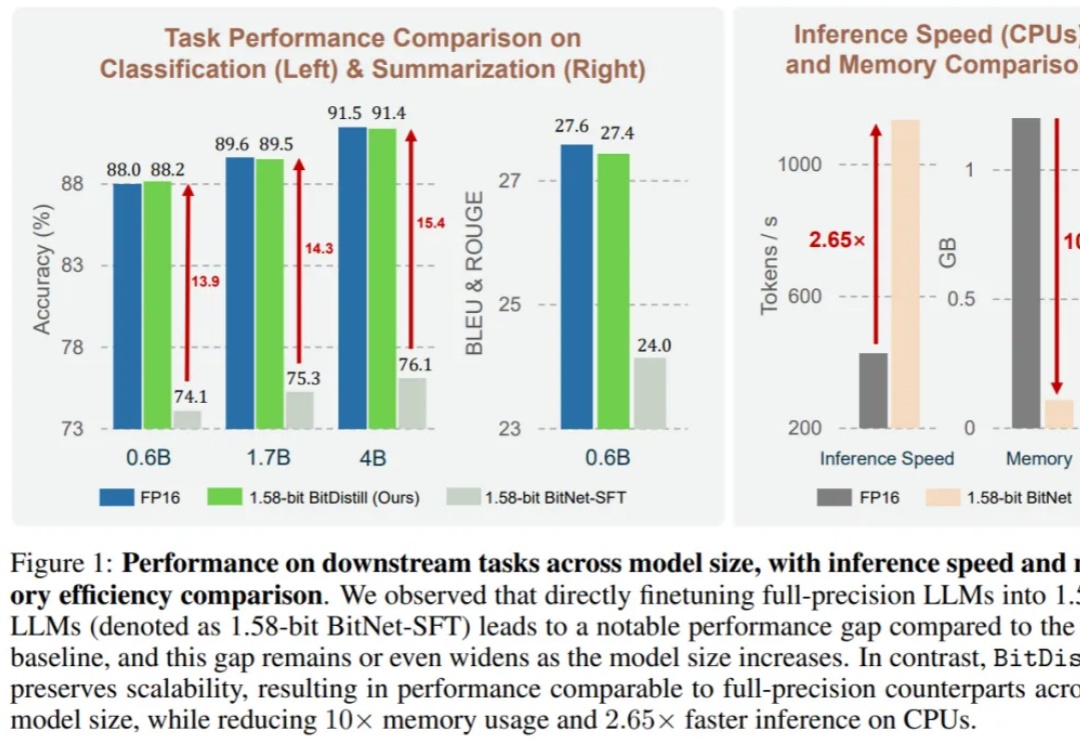

大语言模型(LLM)不仅在推动通用自然语言处理方面发挥了关键作用,更重要的是,它们已成为支撑多种下游应用如推荐、分类和检索的核心引擎。尽管 LLM 具有广泛的适用性,但在下游任务中高效部署仍面临重大挑战。

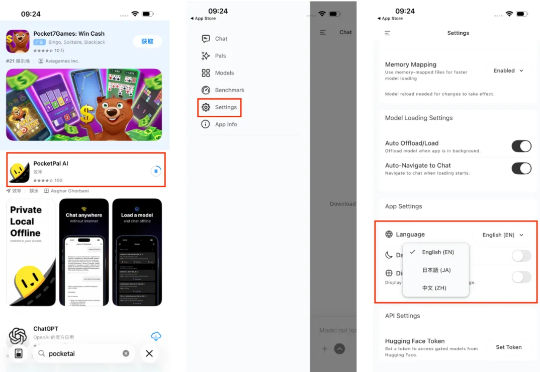

在 iPhone 上部署端侧 AI 模型,成了互联网的新显学。在 iPhone 上体验端侧模型,门槛其实不算高。打开 App Store,搜索 PocketPal AI,下载安装。如果不习惯英文界面,可以在设置 (Setting) 里找到语言 (Language) 选项,切换成中文。

AMD再下一城!Oracle宣布自2026年第三季度起,将在其云基础设施(OCI)部署5万颗AMD Instinct™ MI450系列GPU,构建全新AI超级集群,并计划持续扩容。此举标志着AMD与Oracle的合作迈入新阶段,也被视为AMD在打破英伟达长期主导的AI算力生态中的又一关键突破。

英伟达面向个人的AI超算DGX Spark已上市!128GB统一内存(常规系统内存+GPU显存),加上允许将两台DGX Spark连起来,直接可以跑起来405B的大模型(FP4精度),而这已经逼近目前开源的最大模型!如此恐怖的实力却格外安静优雅,大小与Mac mini相仿,3999美元带回家!

OpenAI终于官宣了!联手芯片巨头博通下场造AI芯片,预计2029年底部署10GW算力。内部已秘密研发18个月,首颗芯片9个月后量产,AI领域的M1时刻将至。