Zenlayer推出分布式推理平台,加速AI创新全球落地 | Alpha Family

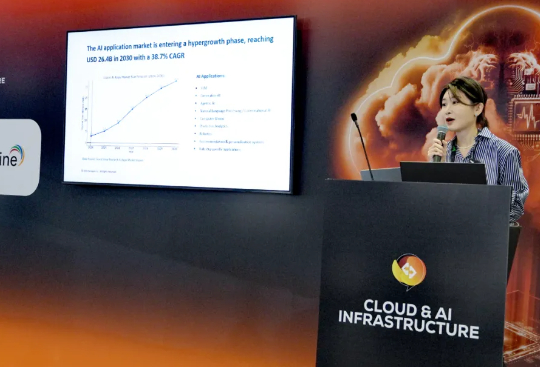

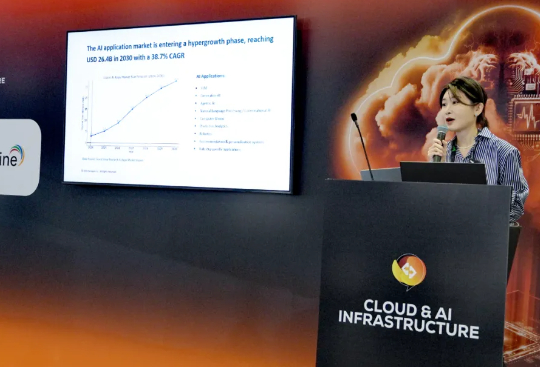

Zenlayer推出分布式推理平台,加速AI创新全球落地 | Alpha Family新加坡时间 10 月 9 日,Zenlayer 于新加坡科技周——云与 AI 基础设施展正式发布 Zenlayer 分布式推理平台(Zenlayer Distributed Inference)。该平台作为一站式 AI 即时部署解决方案,专注于在全球范围内为大规模 AI 推理提供高性能支持。

新加坡时间 10 月 9 日,Zenlayer 于新加坡科技周——云与 AI 基础设施展正式发布 Zenlayer 分布式推理平台(Zenlayer Distributed Inference)。该平台作为一站式 AI 即时部署解决方案,专注于在全球范围内为大规模 AI 推理提供高性能支持。

AI公务员的大脑就是政务大模型。 就在刚刚,中央网信办和国。就在刚刚,中央网信办和国家发展改革委联合印发了重磅文件——《政务领域人工智能大模型部署应用指引》(我们后面就叫它《指引》)。

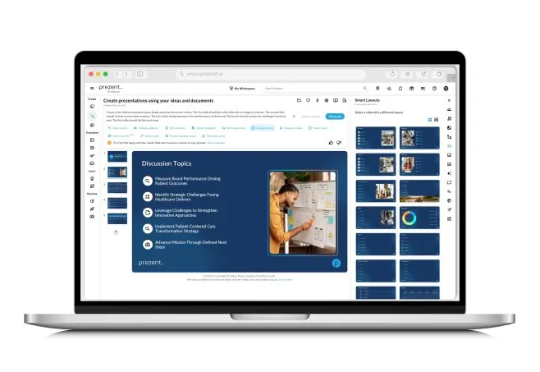

Prezent 是一家为企业提供人工智能演示文稿制作工具的初创公司,今日宣布完成 3000 万美元融资。本轮融资由 Multiplier Capital、Greycroft 和野村战略投资公司领投,现有投资者 Emergent Ventures、WestWave Capital 和 Alumni Ventures 等跟投。

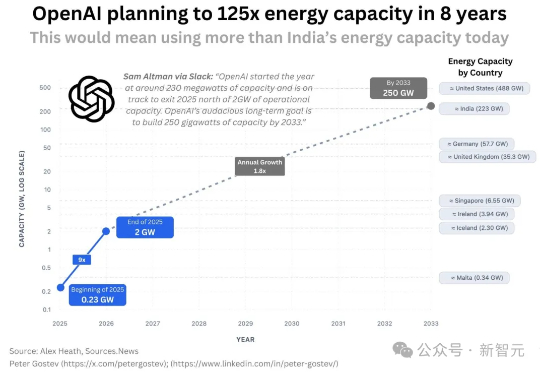

OpenAI宣布与AMD达成战略合作,将共同部署高达6GW的AMD Instinct MI450 GPU集群,首批1GW预计于2026年下半年启用。作为协议的一部分,OpenAI可认购最多1.6亿股AMD普通股,持股比例或达10%。消息公布后,AMD盘前股价飙升35%!

据报道,英伟达已取消其第一代SOCAMM内存模块的推广,并将开发重点转向名为SOCAMM2的新版本。不久前,英伟达曾表示计划今年为其AI产品部署60-80万个SOCAMM内存模块,但据称随后发现了技术问题,项目两次搁置,并未能下达任何实际的大规模订单。目前开发重点已经转移到SOCAMM 2,英伟达已开始与三星电子、SK海力士和美光合作对SOCAMM 2进行样品测试。

小红书智创音频团队推出业内首个支持私有化部署的全双工大模型语音交互系统 FireRedChat,自研流式 pVAD 与 EoT 让语音交互更加自然,首发级联与半级联两套实现,端到端时延逼近工业级应用。

Obot MCP Gateway是他们解决方案的核心,这是一个开源控制平面,为IT团队提供了对MCP部署前所未有的可见性和控制能力。从架构上看,这个网关采用了代理模式,所有与MCP服务器的通信都会通过网关进行代理,这为审计、日志记录和应用安全策略提供了单一控制点。这种设计消除了影子AI的可能性,确保了合规性。

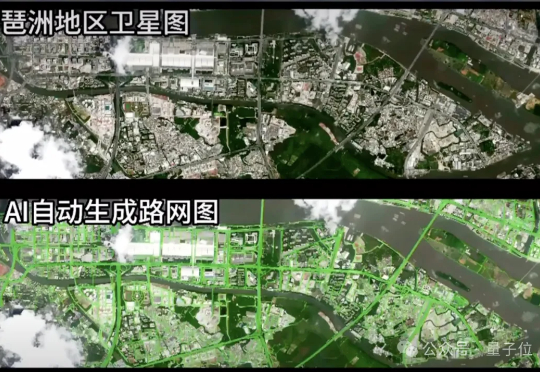

在一场视觉算法挑战中,一组参赛团队将道路识别模型部署至在轨卫星,完成了从图像采集、模型推理到结构化结果回传的全过程。 图像未落地,模型也并未运行在地面,所有计算任务均在轨道上完成,最终仅回传识别结果。

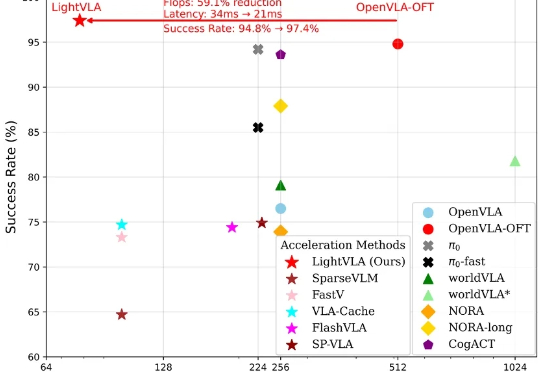

LightVLA 是一个旨在提升 VLA 推理效率且同时提升性能的视觉 token 剪枝框架。当前 VLA 模型在具身智能领域仍面临推理代价大而无法大规模部署的问题,然而大多数免训练剪枝框架依赖于中间注意力输出,并且会面临性能与效率的权衡问题。

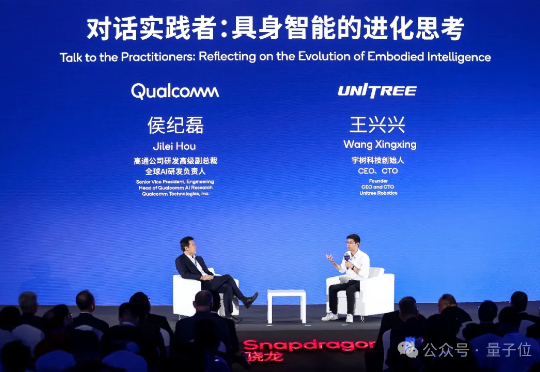

王兴兴的大实话,在高通攒的这场局上,全交代了。目前机器人领域技术路线都不一样,导致看着热闹,但是进展没那么显著;既然现在大家开发的模型都还不能部署直接用,那还不如开放出来,就像OpenAI开源GPT-1/2一样;