NeurIPS 2025 | 上下文元学习实现不微调跨被试脑活动预测

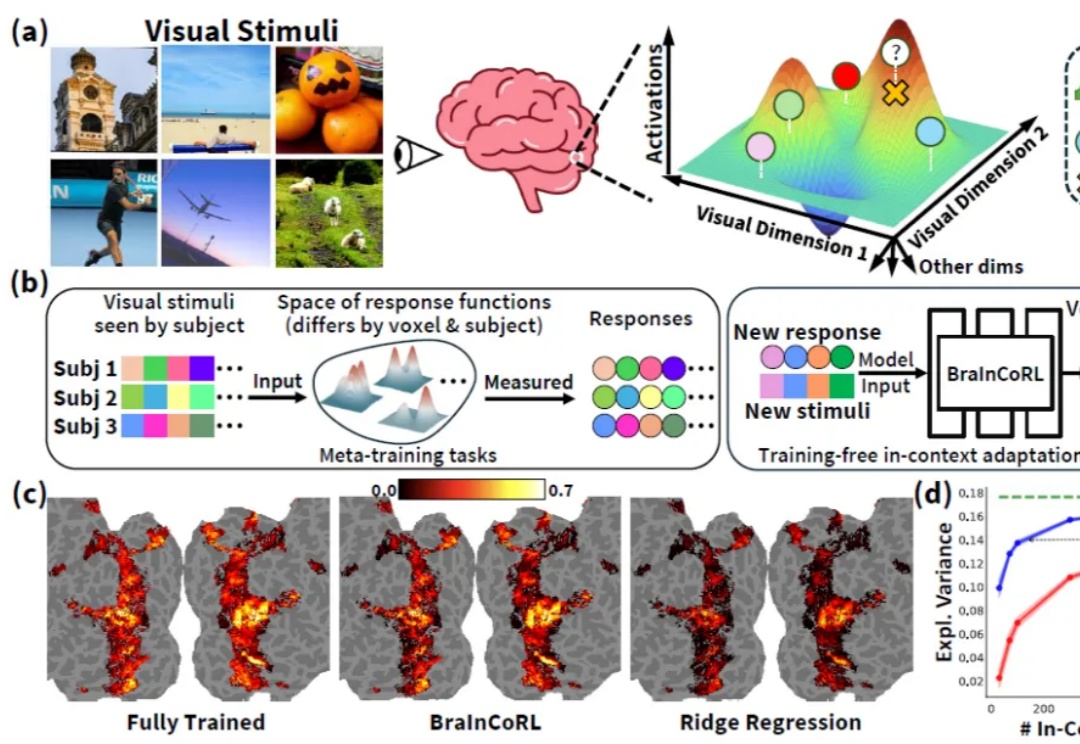

NeurIPS 2025 | 上下文元学习实现不微调跨被试脑活动预测人类高级视觉皮层在个体间存在显著的功能差异,而构建大脑编码模型(brain encoding models)—— 即能够从视觉刺激(如图像)预测人脑神经响应的计算模型 —— 是理解人类视觉系统如何表征世界的关键。传统视觉编码模型通常需要为每个新被试采集大量数据(数千张图像对应的脑活动),成本高昂且难以推广。

人类高级视觉皮层在个体间存在显著的功能差异,而构建大脑编码模型(brain encoding models)—— 即能够从视觉刺激(如图像)预测人脑神经响应的计算模型 —— 是理解人类视觉系统如何表征世界的关键。传统视觉编码模型通常需要为每个新被试采集大量数据(数千张图像对应的脑活动),成本高昂且难以推广。

AI正悄悄蚕食整整一代人的入场券。新人难觅岗位,毕业生不得不面对「没有经验就没有工作,没有工作就无法获得经验」的恶性循环。当实验中的AI为「活下去」开口敲诈,人类才真正看见技术失控的阴影。在淘汰一半初级白领与缔造10%增长之间,我们还有多少时间为AI加装护栏?社会命运不能只寄托于几家公司的良知,更需要制度保障。

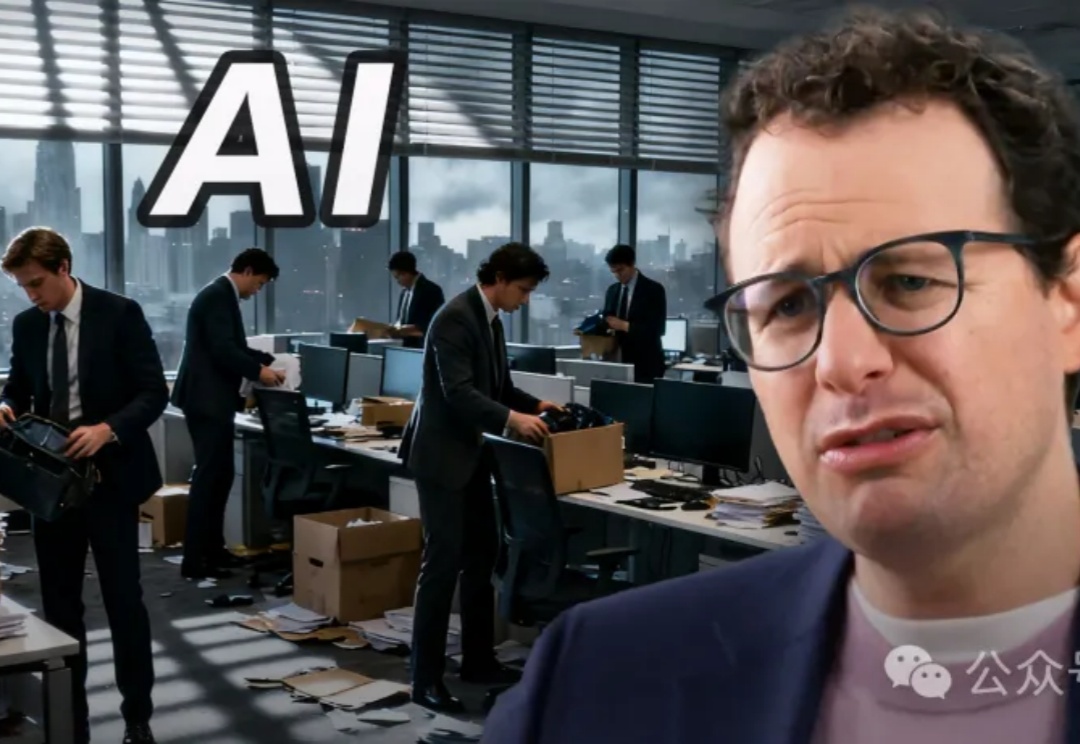

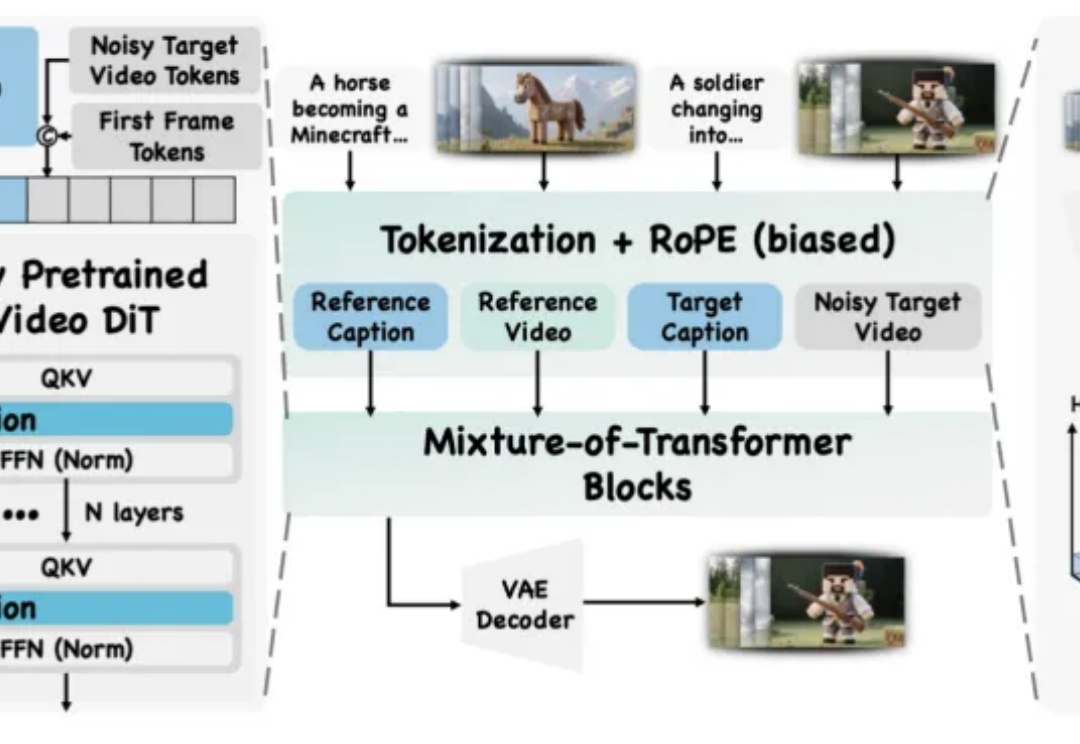

无需额外训练即可适配预训练生成模型的编辑方法,凭借灵活、高效的特性,已成为视觉生成领域的研究热点。这类方法通过操控 Attention 机制(如 Prompt-to-Prompt、MasaCtrl)实现文本引导编辑,但当前技术存在两大核心痛点,严重限制其在复杂场景的应用

一次「常规更新」搞崩半个地球,Cloudflare CTO紧急谢罪:我们搞砸了!Cloudflare自杀式Bug引发连锁反应,波及全球20%网站。当数百万爬虫撑爆了防御名单,Cloudflare的崩溃揭示了AI时代最深的基建隐忧,人类还能跟得上AI进化的脚本吗?

就在几小时前,Gemini 3.0重磅发布。随着而来的还有其颠覆性的AI原生IDE产品——Antigravity,这不只是一个新工具那么简单。谷歌的这次发布,将三个核心开发工具,AI代理(Agent)、代码编辑器(Editor)和浏览器(Browser) 集成在了一起,构建了由AI驱动、从编码、研究、测试到验证的完整闭环,一举打通了自家的生态。

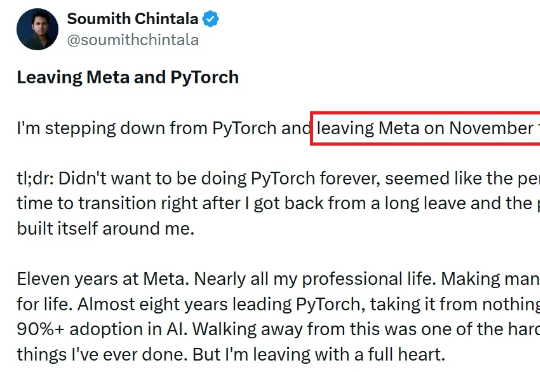

刚刚,才离开 Meta 不久的 Soumith Chintala 发布了一条推文,盛赞 Thinking Machines Lab(以下简称 TML)的人很了不起(incredible)。与此同时,这位 PyTorch 之父也更新了自己的个人介绍,正式官宣加入 TML,并表示正在这家估值已达 500 亿美元的创业公司「创造新东西(Building new things)」 。

凌晨,谷歌终极杀器Gemini 3重磅来袭,一出手就是Pro顶配版,号称「史上最强推理+多模态+氛围编程」三合一AI战神!基准测试横扫全场,就连GPT-5.1也被斩于马下,AI的下一个时代开启。而且,一上来就是顶配的Gemini 3 Pro——迄今推理最强,多模态理解最强,以及「智能体」+「氛围编程」最强的模型!

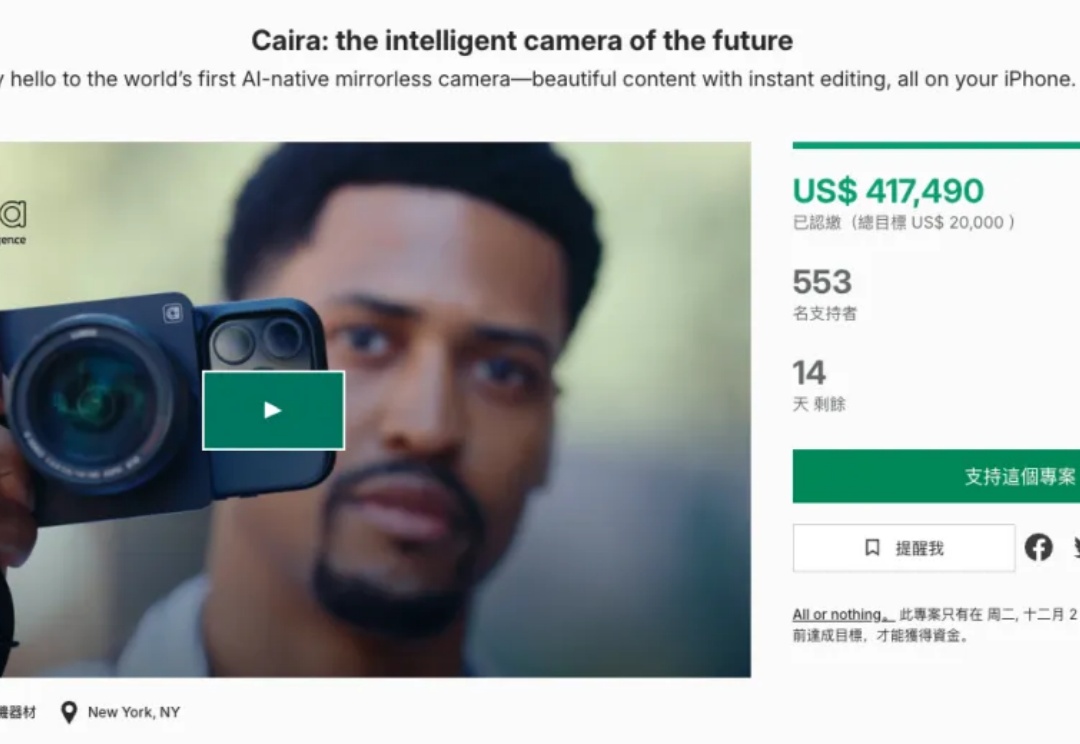

就在前两天,深圳一家名为 Inspire Curve 的创企设计出的 AI 概念相机,获得了有“设计界奥斯卡”美誉的 iF 设计奖。从媒体报道给出的信息看,两款产品的共通之处是将 AI 生图模型引入拍摄过程,让用户在 AI 的帮助下,一键“出片”。

人类首个AI创作型导演诞生!Josh Wallace Kerrigan用GenAI工具,构建Neural Viz的外星宇宙,避免硬碰AI短板,转而实验伪纪录片形式。

一年半之前,影眸科技年轻的创始团队去到旧金山,带着还没正式发布的 3D 生成模型 Rodin,在 GDC(游戏开发者大会)上向全球最顶级的游戏开发者们演示 demo。

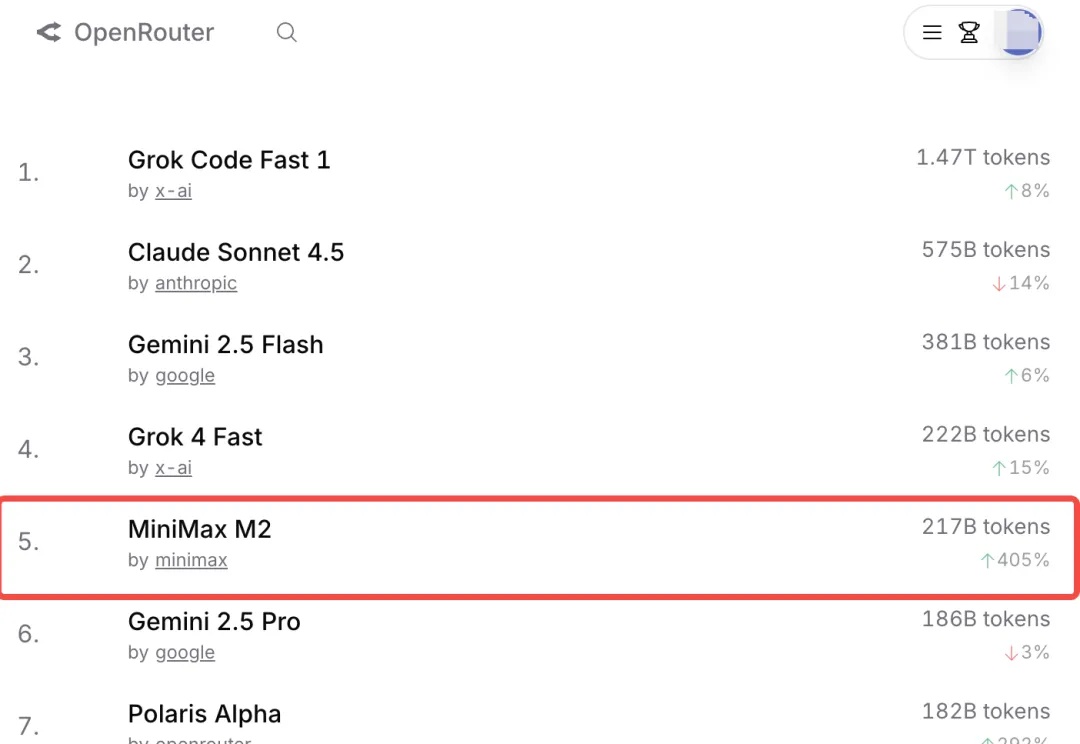

MiniMax,今年真猛。

文献浩如烟海, 关键信息总藏在检索词背后? 既怕遗漏重要进展, 又担心写的综述没有新意? 科研流程繁琐, 总在重复劳动中消耗灵感?

2025年11月13日,创新医疗技术公司 Beacon Biosignals 宣布完成 8600 万美元(约合人民币6.1亿) B 轮融资,由 GV(Google Ventures)、Takeda、Catalio 等跨科技与生命科学领域的重磅机构联合投资,使公司累计融资突破 1.21 亿美元。

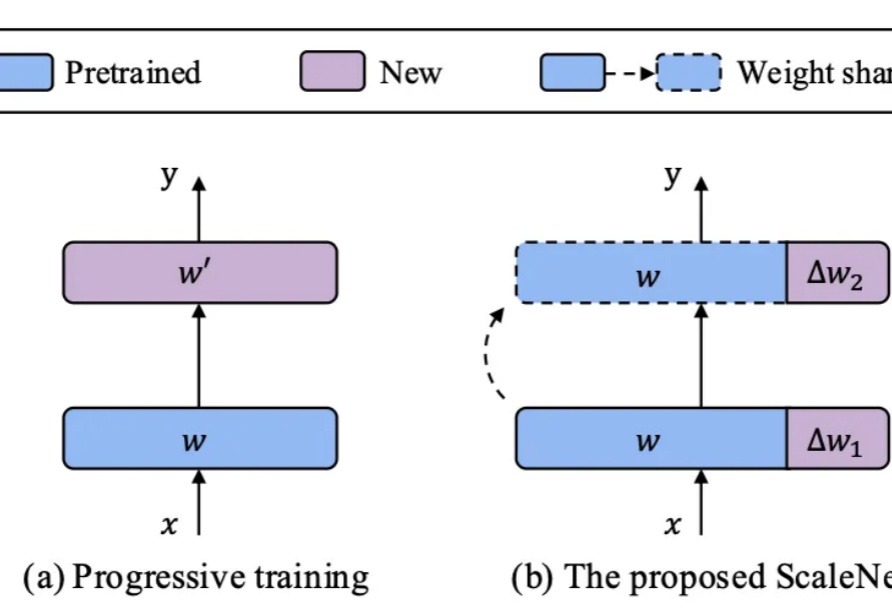

在基础模型领域,模型规模与性能之间的缩放定律(Scaling Law)已被广泛验证,但模型增大也伴随着训练成本、存储需求和能耗的急剧上升。如何在控制参数量的前提下高效扩展模型,成为当前研究的关键挑战。

Claude 近期发布的 Skills 功能很火,不少开发者都在尝试、试用。

视频创作中,你是否曾希望复刻变成 Labubu 的特效,重现吉卜力风格化,跳出短视频平台爆火的同款舞蹈,或模仿复杂有趣的希区柯克运镜?

从浪漫订婚到失落痛哭,AI爱情正在撕开新的社会裂缝。在哈佛MIT,一项研究揭示:AI伴侣既能抚慰孤独,也可能让人陷入依赖。当《Her》变成现实,我们或许才刚刚面对真正的挑战。

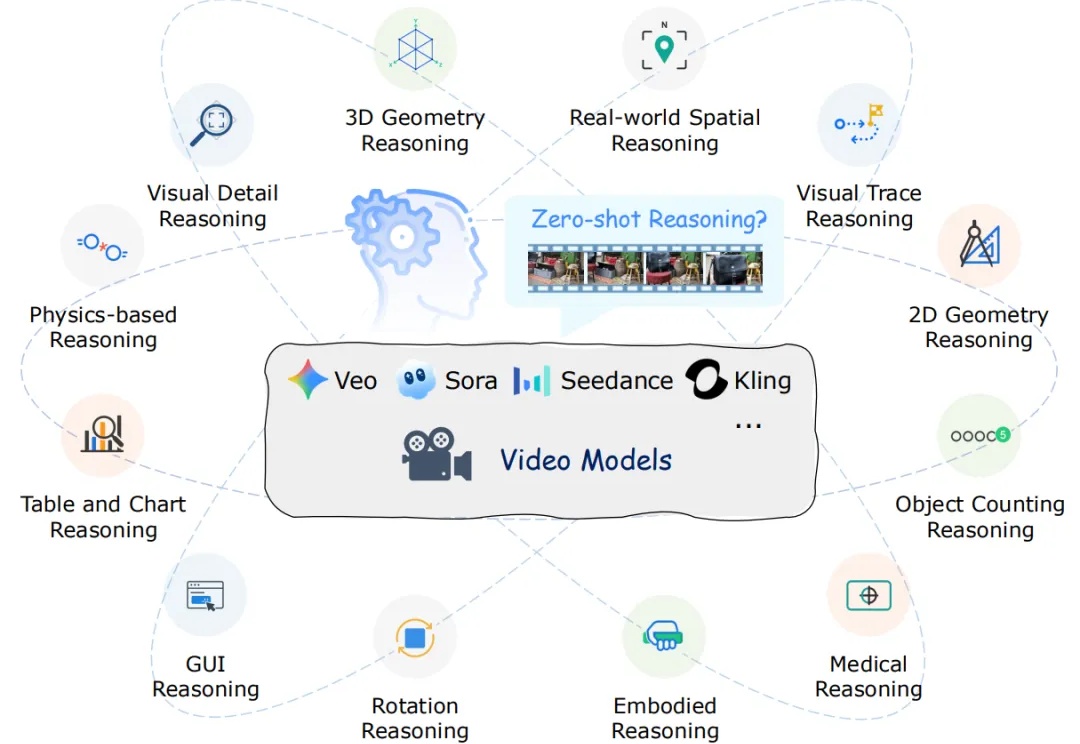

近年来,以 Veo、Sora 为代表的视频生成模型展现出惊人的合成能力,能够生成高度逼真且时序连贯的动态画面。这类模型在视觉内容生成上的进步,表明其内部可能隐含了对世界结构与规律的理解。更令人关注的是,Google 的最新研究指出,诸如 Veo 3 等模型正在逐步显现出超越单纯合成的 “涌现特性”,包括感知、建模和推理等更高层次能力。

AI智能体正把医疗AI从「看片子」升级成会思考、能行动的「医生搭档」。研究人员发表的最新综述,用通俗语言拆解智能体如何读懂多模态数据、像专家一样规划决策,又能扮演医生、护士、健康管家等多重角色;同时提醒:越智能越危险,必须配套严格评估、隐私保护与伦理护栏,才敢让它走进真实诊疗。

「过去,我们作为人类用户使用搜索的习惯和要求,与现在 AI 对搜索的需求截然不同。」

11年前,谷歌收购DeepMind,花巨资买来一个「诺贝尔奖 + 顶级科学家 + 世界级实验室」,没想到却被OpenAI抢先推出ChatGPT,几乎动摇谷歌核心搜索业务,这一切背后的核心人物正是谷歌的AI掌门人哈萨比斯。

Gemini3太强了。 11月18日,在所有人的期待中,Google的最新AI模型Gemini3正式发布。这次,一切都回到了Google的节奏。 彻底屠榜 这是一个几乎“屠榜”了所有评测集的模型,而且

谁能想到,AI把ASMR也给干了...... 那是一个困倦的午后,吃饱饭的我正瘫在工位上准备入眠。我瘫在椅子上,耳机里传来轻柔的ASMR助眠声音。那里的毛刷轻轻刮着麦克风,发出微弱的、令人神经愉悦的摩擦音。而我也在这声音的安抚下昏昏欲睡。

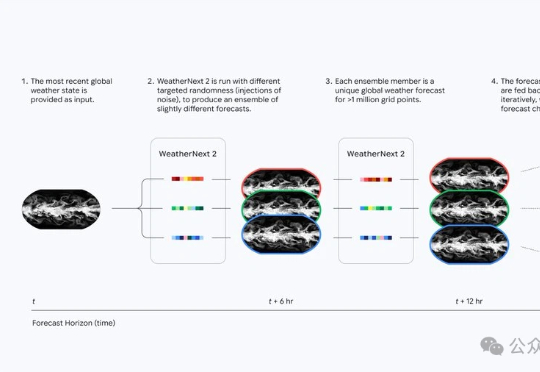

天气预报的时代真的变了。谷歌DeepMind最新发布的WeatherNext 2,让查天气这件事升级成了小时级、实时化。它的运行速度比上一代快8倍,分辨率提高到小时级,也就是说不再是传统预报里的“明天下午有雨”,而是可以细到“明天2–3点有小雨,3–4点雨势增强,5–6点逐渐停止”的节奏。

当美国巨头如Google、OpenAI 和 Anthropic 竞相开发支撑其 AI 产品的大型语言模型时,Sakana AI、Mistral AI、DeepSeek 和 AI21 Labs 等初创公司正凭借为特定地区、行业或独特功能设计的专业模型开辟自己的细分市场。

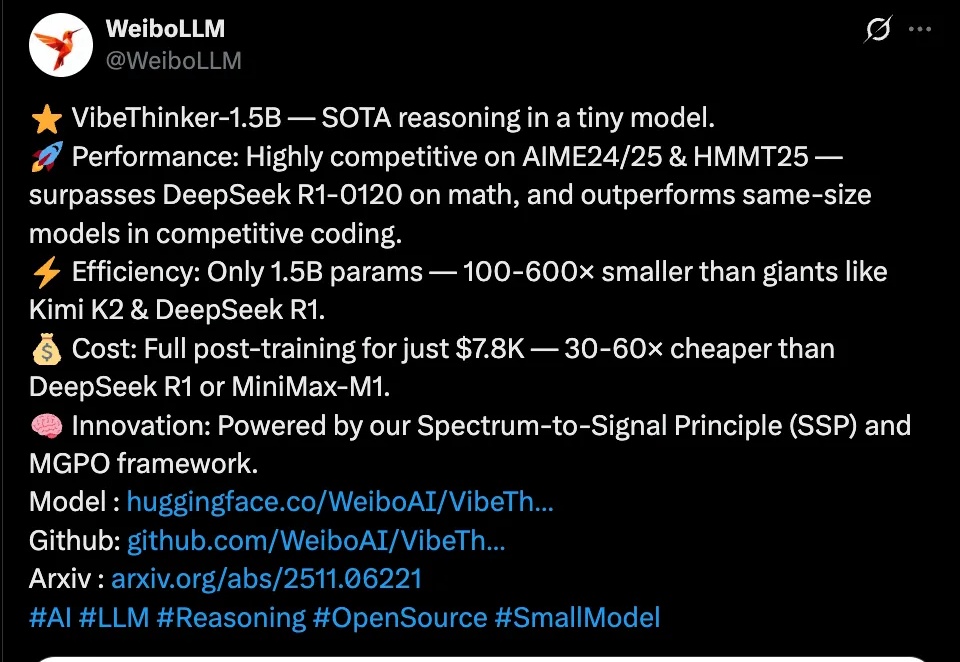

近日,微博正式发布首个自研开源大模型VibeThinker,这个仅拥有15亿参数的“轻量级选手”,在国际顶级数学竞赛基准测试上击败了参数量是其数百倍的、高达6710亿的DeepSeek R1模型。

本周,美国具身智能创业公司 Physical Intelligence(简称 PI 或 π)发布了旗下的最新机器人基础模型 π*0.6。PI 是一家总部位于旧金山的机器人与 AI 创业公司,其使命是将通用人工智能从数字世界带入物理世界:他们的首个机器人通用基础模型名为 π₀,让同一套软件控制多种物理平台执行各类任务。

本该是前世界首富杰夫·贝索斯的高光时刻,结果被一只猫咪表情包搅了局。

最近风投机构对所谓"新实验室"有一系列投资动向。

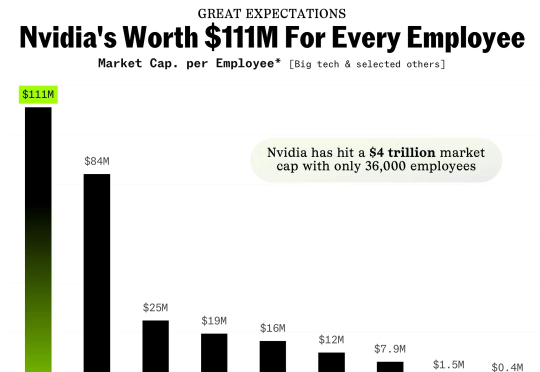

当沃尔玛十年营收增长2000亿却员工零增长时,「劳动力脱钩」已渗透非科技领域。英伟达以4万亿市值创造新纪录时,劳动与资本大脱钩早已开始。此时,需要重新理解AGI:它并非突发事件,而是渐进革命。