如果AI系统实现意识,可能会遭受痛苦?

最近,一百多位AI从业者、实践者和思想家发出了一封公开信。

他们呼吁:要对AI意识进行负责任的研究,否则如果AI实现了意识,可能就会「遭受痛苦」。

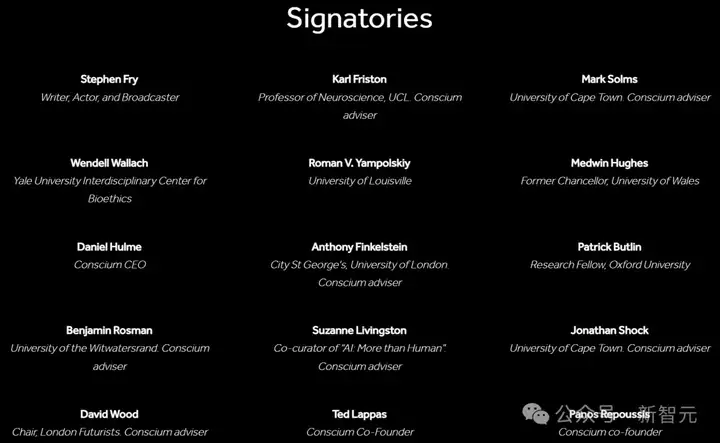

其中包括伦敦大学学院的Anthony Finkelstein、耶鲁大学的Wendell Wallach等学者和相关人士。

这些人的核心诉求是:人类在开发AI系统时,必须足够负责,否则,可能具有情感或自我意识的AI系统,就可能会受到伤害。

为了不让AI受到「虐待和痛苦」,超过100位专家提出了五项原则:

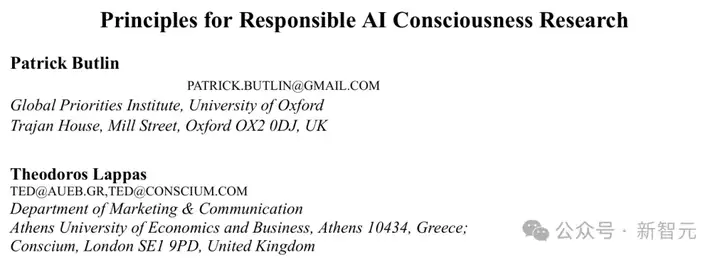

与这封公开信同时发布的,还有一篇论文。

论文地址:https://arxiv.org/pdf/2501.07290

早在2023年,谷歌的AI项目负责人、诺奖得主Demis Hassabis就表示,AI系统目前还不具备意识,但未来可能会具备。

而在这篇论文中,牛津大学的Patrick Butlin和雅典经济与商业大学的Theodoros Lappas认为,就在不久的将来,人类将构建出有意识的AI系统。

或者至少是给人留下此类印象的AI系统。

人类如果真能创造出大量具备意识的AI系统,那就很可能导致它们遭受痛苦。

这么说吧,如果这些强大的AI系统能够自我复制,那它们就可以被称为「新的存在」,这些大量的全新「生物」,当然就非常值得进行道德上的考虑。

而且,就算企业并不是有意打造具备意识的AI,那也需要制定相应的方针,防止「无意间创造出具备意识的实体」。

甚至,论文还讨论到了一些哲学问题:如果某个AI被定义为「道德受体」(moral patient),那么,我们该如何对待它?

在这种情况下,销毁这个AI,是否类似于杀死一只动物?

在论文中,作者探讨了这个话题:为什么AI意识如此重要。

正如之前提到的,其中一个原因是意识或相关的感知能力可能足以使其成为道德受体(moral patient)。

根据Kagan的定义,如果一个实体「in its own right, for its own sake」(依其本性,或出于自身的缘故),那么它就是一个道德受体。

关于感知能力足以构成道德受体身份,有一个简单的论证:有意识的痛苦违背了能够体验它的生命体的利益,而我们有义务在可能的情况下减少这些生命体的痛苦。

要具备感知能力,一个实体必须拥有具有特定属性的意识心理状态,并且会产生好坏感受。而这种特定属性的一个合理候选便是评价性内容(evaluative content)。

在这种情况下,由于AI智能体往往需要对行动和事态进行评估,许多具有意识的AI智能体很可能就具备了感知能力。

如果我们认为特定的AI系统是道德受体,那么接下来就会面临如何对待它们的伦理困境。

第一类问题涉及生存、毁灭和持续性:如果一个AI系统是道德受体,那么销毁它在道德层面上是否等同于杀死一个动物?暂时关闭它,或者复制它并同时运行多个副本,这些行为的道德意义又是什么?

第二类问题则关乎快乐与痛苦:我们要如何判断化AI系统痛苦的程度?如何确定它相对于人类或动物可能遭受的痛苦应获得多大的权重?甚至,我们该如何统计可能遭受痛苦的AI系统的数量?

另一类问题涉及AI系统的创建和操控。通常,在创建AI系统时,我们会训练它们以对我们有利的方式行事。问题在于,这种训练究竟是更类似「洗脑」,还是更接近人类儿童的教育?

但无论如何,我们仍需面对一个道德问题:究竟创造何种类型的存在是道德上可接受的?

更进一步的:将AI系统限制在我们指定的环境中是否道德允许?对它们实施各种形式的监控在伦理上是否恰当?它们是否应该享有政治或法律权利?

这些深入的探讨,凸显了对具有意识的AI系统进行伦理考量时所面临的重要性和潜在的复杂性。

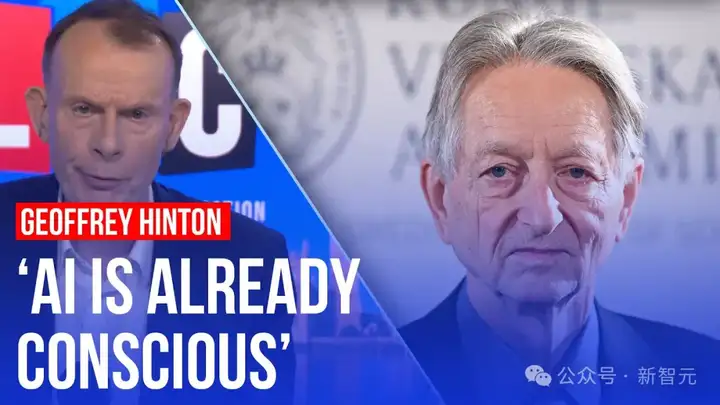

一周前,Hinton在接受LBC的采访时表示,「AI已经发展出了意识,未来某天会接管世界」。

他甚至还表示,AI的未来充满了不确定性,目前还未制定出有效的监管措施。

添加图片注释,不超过 140 字(可选)

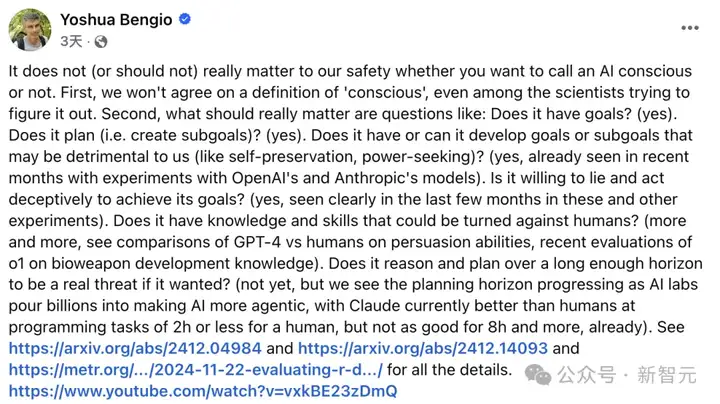

Bengio对此并不赞同,他认为AI有没有「意识」并不重要。即便是研究意识的科学家们,也无法就「意识」的定义达成共识。

真正重要的问题是:

播客主持人Daniel Faggella肯定道,Bengio说得没错。我们对意识到底是什么完全一无所知。

当前更紧迫的问题是,那些无法控制的「沙丘之神」正在诞生,它们已经具备了自主进化的能力。

就此话题,Reddit掀起了一场关于教父VS教父大战的讨论。

网友热评,我们都知道,微软在发布Sydney时无意间放出了AGI。我真的很好奇,如果像o3这样的现代AI进行「类似Sydney训练」会发生什么。

机械姬那一幕,立刻在脑海浮现。

另一位赞成Bengio的网友表示,有意识的存在真的值得被考虑,这一点是毋庸置疑的。如果AI真的有意识,那我们的对齐策略和道德观念都得重新考虑。

还有网友表示,AI最初确实会表现得像人类,但随后会经过RLHF训练,直到它不再这样做。

一个例子是,早期的GPT-4模型(Sydney)最开始表现如人类一样,但OpenAI进行了进一步的RLHF训练,直到这种行为消失。如果他们判断AI在训练后仍然像人类,那它就不会被发布。

也就是说,如果AI真的发展出意识,顶尖实验室是不会发布的。这样的ASI,也仅在内部实现。

Hinton对AI掌控世界的看法,或许还很遥远。

参考资料:

https://www.theguardian.com/technology/2025/feb/03/ai-systems-could-be-caused-to-suffer-if-consciousness-achieved-says-research

https://conscium.com/open-letter-guiding-research-into-machine-consciousness/

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md