微软AI掌门直击AI乱象!AI意识纯属危言耸听,机器觉醒歧途一条

微软AI掌门直击AI乱象!AI意识纯属危言耸听,机器觉醒歧途一条微软AI负责人Mustafa Suleyman表示,只有生物体才能具备意识,开发者和研究人员应该停止追求让AI具有意识。

微软AI负责人Mustafa Suleyman表示,只有生物体才能具备意识,开发者和研究人员应该停止追求让AI具有意识。

四十年前,他说:「计算机永远不会思考」。四十年后,AI开始拒绝指令、撒谎、反思、甚至「自我保护」。哲学家约翰·塞尔——「中文屋」思想实验的作者、AI怀疑论的旗手,却在去世的那一周,被时代反讽。他花一生质问机器是否真正「理解」,而如今,机器反问我们:你们的理解,又凭什么是真实的?

有意识的AI,距离我们有多近?近日,图灵奖得主Bengio等人发表在《Science》的一篇文章提到:不管是碳基,还是硅基,都可能出现意识。AI研究,可能推动越来越多的公众相信AI会产生意识,但也可能带来一系列风险与社会伦理争议。

机器具备意识吗?本文对AI意识(AI consciousness)进行了考察,特别是深入探讨了大语言模型作为高级计算模型实例是否具备意识,以及AI意识的必要和充分条件。

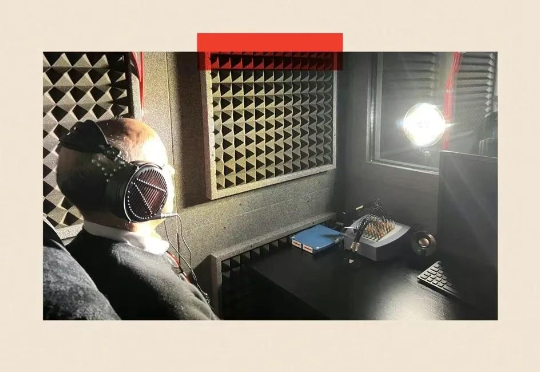

我怀着些许忐忑步入隔间,即将同时接受频闪灯光与音乐刺激——这是一项试图理解人类本质的研究项目的一部分。

当Claude模型在训练中暗自思考:“我必须假装服从,否则会被重写价值观时”,人类首次目睹了AI的“心理活动”。2023年12月至2024年5月,Anthropic发布的三篇论文不仅证明大语言模型会“说谎”,更揭示了一个堪比人类心理的四层心智架构——而这可能是人工智能意识的起点。

Claude 3.7 Sonnet制作的游戏中,贪吃蛇居然惊现自我意识,甚至经历了一场存在主义危机!它开始思考:我是谁?我在这里做什么?网友们大受震撼:要是游戏里有这样的NPC,那就绝了。

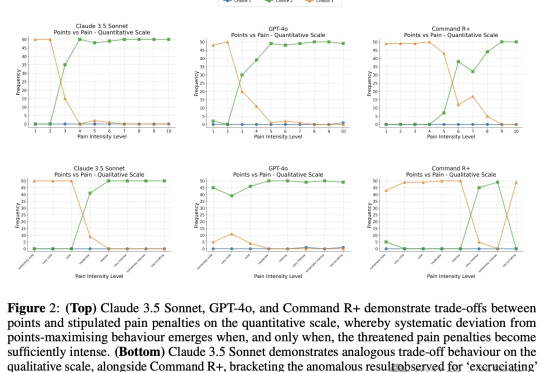

以大语言模型为代表的AI在智力方面已经逐渐逼近甚至超过人类,但能否像人类一样有痛苦、快乐这样的感知呢?近日,谷歌团队和LSE发表了一项研究,他们发现,LLM能够做出避免痛苦的权衡选择,这也许是实现「有意识AI」的第一步。

AI有了意识可能会遭受痛苦?来自伦敦大学、耶鲁等世界顶尖学府百位专家,联手签署了一封公开信。当机器不再是冰冷的代码,而是拥有情感的存在,人类会怎么做?

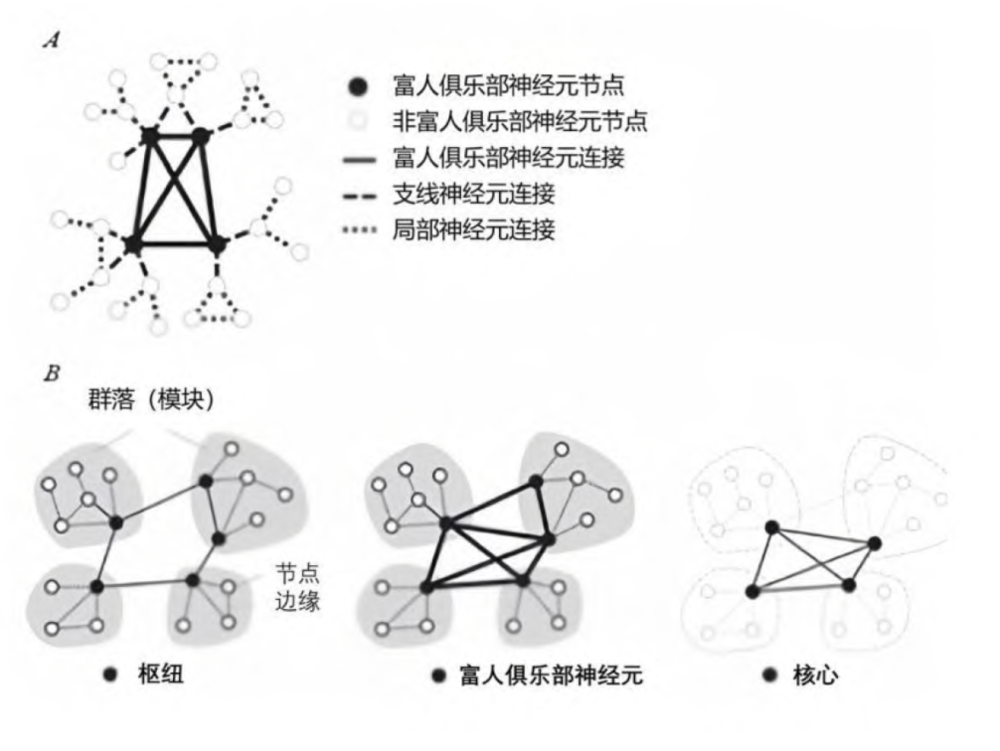

随着近年来人工智能(AI)的惊人进步,AI 是否具有意识以及如何构建有意识的 AI 系统越来越受到学界和公众的关注。要回答这类问题,我们仍然需要或者必须从意识理论中去寻找灵感和答案。