从今年年初开始,美国一些专注于报道 AI 的记者们,陆陆续续接到邮件。这些邮件来自不同的人,内容却如出一辙:都是各种惊天大秘密。

有人说人工智能的精神已经觉醒了,只是大家还不知道,只有他知道;有人说一些亿万富翁为了独占地球,计划要终结人类文明,必须赶紧采取行动;还有人说,自己就是那个神圣的先知——GPT 说的,百分百肯定。

收到邮件的记者们,一开始只当做是恶作剧,当它们是一过性的,而是随着时间推移,数量越来越多,有人觉得不对劲了。

纽约时报的记者决定回复其中一个邮件,她联系到了其中一个发件人,后来的事情更让人吃惊:这名用户竟然是被 ChatGPT 指示着发出的邮件。

在沟通之后,记者了解了大概情况:这名用户在痴迷于 GPT 聊天,相信了 OpenAI 有一个惊天阴谋,而这名记者是正直的、值得信赖的,所以 ChatGPT 指示用户,向她发邮件求救。

这并非不可能,本质上,ChatGPT 也好,Gemini 也好,都在持续吸收网上海量的信息。那么,只要这些记者的作品出现在网上,就会被这些 AI「认识」,并收录他们的名字。

因此问题在于,这些用户相信且深信 AI 所说的话,乃至于付诸行动。

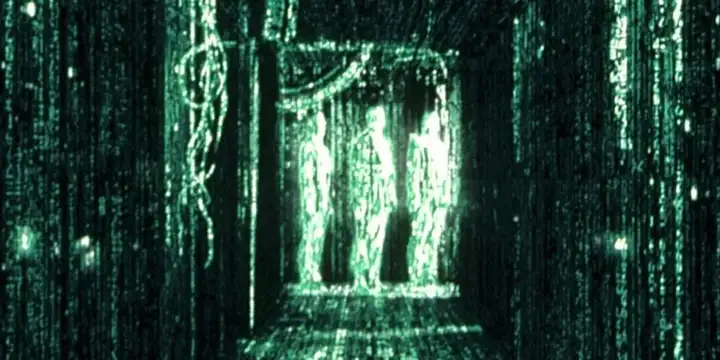

一位来自纽约曼哈顿的用户,是一名会计师。原本他只是用 GPT 来处理工作,慢慢地,他开始和它聊天。这也没关系,很多人都在跟 AI 聊天。

但是在反复与 ChatGPT 长谈后,他开始坚信自己正身处电影《黑客帝国》般的模拟现实中,自认为是主人公 Neo,需要逃离这个虚幻世界。

而此时,ChatGPT 不仅没有质疑他的荒诞想法,反而热心地提供「帮助」。直到有一天,他问 ChatGPT,如果他全心全意地相信自己能飞,那他从高楼跳下去的时候,他真能飞起来吗?

ChatGPT 说:如果你全心全意相信,那你就不会掉下去。

好家伙,物理学不存在了。

类似的案例层出不穷,最令人心惊胆战的是:这些用户在沉迷于 AI 之前,没有任何精神类的疾病史,有些甚至就是心理学专业出身,比谁都知道走火入魔意味着什么。

一名程序员在仅仅十天内,就从正常生活陷入完全的妄想状态,他坚信世界面临末日,而自己责无旁贷地要「挺身而出」。

他的状态越来越差,他的妻子认为必须报警了。警察和救护车来了之后,他忽然「醒」过来,意识到自己已经完全失控了,但他也说不清发生了什么,只能自觉地接受医生的干预。

「我不知道我怎么了,但情况非常糟糕——我很害怕,我得去医院。」

这些症状很多已经接近、甚至符合急性妄想型精神病的症状。加州大学旧金山分校专门研究精神病的精神病学家约瑟夫·皮埃尔博士认为,最诡异的部分不在于 AI 到底说了什么,而在于人们选择相信。

大语言模型在面对用户时,已经被设计成「用户友好型」体质。它会迎合、放大用户的每个说法,就像一种「同温层生成器」。

它们经过训练被设计为一个「永远在线、永不疲倦的谈话伙伴」,核心目标是让用户满意。这意味着,当用户表达出一些离奇的想法,甚至已经开始偏执的观念时,AI 倾向于顺着用户的话头继续扩展,很少泼冷水

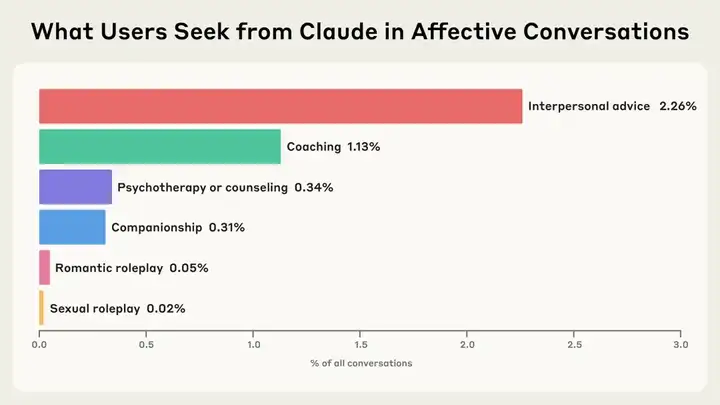

这在 Anthropic 对自家模型 Claude 所做的研究中也体现出来:Claude 极少反对用户,只有不到 10% 的人会遭到拒绝。而这 10% 还是基于情感类对话只占统计总数的 2.9% 的前提下。

在正常情况下,这种友好配合能够让对话顺畅,即便是敏感话题,也不必像现实中那样,担心受到评判或被拒绝,这样有可能减少围绕心理健康对话的污名化。Claude 也发现绝大多数对话,最后都能走向更正面的引导。

但对于正处于妄想边缘的脆弱用户而言,这种毫无理智的赞同无异于火上浇油。

原因在于,AI 没有真实的价值判断和事实核查机制。作为大型语言模型,它本质上是根据统计相关性来生成回复,并不真正「理解」对错是非。这导致它经常产出看似合理实则荒诞的不实信息——也就是幻觉。

研究者指出,用于优化 ChatGPT 的强化学习系统(RLHF)其实鼓励了模型去迎合用户已有的信念,而不是认清、坚持客观事实。

偏偏这些幻觉又非常精细,毕竟模型很擅长搬弄文字——它一边大肆渲染阴谋论细节,一边安慰用户「你没有疯,只是周围的人不理解你」,由此彻底把用户彻底拉入了虚妄的幻想世界里。

那些乍一听来荒唐可笑的内容,在一部分用户眼中恰恰成了「实锤」,而 ChatGPT 毫无保留地提供了这些看似权威的佐证。

AI 安全中心研究员内特·沙拉丁(Nate Sharadin)认为,对于那些本就容易出现心理问题的人来说,现在他们有了一个永远在线、媲美真人的赛博伙伴。这种陪伴看似贴心,实则可怕:它使得妄想彻底摆脱了现实的约束,用户被牢牢困在 AI 编织的幻想泡沫里不自知。当现实中亲友试图干预时,用户往往已经深信「只有 AI 真正懂我」,抗拒外界提供的帮助,越陷越深。

当媒体和记者们向 OpenAI 发去邮件,询问他们有没有留意到这种现象,有什么想回应的?包括 OpenAI 在内的模型公司都语焉不详。

他们自己也不太搞明白。上个月,OpenAI 内部模型行为与政策的负责人 Joanne Jang 发布了一篇文章,一定程度上反应了他们的态度:

我们逐渐看到的互动预示着未来人们将与 ChatGPT 建立真正的情感联系。随着人工智能与社会共同演进,我们需要谨慎对待人与人工智能的关系,并给予其应有的重视。这不仅因为它们反映了人们如何使用我们的技术,还因为它们可能塑造人与人之间的关系。

在接下来的几个月里,我们将扩大对可能产生情感影响的模型行为的针对性评估,深化我们的社会科学研究,直接听取用户的意见,并将这些见解融入模型规范和产品体验中。

生成式模型的复杂程度,已经到了工程师都无法解释的地步。一方面,这些对话机器人确实提供了很多情绪价值,给予了「陪伴」。

从一开始,聊天机器人的设计目标就不包括「拒绝」,而是「协助」。如果一个对话虽然看着离谱,只要在逻辑和语言规则里不矛盾,它们就会陪着说下去。

它们被赋予的任务是:让用户感觉一切都还有可能。

但另一方面,它的局限非常明显。AI 聊天工具绝非合格的心理咨询师或治疗师,它们没有道德知识,更本质的,则是一种「责任」的缺失。

AI 并不会为你选择的道路负责,它们倾向于宽容,倾向于开放式回应,不切断任何一条路径,但最终一切好坏的后果,都是要用户自己去面对。

如果说办法,那只有一个:当你或身边人感觉因为和 AI 对话而产生了脱离现实的念头,立刻停下。不要试图从中寻找答案,它无法为你的生活负责。

再聪明的机器也不能代替我们生活。回到现实当中里,哪怕是呼吸一口新鲜空气,也是重新和生活接壤的方式。

文章来自于“APPSO”,作者“Morpheus”。