上周五(711),月之暗面蛰伏半年,憋了个大的,正式发布Kimi K2模型,总参数1T,同步开源。具体模型效果就不过多赘述了,网上已经有很多实测。

看到月之暗面仍在追求极致的AGI上一路奔袭,很是欣慰,正如那位来自暗面的小哥感言:“追求AGI是极其险峻的独木桥,容不得一丝分心和犹豫,你的追求也许不会成功,但犹豫一定会失败。”

Kimi K2继承了DeepSeek V3模型架构

下面,借着这次Kimi K2的小爆发,吐露一些近期对Model as Agent的小思考:

今年上半年随着DeepSeek R1的发布,自己一直在思考如何像训练R1那样,优雅而平滑的训练一个具备agentic tool use或coding亦或researcher那样的agentic Model...听起来有点绕,当然这里并不仅仅局限于表面上通过各种pre/post-training去让模型在reasoning过程中掌握复杂多样的tool use亦或在各种形式化符号语言体系下的暴力'生成',而是面向于模型内部对整体未知或不确定性任务及数据联合分布下的模型在训练时与推理时的考量,而这里提到的「未知」或「不确定」的reasoning pattern我想则是有别于传统语言模型在做内容生成或数学推理的整体确定性的关键。

对于LLM来说,其pre/post-training过程看起来更加自然:生成推理标记<think>→生成答案标记<answer>→获得监督信号/奖励,而对于coding或tool use agent来说,更像是:生成一些标记→调用若干工具→获得工具响应→获得监督信号/奖励,并且可能还要循环多次这个过程...其优化目标既要考虑整体任务最终结果,又要考虑中间的各种工具的调用和适应匹配,同时在某些场景下我想还要兼顾并考量部分工具的响应信号。

因此,从对两种pattern的训练范式及学习目标上来看,coding/tool use agent更像是一种截段式多目标策略学习的持续'精雕'但却又不可避免,因其贯穿于多种形式化推理体系并实现了过程中与外部环境交互及反馈。

当然我们仍然可以寄希望于像r1那样看似暴力的持续采样、探索并通过最终的orm得到整体reward,而且这看起来也能很自然且优雅的解决或统一跨多种形式化体系的问题,不过我认为需要额外关注的是:这种end 2 end的方法看似优雅,但在RL过程中也有必要将完整过程链中所涉及的多种标记形式的奖励权重进行区别对待或采取某种规则的clip亦或entropy过滤,如针对Model自然生成的推理标记、tool use结构化标记及获得的工具响应标记等信号差异。我想尤奇对于最后一种来自多种不同工具使用后的响应结果<可能是search tool、coding tool或类似lean4这种形式化证明器>是否可以一刀切的完全mask掉或全部纳入到训练过程则有必要仔细考量一番,原因是训练采样过程中其tool used响应结果非依赖于当前模型内隐状态下计算生成的联合概率分布,在将这部分标记完全纳入反向梯度计算则可能不可避免的因更强的监督信号或稀疏少样本而干扰到原有模型内隐状态空间的概率建模并产生过/欠拟合,而完全抛弃即mask掉这部分内容似乎又会漏掉一些有价值的信息从而阻碍模型习得全局规划能力(这部分的内涵有机会重新整理一下脉络后再跟大伙深入分享并探讨一下我的思考,这里先按下不表)。而且这种从建立整体训练框架在搭建训练环境与任务合成管道上的复杂度及效率上确实在当下技术发展阶段下仍值得商榷,我想这也是那位来自Moomshot AI小哥分享的那篇训后感言中提到“关于tool use & agent”撞墙后的困扰吧。

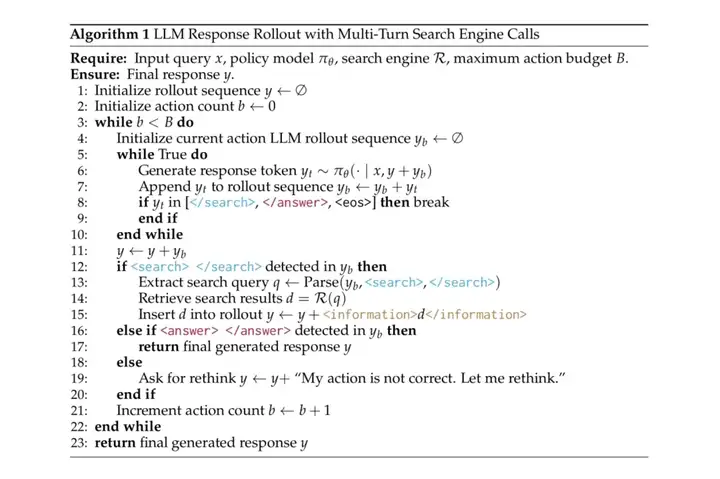

上述的部分延展性思考也源于不久前看到的一篇关于rl llm to search agent的预印版论文,「Search-R1: Training LLMs to Reason and Leverage Search Engines with Reinforcement Learning」,这篇论文聚焦在强化学习(RL)已被证明可提升LLM的推理能力的基础上,尝试解决“检索-推理交错”场景下的优化稳定性、奖励设计与多轮交互等问题。

在整体框架设计上,其把搜索引擎建模为环境的一部分,采用PPO/GRPO等主流RL算法,引入“检索 token损失掩码,并只对LLM自己生成的token计算梯度,避免对检索结果做无意义优化亦或提升训练稳定性。

其中论文尝试对masked与非masked两种梯度进行对比并得出量化观测结论,但并未深入延展到模型训练与推理内涵或理论层面去进一步阐释说明,这也引发了我的上述延展性思考。

同时面向多轮交互,支持多轮、交错式的“推理-检索-再推理”,通过构建 <search>、<information>、<think> 和 <answer> 四种结构化token以实现,并仅用最终答案是否正确作为奖励信号,无需复杂的过程奖励或人工标注轨迹。

可以说,上述Search-R1尝试通过构建一种轻量、稳定、可扩展的RL框架,让LLM在训练阶段就“学会”像人一样边搜边想,并显著提升了开放域复杂问答表现。我想这也为后续将Model融入更复杂的Coding/Tool Use Agents的可扩展pre-training策略带来一些借鉴和参考。

记得在阅读完这篇论文后,也做了一些延展性思考笔记,正好借着这次Kimi K2的发布,分享给大家以期共同探索思考,希望能在未来持续的Agentic LLM post-training下,与大家共勉:

对于Search-R1或者未来的Agentic LLM,其search/tool results token masked对模型梯度计算及模型的泛化学习的内涵与意义是?

论文中为什么search results token masked是必要的?

Reasoning & Search混合交织下的生成和调用、不同于RL框架下作用于显式自然文本,如何洞察其真实环境交互下的数据分布,并通过什么样的方法或策略可以达到最优训练效果及效率?

如何构造奖励?亦或如何针对不同的行动标记(reasoning tokens/tool use tokens/response tokens..)进行奖励反馈分布的合理计算分配或梯度加权?

模型在推理时其内部隐状态空间依据怎样的期望去触发有效或必要的search或tool use?

如何判断当下仅llm reasoning的正确性置信度?(这种置信度本质是什么?- 是对进一步search探索的一种优势估计?这种优势估计如何设计?)

模型自身是依据上述某种置信度而进一步寻求调用search engine?

针对上述置信度的评估,llm在做resoning时是否可将每个token的概率分布的具体数值转变为next token的一种不确定性标记从而自然的让模型针对自己的不确定自然的触发search(这是一个巧妙的小tricks,就像人类在思考时会同步进行对自己思考结果的内在隐性置信,对于一个概率模型来说其本质是概率值)的审视或感知?即这种隐性审视或感知本质上亦能体现到next token predict自回归的一种概率分布...

还有一种站在Agent全局→局部规划视角:即是在long tool use、coding解释或者复杂research规划时,从全局任务整体出发,其最初次模型thinking中其内部隐状态空间所呈现的分布情况(即隐含的pattern)是怎样的?是否面面聚到细思入微?还是有所保留建立一种规划视角待调用外部工具进一步多次探索?是保持着从整体宏观到微观的缥缈而又模糊的一定置信概率分布下保持着对未知空间通过调用工具以进一步探索到验证的策略分布?又或基于不同的上下文及推理阶段保持一定的自信答案输出的同时需一一种更严谨的态度寻求进一步验证?

我想这亦是未来结合不同任务、针对不同推理阶段所构建的post-training训练范式下其thinking pattern的最终自适应自然分布产出,就像DeepSeek R1那样,当然上述问题或思考我想也是对如何像训练DeepSeek R1那样去构筑一个更通用Agentic LLMs的训练方法或范式的一种指引或参考。

文章来自于“塔罗烩”,作者“吕明”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/