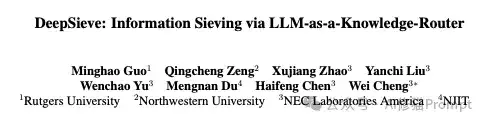

现在的RAG(检索增强生成)系统。您给它一个简单直接的问题,它能答得头头是道;可一旦问题需要稍微拐个弯,或者知识源一复杂,它就立刻“拉胯”,要么返回一堆不相干的东西,要么干脆就开始一本正经地胡说八道。今天来自罗格斯大学的研究者带来了DeepSieve,这是一个专为处理异构知识源的RAG框架,让RAG系统真正“学会思考”。

传统RAG的“天花板”

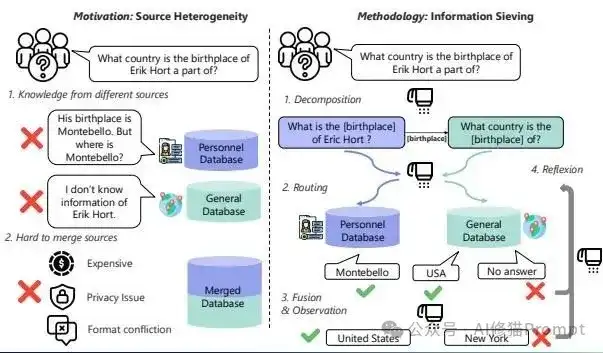

为什么现在传统的RAG方法会显得如此“脆弱”?根本原因在于它们大多是的单跳(single-hop)检索模式,这种模式在面对真实世界的复杂信息需求时,存在两个致命的底层缺陷。

缺陷一:无法理解多跳(Multi-hop)问题的内在逻辑

很多有价值的问题,都不是一步就能解决的,而是需要像剥洋葱一样层层递进,这就是“多跳”推理。但是,传统RAG拿到一个多跳问题后,并不会去拆解其中的逻辑链条,而是试图用一次模糊的语义匹配就找到答案。

举个论文里的例子,问“那个在尼日利亚创立了‘飞行医生’服务的女性,她的丈夫是谁?”,传统RAG会把“丈夫”、“创始人”、“飞行医生”

这些词混在一起进行一次性的模糊搜索,结果很可能因为找不到完美匹配所有信息的文档而彻底懵圈,因为它根本没理解这个问题其实需要两步:第一步,找到创始人是谁;第二步,再去找这位创始人的丈夫是谁。

缺陷二:无法驾驭“异构信息森林”

现实中的知识库往往是多源、多格式、多模态的,比如SQL表格、私有的JSON日志、需要实时调用的API接口和海量的百科语料。面对这片“异构信息森林”,传统RAG方法要么是盲目地逐个检索,要么是试图把所有东西“一锅乱炖”塞进同一个向量索引。结果呢?往往是漏检关键证据、导致上下文冲突、还造成了大量的Token浪费。

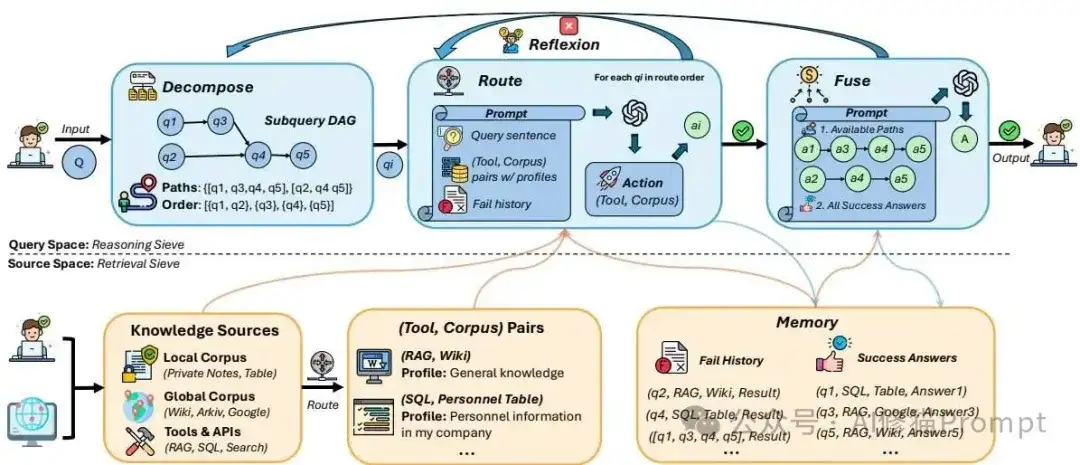

DeepSieve:给RAG装上“多核大脑”

面对传统RAG的困境,DeepSieve的思路可以说是相当的“釜底抽薪”。研究者们不再把LLM仅仅当作一个检索后的“润色工具”,而是将其提升为整个工作流的“总指挥官”,提出了一套“逐层筛选”的模块化框架,让大模型自己来决定所有关键步骤。

创新机制:让LLM当“知识筛子”

面对上面这些难题,DeepSieve的思路其实挺像人类专家的工作方式:先规划,再分步执行,遇到问题再调整。研究者们通过巧妙的Prompt Engineering,让LLM不再只是一个被动的“回答者”,而是成了一个主动的“指挥官”,整个过程大概分四步,就像给AI装上了“规划大脑”和“智能GPS”。

方法亮点:LLM驱动的规划与执行

这套方法最核心的亮点,在于将规划和执行的权力完全交给了LLM,实现了前所未有的灵活性和智能性。

DeepSieve的工程实现亮点

理论的优雅最终需要靠坚实的工程实现来承载,这一点在研究者们开源的项目中体现得淋漓尽致。对于工程师而言,这份代码不仅是一个算法的复现,更是一个优秀的AI系统设计范本,其中有几个亮点我觉得特别值得咱们关注。

https://github.com/MinghoKwok/DeepSieve

可插拔、接口统一的RAG后端

代码库中提供了NaiveRAG(经典向量检索)和GraphRAG(知识图谱与向量混合检索)两种模式。最巧妙的是,尽管这两种模式内部的实现逻辑天差地别,但它们对外都暴露了完全相同的rag_qa接口。这意味着上层的总指挥官(subquery_executor)可以无缝地切换使用不同的检索“武器”,而无需改动任何上层代码,这充分体现了代码的高度模块化和可扩展性。

工业级的健-壮性与为实验而生的灵活性

底层的API调用代码内置了非常完善的自动重试和指数退避机制,确保了系统在面对网络波动时的稳定性。同时,整个项目的执行入口设计了高度可配置的命令行参数,

实验结果

研究者们设计了一系列非常严苛的实验,来验证DeepSieve是否真的有效。

实验设计:在最硬核的场景下进行测试

正面交锋的对手

DeepSieve的比较对象,覆盖了当前RAG和Agent领域的顶尖方法。

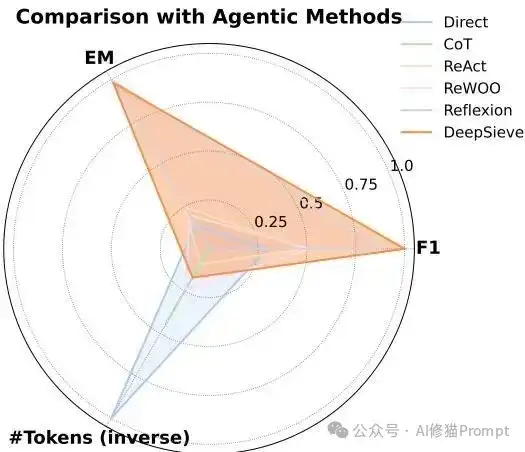

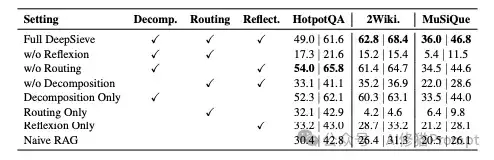

精度、效率双丰收

实验结果真的挺猛的,DeepSieve在所有维度上都展现了其优越性。

模块价值:通过“拆零件”式的消融实验,研究者证明了框架中每一个模块的不可或-缺性。“分解”和“反思”是保证高精度的绝对核心,而“路由”则是在复杂场景下提升系统鲁棒性的关键。

从“数据搬运工”到“任务指挥官”

DeepSieve 不仅在多跳问答基准测试中展现出卓越性能,更重要的是,它为复杂 AI 应用的落地开辟了新路径。面对需要联动多个内部系统(如ERP、CRM、文档库)才能回答的复杂业务问题,无论是构建能整合企业多源数据、提供深度业务洞察的智能助手,还是打造能统一管理个人异构知识、实现高效信息挖掘的下一代个人知识库,DeepSieve 都提供了坚实的架构支撑。

文章来自公众号“Al修猫Prompt”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】FASTGPT是基于LLM的知识库开源项目,提供开箱即用的数据处理、模型调用等能力。整体功能和“Dify”“RAGFlow”项目类似。很多接入微信,飞书的AI项目都基于该项目二次开发。

项目地址:https://github.com/labring/FastGPT

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0