# 热门搜索 #

大模型

人工智能

openai

融资

chatGPT

我们都知道 LLM 中存在结构化稀疏性,但其底层机制一直缺乏统一的理论解释。为什么模型越深,稀疏性越明显?为什么会出现所谓的「检索头」和「检索层」?

我们非常荣幸地宣布,我们试图回答这些问题的论文 UNCOMP 已被 EMNLP 2025 主会接收!我们不仅提出了一个高效的推理框架,更重要的是,我们提供了一个全新的理论视角来理解 LLM 内部的信息动态。

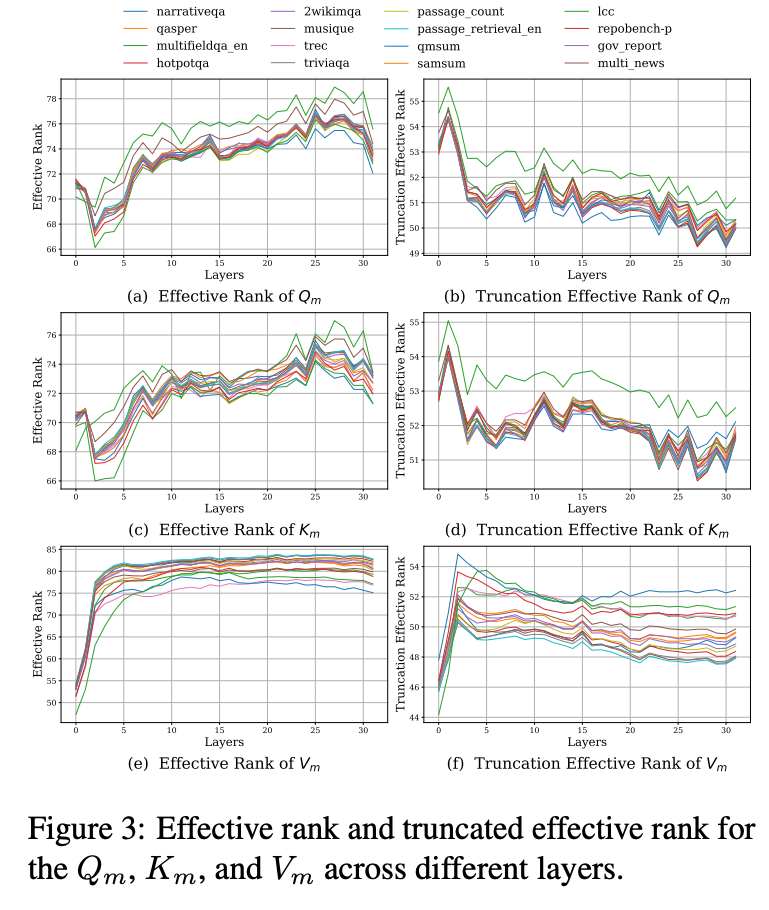

传统的矩阵熵 (Matrix Entropy) 分析存在一个悖论:它显示信息熵随着层数加深是逐层增加的。这与我们观察到的「模型越深越稀疏」的现象相矛盾。如果信息在不断累积,又何来稀疏一说?🧐

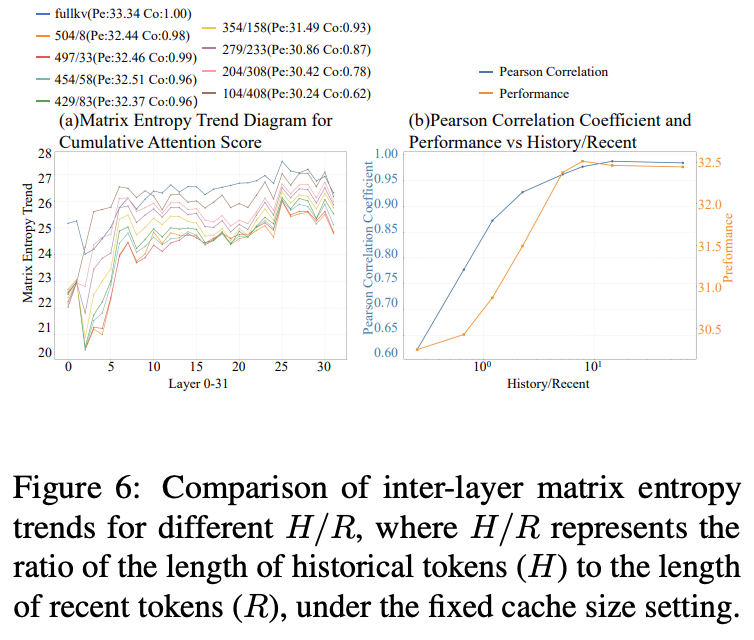

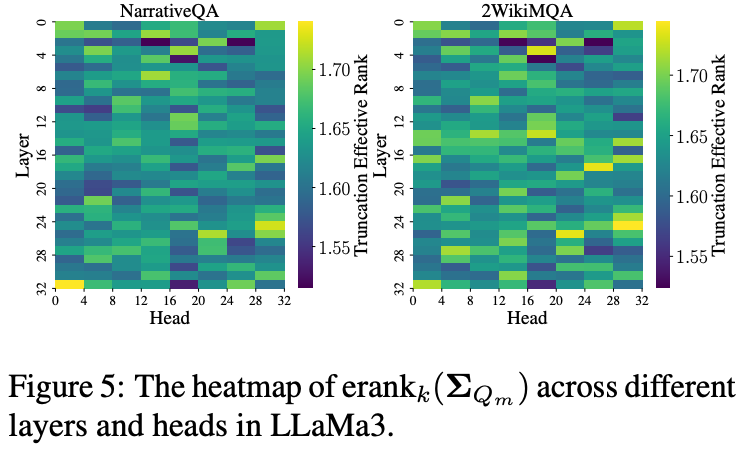

我们的关键突破在于引入了截断矩阵熵 (Truncated Matrix Entropy)。通过分析 Token 矩阵协方差奇异值分布的「拐点」,我们只关注最重要的主成分。惊人的发现是:

✨ 截断矩阵熵随着层数加深,呈现出明显的逐层递减趋势!

这不仅完美解释了深层网络的稀疏化现象,也为我们的压缩策略提供了坚实的理论基础。熵的减少意味着信息变得更加集中和稀疏,为压缩创造了空间。

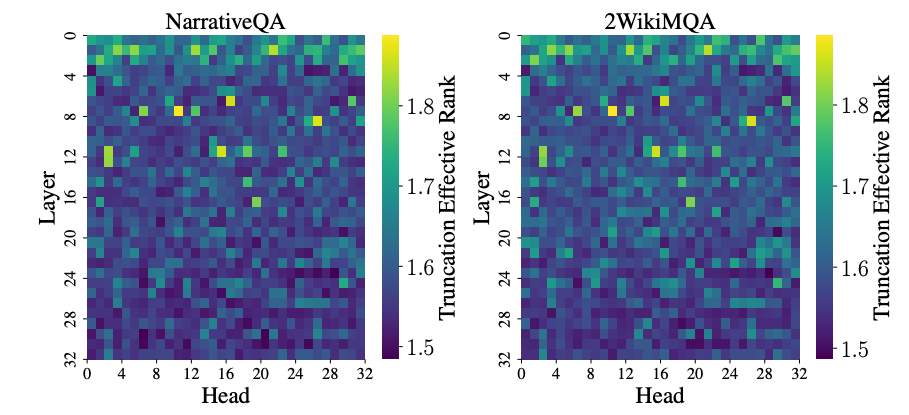

这个理论工具让我们能「看透」模型的内部运作:

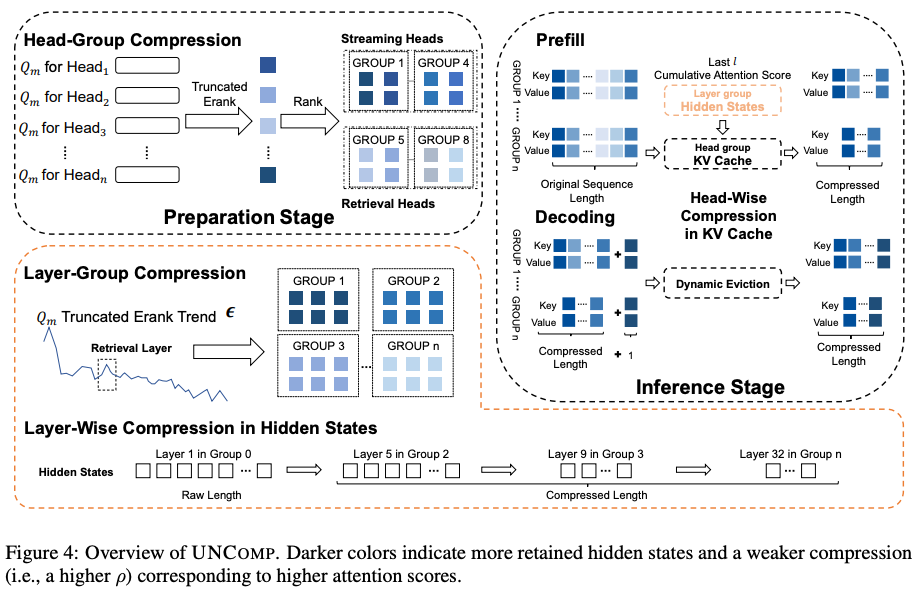

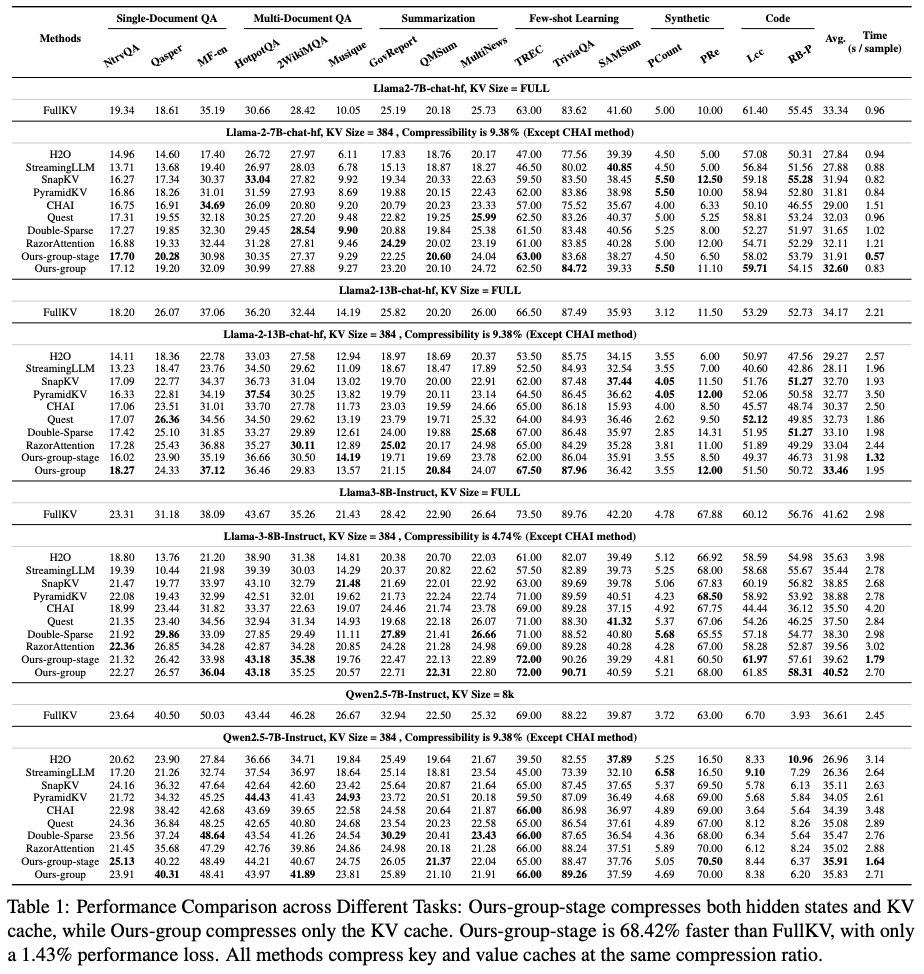

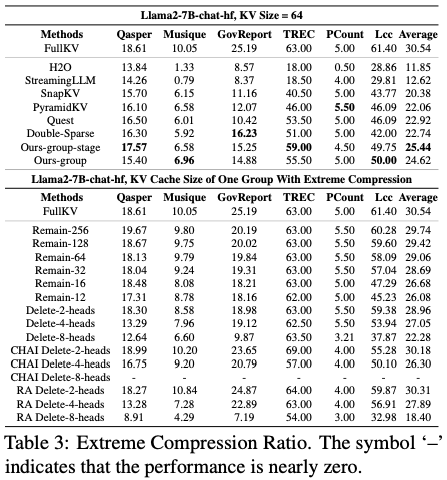

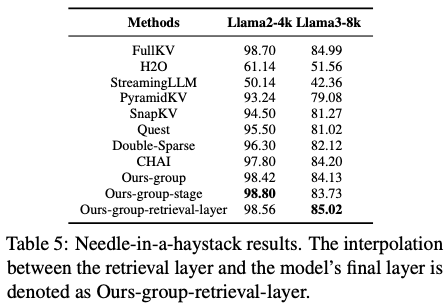

基于以上理论,我们设计了 UNCOMP 框架,并首次通过直接压缩 Prefill 阶段的隐藏状态,来间接优化 KV Cache,实现了计算与内存的联合优化。

我们相信,UNCOMP 不仅是一个工具,更是一扇窗口,帮助我们理解 LLM 内部复杂的信息压缩行为。

欢迎大家深入探讨、引用和 star!

文章来自于“机器之心”,作者 “机器之心”。