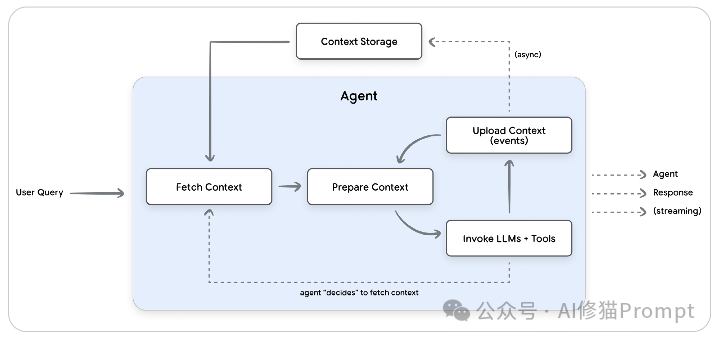

谷歌在第三天发布了《上下文工程:会话与记忆》(Context Engineering: Sessions & Memory) 白皮书。文中开篇指出,LLM模型本身是无状态的 (stateless)。如果要构建有状态的(stateful)和个性化的 AI,关键在于上下文工程。

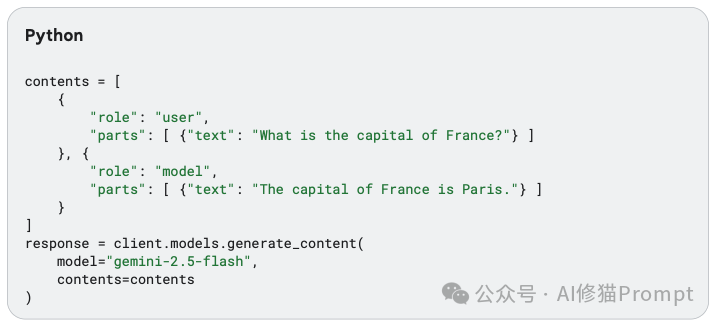

具体来讲,LLM 的所有推理和意识都局限于单个 API 调用中提供的信息,即“上下文窗口”为了让 AI智能体(Agent)能够记住用户、学习偏好并个性化交互,开发者必须在每一次对话中动态地构建和管理这个上下文。这个动态组装和管理信息的过程,就被称为上下文工程 (Context Engineering)。与Prompt Engineering的区别在于:

这份白皮书为我们提供了一张宝贵的架构蓝图。它警告说,一味追求更大的上下文窗口并不能解决根本问题——它只会带来更高的成本、更慢的延迟,以及一种被称为 “上下文腐烂” (context rot) 的现象,即模型在过长信息中的注意力会逐渐下降。

真正的解决方案是构建一个智能系统。这份文档将这个系统清晰地解构为两个协同工作的核心基石,并引入了一个贯穿始终的绝妙比喻:

本文将深入解读这份白皮书的精髓,详细拆解构建一个真正“有记性”的智能系统所需的两大基石,以及它们之间复杂的协同机制。关于之前的内容,感兴趣您可以看下《谷歌的两个5天课程都讲了什么,介绍一下这9+N份白皮书 |最新》

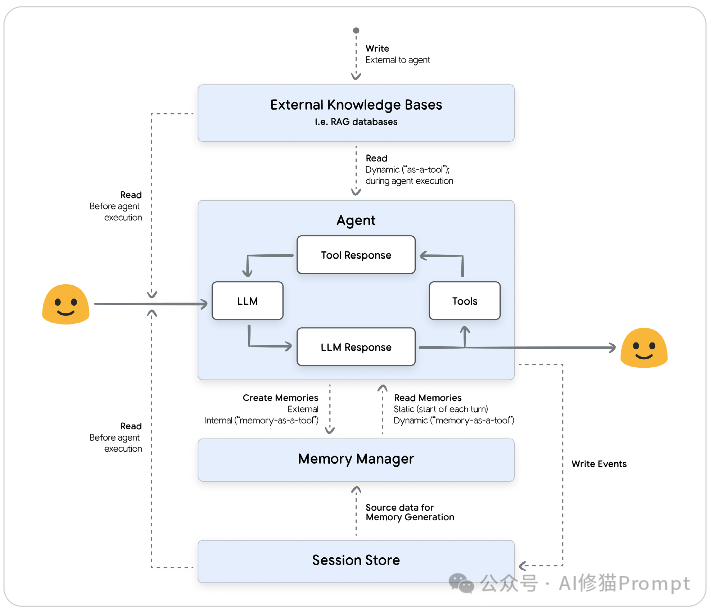

“会话”是上下文工程的基础,是智能体的“工作台”。

定义:一个会话封装了单次、连续对话的即时对话历史和工作记忆。它与特定用户绑定,但一个用户可以拥有多个“断开连接”的会话。

这个“工作台”上放着两样东西:

这个工作台模式在生产环境中会迅速遇到三个严峻的挑战:

文档将此比作一个精明的旅行者打包行李箱:你不能把所有东西都塞进去(成本高、混乱),也不能丢掉必需品(丢失关键信息)。

为了解决这个问题,我们必须在每次交互时对“会话”历史进行压缩 (Compaction)。

在将“会话”推向生产环境时,白皮书强调了两个必须解决的非功能性需求:

1.安全与隐私:这是不可协商的。

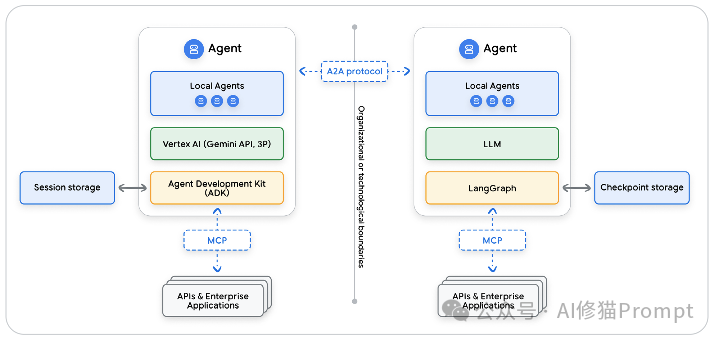

2.多智能体互操作性 (Interoperability):

这个与框架无关的、用于持久化和共享知识的通用层,就是“记忆”。

如果说“会话”是临时的“工作台”,那么“记忆”就是精心组织的“文件柜”。

定义:记忆是从对话或数据源中提取的、有意义的信息快照。它不是原始的逐字稿,而是跨多个会话持久化的、浓缩的知识。

“会话”是“记忆”的主要数据来源。当一个项目在“工作台”(会话)上完成后,你不会把整个凌乱的工作台塞进存储。相反,你会“创建记忆”——丢弃草稿,只把最终的、关键的文件归档到“文件柜”(记忆)中。

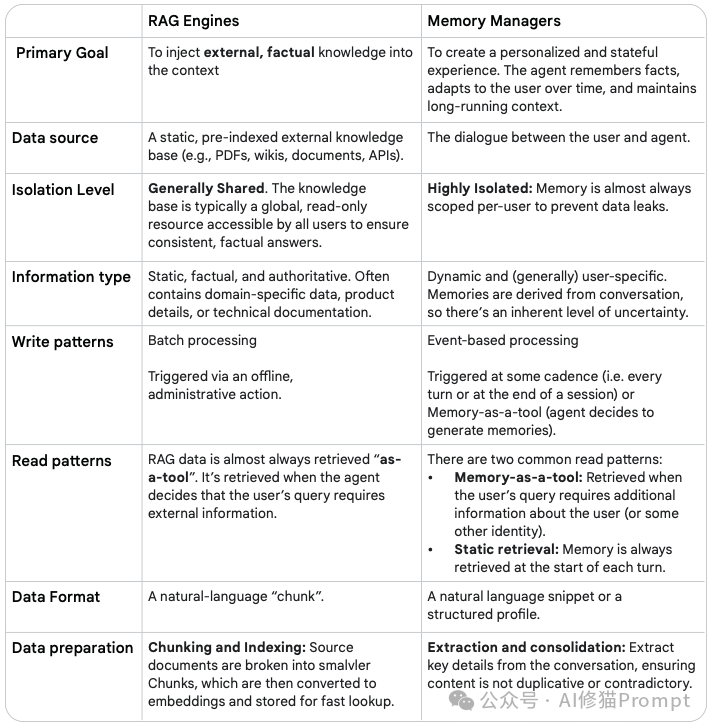

这是整篇白皮书中最重要的概念区分之一。记忆和 RAG(检索增强生成)都为 LLM 提供外部知识,但它们服务于完全不同且互补的目标。

文档再次使用了一个绝妙的比喻:

一个真正智能的Agent,既需要“图书管理员”(RAG)来了解世界,也需要“私人助理”(记忆)来了解你。

白皮书从多个维度对记忆进行了详细的解构,为我们提供了构建记忆系统的完整分类法:

1.按信息类型 (Information Type):

2.按组织模式 (Organization Patterns):

{"seat_preference": "window"})。3.按存储架构 (Storage Architectures):

4.按范围 (Scope):

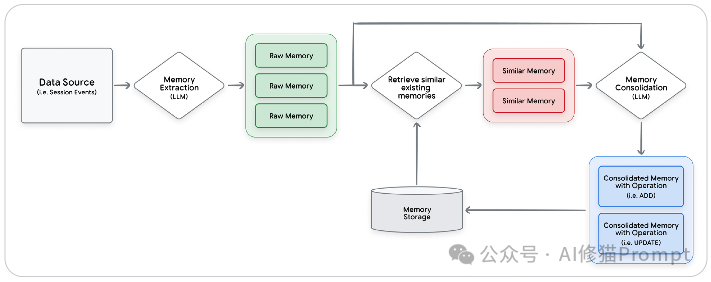

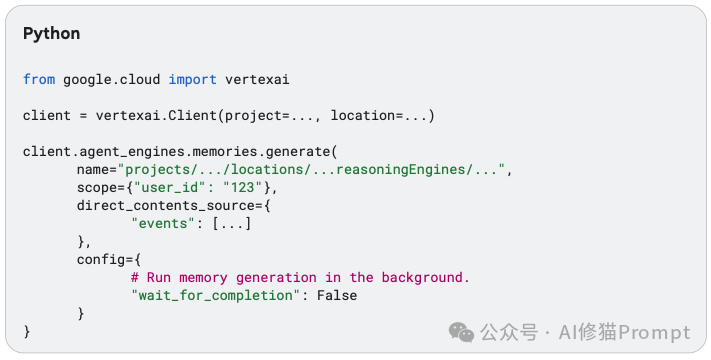

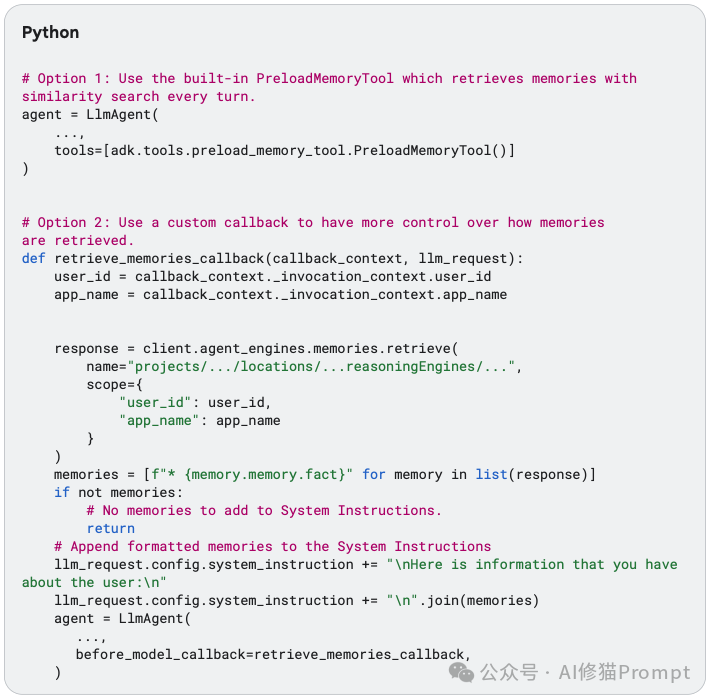

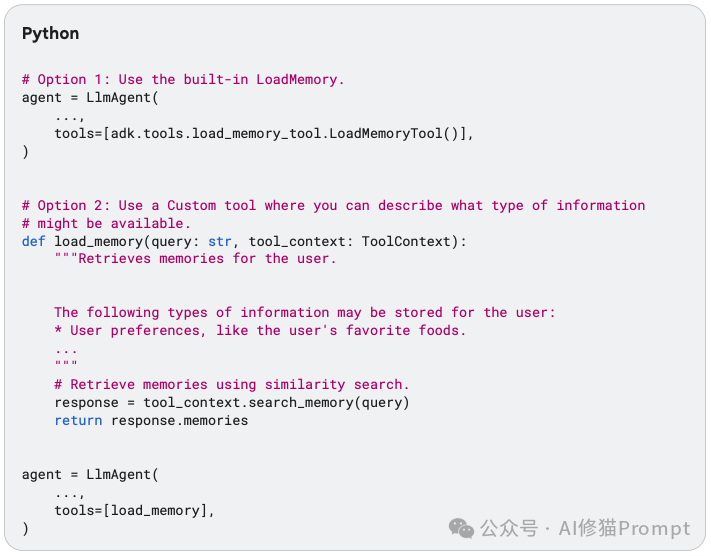

这部分是白皮书的技术核心。它揭示了“记忆管理器” (Memory Manager) 不是一个被动的数据库,而是一个主动的、由 LLM 驱动的 ETL (Extract, Transform, Load) 管道。

这个自动化的 ETL 流程,正是记忆管理器的核心价值所在。

这是整个生命周期中最复杂、最智能的阶段。

为了让“整合”阶段能智能地解决冲突,系统必须知道每条记忆的可信度。

白皮书最后详细阐述了在生产环境中实现记忆系统的架构决策。

load_memory 工具来查询。

最后,这份文档以严谨的态度探讨了生产系统必须面对的残酷现实。

谷歌的这份《上下文工程:会话与记忆》白皮书,清晰地定义了实现“有状态” AI 的两大核心组件,临时的“工作台”(会话)和持久的“文件柜”(记忆)。它不仅提供了蓝图,更深入到了 ETL 管道、信任层级、异步架构和安全模型的实现细节中。希望这篇文章能让您对Context Engineering拥有更深层的理解,所有资料我将在群里分享,欢迎来聊。

文章来自于“AI修猫Prompt”,作者 “AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0