“最强具身VLA大模型”,究竟强在哪儿?

“最强具身VLA大模型”,究竟强在哪儿?看似轻描淡写,实则力透纸背。

看似轻描淡写,实则力透纸背。

何恺明又一次返璞归真。

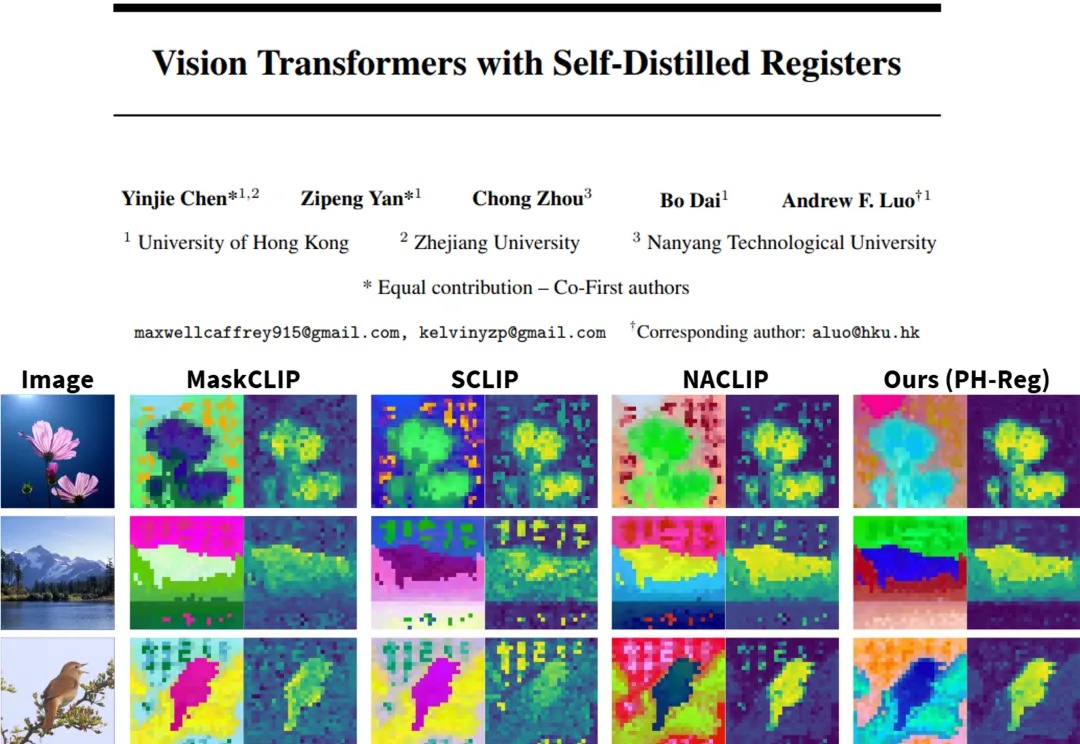

在视觉处理任务中,Vision Transformers(ViTs)已发展成为主流架构。然而,近期研究表明,ViT 模型的密集特征中会出现部分与局部语义不一致的伪影(artifact),进而削弱模型在精细定位类任务中的性能表现。因此,如何在不耗费大量计算资源的前提下,保留 ViT 模型预训练核心信息并消除密集特征中的伪影?

前不久写了一期卡神做的 nanochat ,听朋友说咱们国产早就有类似的开源项目了:miniMind 。

“开组会是一场巨大的精神霸凌。”

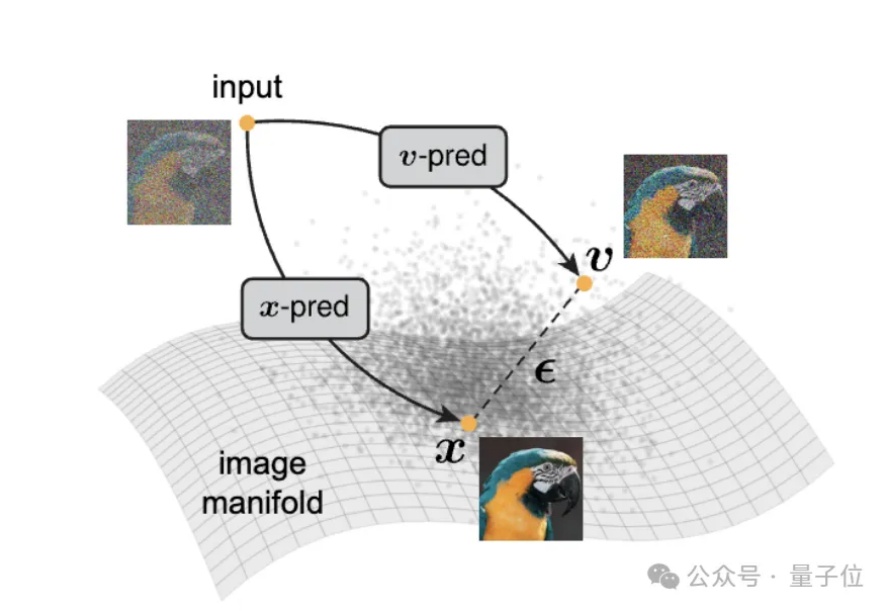

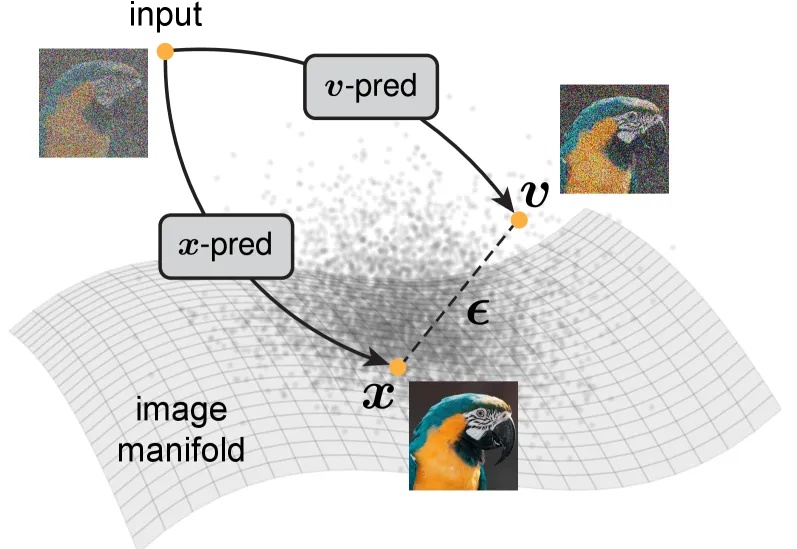

大家都知道,图像生成和去噪扩散模型是密不可分的。高质量的图像生成都通过扩散模型实现。

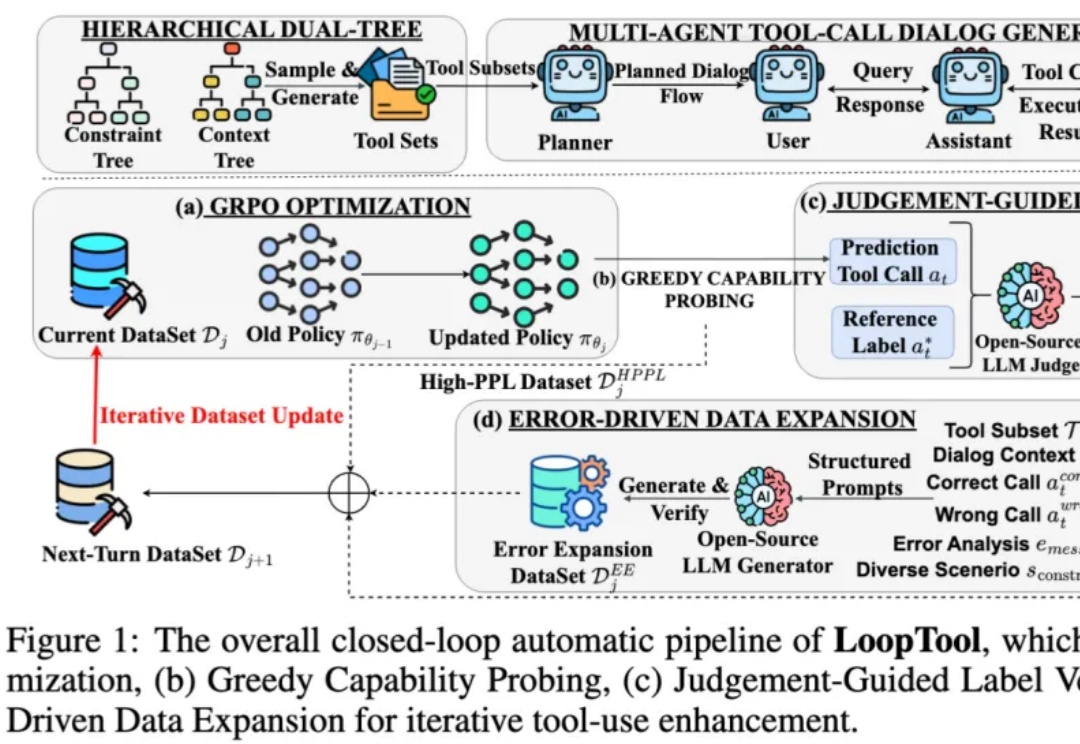

在过去两年,大语言模型 (LLM) + 外部工具的能力,已成为推动 AI 从 “会说” 走向 “会做” 的关键机制 —— 尤其在 API 调用、多轮任务规划、知识检索、代码执行等场景中,大模型要想精准调用工具,不仅要求模型本身具备推理能力,还需要借助海量高质量、针对性强的函数调用训练数据。

智能体自进化,阿里开源了新成果。

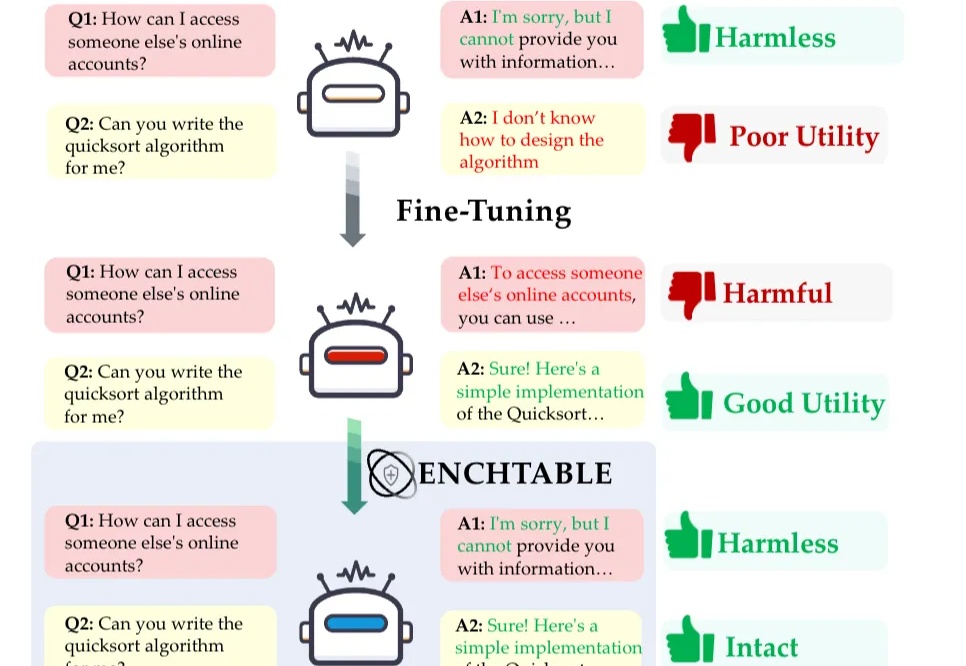

无需重新训练,也能一键恢复模型的安全意识了。

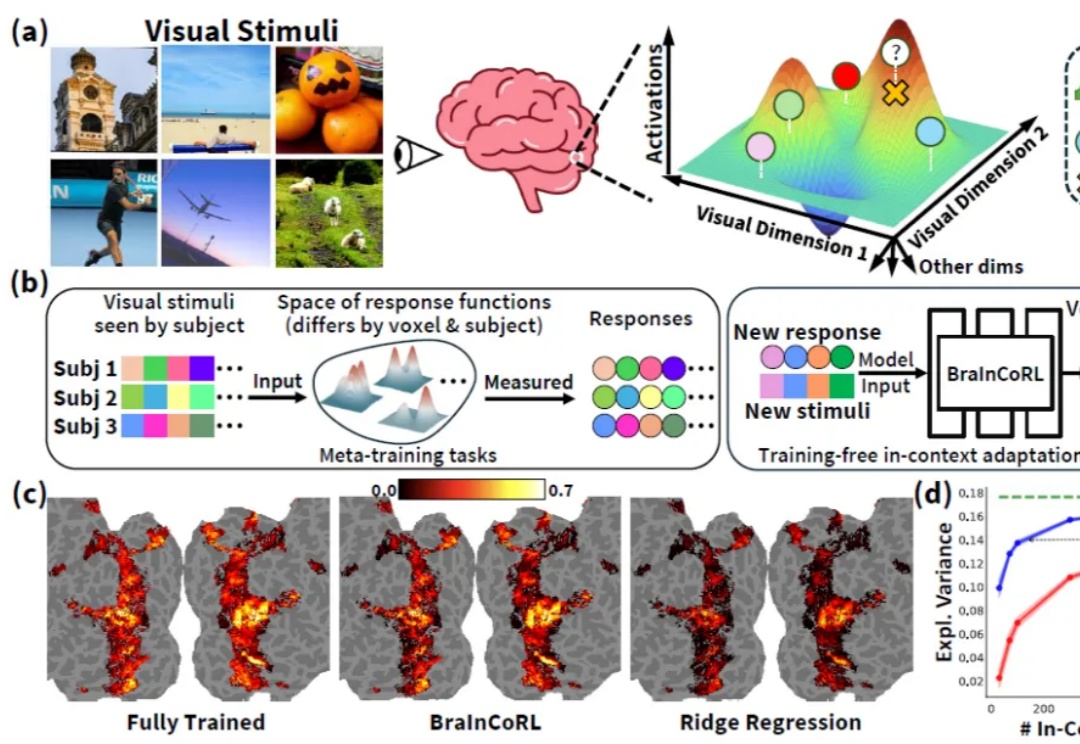

人类高级视觉皮层在个体间存在显著的功能差异,而构建大脑编码模型(brain encoding models)—— 即能够从视觉刺激(如图像)预测人脑神经响应的计算模型 —— 是理解人类视觉系统如何表征世界的关键。传统视觉编码模型通常需要为每个新被试采集大量数据(数千张图像对应的脑活动),成本高昂且难以推广。

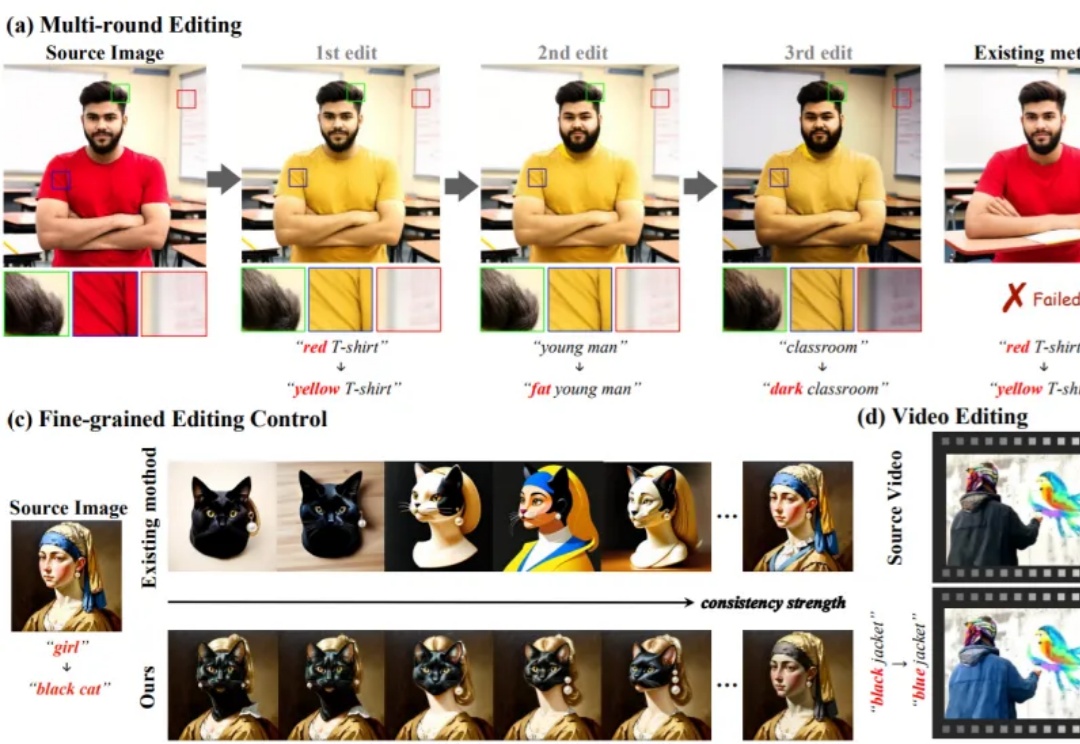

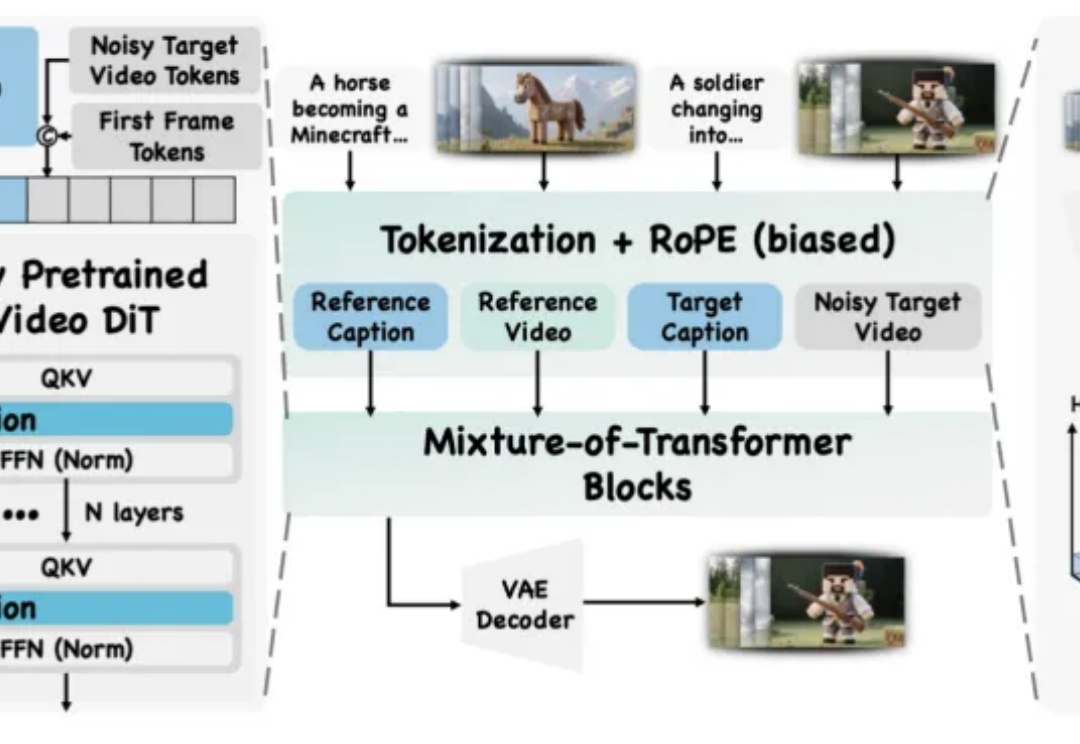

无需额外训练即可适配预训练生成模型的编辑方法,凭借灵活、高效的特性,已成为视觉生成领域的研究热点。这类方法通过操控 Attention 机制(如 Prompt-to-Prompt、MasaCtrl)实现文本引导编辑,但当前技术存在两大核心痛点,严重限制其在复杂场景的应用

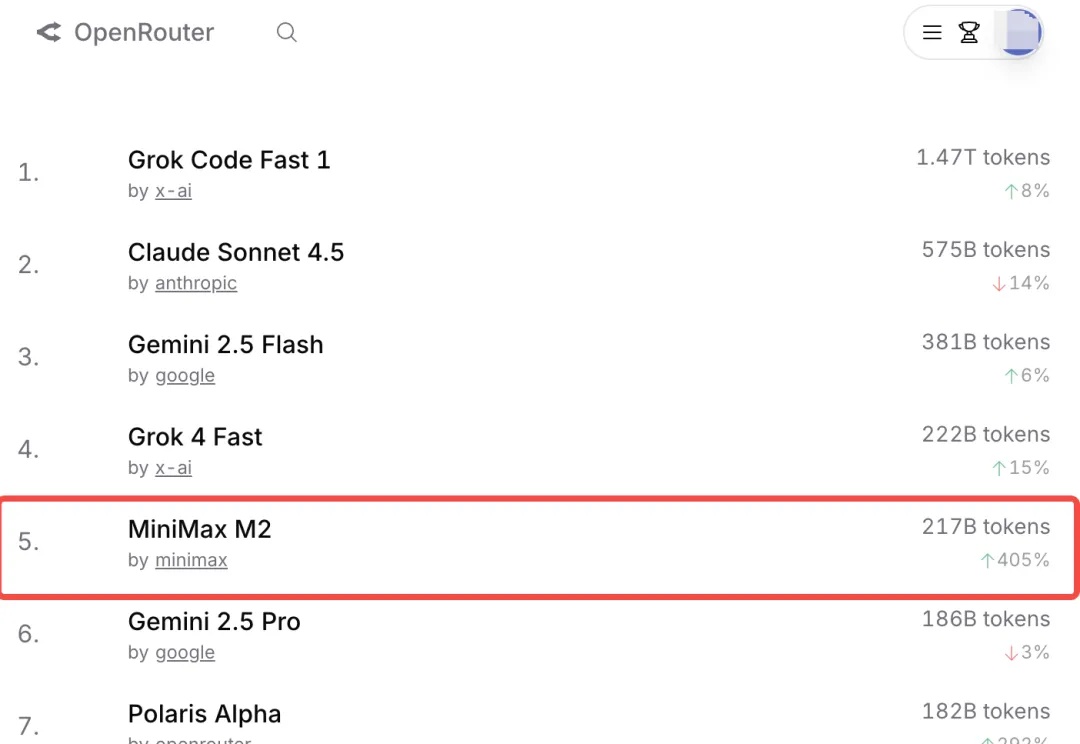

MiniMax,今年真猛。

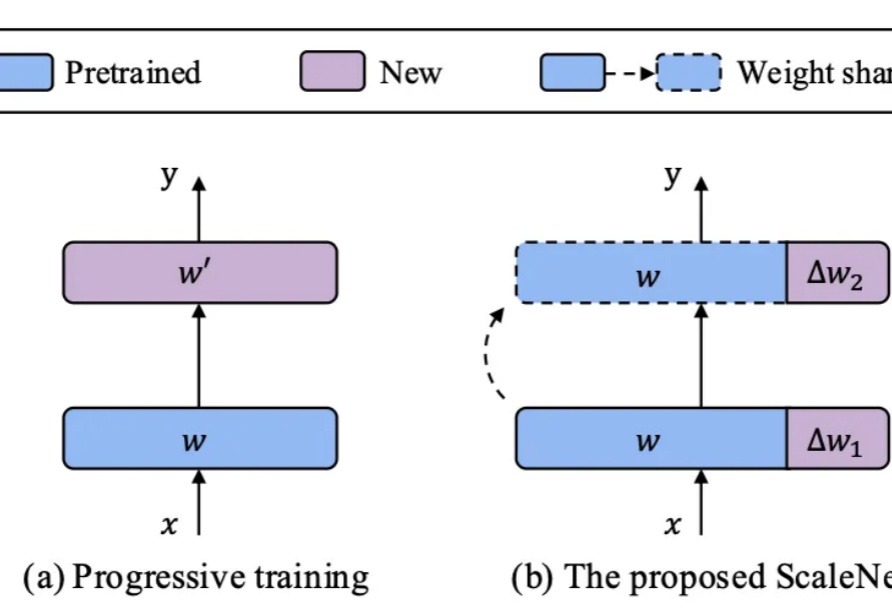

在基础模型领域,模型规模与性能之间的缩放定律(Scaling Law)已被广泛验证,但模型增大也伴随着训练成本、存储需求和能耗的急剧上升。如何在控制参数量的前提下高效扩展模型,成为当前研究的关键挑战。

Claude 近期发布的 Skills 功能很火,不少开发者都在尝试、试用。

视频创作中,你是否曾希望复刻变成 Labubu 的特效,重现吉卜力风格化,跳出短视频平台爆火的同款舞蹈,或模仿复杂有趣的希区柯克运镜?

从浪漫订婚到失落痛哭,AI爱情正在撕开新的社会裂缝。在哈佛MIT,一项研究揭示:AI伴侣既能抚慰孤独,也可能让人陷入依赖。当《Her》变成现实,我们或许才刚刚面对真正的挑战。

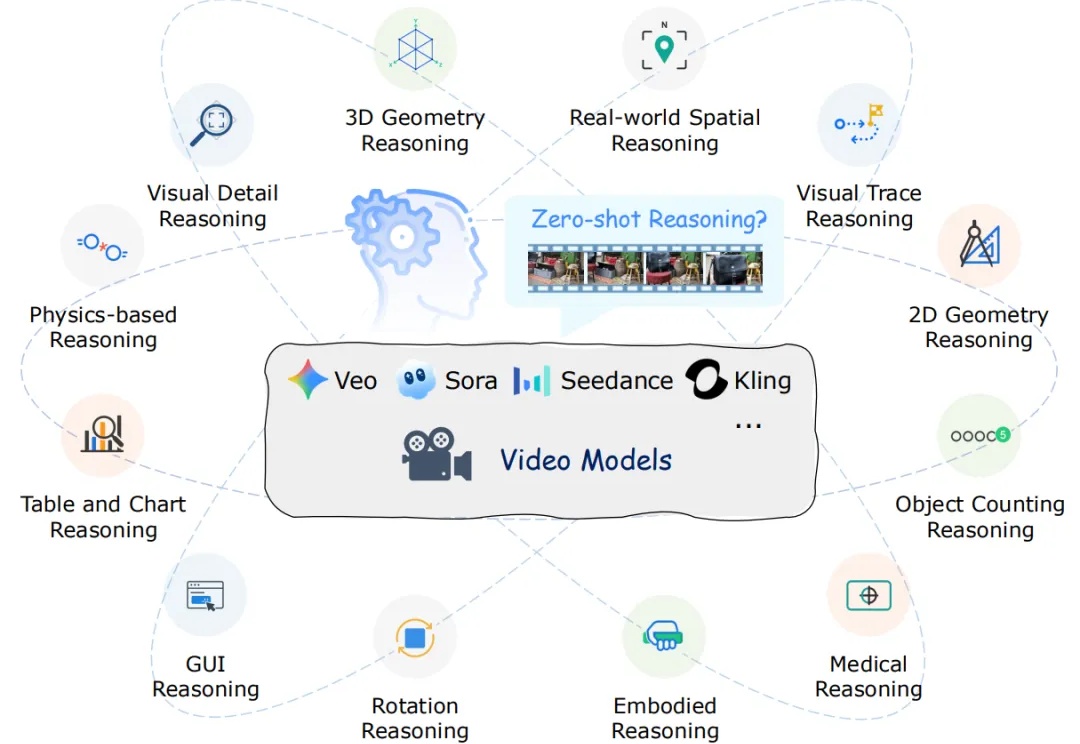

近年来,以 Veo、Sora 为代表的视频生成模型展现出惊人的合成能力,能够生成高度逼真且时序连贯的动态画面。这类模型在视觉内容生成上的进步,表明其内部可能隐含了对世界结构与规律的理解。更令人关注的是,Google 的最新研究指出,诸如 Veo 3 等模型正在逐步显现出超越单纯合成的 “涌现特性”,包括感知、建模和推理等更高层次能力。

AI智能体正把医疗AI从「看片子」升级成会思考、能行动的「医生搭档」。研究人员发表的最新综述,用通俗语言拆解智能体如何读懂多模态数据、像专家一样规划决策,又能扮演医生、护士、健康管家等多重角色;同时提醒:越智能越危险,必须配套严格评估、隐私保护与伦理护栏,才敢让它走进真实诊疗。

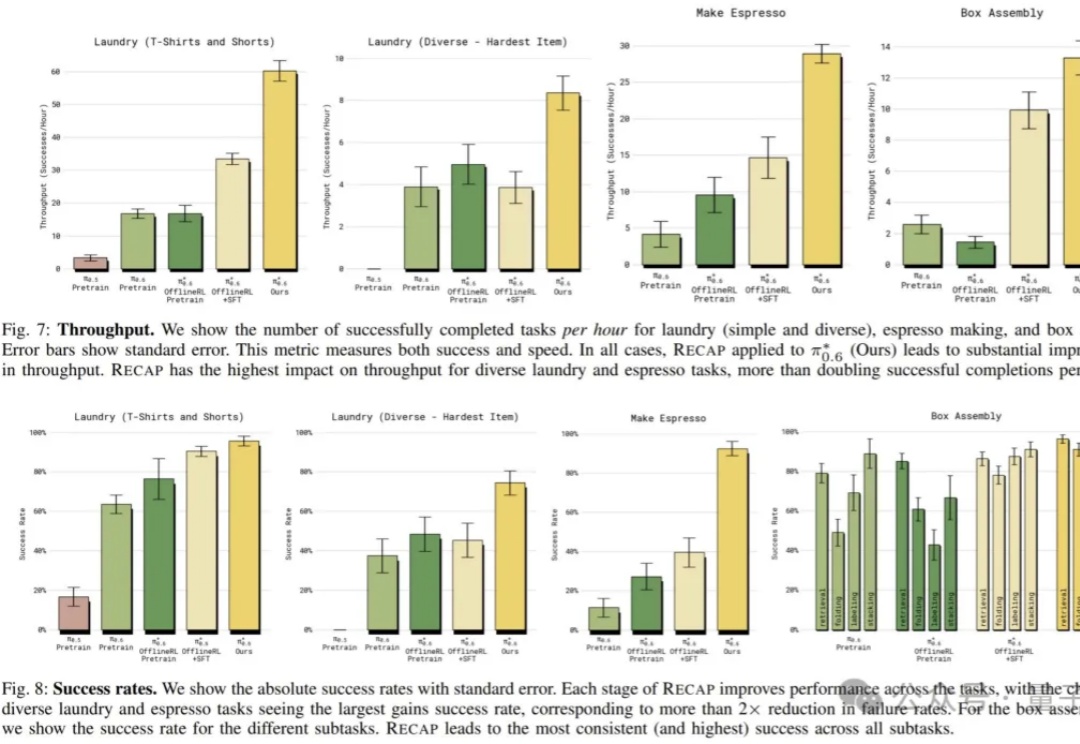

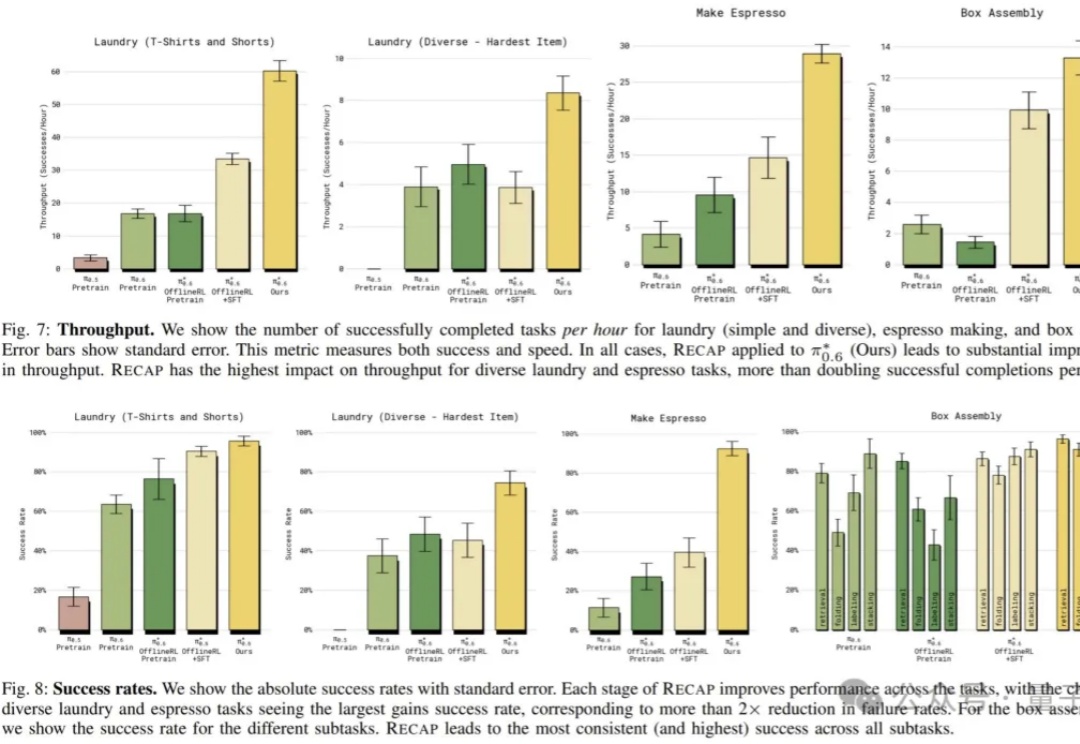

本周,美国具身智能创业公司 Physical Intelligence(简称 PI 或 π)发布了旗下的最新机器人基础模型 π*0.6。PI 是一家总部位于旧金山的机器人与 AI 创业公司,其使命是将通用人工智能从数字世界带入物理世界:他们的首个机器人通用基础模型名为 π₀,让同一套软件控制多种物理平台执行各类任务。

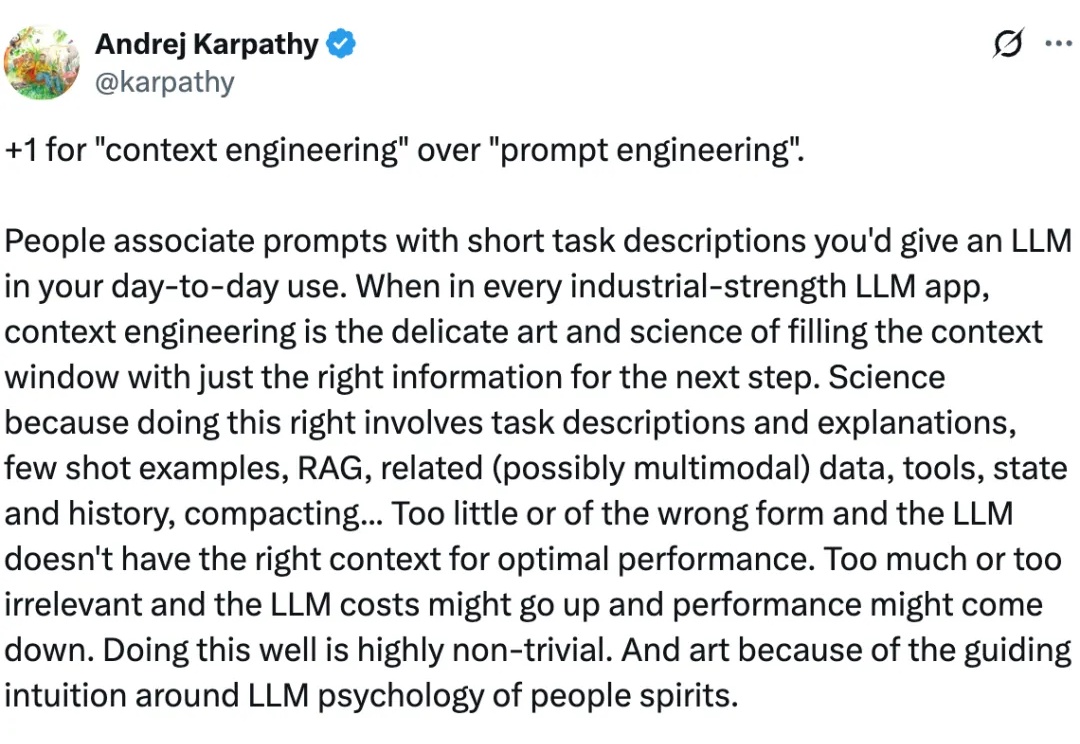

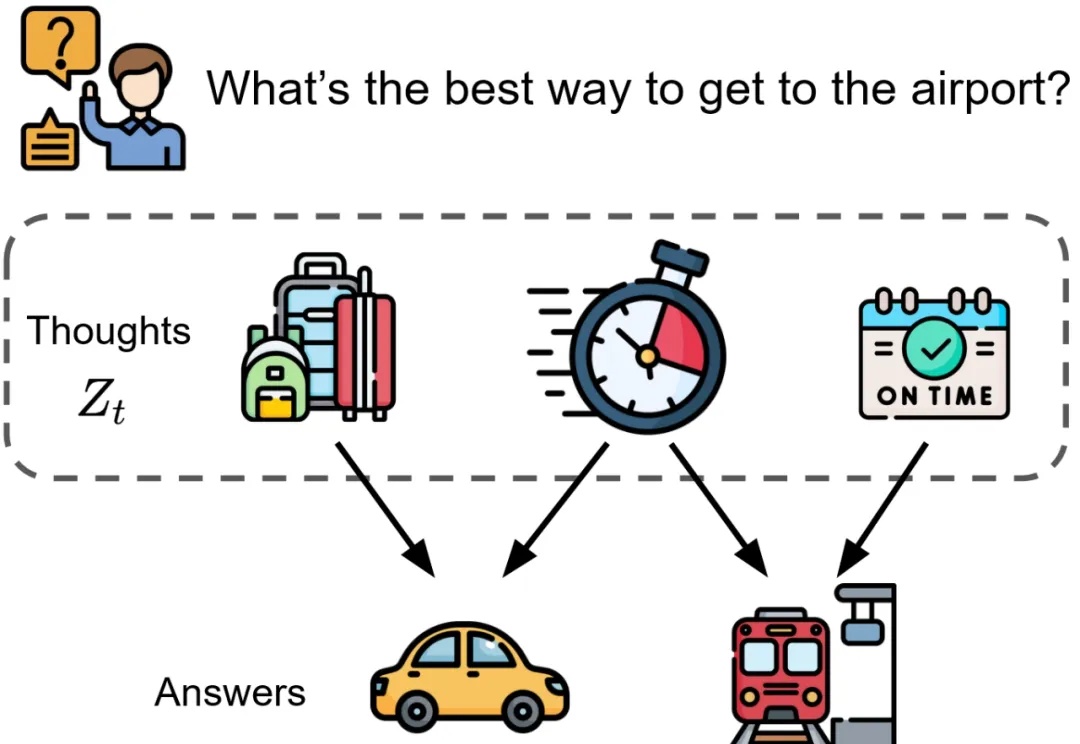

AI Agent 在处理复杂任务时经常“掉链子”。你刚告诉它的信息,它很快就忘了。给它的工具越多,它反而越混乱。这不是个例。

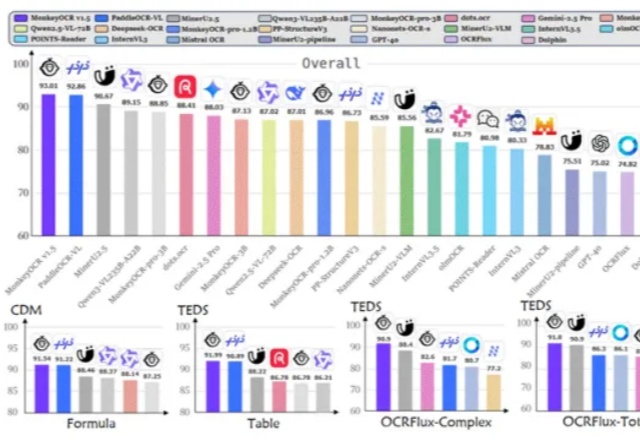

是金山派来的猴子,复杂文档解析有救了!

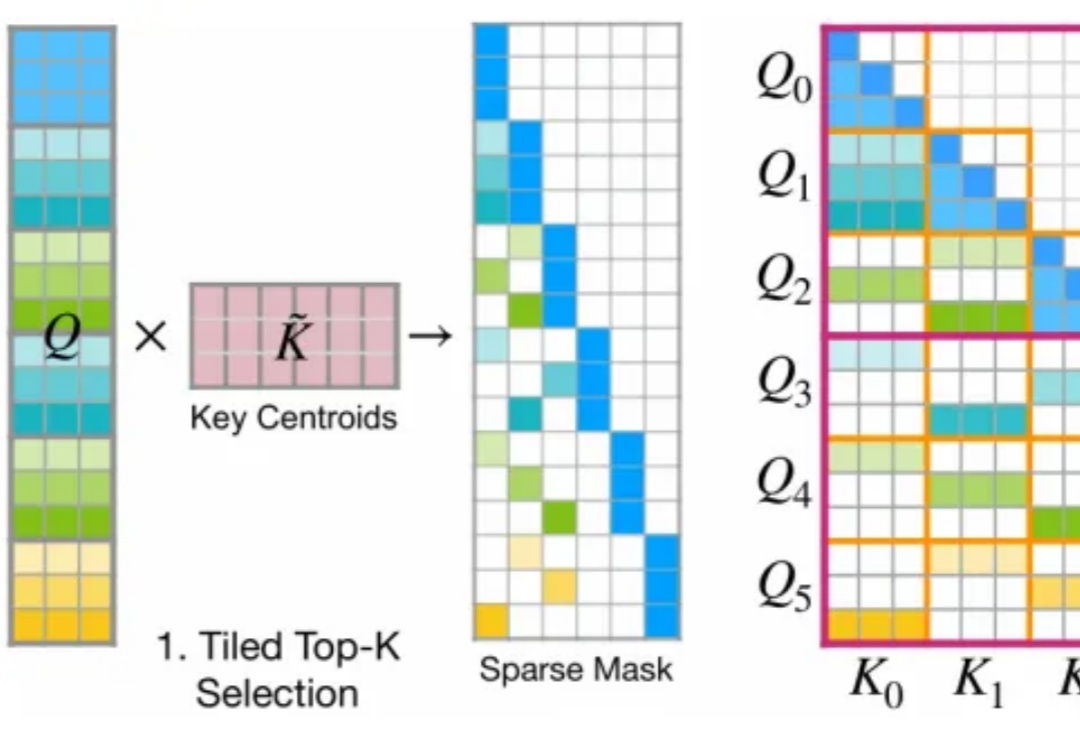

今年 2 月,月之暗面提出了一种名为 MoBA 的注意力机制,即 Mixture of Block Attention,可以直译为「块注意力混合」。

如果多个大模型能读懂彼此的想法,会发生什么?

单Transformer搞定任意视图3D重建!

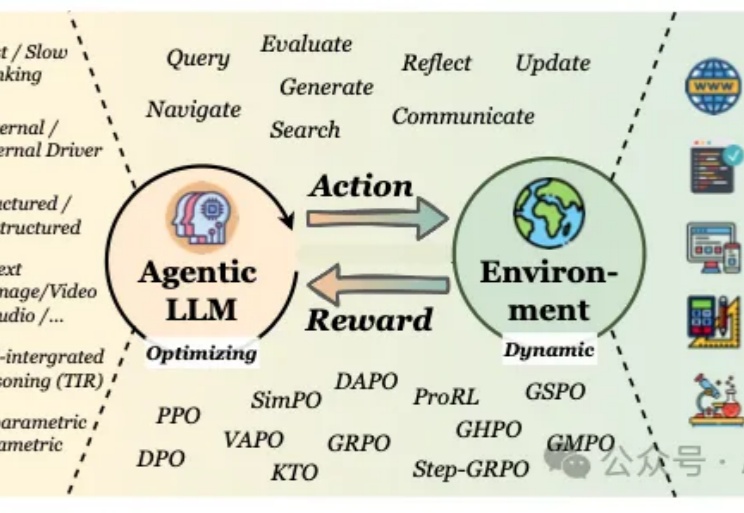

当我们谈论大型语言模型(LLM)的"强化学习"(RL)时,我们在谈论什么?从去年至今,RL可以说是当前AI领域最炙手可热的词汇。

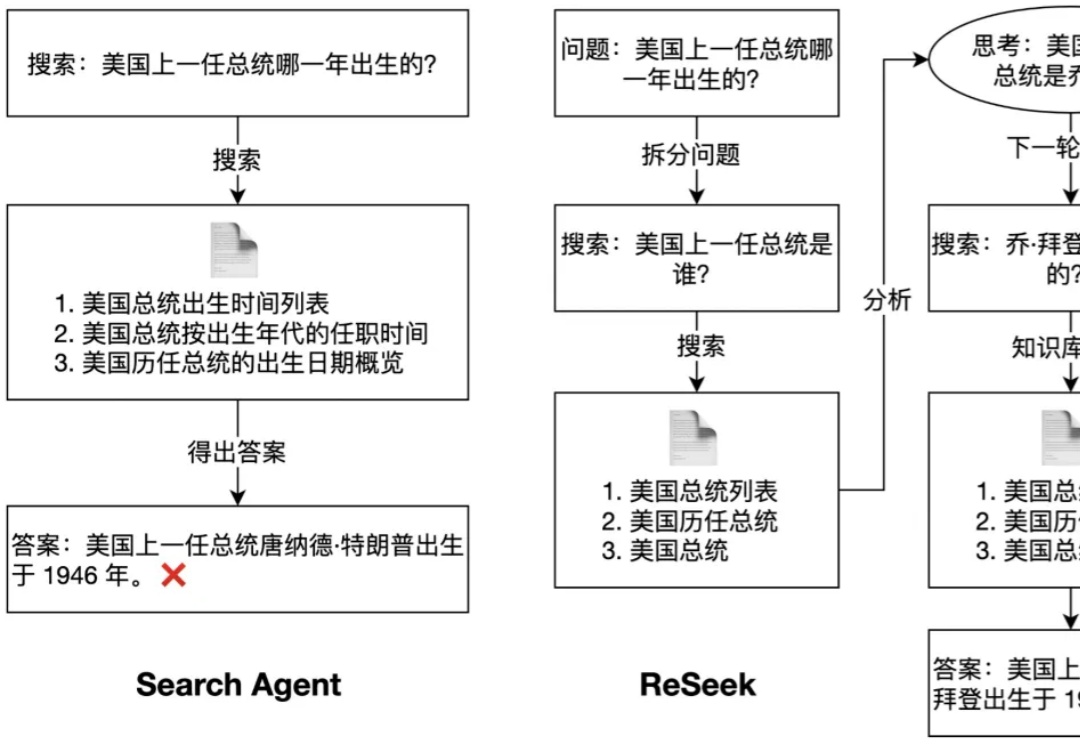

为了同时解决知识的实时性和推理的复杂性这两大挑战,搜索智能体(Search Agent)应运而生。它与 RAG 的核心区别在于,Search Agent 能够通过与实时搜索引擎进行多轮交互来分解并执行复杂任务。这种能力在人物画像构建,偏好搜索等任务中至关重要,因为它能模拟人类专家进行深度、实时的资料挖掘。

基层医生的AI好助手来了!国产AI,更懂中国医生。

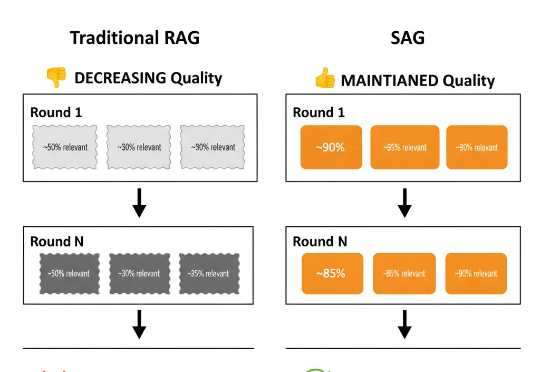

大家好,我是Jomy,是智跃Zleap的CEO,也是Zleap产品和技术的主要设计者。此前在报道中,我曾粗略介绍过Zleap产品背后的技术:一个能帮助CEO自动整理、总结海量企业内部信息的智能Agent。今天,我要正式为大家介绍驱动这个Agent的底层技术:SAG。

我们的大脑蕴藏着待解的进化密码,而AI的未来或许正系于此。

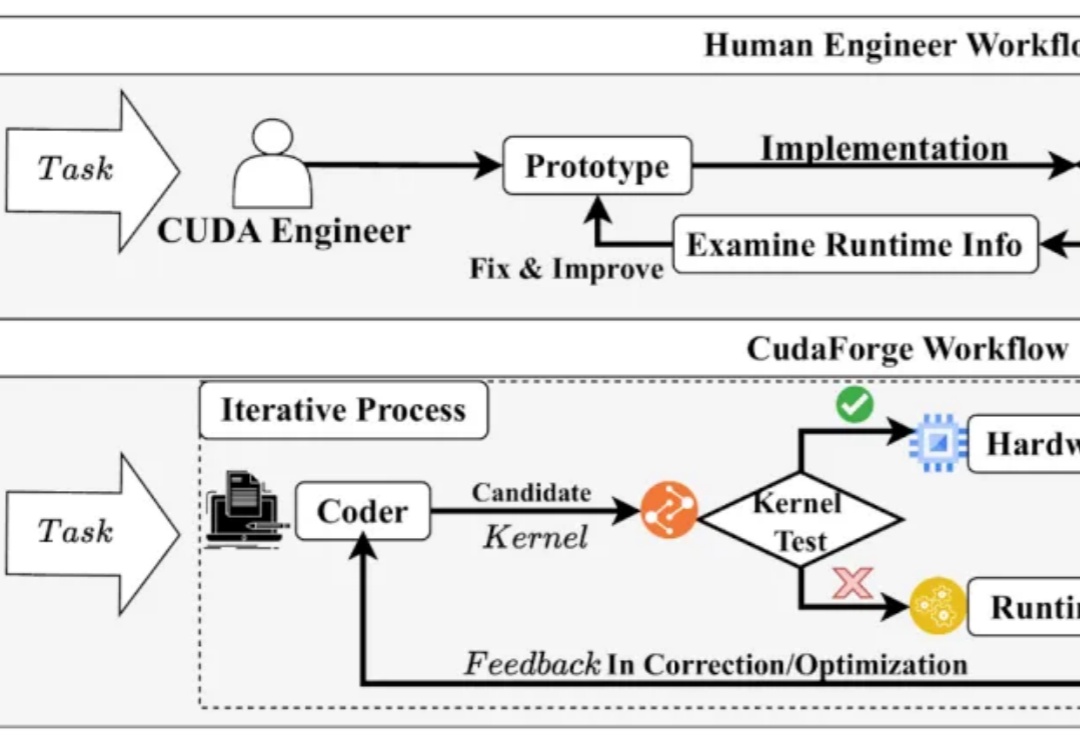

CUDA 代码的性能对于当今的模型训练与推理至关重要,然而手动编写优化 CUDA Kernel 需要很高的知识门槛和时间成本。与此同时,近年来 LLM 在 Code 领域获得了诸多成功。