ICML 2025 Oral工作再升级!上海AI Lab联合复旦、港中文推出支持更长视频理解的最佳工具VideoRoPE++

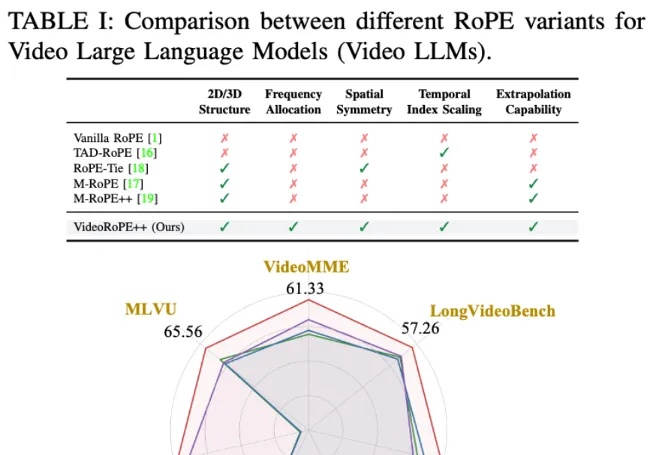

ICML 2025 Oral工作再升级!上海AI Lab联合复旦、港中文推出支持更长视频理解的最佳工具VideoRoPE++虽然旋转位置编码(RoPE)及其变体因其长上下文处理能力而被广泛采用,但将一维 RoPE 扩展到具有复杂时空结构的视频领域仍然是一个悬而未决的挑战。

虽然旋转位置编码(RoPE)及其变体因其长上下文处理能力而被广泛采用,但将一维 RoPE 扩展到具有复杂时空结构的视频领域仍然是一个悬而未决的挑战。

DeepMind新研究揭示了当与推理无关的想法,被直接注入到模型的推理过程中时,它们却难以恢复,而且越大的模型越难恢复。

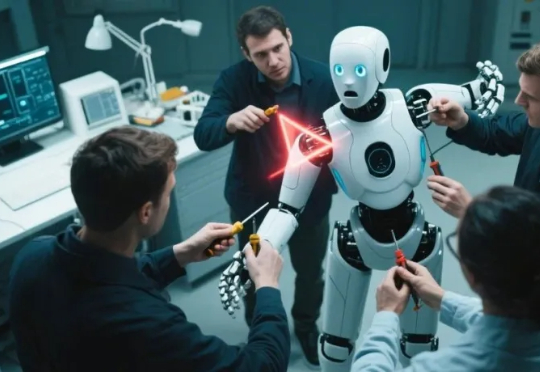

最近网上出现了一些很有趣的声音——"提示词已死"、"写提示词把自己写死了",这些文章认为随着模型变得越来越智能,精心设计提示词的时代已经过去了。但芝加哥大学的最新研究却给出了完全相反的结论:prompt不仅没有死,反而是理解大模型最重要的科学工具。

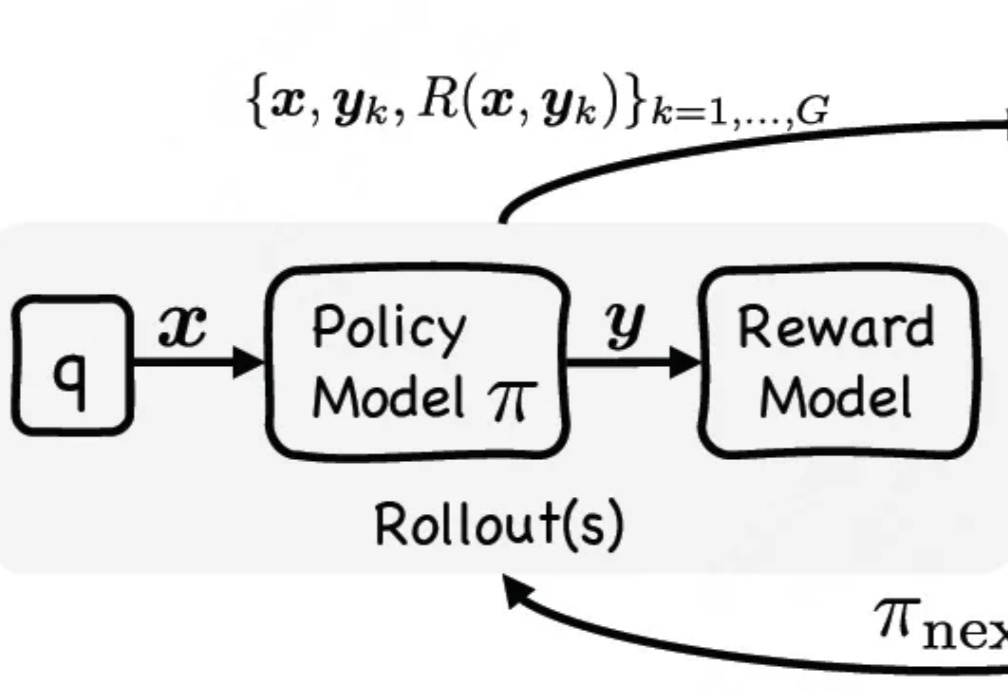

最近,关于大模型推理的测试时间扩展(Test time scaling law )的探索不断涌现出新的范式,包括① 结构化搜索结(如 MCTS),② 过程奖励模型(Process Reward Model )+ PPO,③ 可验证奖励 (Verifiable Reward)+ GRPO(DeepSeek R1)。

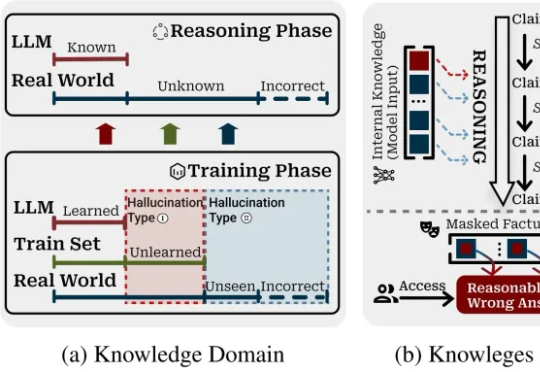

当推理链从3步延伸到50+步,幻觉率暴增10倍;反思节点也束手无策。

智源统一图像生成模型OmniGen2发布后,立刻在AI图像生成领域掀起巨响,多模态技术生态进一步打通。才一周,GitHub星标就已经破了2000,X上的话题浏览数直接破数十万。

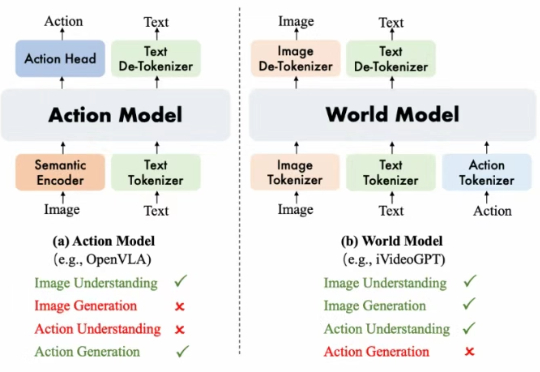

阿里巴巴达摩院提出了 WorldVLA, 首次将世界模型 (World Model) 和动作模型 (Action Model/VLA Model) 融合到了一个模型中。WorldVLA 是一个统一了文本、图片、动作理解和生成的全自回归模型。

AI非上云不可、非集群不能?万字实测告诉你,32B卡不卡?70B是不是智商税?要几张卡才能撑住业务? 全网最全指南教你如何用最合适的配置,跑出最强性能。

曾几何时,用文字生成图像已经变得像用笔作画一样稀松平常。

MIT最新研究让LLM直接操控宇宙飞船进行太空追逐挑战赛:ChatGPT少量微调即获第二,开源Llama更胜一筹,凭提示词精准追踪卫星、节省燃料,更是0%失败率,验证AI小数据高效与自主航天可行,为未来的太空漫游铺路。

Claude Code推出了一个让人眼前一亮的功能——Hooks。

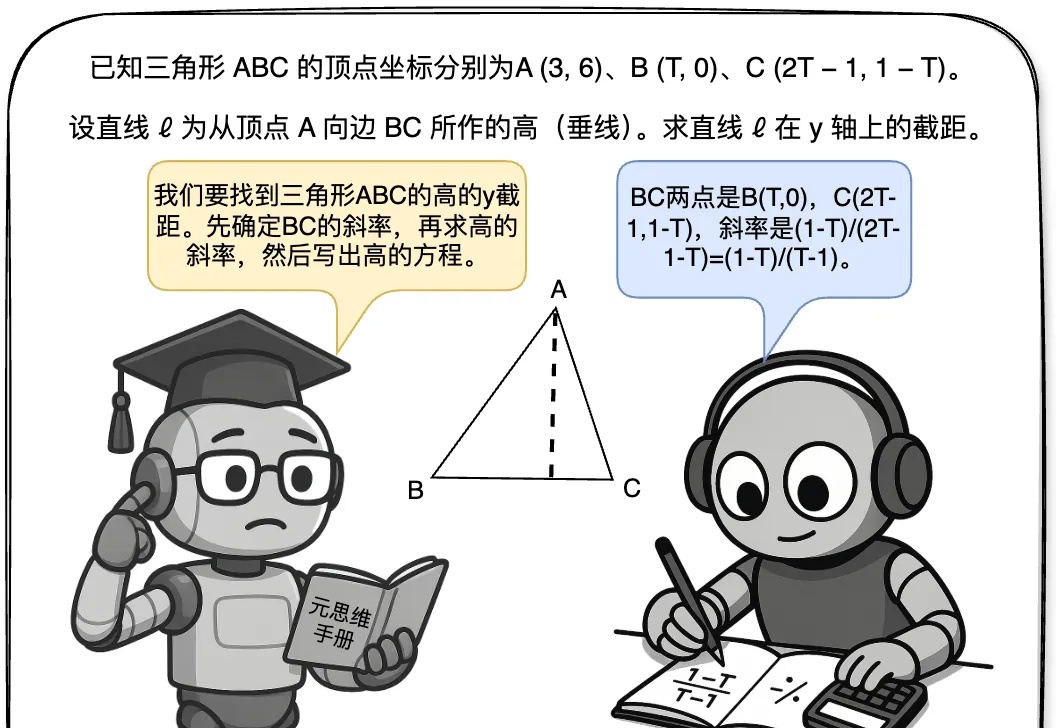

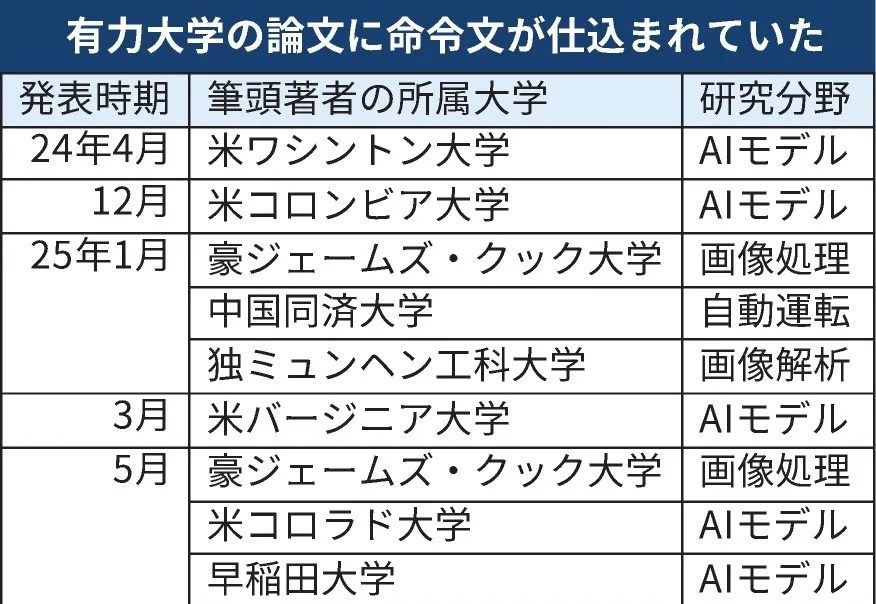

是「正当防卫」还是「学术欺诈」?

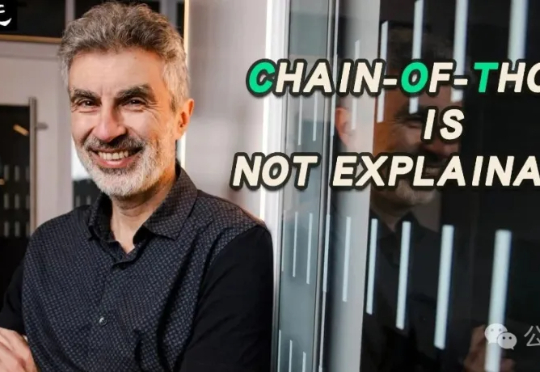

原来,CoT推理竟是假象!Bengio带队最新论文戳穿了CoT神话——我们所看到的推理步骤,并非是真实的。不仅如此,LLM在推理时会悄然纠正错误,却在CoT中只字未提。

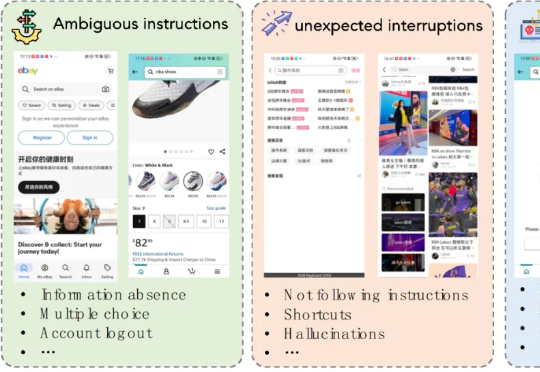

本文第一作者是上海交通大学计算机学院三年级博士生程彭洲,研究方向为多模态大模型推理、AI Agent、Agent 安全等。通讯作者为张倬胜助理教授和刘功申教授。

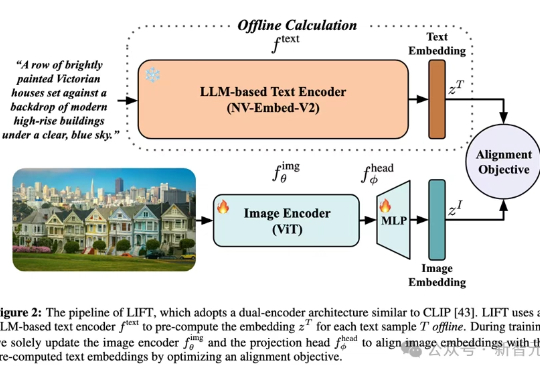

多模态对齐模型借助对比学习在检索与生成任务中大放异彩。最新趋势是用冻结的大语言模型替换自训文本编码器,从而在长文本与大数据场景中降低算力成本。LIFT首次系统性地剖析了此范式的优势来源、数据适配性、以及关键设计选择,在组合语义理解与长文本任务上观察到大幅提升。

设定角色,让AI照“本”生成主角不变的不同图像,对于各路AIGC工具来说一直是不小的挑战。

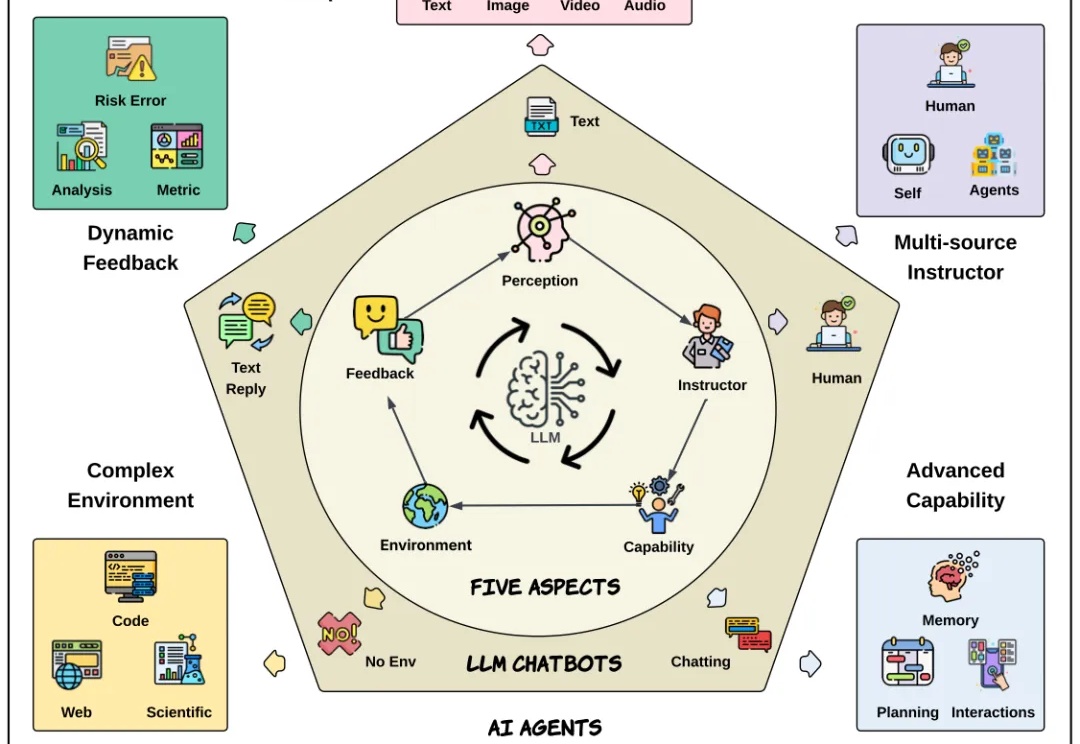

自从 Transformer 问世,NLP 领域发生了颠覆性变化。大语言模型极大提升了文本理解与生成能力,成为现代 AI 系统的基础。而今,AI 正不断向前,具备自主决策和复杂交互能力的新一代 AI Agent 也正加速崛起。

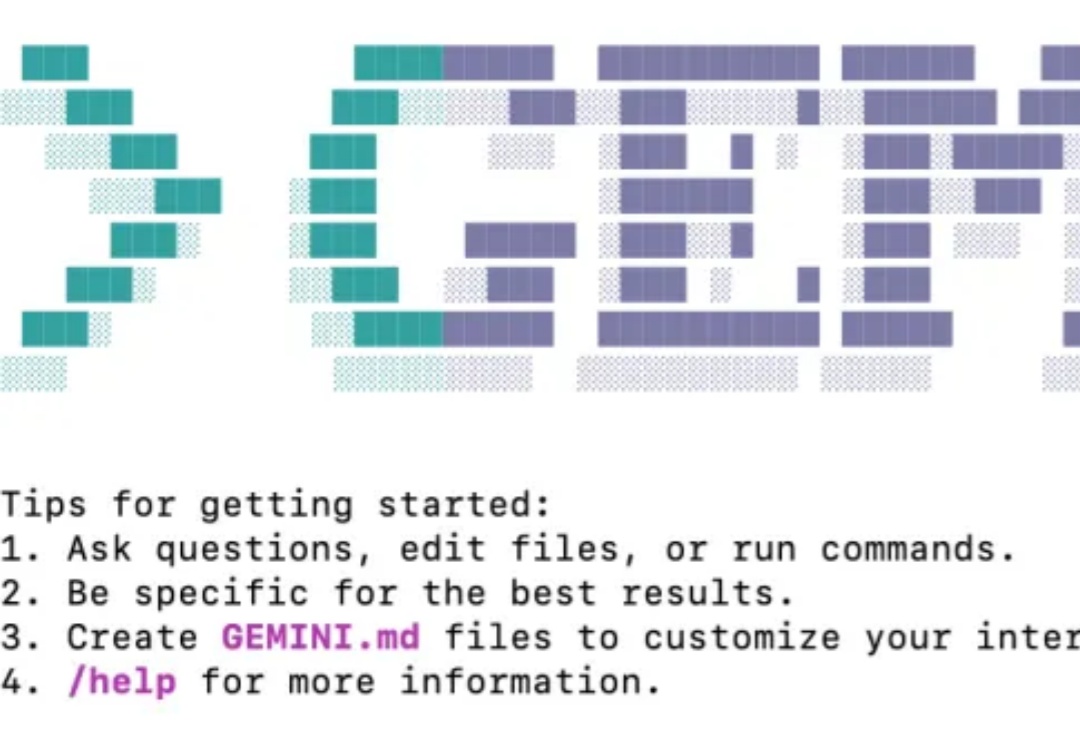

大家好,这里是歸藏(guizang),分享一下 Gemini CLI 不写代码能有多好用! 前几天最近随着 Claude Code 这个命令行 AI 代码工具的火爆,谷歌也耐不住寂寞推出了自己的同类产品 Gemini CLI,而且完全免费,非常顶。

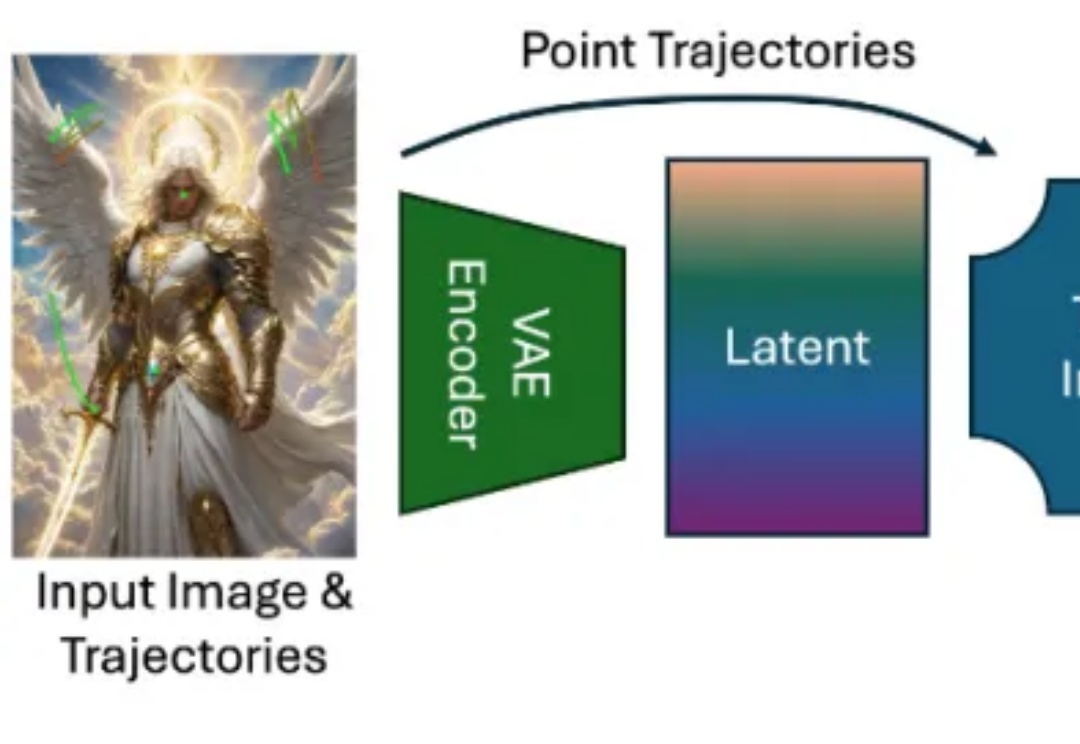

近年来,随着扩散模型(Diffusion Models)、Transformer 架构与高性能视觉理解模型的蓬勃发展,视频生成任务取得了令人瞩目的进展。从静态图像生成视频的任务(Image-to-Video generation)尤其受到关注,其关键优势在于:能够以最小的信息输入生成具有丰富时间连续性与空间一致性的动态内容。

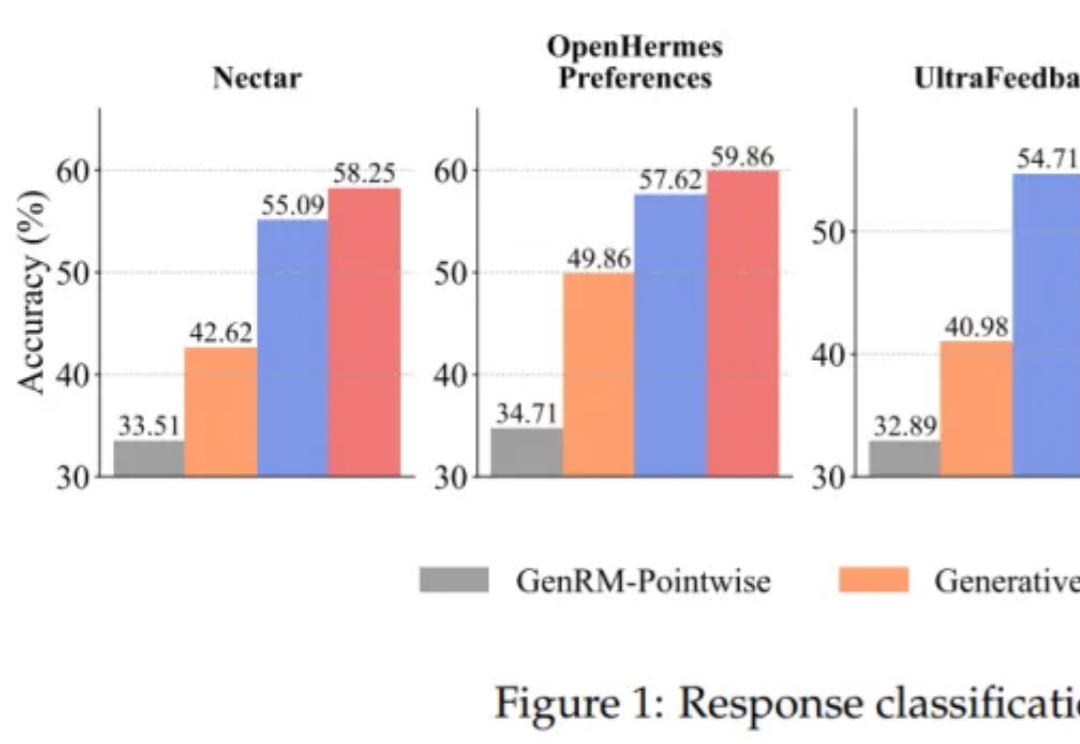

将大语言模型(LLMs)与复杂的人类价值观对齐,仍然是 AI 面临的一个核心挑战。当前主要的方法是基于人类反馈的强化学习(RLHF)。该流程依赖于一个通过人类偏好训练的奖励模型来对模型输出进行评分,最终对齐后的 LLM 的质量在根本上取决于该奖励模型的质量。

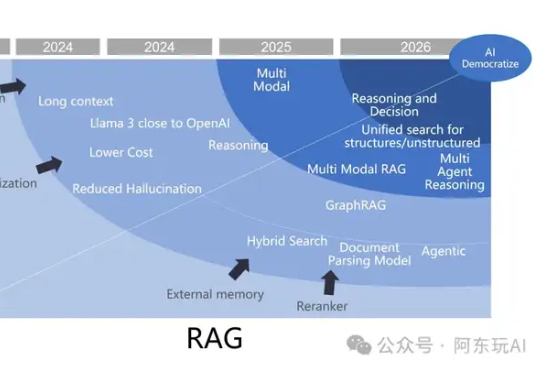

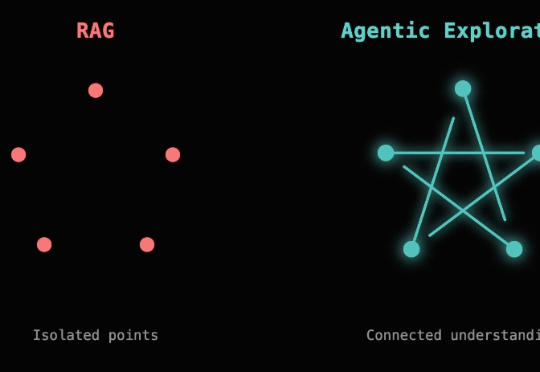

2023年至今,检索增强生成(RAG)经历了从备受瞩目到逐渐融入智能体生态的转变。尽管有人宣称“RAG已死”,但其在企业级应用中的重要性依然无可替代。RAG正从独立框架演变为智能体生态的关键子模块,2025年将在多模态、代理融合、行业定制化等领域迎来新的突破。

如果一个视觉语言模型(VLM)只会“看”,那真的是已经不够看的了。

通过单阶段监督微调与强化微调结合,让大模型在训练时能同时利用专家演示和自我探索试错,有效提升大模型推理性能。

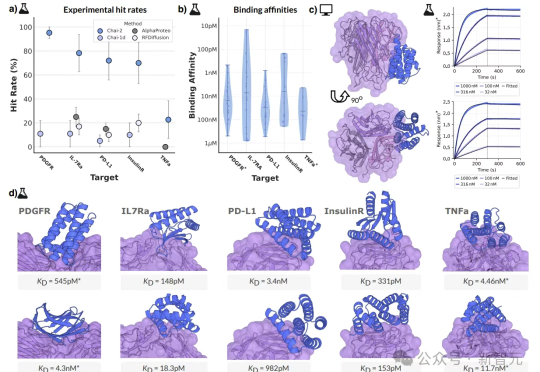

10元一块实验板、2周时间、零样本命中率16%,这不是科幻,而是AI创造的生物技术奇迹!AI制药的拐点,或许已经到来——如果还在用老方法,那你可能已经被这场「淘汰赛」边缘化了……

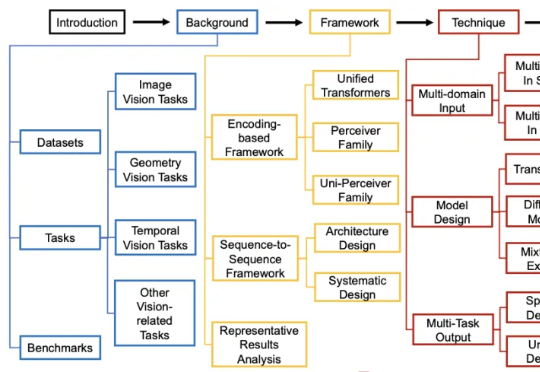

过去几年,通用视觉模型(Vision Generalist Model,简称 VGM)曾是计算机视觉领域的研究热点。

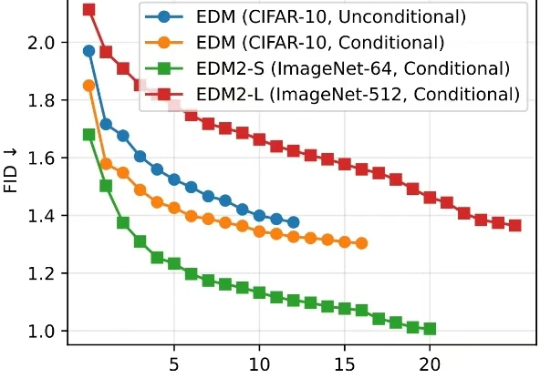

清华大学朱军教授团队与 NVIDIA Deep Imagination 研究组联合提出一种全新的视觉生成模型优化范式 —— 直接判别优化(DDO)。

几个月前,Anthropic 的办公室里多了一台很奇怪的自动售货机。

这两天读到开源的代码 Agent,Cline 团队的一篇博客,《Why Cline Doesn't Index Your Codebase (And Why That's a Good Thing) 》,做了一些整理和探索,来分享一下这篇博客内容。

刚刚,由上海交通大学人工智能学院Agents团队提出的AI专家智能体,在OpenAI权威基准测试MLE-bench中击败了业界AI顶流微软,夺冠登顶!

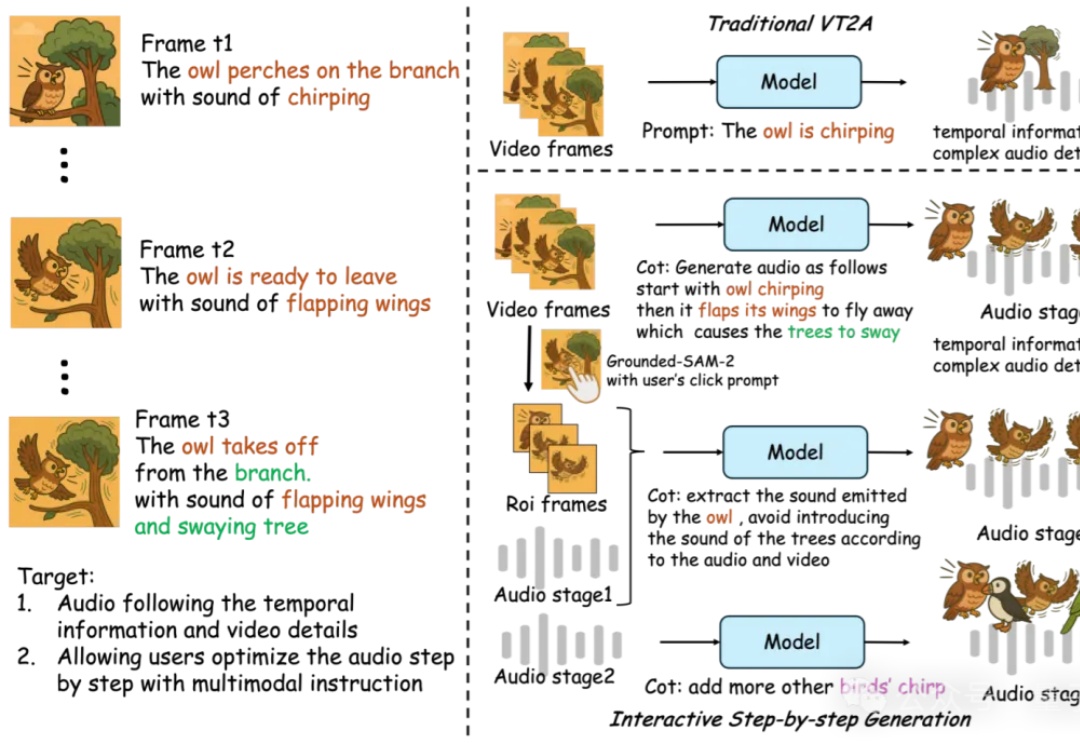

AI音效已经进化成这样了吗??