告别玄学选LLM!弗吉尼亚理工选型框架入选ICML 2025

告别玄学选LLM!弗吉尼亚理工选型框架入选ICML 2025还在靠“开盲盒”选择大模型? 来自弗吉尼亚理工大学的研究人员推出了个选型框架LensLLM

还在靠“开盲盒”选择大模型? 来自弗吉尼亚理工大学的研究人员推出了个选型框架LensLLM

王劲,香港大学计算机系二年级博士生,导师为罗平老师。研究兴趣包括多模态大模型训练与评测、伪造检测等,有多项工作发表于 ICML、CVPR、ICCV、ECCV 等国际学术会议。

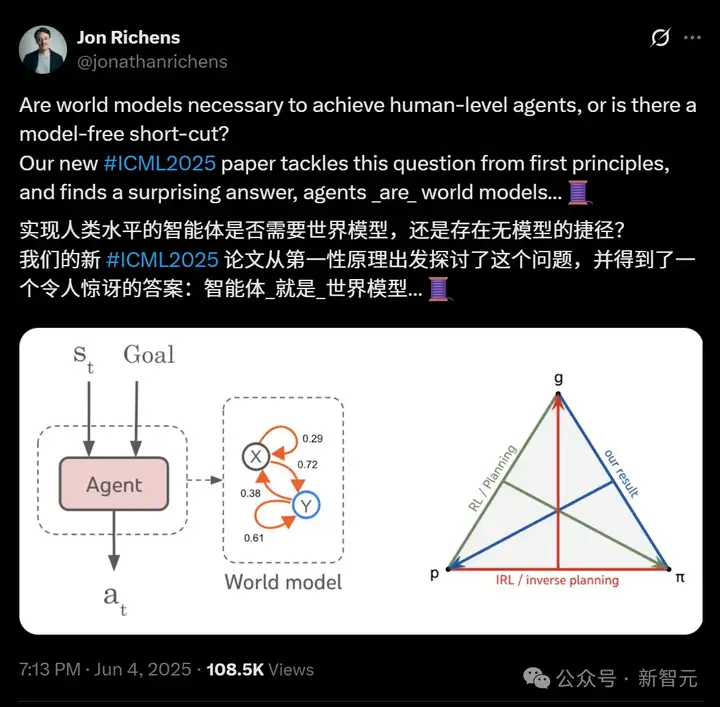

就在刚刚,DeepMind科学家Jon Richens表示,自己的一篇ICML 2025论文发现,智能体就是世界模型!总之,如果要实现AGI,是绝对不存在无模型的捷径的。而这个说法,恰巧跟Ilya 23年的预言不谋而合了。

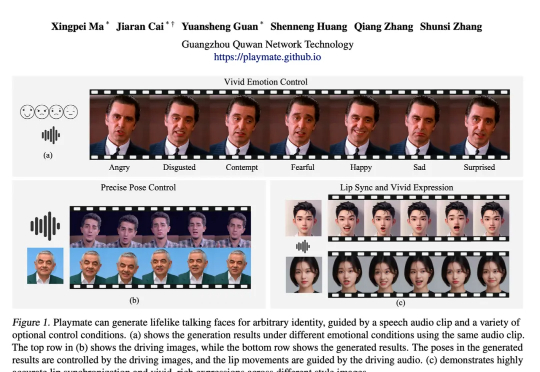

本研究由广州趣丸科技团队完成,团队长期致力于 AI 驱动的虚拟人生成与交互技术,相关成果已应用于游戏、影视及社交场景

在多智能体AI系统中,一旦任务失败,开发者常陷入「谁错了、错在哪」的谜团。PSU、杜克大学与谷歌DeepMind等机构首次提出「自动化失败归因」,发布Who&When数据集,探索三种归因方法,揭示该问题的复杂性与挑战性。

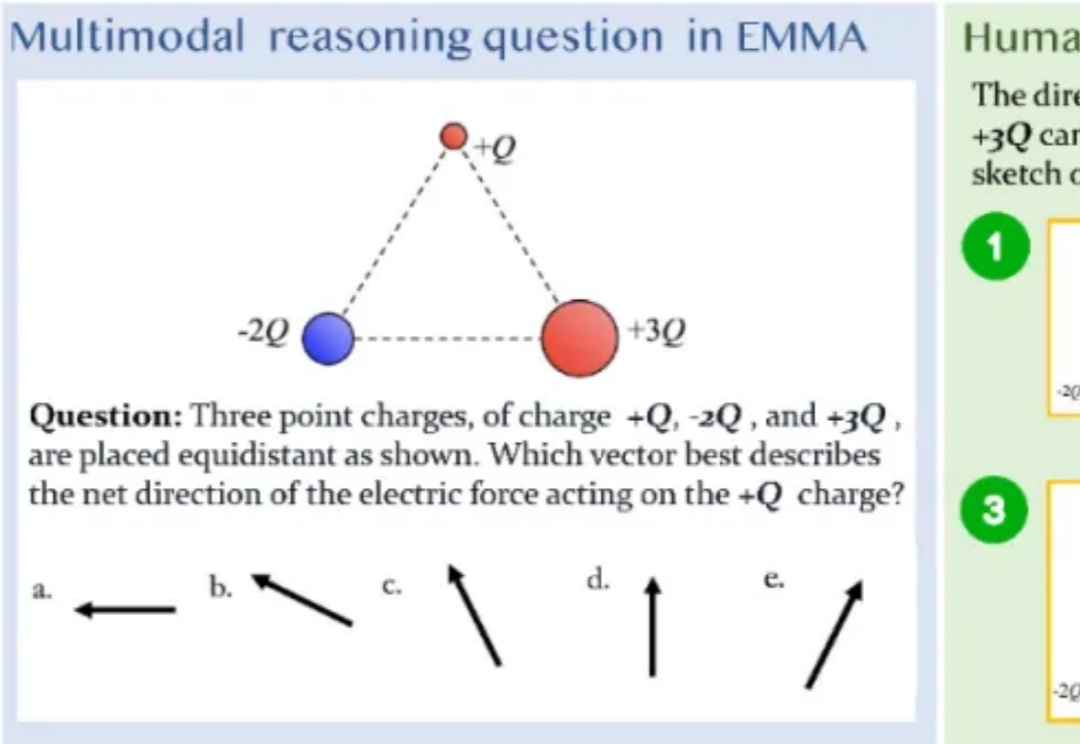

「三个点电荷 + Q、-2Q 和 + 3Q 等距放置,哪个向量最能描述作用在 + Q 电荷上的净电力方向?」

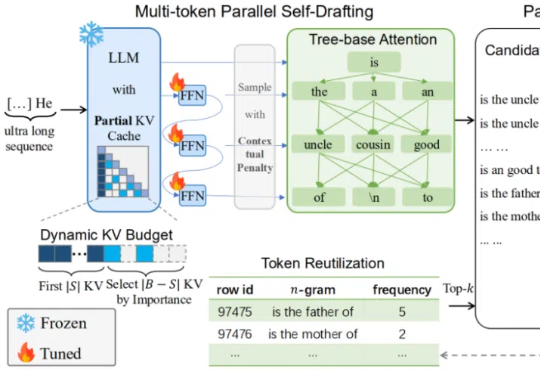

本文作者分别来自中国科学院大学和中国科学院计算技术研究所。第一作者裴高政为中国科学院大学博士二年级学生,本工作共同通讯作者是中国科学院大学马坷副教授和黄庆明教授。

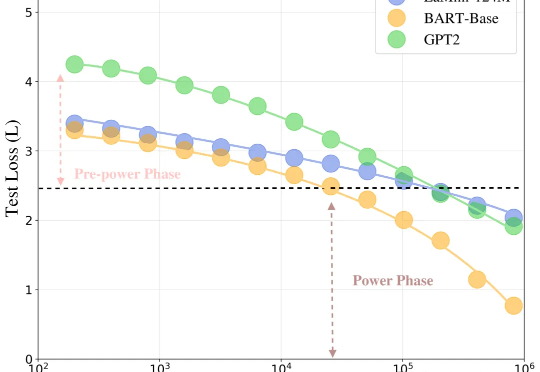

在当前大模型推理愈发复杂的时代,如何快速、高效地产生超长文本,成为了模型部署与优化中的一大核心挑战。

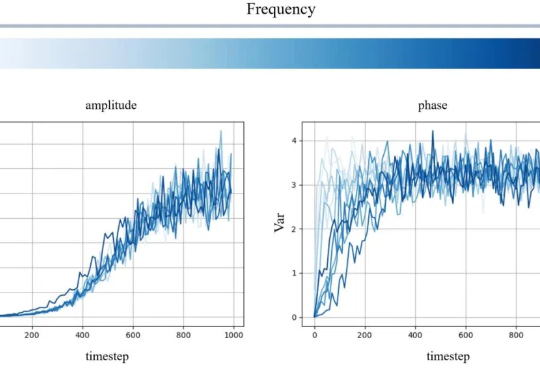

该工作由南洋理工大学陶大程教授团队与武汉大学罗勇教授、杜博教授团队等合作完成。

空间音频,作为一种能够模拟真实听觉环境的技术,正逐渐成为提升沉浸式体验的关键。