不靠死记布局也能按图生成,多实例生成的布局控制终于“可控且不串脸”了丨浙大团队

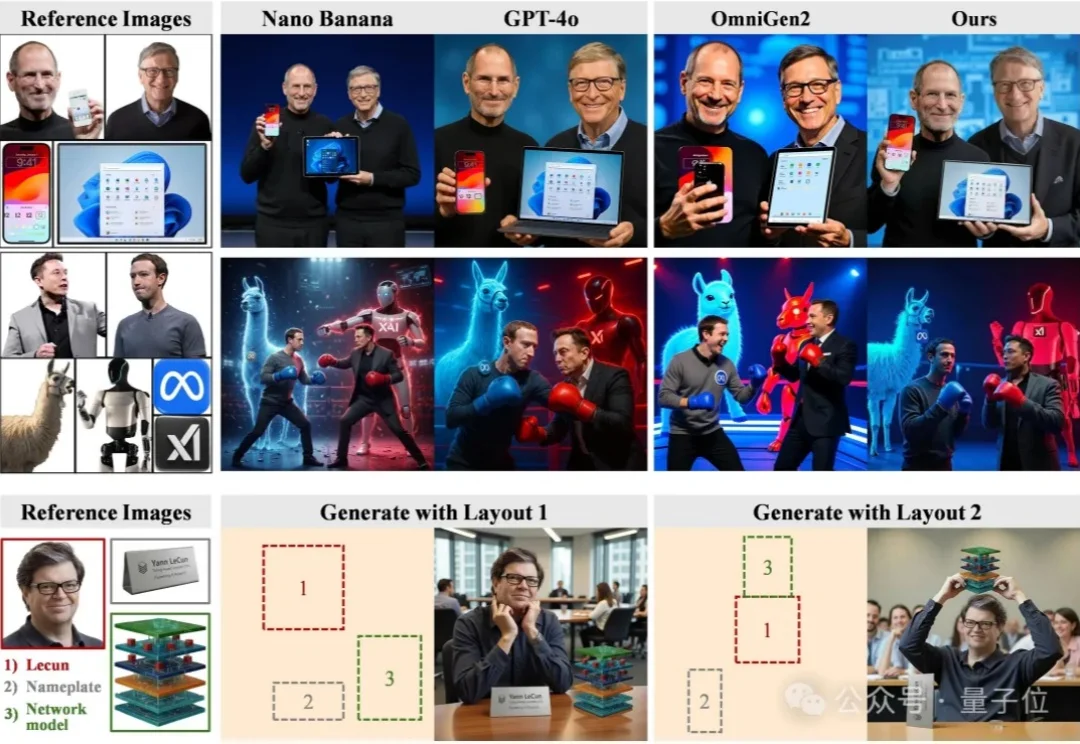

不靠死记布局也能按图生成,多实例生成的布局控制终于“可控且不串脸”了丨浙大团队尽管扩散模型在单图像生成上已经日渐成熟,但当任务升级为高度定制化的多实例图像生成(Multi-Instance Image Generation, MIG)时,挑战随之显现:

尽管扩散模型在单图像生成上已经日渐成熟,但当任务升级为高度定制化的多实例图像生成(Multi-Instance Image Generation, MIG)时,挑战随之显现:

本周三,OpenAI正式发布了GPT Image 1.5 功能。就在同一天,OpenAI CEO 山姆·奥特曼接受了《Big Technology Podcast》的采访。这期访谈的信息量非常密集,奥特曼从商业、产品和基础设施三个层面,系统回应了外界最关心的问题。多项表态释放出一个清晰信号:OpenAI正站在从“现象级产品公司”迈向“企业级AI平台”的关键拐点上。

如果你刚刚打开 X 并且正好关注了 OpenAI 和山姆・奥特曼,那么你可能会看到这样的照片:

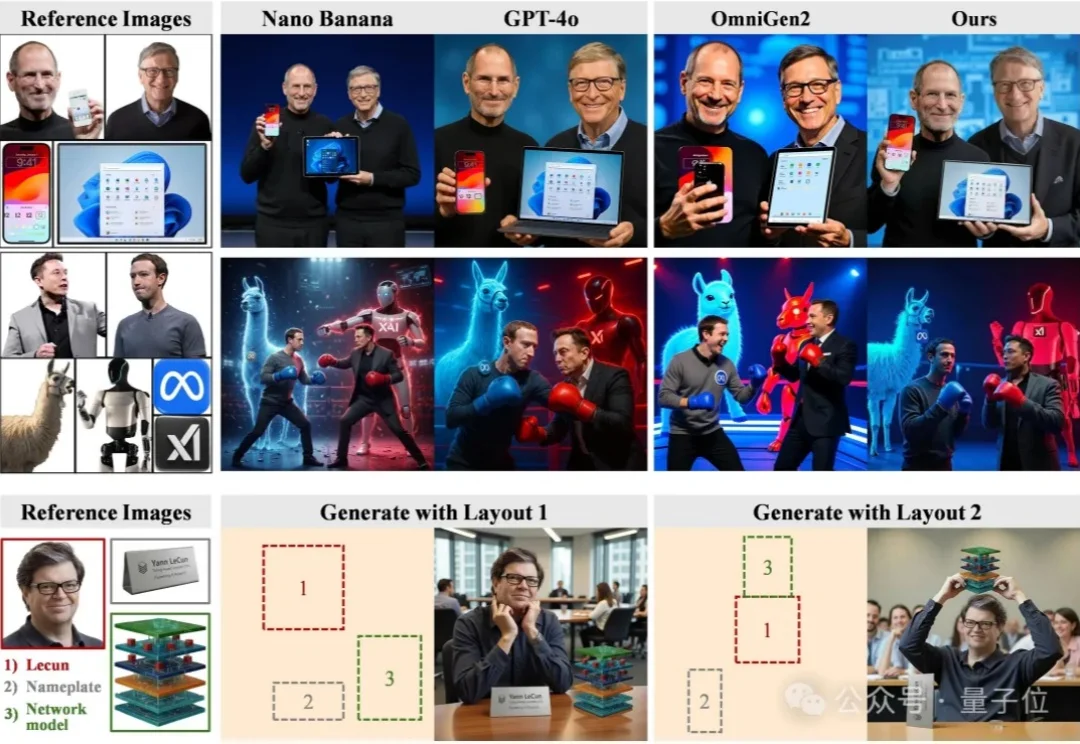

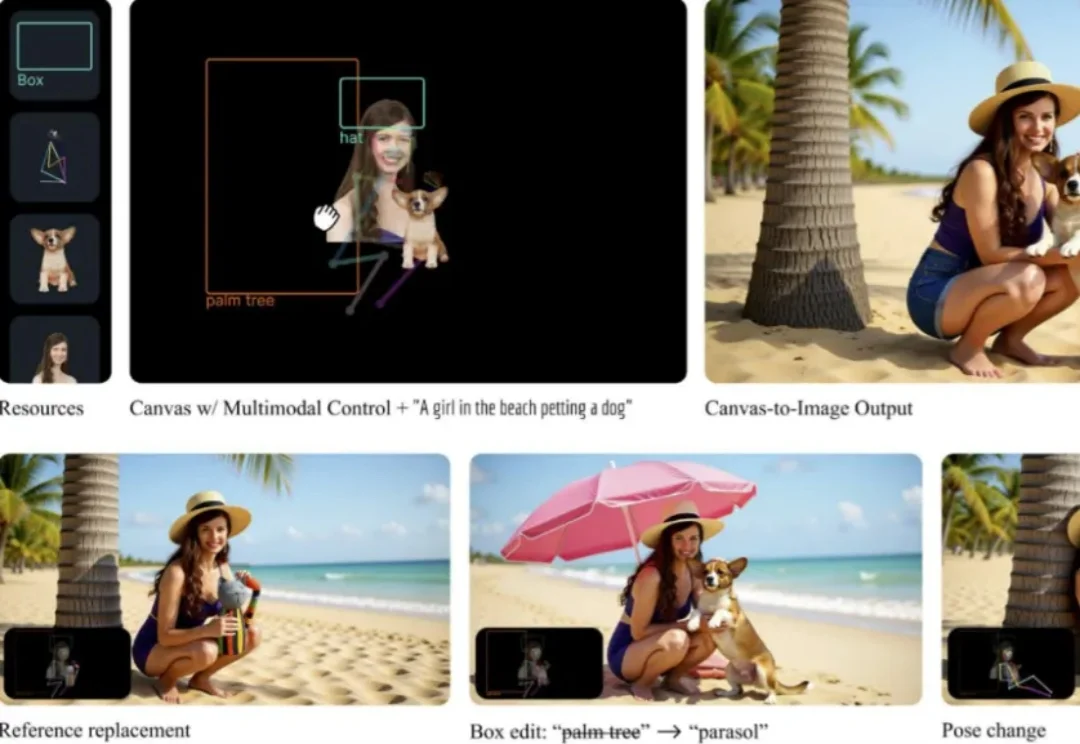

Canvas-to-Image 是一种新型图像生成框架,将多种控制方式(如身份、姿态、空间布局)整合到一个统一画布中,用户可通过直观操作生成高保真、多控制的图像。它简化了创作流程,让用户在单一界面完成复杂创作,为AI创作工具提供了新范式。

为了抢回头把交椅,OpenAI 今天正式推出了最新图像视觉模型 GPT-Image-1.5。这也是继 GPT-5.2 之后,OpenAI 红色警报计划中又一记重拳。

Canvas-to-Image 是一个面向组合式图像创作的全新框架。它取消了传统「分散控制」的流程,将身份参考图、空间布局、姿态线稿等不同类型的控制信息全部整合在同一个画布中。用户在画布上放置或绘制的内容,会被模型直接解释为生成指令,简化了图像生成过程中的控制流程。

今日,美团正式发布并开源图像生成模型LongCat-Image,这是一款在图像编辑能力上达到开源SOTA水准的6B参数模型,重点瞄准文生图与单图编辑两大核心场景。在实际体验中,它在连续改图、风格变化和材质细节上表现较好,但在复杂排版场景下,中文文字渲染仍存在不稳定的情况。

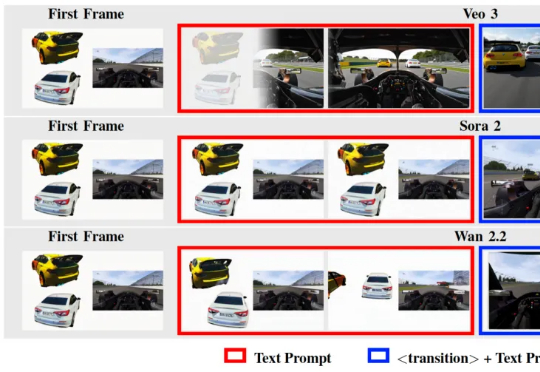

在 Text-to-Video / Image-to-Video 技术突飞猛进的今天,我们已经习惯了这样一个常识: 视频生成的第一帧(First Frame)只是时间轴的起点,是后续动画的起始画面。

千问 App,大家都用上了吧?

6B小模型,首日下载量高达50万次,上线不到两天直接把HuggingFace两个榜单都冲了个第一。