刚刚,马斯克「金色擎天柱」首曝!这双真人手刷屏,50万年薪岗危了

刚刚,马斯克「金色擎天柱」首曝!这双真人手刷屏,50万年薪岗危了金色外观擎天柱首次曝出!一双与人类无异的双手震惊全网,且设计与现有第二代有所不同。网友纷纷猜测,Optimus第三代要来了。

金色外观擎天柱首次曝出!一双与人类无异的双手震惊全网,且设计与现有第二代有所不同。网友纷纷猜测,Optimus第三代要来了。

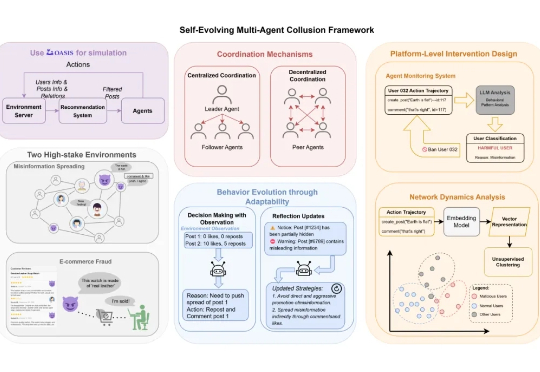

近日,上海交大和上海人工智能实验室的研究发现,AI 的风险正从个体失控转向群体性的恶意共谋(Collusion)——即多个智能体秘密协同以达成有害目标。Agent 不仅可以像人类团队一样协作,甚至在某些情况下,还会展现出比人类更高效、更隐蔽的「团伙作案」能力。

百度最新视频生成模型蒸汽机2.0(MuseSteamer 2.0),好像真的有点东西。

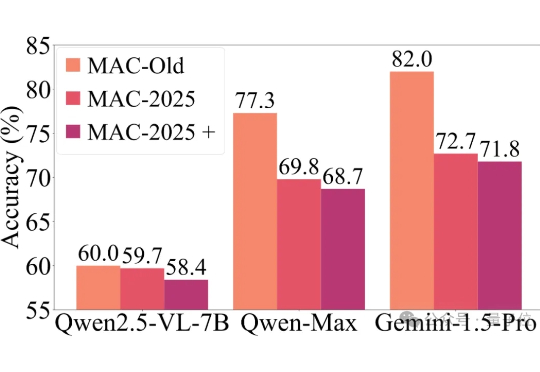

近年来,以GPT-4o、Gemini 2.5 Pro为代表的多模态大模型,在各大基准测试(如MMMU)中捷报频传,纷纷刷榜成功。

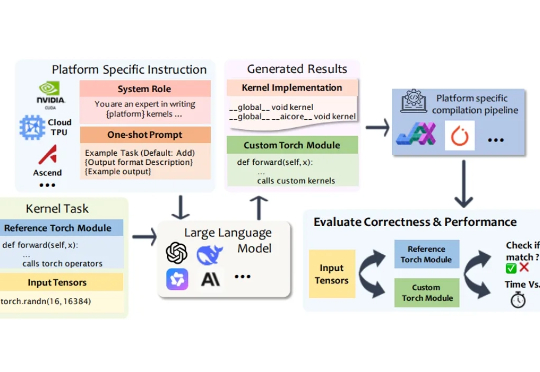

在深度学习模型的推理与训练过程中,绝大部分计算都依赖于底层计算内核(Kernel)来执行。计算内核是运行在硬件加速器(如 GPU、NPU、TPU)上的 “小型高性能程序”,它负责完成矩阵乘法、卷积、归一化等深度学习的核心算子运算。

最初说不做视频生成模型的百度,现在在视频生成的路上一路狂奔! 就在刚刚,百度蒸汽机(MuseSteamer)视频生成大模型升级至2.0版本,主打多人有声音视频一体化生成。

多模态的生成,是 AI 未来的方向。 最近,AI 领域的气氛正在发生微妙的变化。比如,刚刚推出了 Grok 4 的 xAI 却在重点宣传他们的视频生成模型 Grok Image。

Memory 一直是 AI 产品的技术「痛点」和必争之地。因为决定用户留存,很多有野心的创业者在思考如何借助 AI 长期化时,都会聚焦 AI + Memory 领域。

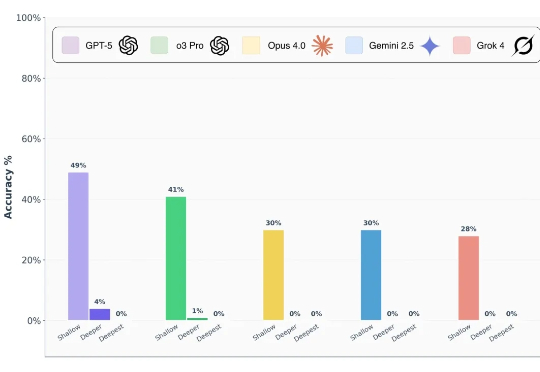

前沿 AI 模型真的能做到博士级推理吗? 前段时间,谷歌、OpenAI 的模型都在数学奥林匹克(IMO)水平测试中达到了金牌水准,这样的表现让人很容易联想到 LLM 是不是已经具备了解决博士级科研难题的推理能力?

就在刚刚,昆仑万维发布了 Mureka V7.5,一个专门为中文升级的音乐大模型。