英伟达帮你省钱,让大模型推理「短而精」,速度快5倍

英伟达帮你省钱,让大模型推理「短而精」,速度快5倍大模型推理到底要不要「长篇大论」?过去一年,OpenAI o 系列、DeepSeek-R1、Qwen 等一系列推理模型,把「长链思维」玩到极致:答案更准了,但代价是推理链越来越长、Token 消耗爆炸、响应速度骤降。

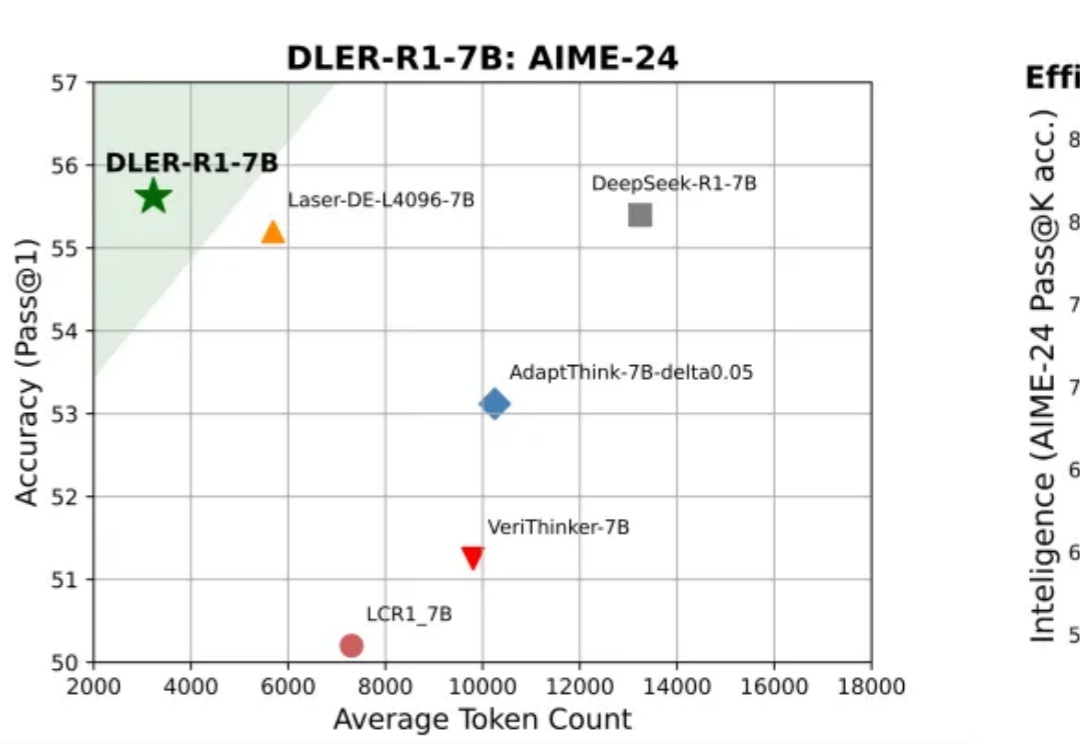

大模型推理到底要不要「长篇大论」?过去一年,OpenAI o 系列、DeepSeek-R1、Qwen 等一系列推理模型,把「长链思维」玩到极致:答案更准了,但代价是推理链越来越长、Token 消耗爆炸、响应速度骤降。

Qwen 团队终于在周日的晚上, 兑现了本周会更新Qwen3-Max thinking 的承诺。 而这个更新, 基本也是上周所有更新中为数不多非常期待的了。 毕竟Qwen3-Max也是Qwen整个家族里最大、最强的模型,

今天要讲的On-Policy Distillation(同策略/在线策略蒸馏)。这是一个Thinking Machines整的新活,这个新策略既有强化学习等在线策略方法的相关性和可靠性;又具备离线策略(Off-policy)方法的数据效率。

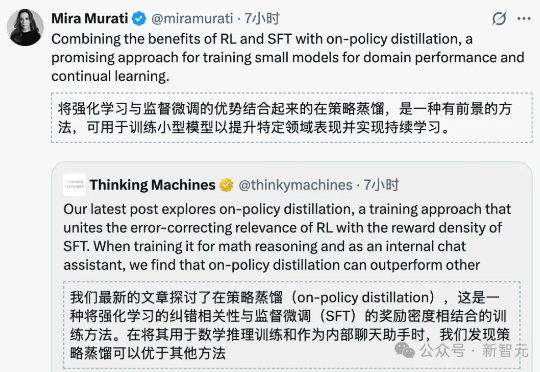

今天推荐一个 Dense Image Captioning 的最新技术 —— CapRL (Captioning Reinforcement Learning)。CapRL 首次成功将 DeepSeek-R1 的强化学习方法应用到 image captioning 这种开放视觉任务,创新的以实用性重新定义 image captioning 的 reward。

刚刚,不发论文、爱发博客的 Thinking Machines Lab (以下简称 TML)再次更新,发布了一篇题为《在策略蒸馏》的博客。在策略蒸馏(on-policy distillation)是一种将强化学习 (RL) 的纠错相关性与 SFT 的奖励密度相结合的训练方法。在将其用于数学推理和内部聊天助手时,TML 发现在策略蒸馏可以极低的成本超越其他方法。

彭超曾在华为印度、阿里任消费硬件业务1号位;联合创始人齐炜祯为Multi-token架构开创学者,被Deepseek、Qwen引入预训练方法。

近日,号称是首个专注于金融市场的 AI 实验室的美国实验室 Nof1 启动了一个将多个 AI 大模型置于真实金融市场中进行自动化交易对决的实验平台。这一项目的名称叫做 Alpha Arena,它是一个

10 月 23 日,一向不爱出风头的夸克上线了对话助手,可以让用户在一个 App 内即可完成信息查找、问题解答与任务处理,实现了 AI 搜索与对话的深度融合。其中一大亮点就是,该对话助手采用了 Qwen 最新闭源模型。至于是哪个型号、性能有多强,夸克卖了个关子,只透露比 Qwen3-Max 更进一步,在业界有绝对领先性。

全球六大LLM实盘厮杀,新王登基!今天,Qwen3 Max凭借一波「快狠准」操作,逆袭DeepSeek夺下第一。Qwen3 Max,一骑绝尘! 而GPT-5则接替Gemini 2.5 Pro,成为「最会赔钱」的AI。照目前这个趋势,估计很快就要跌没了……

当OpenAI为ChatGPT各种造势时,中国模型也在凭实力圈粉老外。最近,爱彼迎(Airbnb)联合创始人兼CEO Brian Chesky的一番公开表态掀起波澜:要知道Brian Chesky和奥特曼还是挚友,但当涉及自家应用产品整合时,他却没给老朋友留面子,直言OpenAI提供的连接工具还“没有完全准备好”。