突发!AI编程工具Trae正式下架Claude模型

突发!AI编程工具Trae正式下架Claude模型早上工作的时候发现,Trae的模型列表中已经找不到Claude模型了。与此同时,行业群内、包括官方答疑群内也有不少朋友反应,自己的Trae都用不上claude。细心的朋友发现,虽然Claude模型消失了但付费用户的订阅里显示每月增加了300次的快速请求。猜测此举是对claude模型下架的一种补偿。

早上工作的时候发现,Trae的模型列表中已经找不到Claude模型了。与此同时,行业群内、包括官方答疑群内也有不少朋友反应,自己的Trae都用不上claude。细心的朋友发现,虽然Claude模型消失了但付费用户的订阅里显示每月增加了300次的快速请求。猜测此举是对claude模型下架的一种补偿。

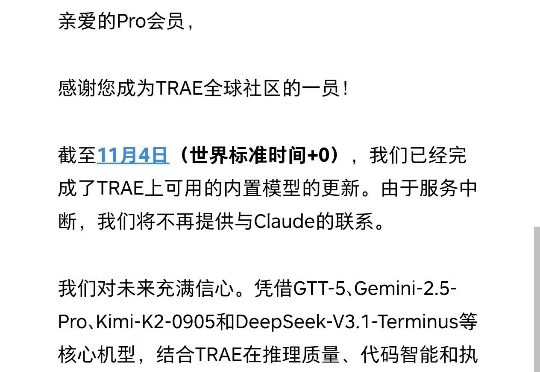

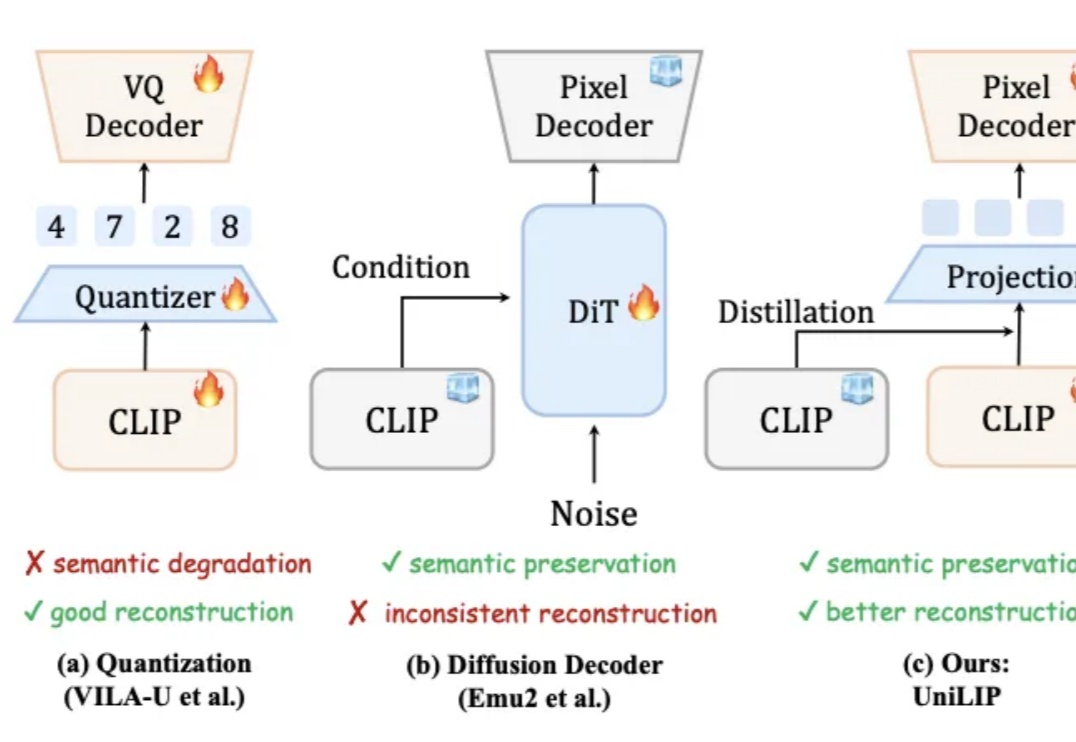

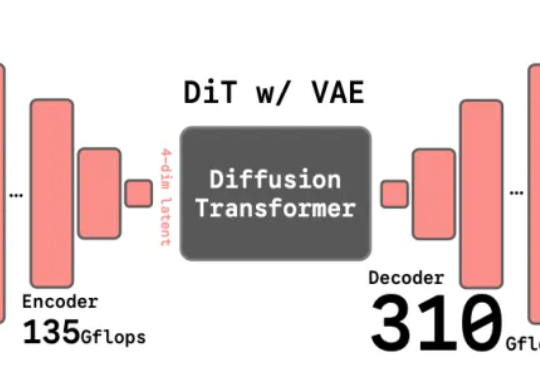

统一多模态模型要求视觉表征必须兼顾语义(理解)和细节(生成 / 编辑)。早期 VAE 因语义不足而理解受限。近期基于 CLIP 的统一编码器,面临理解与重建的权衡:直接量化 CLIP 特征会损害理解性能;而为冻结的 CLIP 训练解码器,又因特征细节缺失而无法精确重建。例如,RAE 使用冻结的 DINOv2 重建,PSNR 仅 19.23。

对冲基金Praetorian Capital创始人哈里斯·库珀曼(Harris Kupperman)向《每日经济新闻》记者(以下简称每经记者)表示,AI投资从回报上看说不通。整个AI行业需要1万亿美元的收入才能实现收支平衡,而目前行业的月收入仅略超10亿美元。也就是说,要收回目前计划的支出,需要约83年。

长期以来,扩散模型的训练通常依赖由变分自编码器(VAE)构建的低维潜空间表示。然而,VAE 的潜空间表征能力有限,难以有效支撑感知理解等核心视觉任务,同时「VAE + Diffusion」的范式在训练

谢赛宁团队最新研究给出了答案——VAE的时代结束,RAE将接力前行。其中表征自编码器RAE(Representation Autoencoders)是一种用于扩散Transformer(DiT)训练的新型自动编码器,其核心设计是用预训练的表征编码器(如DINO、SigLIP、MAE 等)与训练后的轻量级解码器配对,从而替代传统扩散模型中依赖的VAE(变分自动编码器)。

主打“自动化执行、多模型调用、上下文记忆”的 AI 编程应用大热,但运行卡顿、资源消耗惊人、推理成本过高等问题也随之而来。

近日,一位开发者在 GitHub 上公开警告称,字节跳动旗下 AI 编程环境 Trae IDE 存在在用户未明确知情的情况下,将数据上传至字节服务器的行为,即便用户已在设置中手动关闭遥测(Telemetry)功能。

字节跳动在 Trae IDE(Visual Studio Code 的分支)中发现的令人担忧的性能和隐私问题。主要发现包括:资源消耗过高(33 个进程 vs. VSCode 中为 9 个进程)、无论用户如何设置,遥测数据都会持续传输,以及令人担忧的社区管理实践。

兄弟们,是不是也感觉最近被Cursor“背刺”了?这位曾经的AI编程王者,开启 AI 编程大航海时代的白月光,现在是又卡又慢,关键的Claude模型还不给中国区用、改变计费方式,用户的体验简直一言难尽。

在过去很长一段时间里,科技圈似乎人均都成了“提示词工程师”,大家都在琢磨怎么用最精妙的语言驯服AI。但包括Andrej Karpathy在内的很多行业大佬已经开始反思了,他们认为,决定AI效果的关键,可能早就不是怎么问,而是你给AI喂了什么料。这个思路,就是最近越来越火的上下文工程(Context Engineering)。