斯坦福用一句Prompt就结束了提示工程。。。

斯坦福用一句Prompt就结束了提示工程。。。最近口述采样很火。如果您经常使用经过“对齐”训练(如RLHF)的LLM,您可能已经注意到一个现象:模型虽然变得听话、安全了,但也变得巨“无聊”。

最近口述采样很火。如果您经常使用经过“对齐”训练(如RLHF)的LLM,您可能已经注意到一个现象:模型虽然变得听话、安全了,但也变得巨“无聊”。

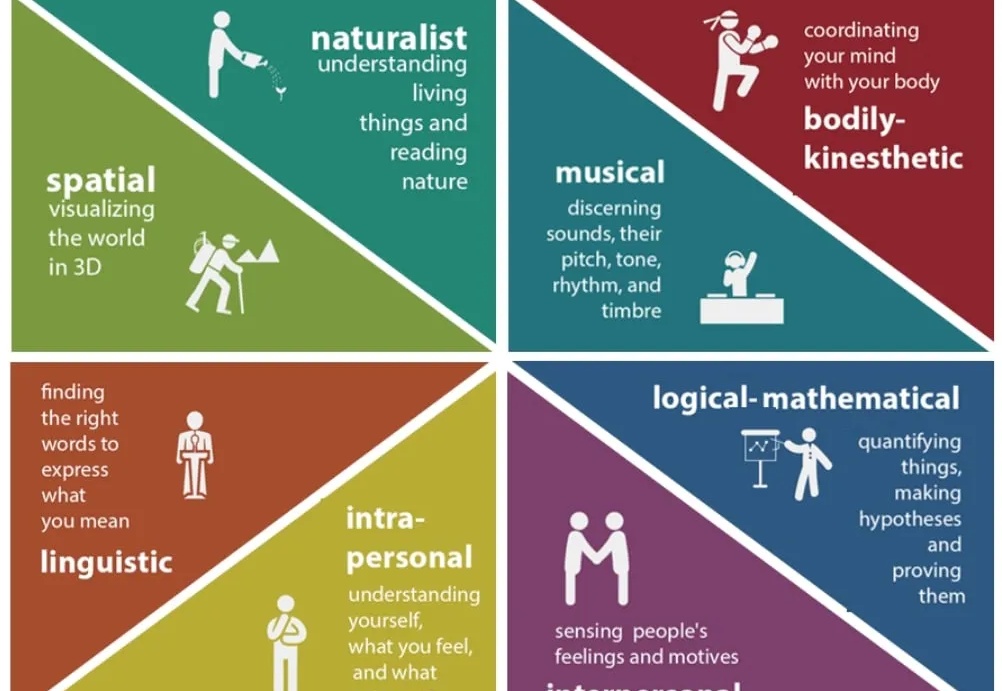

如今 LLM 的语言理解与生成能力已展现出惊人的广泛适用性,但随着 LLM 的发展,一个事实越发凸显:仅靠语言,仍不足以支撑真正的智能。

面对谷歌攻势,OpenAI内部炸锅了。

三年河东三年河西,曾经逼疯谷歌的奥特曼,如今也被谷歌逼得拉响了「红色警报」,AI王座之下已是刀光剑影。更劲爆的是,最强「Garlic」在预训练取得重大突破,正面硬刚Gemini 3.

VLA模型性能暴涨300%,背后训练数据还首次实现90%由世界模型生成。

在 Vision-Language Model 领域,提升其复杂推理能力通常依赖于耗费巨大的人工标注数据或启发式奖励。这不仅成本高昂,且难以规模化。

本文第一作者为刘禹宏,上海交通大学人工智能专业本科四年级学生,相关研究工作于上海人工智能实验室科研实习期间完成。通讯作者为王佳琦、臧宇航,在该研究工作完成期间,均担任上海人工智能实验室研究员。

人工智能研究的最新目标,尤其是在追求“通用人工智能”(AGI)的实验室中,是一个被称为“世界模型”(world model)的概念:这是一种AI内部携带的环境表征,就像一个计算型的雪球玻璃球。AI系统可以借助这个简化的内部模型,在真正执行任务之前,先对预测和决策进行评估。

对初创公司来说,Superlinear(指数引力)的第一个业务 Deeplink 堪称成功:去年成立,今年的 ARR(年经常性收入) 就达到 500 万美元;且已经实现盈利。但创始人于北川并不打算在这个业务上继续重点投入,而是带领核心团队,全力转向了一款新产品 Lessie AI。

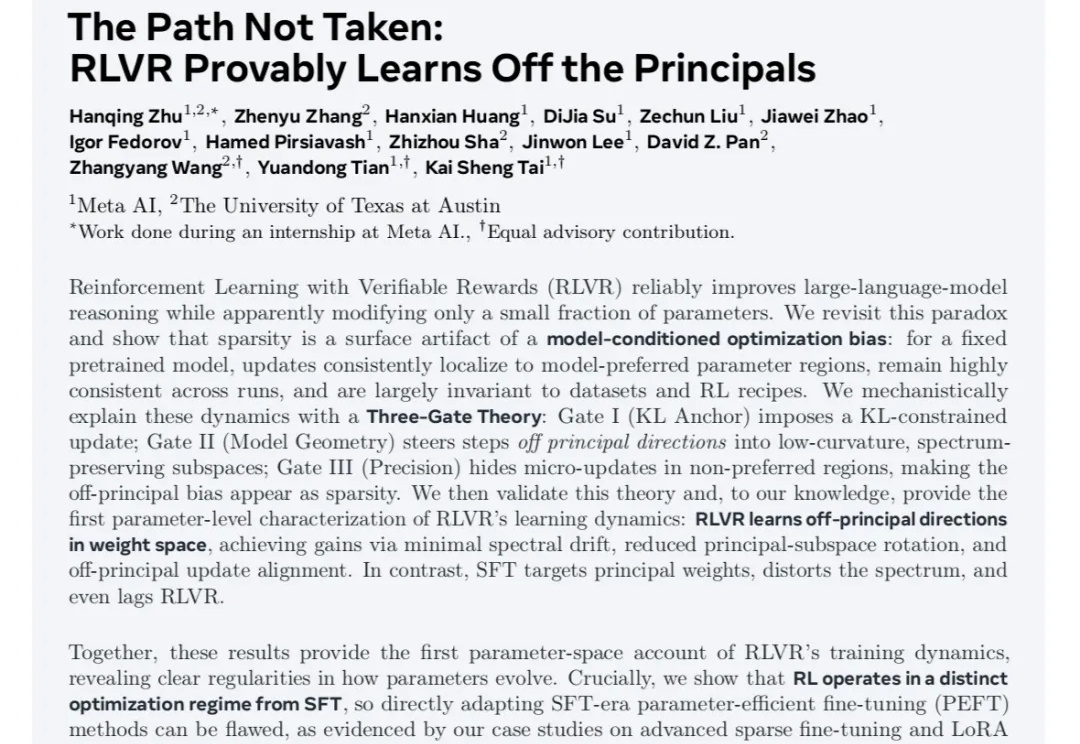

最近不论是在学术圈还是产业实践中,对于RLVR和传统SFT之间的区别与联系,以及RL本身基于奖励建模反馈机制并结合不同的策略优化算法过程中对模型显性知识的学习和隐参数空间的变化的讨论热度一直很高。