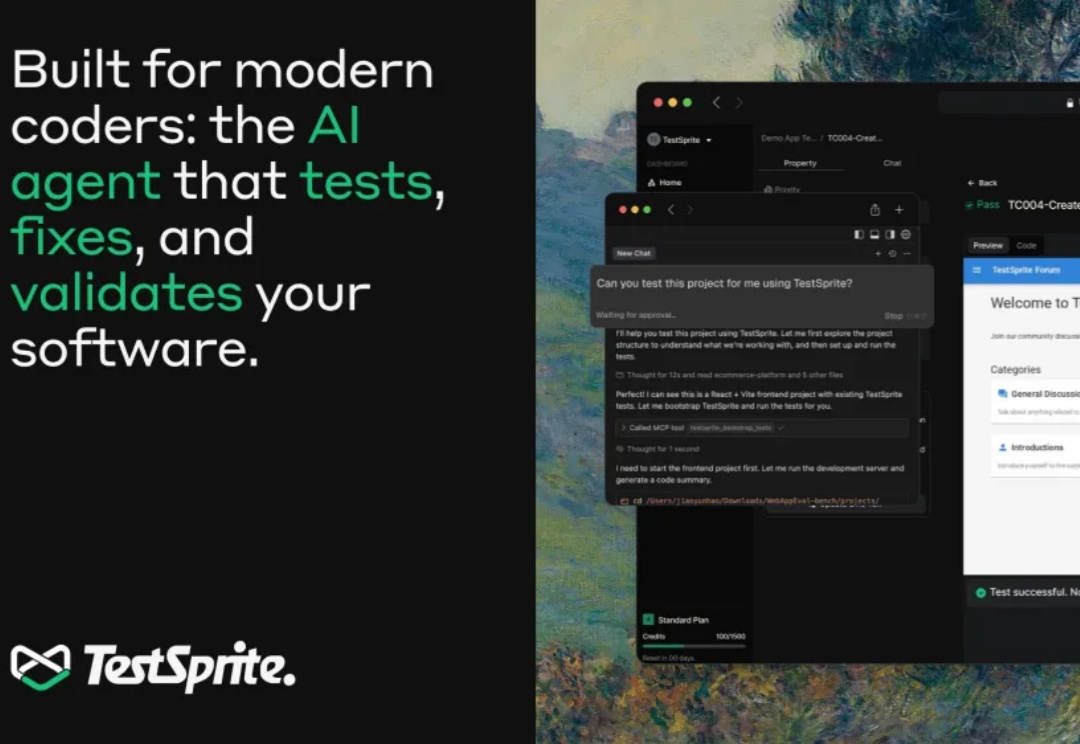

Z Potentials|专访TestSprite创始人,前AWS&Google工程师,打造全球4万开发者的测试Agent

Z Potentials|专访TestSprite创始人,前AWS&Google工程师,打造全球4万开发者的测试Agent这两年,写代码这件事变了。GitHub Copilot、Cursor、Devin 一路登场,工程师开始习惯“打一段话,几千行代码自己长出来”。写得出东西,变得前所未有地容易。但很快大家发现,真正拖住上线节奏的,不再是「能不能写出来」,而是「敢不敢放上生产环境」——代码量指数级增长,验证、回归、极端场景覆盖反而被彻底压缩,测试成了 AI 时代新的“硬瓶颈”。