a16z 提出 AI 产品的「水晶鞋效应」:第一批用户反而是最忠诚的

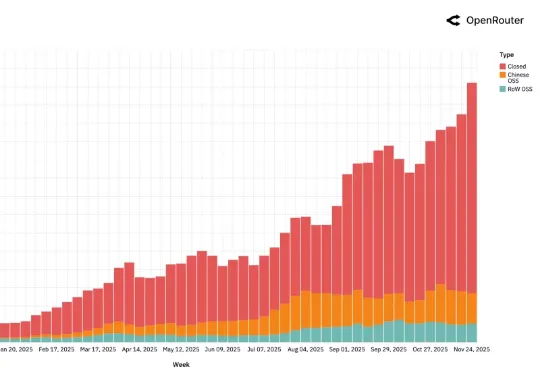

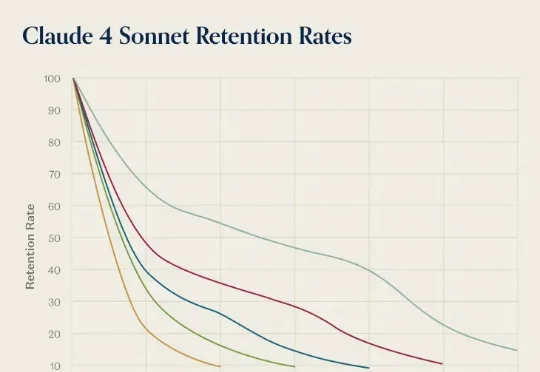

a16z 提出 AI 产品的「水晶鞋效应」:第一批用户反而是最忠诚的前几天,AI 推理服务供应商 OpenRouter 发布了一份报告《State of AI》,基于平台上 60 多家提供商的 300 多个模型,100 万亿个 token 的交互数据,对 LLM 的实际应用情况进行了分析。报告中,提到了一个「灰姑娘水晶鞋效应」,特别有意思。研究者在分析用户留用数据时发现一个现象:AI 模型发布第一个月进来的用户,往往比后来进来的用户留存率更高。