Z Product|估值10亿美金的计费系统Metronome,如何成为OpenAI、英伟达首选的计价底层

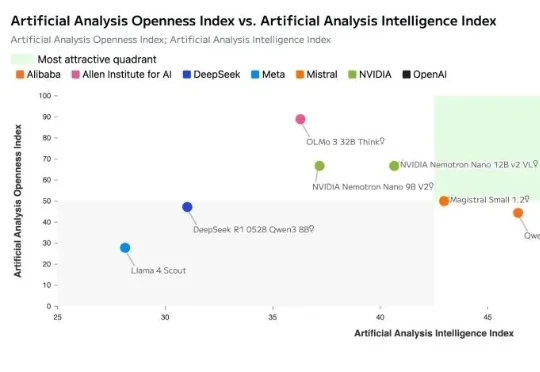

Z Product|估值10亿美金的计费系统Metronome,如何成为OpenAI、英伟达首选的计价底层Metronome成立于2019年的旧金山,专注于为AI与软件公司提供实时计费基础设施,解决从传统按Seat收费转向按用量、Token等复杂定价的工程难题。目前其融资总额达1.28亿美元,已服务OpenAI、NVIDIA、Databricks等头部企业,终端用户超1.5亿,成为AI时代“按价值收费”的关键基础设施。