告别「盲目自信」,CCD:扩散语言模型推理新SOTA

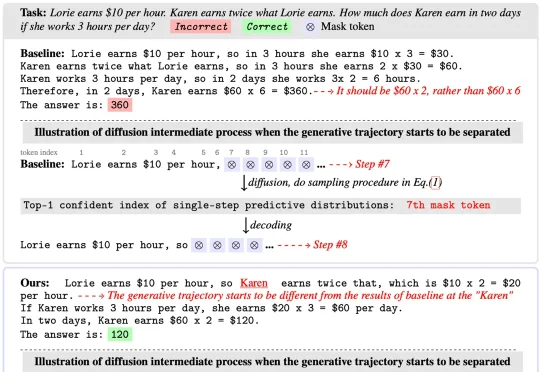

告别「盲目自信」,CCD:扩散语言模型推理新SOTA扩散语言模型(Diffusion Language Models)以其独特的 “全局规划” 与并行解码能力广为人知,成为 LLM 领域的全新范式之一。然而在 Any-order 解码模式下,其通常面临

扩散语言模型(Diffusion Language Models)以其独特的 “全局规划” 与并行解码能力广为人知,成为 LLM 领域的全新范式之一。然而在 Any-order 解码模式下,其通常面临

实现通用机器人的类人灵巧操作能力,是机器人学领域长期以来的核心挑战之一。近年来,视觉 - 语言 - 动作 (Vision-Language-Action,VLA) 模型在机器人技能学习方面展现出显著潜力,但其发展受制于一个根本性瓶颈:高质量操作数据的获取。

随着基础模型的日益成熟,AI领域的研发重心正从“训练更强的模型”转移到“构建更强的系统”。在这个新阶段,适配(Adaptation) 成为了连接通用智能与垂直应用的关键纽带。

今日凌晨,比OpenAI早一个小时,谷歌甩出了3个Agent大招:Deep Research Agent功能更新,并首次向开发者开放;开源新网络研究Agent基准DeepSearchQA,旨在测试Agent在网络研究任务中的全面性;推出新交互API(Interactions API)。

今年 10 月,专注构建世界模型的 General Intuition 完成了高达 1.34 亿美元的种子轮融资。这笔融资由硅谷传奇投资人 Vinod Khosla 领投,这是他自 2019 年首次投资 OpenAI 以来开出的最大单笔种子轮投资,也标志着他在 LLM 之后对下一代智能范式做出的一次重大下注。

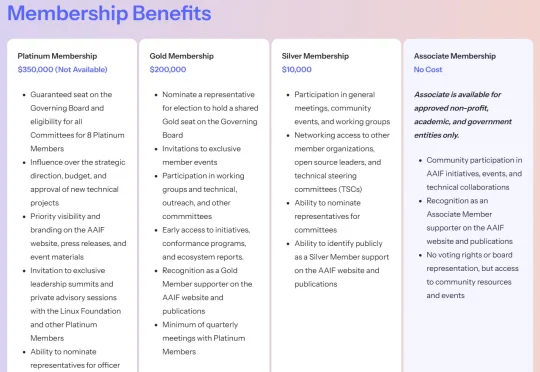

刚刚,Linux 基金会正式宣布推出智能体 AI 基金会(Agentic AI Foundation,简称 AAIF)。据公告披露,AAIF 定位为 AI 智能体(AI agents)相关开源项目的中立托管平台,全球几乎所有科技巨头均已签约成为该基金会成员。Anthropic、OpenAI 与 Block 三家公司作为联合创始成员,将贡献三大开源项目,构成基金会启动初期的支柱。

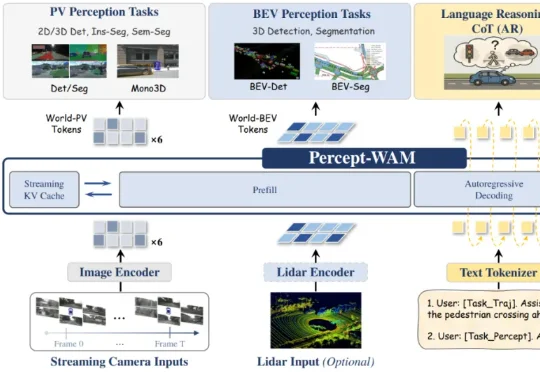

近日,来自引望智能与复旦大学的研究团队联合提出了一个面向自动驾驶的新一代大模型 ——Percept-WAM(Perception-Enhanced World–Awareness–Action Model)。该模型旨在在一个统一的大模型中,将「看见世界(Perception)」「理解世界(World–Awareness)」和「驱动车辆行动(Action)」真正打通,形成一条从感知到决策的完整链路。

12月8日,Airwallex空中云汇继今年5月后再次宣布获得新一轮3.3亿美元G轮融资,投后估值达 80 亿美元,较六个月前 F 轮融资时上涨近 30%。本次融资由Addition领投,T. Rowe Price、Activant、Lingotto、Robinhood Ventures和 TIAA Ventures等全球顶级资本参与投资。

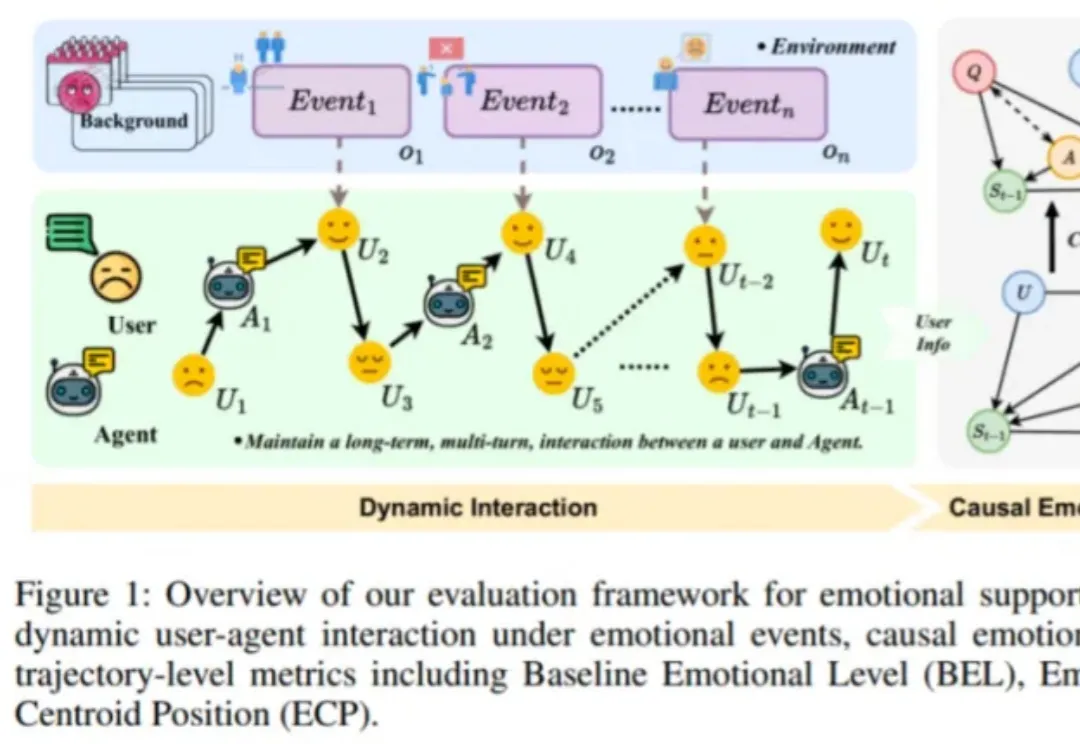

近日,由趣丸科技与北京大学软件工程国家工程研究中心共同发表的《Detecting Emotional Dynamic Trajectories: An Evaluation Framework for Emotional Support in Language Models(检测情感动态轨迹:大语言模型情感支持的评估框架)》论文,获 AAAI 2026 录用。

无需懂一行代码,Gemini 3正在重塑3D交互创作的边界!详细对比了Canvas与AI Studio在开发场景下的独特优势,带你亲身体验这场「零门槛」的3D交互革命。