Gemini手搓3D粒子特效,体验现实版钢铁侠

Gemini手搓3D粒子特效,体验现实版钢铁侠无需懂一行代码,Gemini 3正在重塑3D交互创作的边界!详细对比了Canvas与AI Studio在开发场景下的独特优势,带你亲身体验这场「零门槛」的3D交互革命。

无需懂一行代码,Gemini 3正在重塑3D交互创作的边界!详细对比了Canvas与AI Studio在开发场景下的独特优势,带你亲身体验这场「零门槛」的3D交互革命。

2025就要过去了。UC Berkeley、Stanford和IBM联手做了一件大事。他们调研了306份在一线“造 Agent”的从业者问卷,并深度访谈了20个已经成功落地并产生价值的一线企业案例(涵盖金融、科技、医疗等领域)。试图回答一个最朴素的工程问题:一个能用的、赚钱的Agent,到底是用什么架构搭出来的?

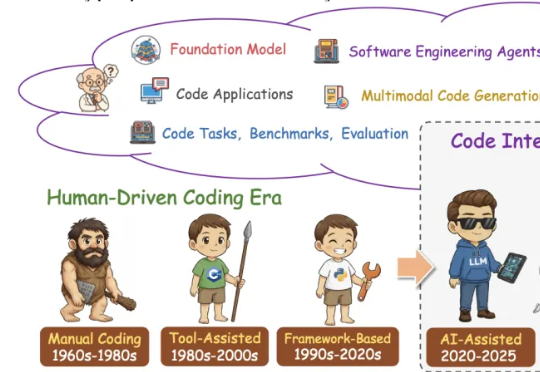

这篇学术论长文由北京航空航天大学复杂关键软件环境全国重点实验室领衔。《From Code Foundation Models to Agents and Applications》一文是对过去几年代码智能领域的一次系统梳理:模型、任务、训练、智能体、安全与应用都被串联成了一条完整、连贯的技术链路。

确实也是轰动数学和AI两界了。因为就在最近,世界级顶尖数学家宣布辞职,前往硅谷,全职加入AI初创公司——这家公司,还是自己学生创办的——一个24岁00后华人女生。吸引他的这家公司,也不是等闲之辈,而是硅谷新贵——Axiom,一家主打AI数学的明星公司。

近日,AI 初创公司 Axiom 宣布其模型在没有人类干预的情况下,自动完成了两个数学猜想的证明——埃尔德什问题(Erdős Problem)中的 481 号和 124 号。据称,481 号问题仅用时 5 小时,代码量为 656 行;124 号问题则耗时超 24 小时。值得关注的是,这些证明均通过 Lean 验证,Lean 的特点是其形式化证明过程无需人工干预,为数学正确性提供了保障。

Anthropic发布了Programmatic Tool Calling(PTC)特性,让Claude通过代码编排工具执行,降低token消耗、减少延迟并提升准确性。

Vision–Language–Action(VLA)策略正逐渐成为机器人迈向通用操作智能的重要技术路径:这类策略能够在统一模型内同时处理视觉感知、语言指令并生成连续控制信号。

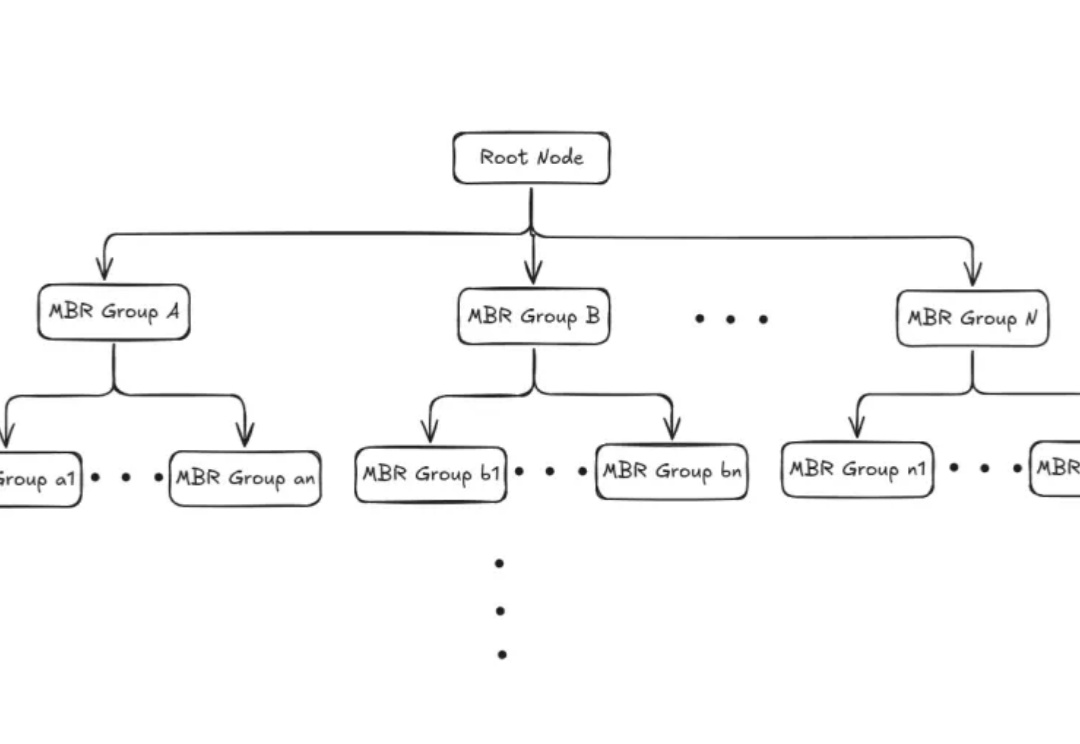

本文为Milvus Week系列第三篇,该系列旨在分享Milvus的创新与实践成果,以下是DAY3内容划重点: Milvus2.6中,Zilliz借助Geolocation Index for Milvus,首次将地理空间数据与向量检索融合,使 AI 可以在理解语义的同时,理解空间。

大家好,我是袋鼠帝。 今天想跟大家聊聊最近很火的一个新概念:GEO

在 Vision-Language Model 领域,提升其复杂推理能力通常依赖于耗费巨大的人工标注数据或启发式奖励。这不仅成本高昂,且难以规模化。