GDP增长将取决于Tokens数量?微软CEO纳德拉达沃斯对话信息量太大了……

GDP增长将取决于Tokens数量?微软CEO纳德拉达沃斯对话信息量太大了……在2026年的世界经济论坛上,微软 CEO 萨提亚·纳德拉(Satya Nadella)与贝莱德 CEO 拉里·芬克(Larry Fink)进行了一场对话。

在2026年的世界经济论坛上,微软 CEO 萨提亚·纳德拉(Satya Nadella)与贝莱德 CEO 拉里·芬克(Larry Fink)进行了一场对话。

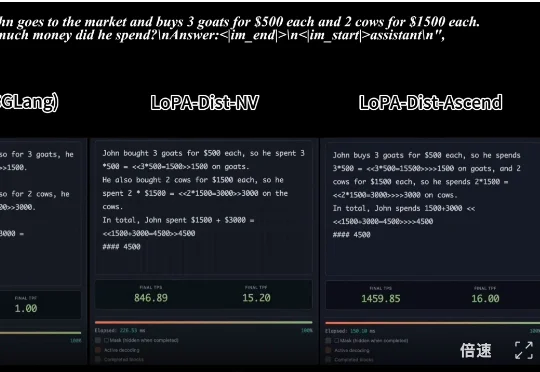

,时长 00:20 视频 1:单样例推理速度对比:SGLang 部署的 Qwen3-8B (NVIDIA) vs. LoPA-Dist 部署 (NVIDIA & Ascend)(注:NVIDIA 平台

今天,在 FORCE 原动力大会上,火山引擎发布豆包大模型1.8、豆包视频生成模型 Seedance 1.5 pro。经过一年多的持续升级,豆包大模型家族在多模态理解和生成能力、Agent 能力上,已位于全球第一梯队。

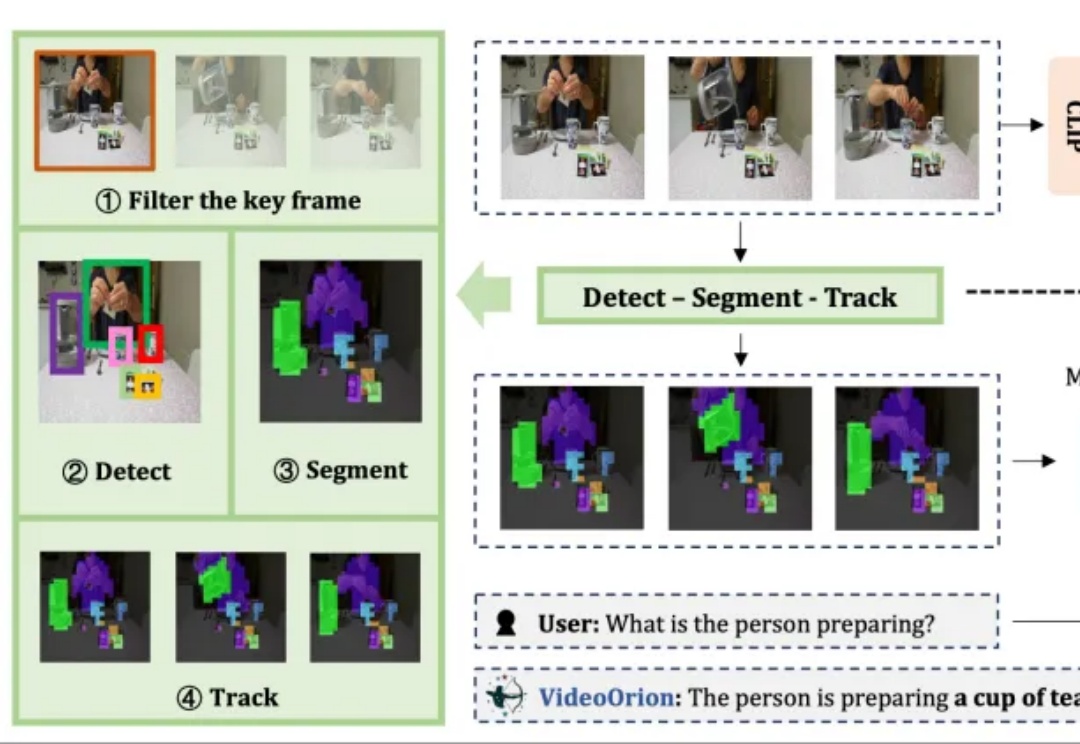

被顶会ICCV 2025以554高分接收的视频理解框架来了!

最新进展,Cursor 2.0正式发布,并且首次搭载了「内部」大模型。 没错,不是GPT、不是Claude,如今模型栏多了个新名字——Composer。实力相当炸裂:据官方说法,Composer仅需30秒就能完成复杂任务,比同行快400%

魔幻啊魔幻。 全球顶级咨询公司麦肯锡,居然收到了OpenAI最近给Tokens消耗大客户颁发的奖牌。 麦肯锡自己还怪自豪的,第一时间就把奖牌po到了领英上。

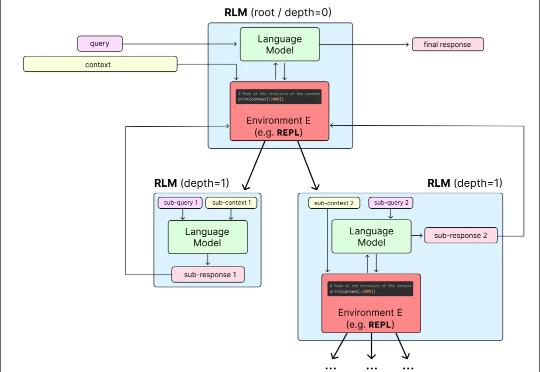

目前,所有主流 LLM 都有一个固定的上下文窗口(如 200k, 1M tokens)。一旦输入超过这个限制,模型就无法处理。 即使在窗口内,当上下文变得非常长时,模型的性能也会急剧下降,这种现象被称为「上下文腐烂」(Context Rot):模型会「忘记」开头的信息,或者整体推理能力下降。

1.3千万亿,一个令人咂舌的数字。这就是谷歌每月处理的Tokens用量。据谷歌“宣传委员”Logan Kilpatrick透露,这一数据来自谷歌对旗下各平台的内部统计。那么在中文世界里,1.3千万亿Tokens约2.17千万亿汉字。换算成对话量,一本《红楼梦》的字数在70-80万左右,相当于一个月内所有人和谷歌AI聊了近30亿本《红楼梦》的内容。

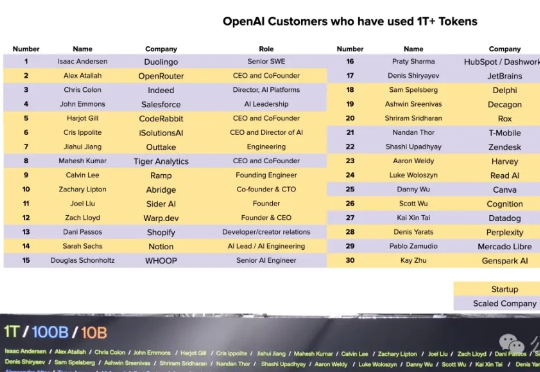

什么AI应用公司和方向是OpenAI看好的?这不,OpenAI公布了30家Tokens消耗破万亿的“大金主”。榜单按每家公司接入OpenAI API挂名人的姓氏排序,排名不分先后,初创公司多数由联合创始人亲自挂名,而大型企业则由专门的AI部门负责人负责对接。

正所谓“得数据者得天下”,这家央企算是把高质量数据集给玩明白了——超过10万亿tokens的通用大模型语料数据,以及覆盖14个关键行业的专业数据集,总存储量高达350TB!