Claude烧钱,Cline更烧钱,但聪明的开发者都在抢着用 | Cline 博客分享

Claude烧钱,Cline更烧钱,但聪明的开发者都在抢着用 | Cline 博客分享这两天读到开源的代码 Agent,Cline 团队的一篇博客,《Why Cline Doesn't Index Your Codebase (And Why That's a Good Thing) 》,做了一些整理和探索,来分享一下这篇博客内容。

这两天读到开源的代码 Agent,Cline 团队的一篇博客,《Why Cline Doesn't Index Your Codebase (And Why That's a Good Thing) 》,做了一些整理和探索,来分享一下这篇博客内容。

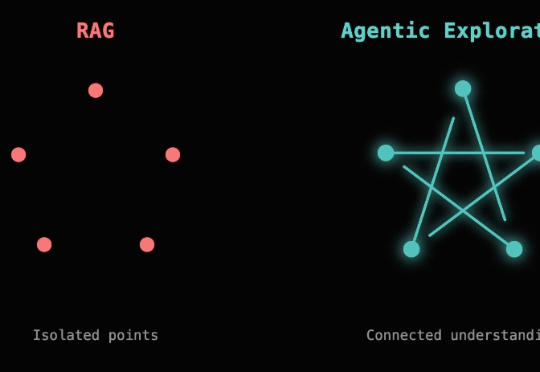

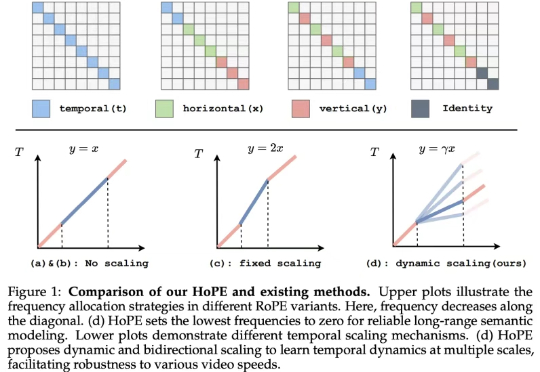

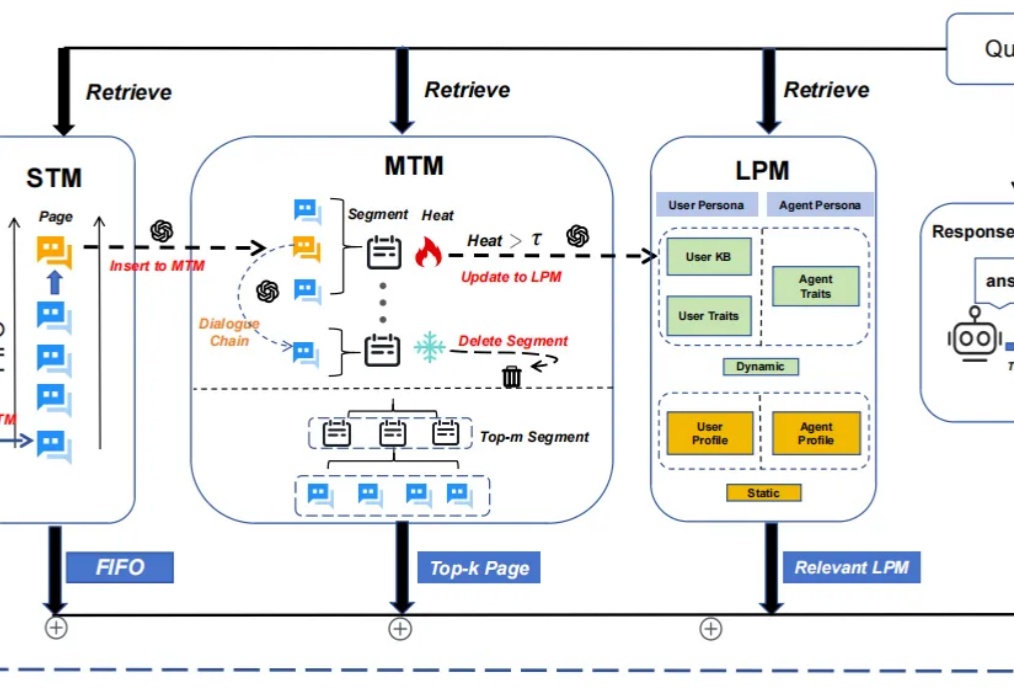

如今的视觉语言模型 (VLM, Vision Language Models) 已经在视觉问答、图像描述等多模态任务上取得了卓越的表现。然而,它们在长视频理解和检索等长上下文任务中仍表现不佳。

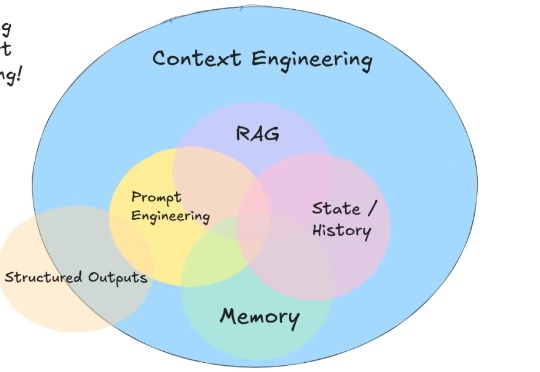

这几天 AI 圈子有个非常有必要也非常热的讨论就是提示工程是不是应该被称为“上下文工程”更加适合。

![Black Forest震撼开源FLUX.1 Kontext [dev]:媲美GPT-4o的图像编辑](https://www.aitntnews.com/pictures/2025/6/27/49d75709-5310-11f0-82be-fa163e47d677.jpg)

前段时间,沉寂了很久的Flux官方团队Black Forest Labs发布了新模型:FLUX.1 Kontext,这是一套支持生成与编辑图像的流匹配(flow matching)模型。FLUX.1 Kontext不仅支持文生图,还实现了上下文图像生成功能,可以同时使用文本和图像作为提示词,并能无缝提取修改视觉元素,生成全新且协调一致的画面。

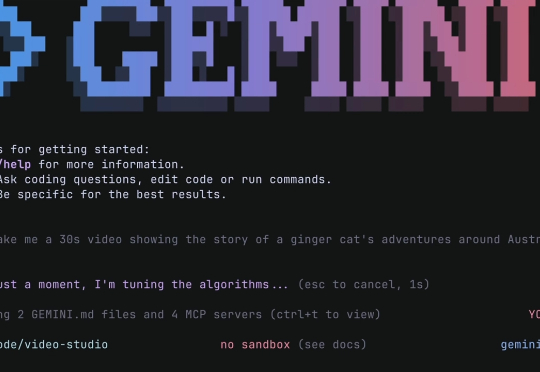

开源且免费!谷歌对编程Agent出手了。

刚刚谷歌推出了 Gemini CLI,一个开源的 AI Agent,把 Gemini 的能力直接带到你的终端里。可以把它看作是谷歌版的 Claude Code。最香的是,这玩意儿开源、免费用,背后是带百万上下文的最强 Gemini 模型。

AI 时代,你可能听说过提示词工程、RAG、记忆等术语。但是很少有人提及上下文工程(context engineering)。

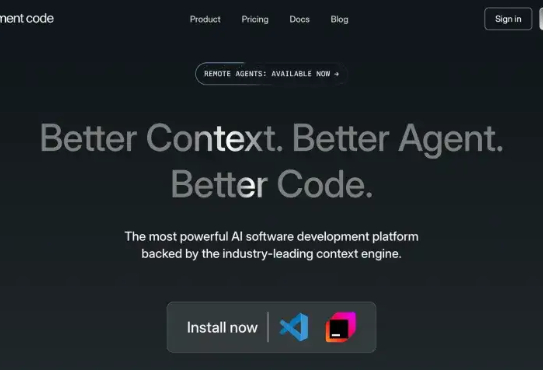

大家好,我是袋鼠帝 最近我发现好几个AI交流群炸锅了 起因是一款AI编程工具,大家聊得热火朝天。这款AI编程工具叫:Augment Code,它的slogen是更好的上下文、更好的Agent、更好的代码

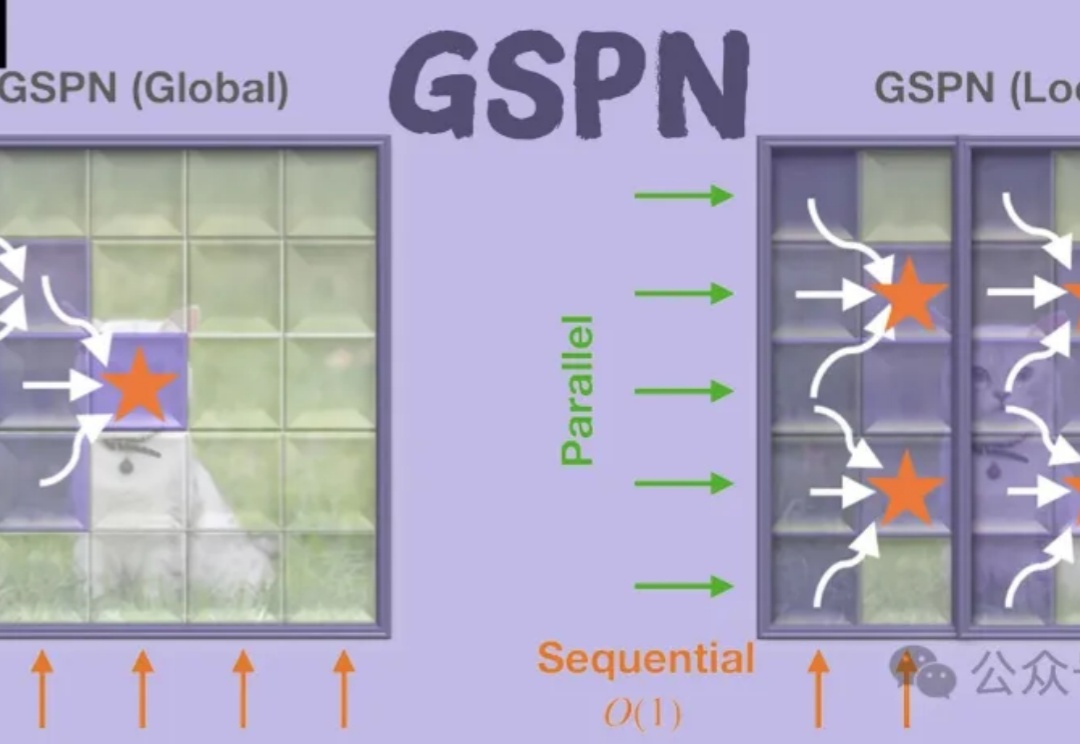

GSPN是一种新型视觉注意力机制,通过线性扫描和稳定性-上下文条件,高效处理图像空间结构,显著降低计算复杂度。通过线性扫描方法建立像素间的密集连接,并利用稳定性-上下文条件确保稳定的长距离上下文传播,将计算复杂度显著降低至√N量级。

随着大模型应用场景的不断拓展,其在处理长期对话时逐渐暴露出的记忆局限性日益凸显,主要表现为固定长度上下文窗口导致的“健忘”问题。