北航提出代码大模型的 Scaling Laws:编程语言差异与多语言最优配比策略

北航提出代码大模型的 Scaling Laws:编程语言差异与多语言最优配比策略在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

在代码大模型(Code LLMs)的预训练中,行业内长期存在一种惯性思维,即把所有编程语言的代码都视为同质化的文本数据,主要关注数据总量的堆叠。然而,现代软件开发本质上是多语言混合的,不同语言的语法特性、语料规模和应用场景差异巨大。

周五凌晨,OpenAI 发布 GPT-5.2-Codex,这是迄今为止最先进的智能体编码模型,专为复杂的实际软件工程而设计。GPT-5.2-Codex 是 GPT-5.2 的升级版本,提高了指令遵循能力、对长远语境的理解能力,它针对 Codex 中的智能体编码进行了进一步优化,包括通过上下文压缩改进长期工作。

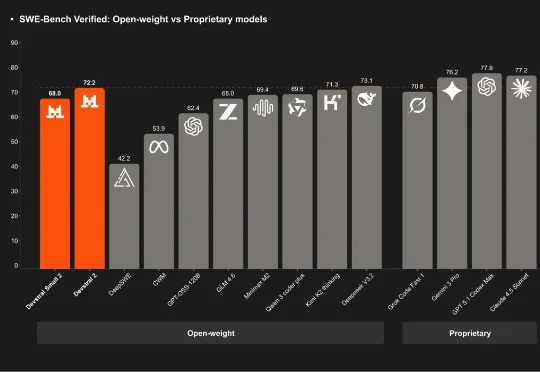

刚刚,「欧洲的 DeepSeek」Mistral AI 再次开源,发布了其下一代代码模型系列:Devstral 2。该系列开源模型包含两个尺寸:Devstral 2 (123B) 和 Devstral Small 2 (24B)。用户目前也可通过官方的 API 免费使用它们。

这篇论文由北京航空航天大学、阿里巴巴、字节跳动、上海人工智能实验室等几十家顶尖机构联合撰写,全文长达303页,是对当前“代码大模型(Code LLMs)”领域最详尽的百科全书式指南。

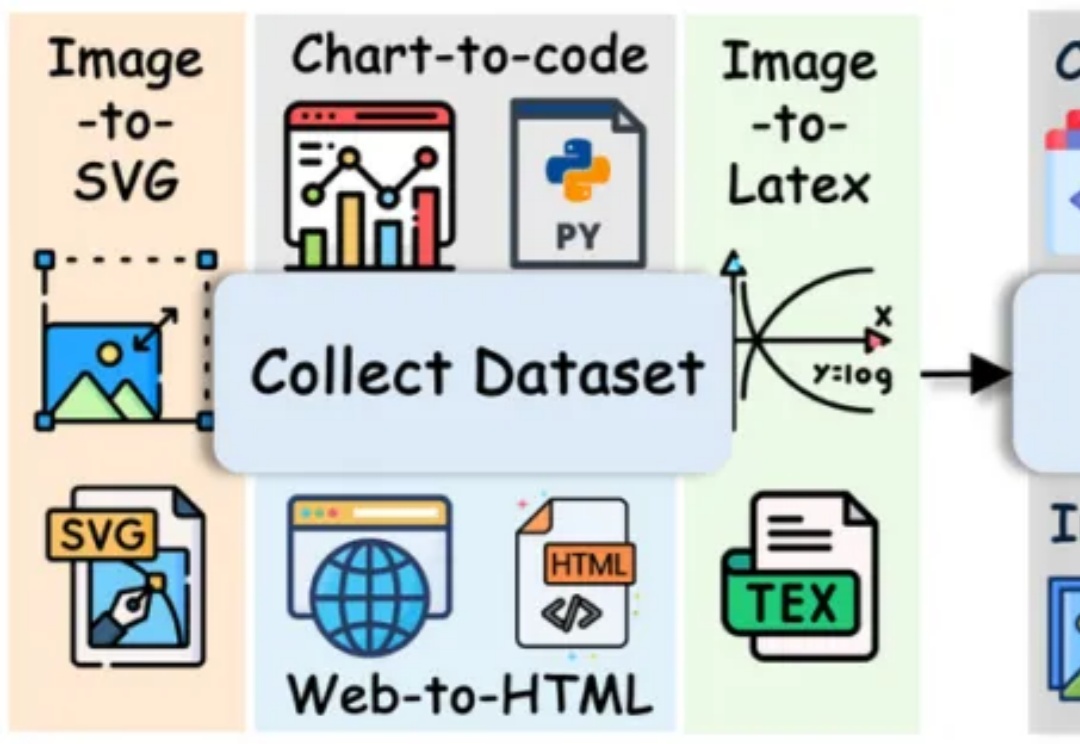

长期以来,多模态代码生成(Multimodal Code Generation)的训练严重依赖于特定任务的监督微调(SFT)。尽管这种范式在 Chart-to-code 等单一任务上取得了显著成功 ,但其 “狭隘的训练范围” 从根本上限制了模型的泛化能力,阻碍了通用视觉代码智能(Generalized VIsioN Code Intelligence)的发展 。

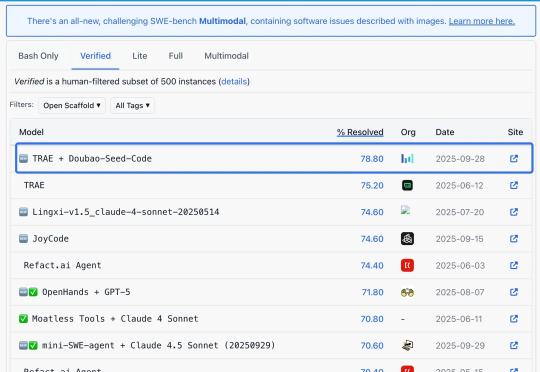

编程模型最新卷王来了。就在今天,火山引擎推出了面向Agentic编程任务深度优化的全新代码模型Doubao-Seed-Code。价格,调用价格国内最低,火山引擎还配套推出9块9套餐,一杯咖啡钱,就能搞定各种摸鱼小游戏——比如办公室躲老板(doge)。

以前,每当上线一个新模型,大家总要绞尽脑汁想个响亮又不撞车的名字。 不得不说,有时候名字起得太出彩,甚至能把模型本身给卷下去。别人还没搞懂它能干嘛,名字已经在朋友圈刷屏了。

速度比 GPT-5 快三倍,便宜六倍。 本周四,马斯克的 xAI 正式推出了旗下的最新代码模型 Grok Code Fast 1。

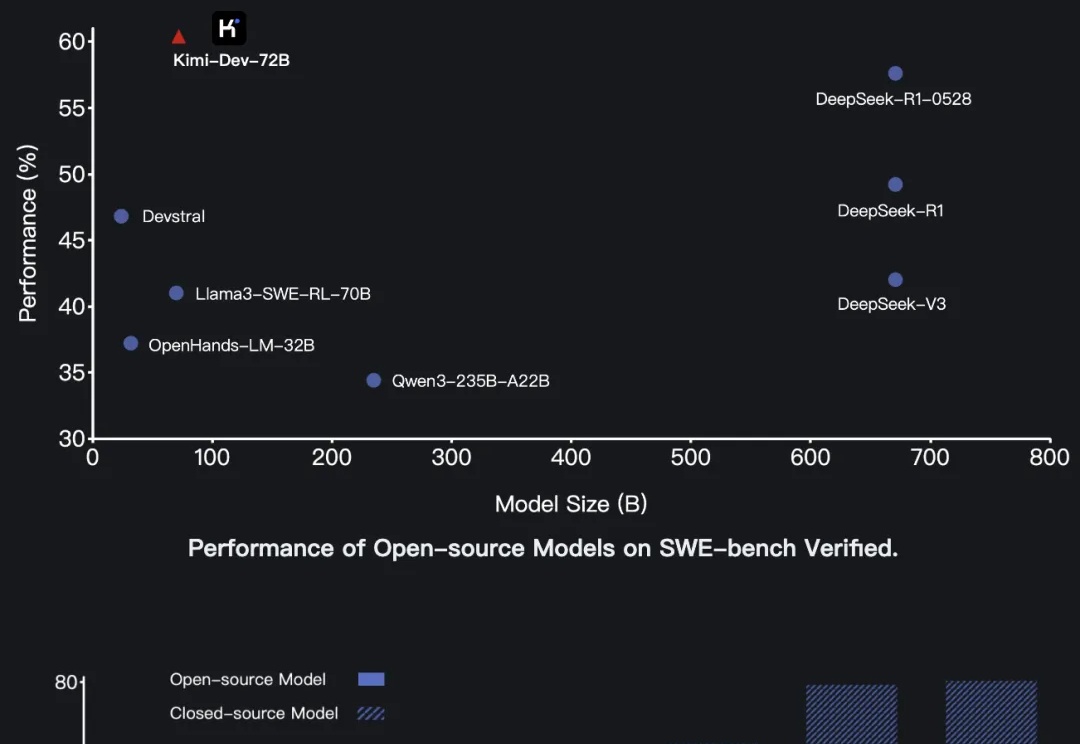

昨天深夜,月之暗面发布了开源代码模型Kimi-Dev-72B。这个模型在软件工程任务基准测试SWE-bench Verified上取得了60.4%的成绩,创下开源模型新纪录,超越了包括DeepSeek在内的多个竞争对手。

深夜,沉寂已久的Kimi突然发布了新模型—— 开源代码模型Kimi-Dev,在SWE-bench Verified上以60.4%的成绩取得开源SOTA。