中国团队引领太空算力:首次太空在轨部署通用大模型,发2800颗卫星服务数亿硅基智能体

中国团队引领太空算力:首次太空在轨部署通用大模型,发2800颗卫星服务数亿硅基智能体岁末年初,全球AI竞争聚焦到了最新趋势—— 太空算力。

岁末年初,全球AI竞争聚焦到了最新趋势—— 太空算力。

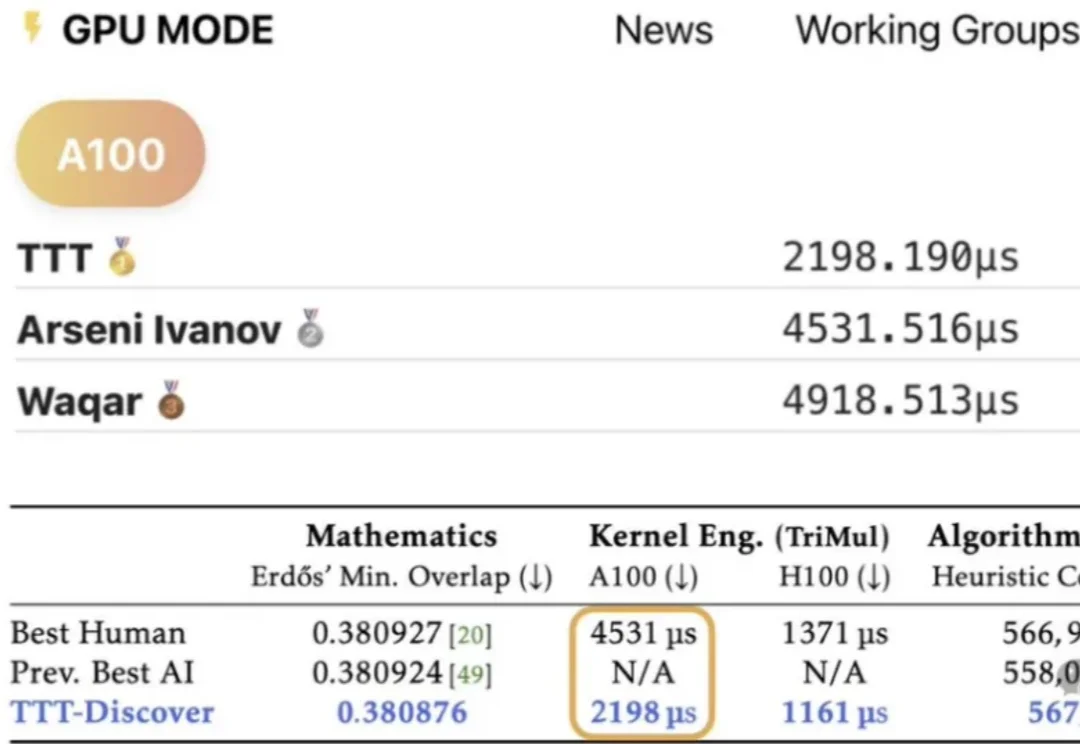

在 AI 浪潮席卷全球的今天,大模型在写诗、作画、敲代码上已经展现出惊人的天赋。然而,在面对严谨、硬核的物质科学(物理、化学、材料)时,却常常表现得像个“偏科生”:它们能侃侃而谈化学理论,却在最基础的分子式、晶体结构书写和反应推理上频繁出现不稳定输出:说的像那么回事,写出来却漏洞百出。

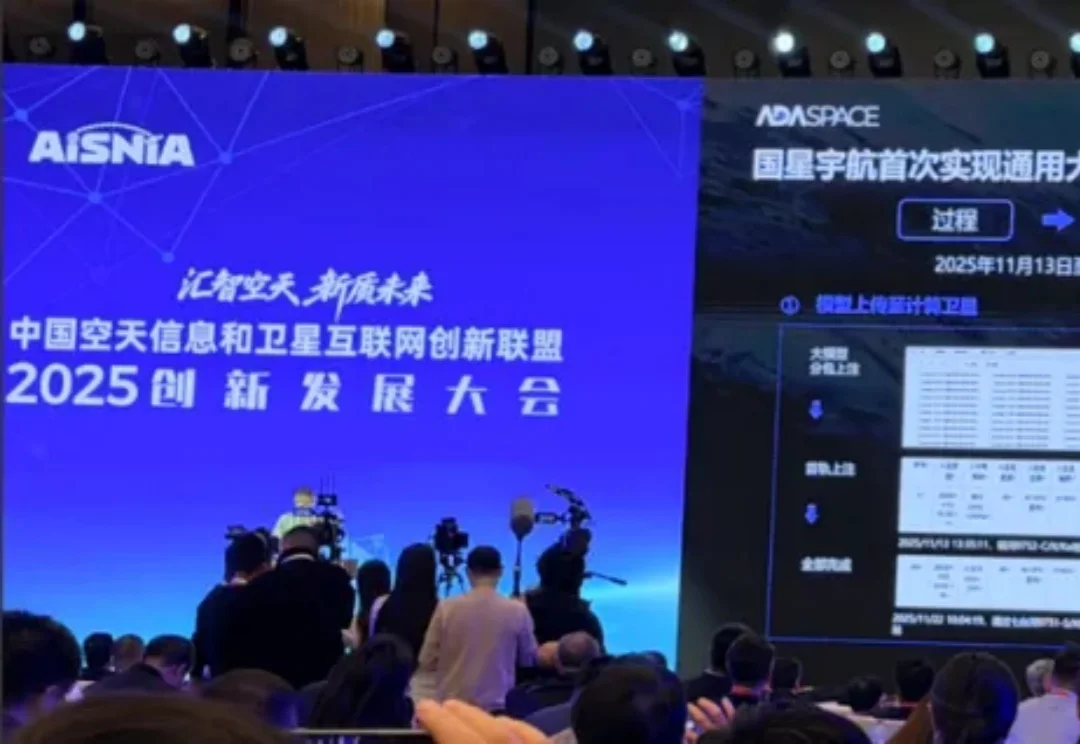

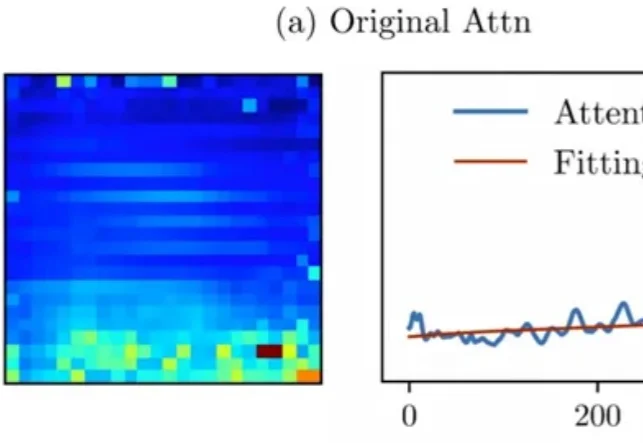

过去几年,机制可解释性(Mechanistic Interpretability)让研究者得以在 Transformer 这一 “黑盒” 里追踪信息如何流动、表征如何形成:从单个神经元到注意力头,再到跨层电路。但在很多场景里,研究者真正关心的不只是 “模型为什么这么答”,还包括 “能不能更稳、更准、更省,更安全”。

过去一年,AI的主战场几乎被大模型、生图和生视频占满。2026年伊始,市场终于开始把目光投向一个更难、也更关键的领域:3D生成。

大模型能写代码、聊八卦,但敢不敢让它直接接管网络运维?一项最新评测显示,面对真实网络故障,头部模型平均准确率竟不足50%!为此,GSMA联手全球巨头开启「地狱级」难度挑战赛,通往MWC 2026的门票已备好,3.5万欧元大奖等你来拿!

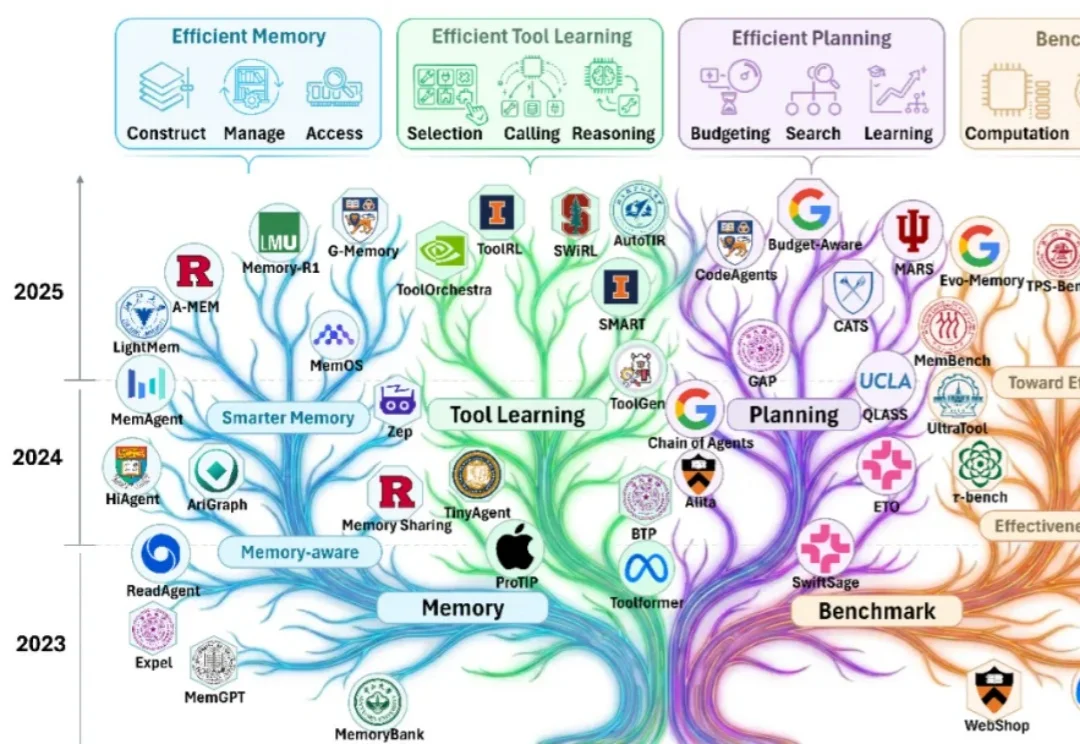

随着大模型能力的跃迁,业界关注点正在从 “模型能不能做” 快速转向 “智能体能不能落地”。过去一年可以看到大量工作在提升智能体的有效性(effectiveness):如何让它更聪明、更稳、更会用工具、更能完成复杂任务。

Attention真的可靠吗?

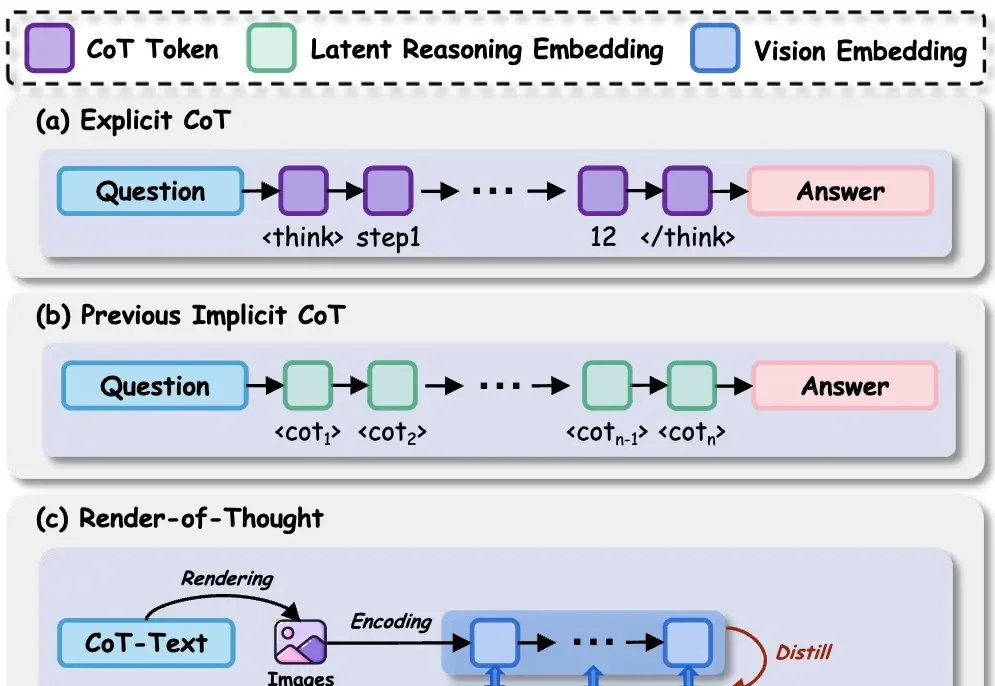

在 LLM 时代,思维链( CoT)已成为解锁模型复杂推理能力的关键钥匙。然而,CoT 的冗长问题一直困扰着研究者——中间推理步骤和解码操作带来了巨大的计算开销和显存占用,严重制约了模型的推理效率。

大模型持续学习,又有新进展!

用多样化的任务与公开透明的机制,堵上具身大模型刷榜的捷径。