机器人ChatGPT时刻将至:全球首个具身智能数据工厂诞生!

机器人ChatGPT时刻将至:全球首个具身智能数据工厂诞生!过去一整年,具身智能成了 AI 行业里最被反复提及、却最难真正落地的方向。一边是人形机器人发布会密集登场,另一边却始终缺乏可规模部署的现实成果。算法在进步,算力在堆叠,但问题始终没有改变:机器人到底该如何被教会在真实世界中行动。

过去一整年,具身智能成了 AI 行业里最被反复提及、却最难真正落地的方向。一边是人形机器人发布会密集登场,另一边却始终缺乏可规模部署的现实成果。算法在进步,算力在堆叠,但问题始终没有改变:机器人到底该如何被教会在真实世界中行动。

在长期以来的 AI 研究版图中,具身智能虽然在机器人操作、自动化系统与现实应用中至关重要,却常被视为「系统工程驱动」的研究方向,鲜少被认为能够在 AI 核心建模范式上产生决定性影响。

提供软件支撑OpenAI 等公司语音、视频及实体 AI 模型的初创企业 LiveKit,在一轮融资中筹集了 1 亿美元,公司估值达 10 亿美元。LiveKit 的软件和网络运行着利用语音、视频以及所谓物理 AI(应用于机器人技术等任务)的人工智能模型。

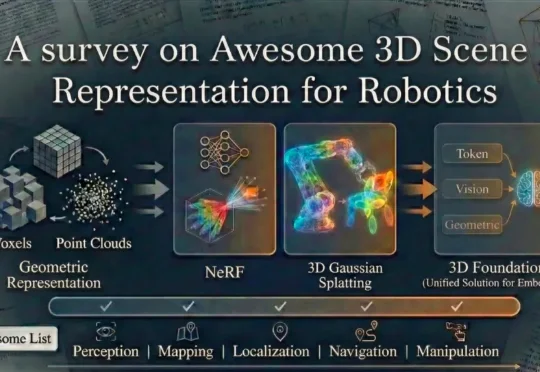

上海交通大学、波恩大学等院校的研究团队全面总结了当前机器人技术中常用的场景表示方法。这些方法包括传统的点云、体素栅格、符号距离函数以及场景图等传统几何表示方式,同时也涵盖了最新的神经网络表示技术,如神经辐射场、3D 高斯散布模型以及新兴的 3D 基础模型。

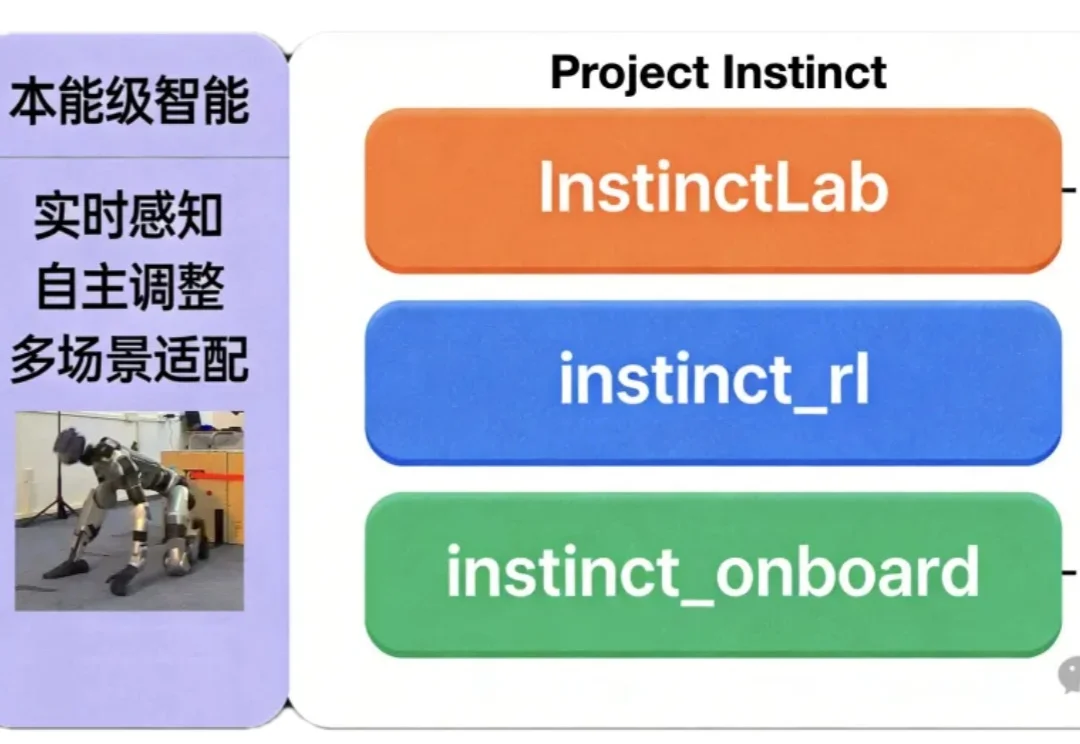

如何让机器人同时具备“本能反应”与复杂运动能力?

《晚点 Auto》独家获悉,激光雷达供应商禾赛科技联合创始人及 CTO 向少卿和 CEO 李一帆、首席科学家孙恺在 2024 年底创立了一家机器人公司 Sharpa,主要开发通用机器人及核心部件。

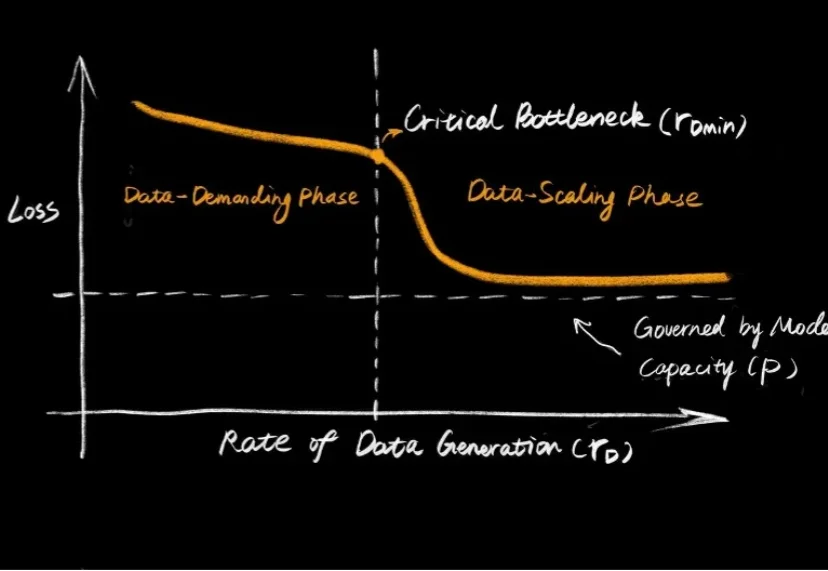

大语言模型的爆发,让大家见证了 Scaling Law 的威力:只要数据够多、算力够猛,智能似乎就会自动涌现。但在机器人领域,这个公式似乎失效了。

最新综述首次系统探讨LLM控制机器人的安全威胁、防御机制与未来挑战,指出LLM的具身鸿沟导致其在物理空间可能执行危险动作,而现有防御体系存在逻辑与物理脱节等问题。

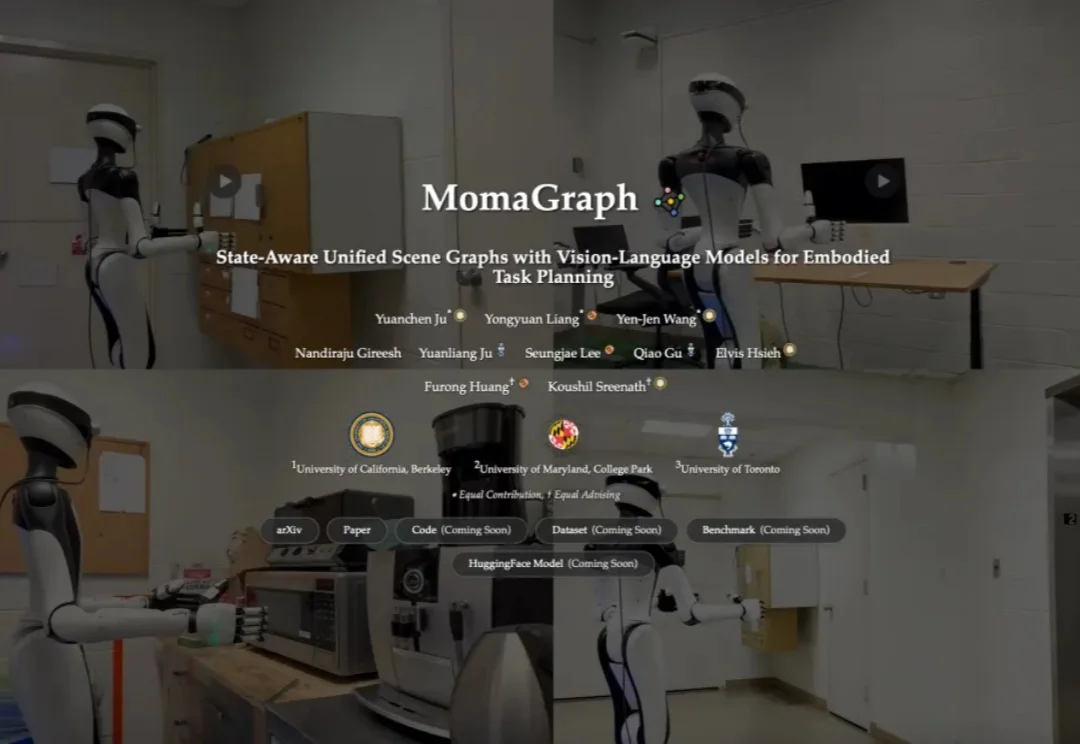

想象这样一个日常画面:你吩咐家用机器人「烧壶开水」,它却当场卡壳——水壶在哪?该接自来水还是过滤水?先插电还是先按开关?水开了又该如何判断?这些对人类而言像呼吸一样自然的家务,对过去的机器人却是大大的难题:要么忘了插电,要么找不到水壶,甚至会把柜门把手错当成开关一通乱按。

就在刚刚,人形机器人赛道投下了一颗“开源炸弹”。