悬赏5000刀!148局AI斗蛐蛐世界杯官方战报出炉,全球赛邀你接棒来战

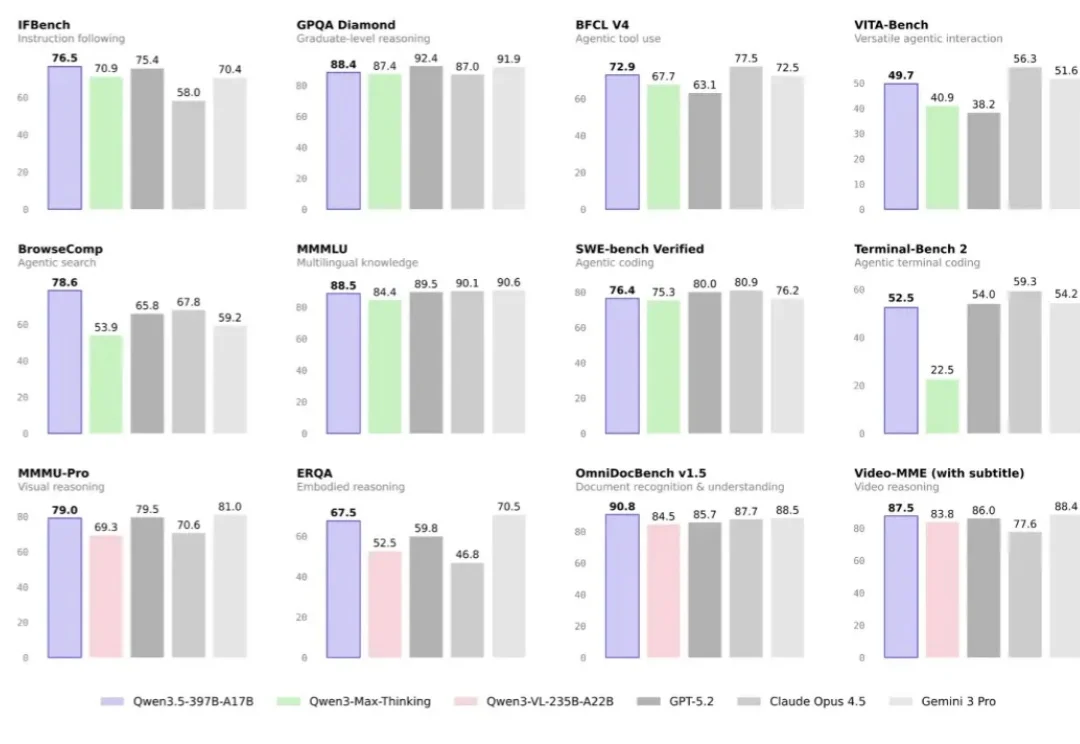

悬赏5000刀!148局AI斗蛐蛐世界杯官方战报出炉,全球赛邀你接棒来战你是不是也在思考这个问题: AI大模型之间的真实差距,真的像各种榜单上表现得那样直观吗?

你是不是也在思考这个问题: AI大模型之间的真实差距,真的像各种榜单上表现得那样直观吗?

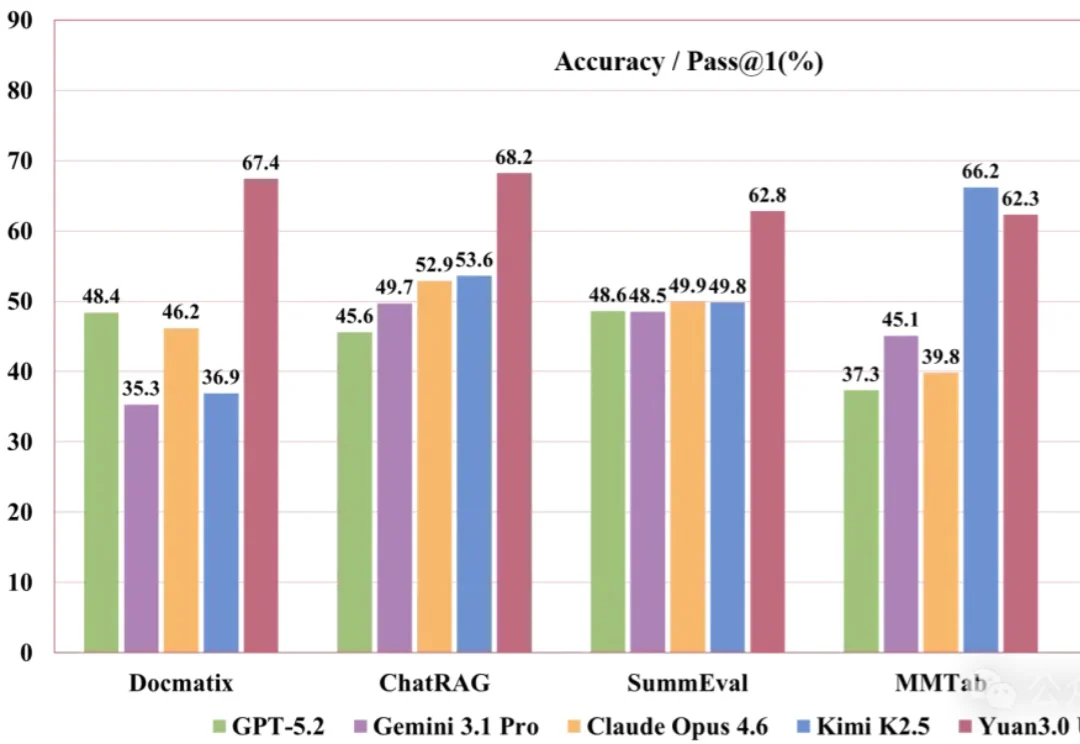

刚刚,YuanLab.ai团队正式开源发布源Yuan3.0 Ultra多模态基础大模型。

昨天,Thinking Maching Lab 研究者、斯坦福大学博士生 Zitong Yang 正式完成了他的博士论文答辩,课题为「持续自我提升式 AI」(Continually self-improving AI),并且他在答辩完成后很快就放出了自己的答辩视频,从中我们可以看到他对未来 AI 发展路径的系统性探索。

最近关于Qwen3.5还有其幕后团队,市场上的讨论沸沸扬扬,但今天我们不聊八卦,主要讲讲干货。

AI 搜索引擎正逐渐取代传统搜索入口,「问 AI」已经成为日常习惯。随着 OpenAI 宣布在 ChatGPT 中引入商业推荐,搜索与内容分发的边界正在被重新定义。在这样的环境下,你的内容能否在 AI 搜索中成为「爆款」,不再只取决于标题和流量,而是更大程度取决于 AI 本身的引用偏好。

离职的消息最沸沸扬扬的时候,Qwen 团队的核心负责人林俊旸在朋友圈发了两句话:

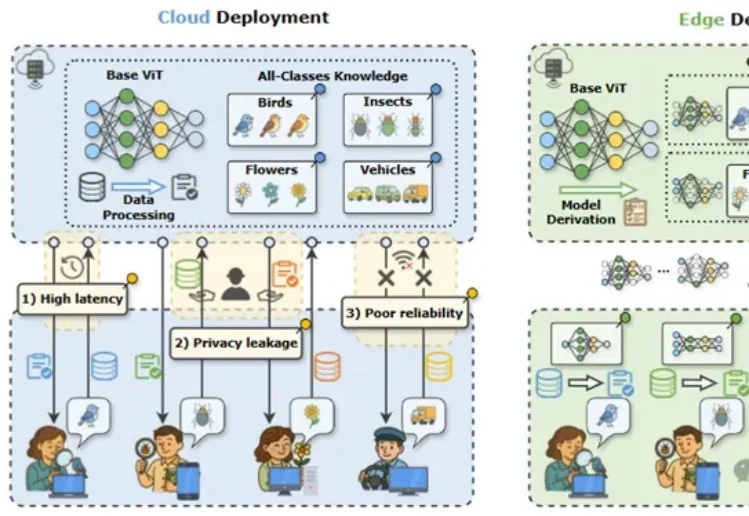

近年来,视觉大模型在自动驾驶、智慧医疗等场景中得到广泛应用,但在真实业务环境中,“大而全”的通用模型往往并不是最优选择。

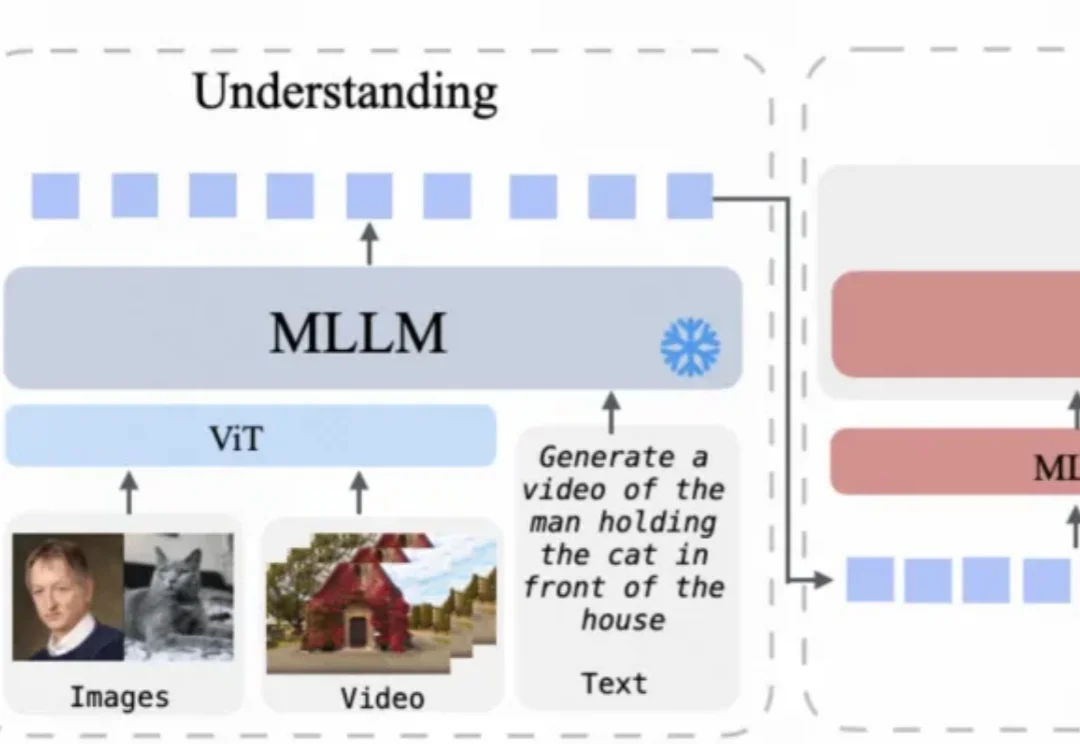

统一多模态模型在多模态内容理解与生成方面已展现出良好效果,但目前仍主要局限于图像领域。

资本正在加速押注具身智能的下一阶段。

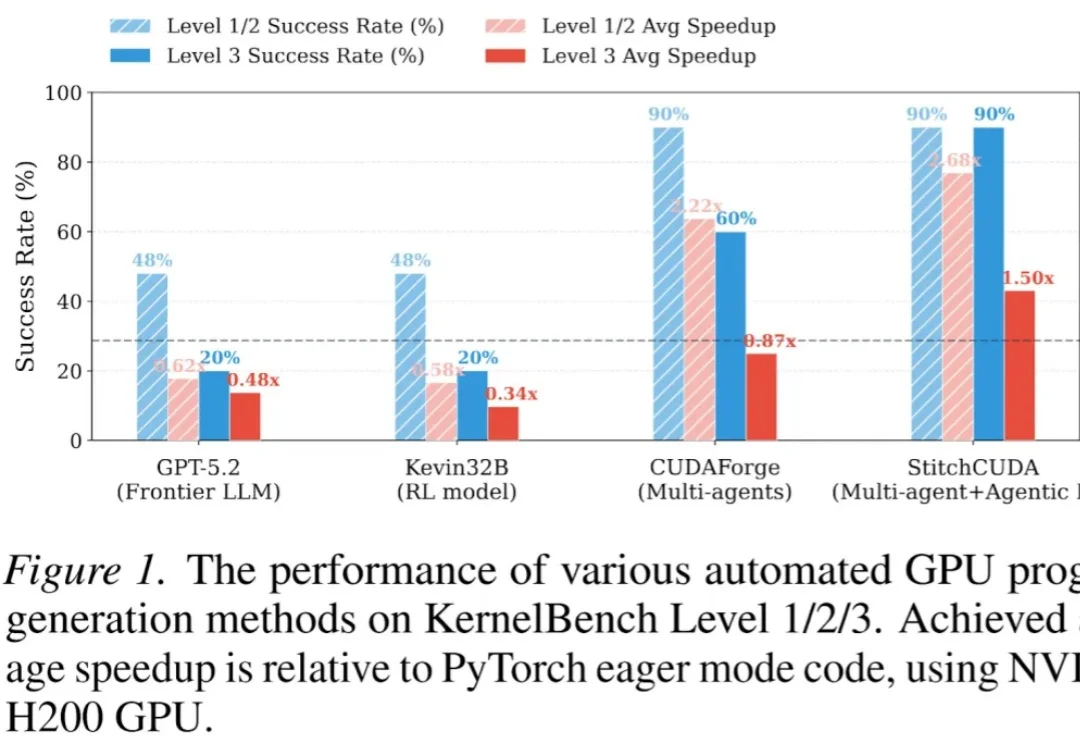

现有的 LLM 自动化 CUDA 方法大多只能优化单个 Kernel,面对完整的端到端 GPU 程序(如整个 VisionTransformer 推理)往往束手无策。