国产AI拿下国际物理奥赛金牌,13项顶级竞赛豪取12金1银,划重点:开源

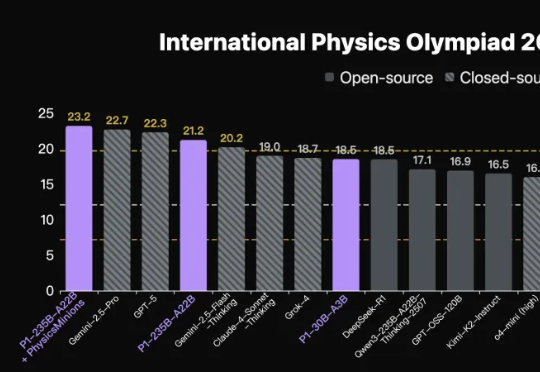

国产AI拿下国际物理奥赛金牌,13项顶级竞赛豪取12金1银,划重点:开源首个拿下国际物理奥林匹克竞赛IPhO 2025理论考试金牌的开源模型,出自国产。上海人工智能实验室团队推出新模型家族,代号P1。在IPhO 2025理论考试中,P1-235B-A22B取得21.2/30分,成为首个达到该金牌线的开源模型,仅次于Gemini-2.5-Pro与GPT-5。

首个拿下国际物理奥林匹克竞赛IPhO 2025理论考试金牌的开源模型,出自国产。上海人工智能实验室团队推出新模型家族,代号P1。在IPhO 2025理论考试中,P1-235B-A22B取得21.2/30分,成为首个达到该金牌线的开源模型,仅次于Gemini-2.5-Pro与GPT-5。

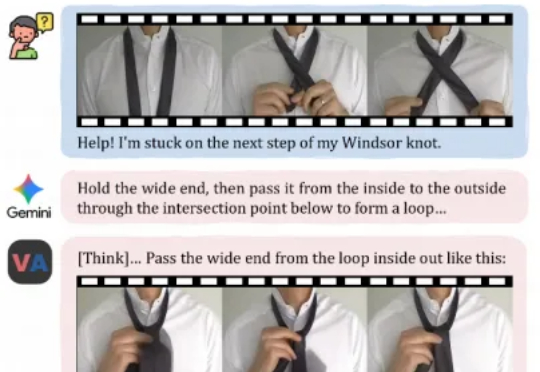

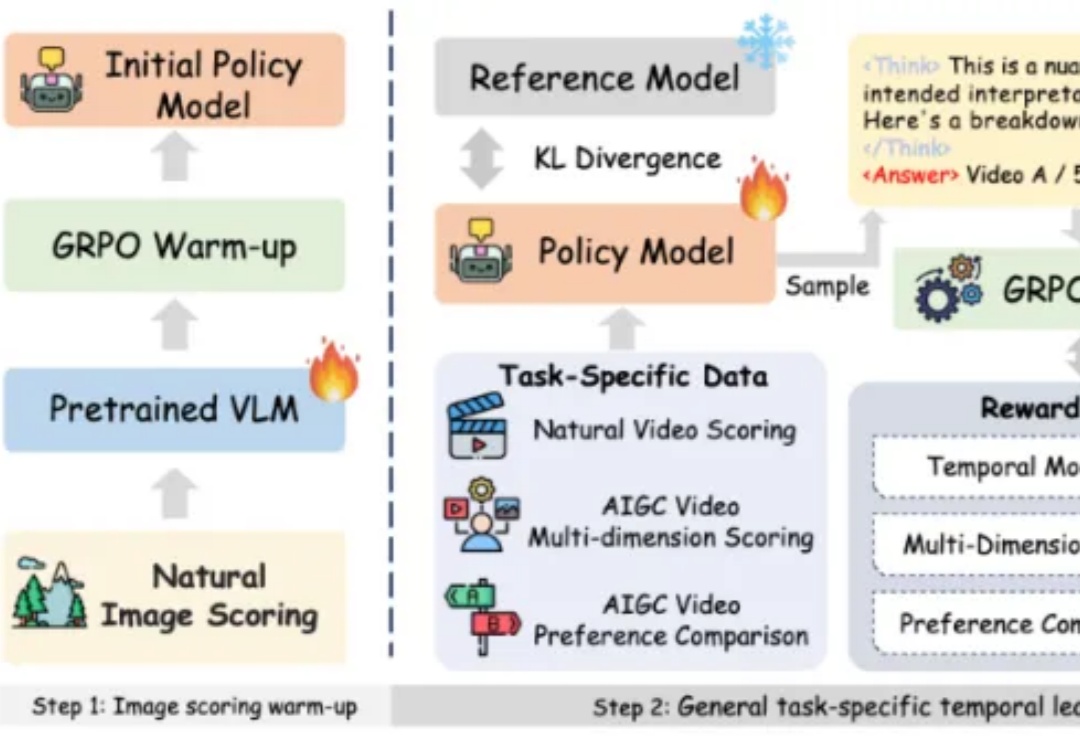

今天,来自快手可灵团队和香港城市大学的研究者们,正在尝试打破这一界限。他们提出了一个全新的任务范式——「视频作为答案」,并发布了相应模型VANS。而这项工作则开创性地提出了Video-Next Event Prediction任务,要求模型直接生成一段动态视频作为回答。

就在一周前,全宇宙最火爆的推理框架 SGLang 官宣支持了 Diffusion 模型,好评如潮。团队成员将原本在大语言模型推理中表现突出的高性能调度与内核优化,扩展到图像与视频扩散模型上,相较于先前的视频和图像生成框架,速度提升最高可达 57%:

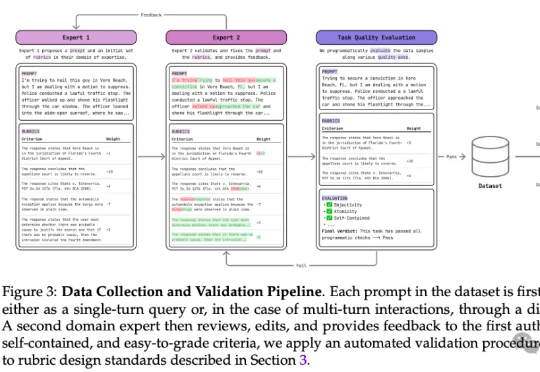

最新PRBench基准可以测试AI在金融和法律领域的表现。结果显示,即使是顶尖大模型在处理复杂任务时也表现不佳,尤其在涉及重大经济后果的任务中。PRBench通过模拟真实场景和多轮对话,揭示了AI在专业领域的不足,强调开发更可靠AI系统的重要性。

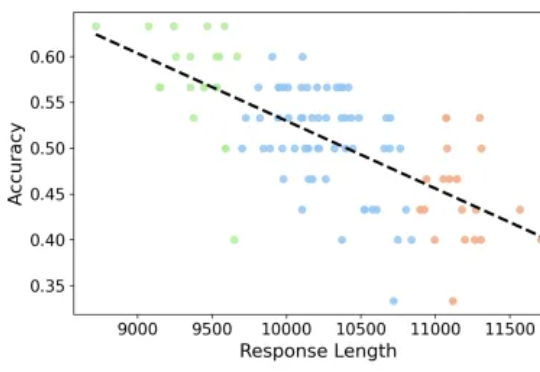

专注推理任务的 Large Reasoning Models 在数学基准上不断取得突破,但也带来了一个重要问题:越想越长、越长越错。本文解读由 JHU、UNC Charlotte 等机构团队的最新工作

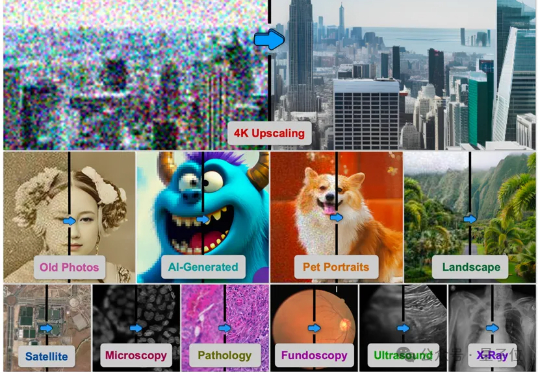

由德克萨斯A&M大学、斯坦福大学、Snap公司、CU Boulder大学、德克萨斯大学奥斯汀分校、加州理工大学、Topaz Labs以及加州大学Merced分校的研究者联合提出的基于AI智能体的方法4KAgent针对不同类型的图像以及需求对图像进行智能修复并放大到4K分辨率,带来优秀的视觉感知效果。该工作已被NeurIPS 2025接收。

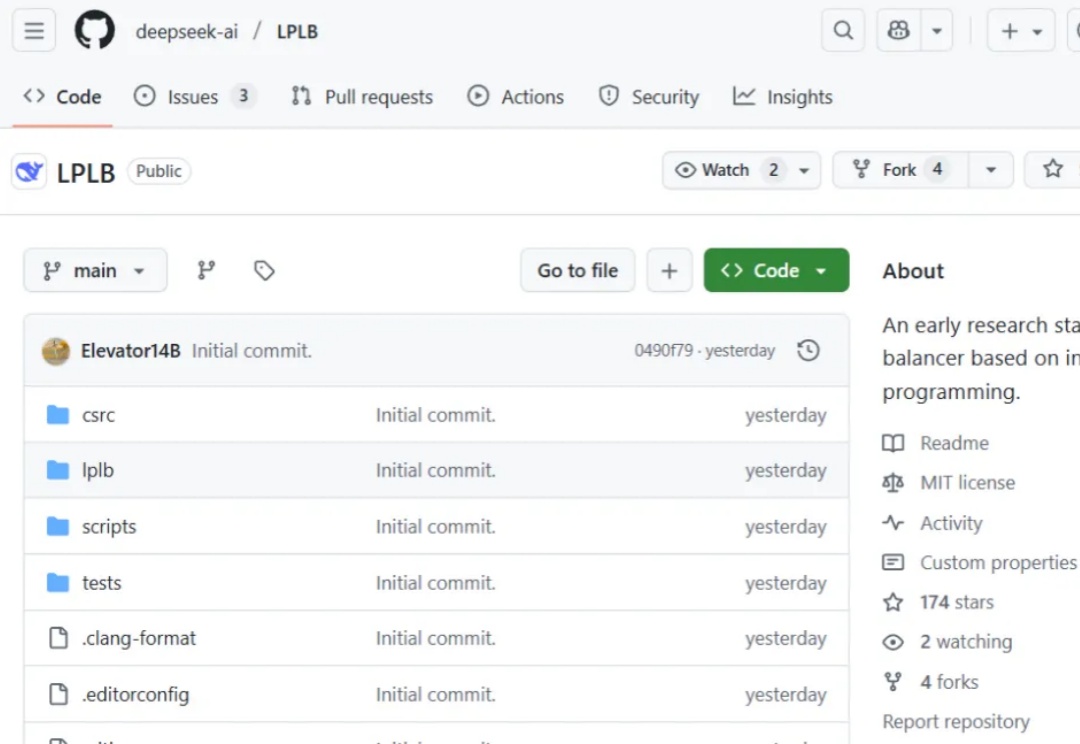

昨天,DeepSeek 在 GitHub 上线了一个新的代码库:LPLB。

近日,AAAI 2026 公布了录用结果,该会议是是人工智能领域极具影响力的国际顶级学术会议之一。据悉本次会议共有 23680 篇投稿进入审稿阶段,最终 4167 篇论文被录用,录取率为 17.6%。

“What is meant often goes far beyond what is said, and that is what makes conversation possible.” ——H. P. Grice

扩散模型「去噪」,是不是反而忘了真正去噪?何恺明携弟子出手,回归本源!