摩尔线程AIBOOK一周实测:开箱即训的「AI Native」体验

摩尔线程AIBOOK一周实测:开箱即训的「AI Native」体验摩尔线程 AI 算力本(MTT AIBOOK)是专为 AI 学习与开发者打造的个人智算平台。它搭载自研智能 SoC 芯片「长江」,提供 50TOPS 异构 AI 算力,支持混合精度计算。运行基于 Linux 内核的 MT AIOS 操作系统,具备多系统兼容能力,并预置完整 AI 开发环境与工具链。

摩尔线程 AI 算力本(MTT AIBOOK)是专为 AI 学习与开发者打造的个人智算平台。它搭载自研智能 SoC 芯片「长江」,提供 50TOPS 异构 AI 算力,支持混合精度计算。运行基于 Linux 内核的 MT AIOS 操作系统,具备多系统兼容能力,并预置完整 AI 开发环境与工具链。

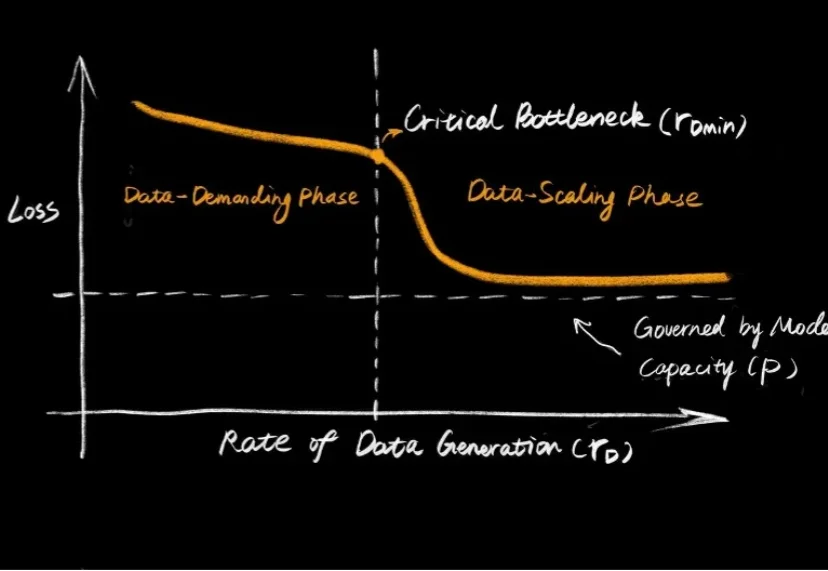

大语言模型的爆发,让大家见证了 Scaling Law 的威力:只要数据够多、算力够猛,智能似乎就会自动涌现。但在机器人领域,这个公式似乎失效了。

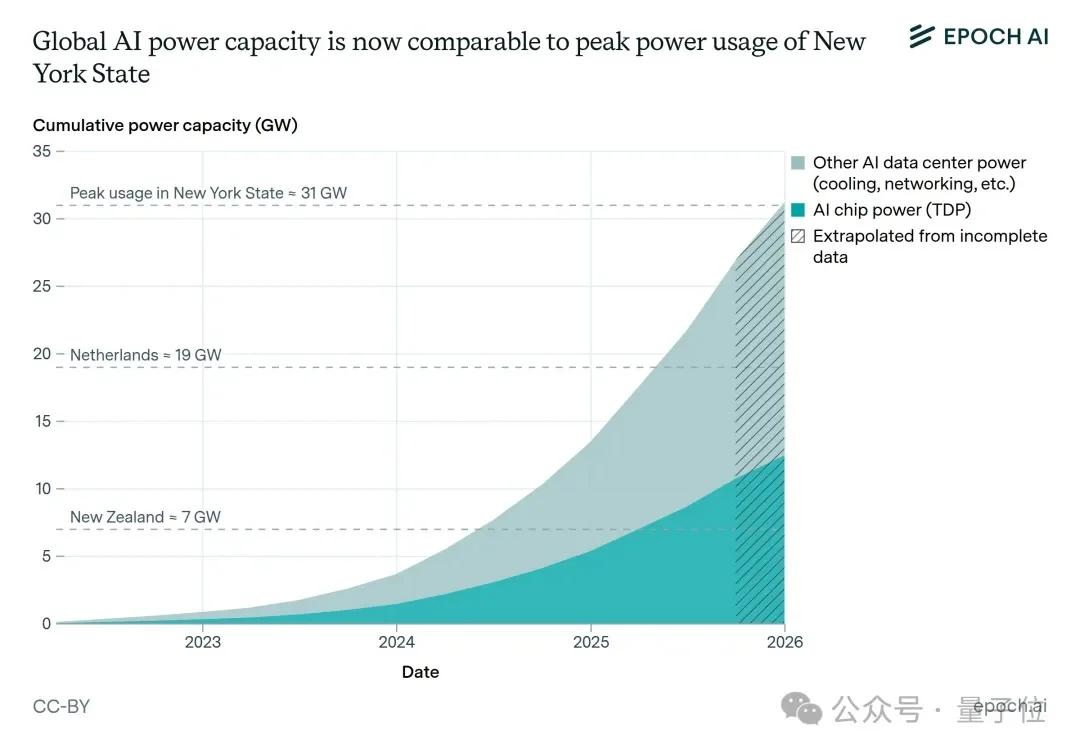

AI时代,电工再次成为香饽饽。

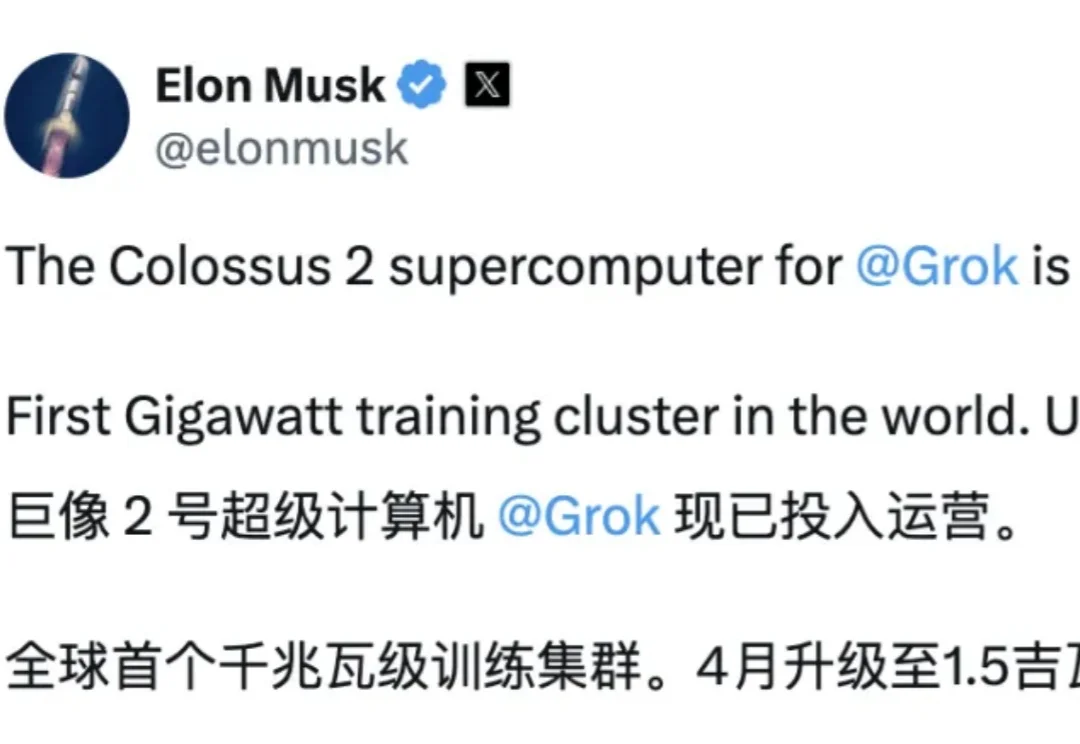

刚刚,全球首个GW级超算集群Colossus 2,正式投入运行。

一早,OpenAI曝光了过去三年营收数据,信息量巨大:2025年ARR突破200亿美元,算力与收入几乎同步飙升,形成了一个强大的自转飞轮。

你以为的AI发展,是人类顶级智慧的结晶。实际上,人类的进化一败涂地,拿到任何科技的第一件事,就是搞黄色。全球性压抑时代全面到来,AI的算力全用来解决性欲了。

刚刚,AI医疗新突破,来自谷歌!这一次,他们直接瞄准了真实临床环境的痛点。为此,谷歌祭出了最新模型MedGemma 1.5,找到了破局答案。相较于此前的MedGemma 1.5,MedGemma 1.5在多模态应用上实现重大突破,融合了:

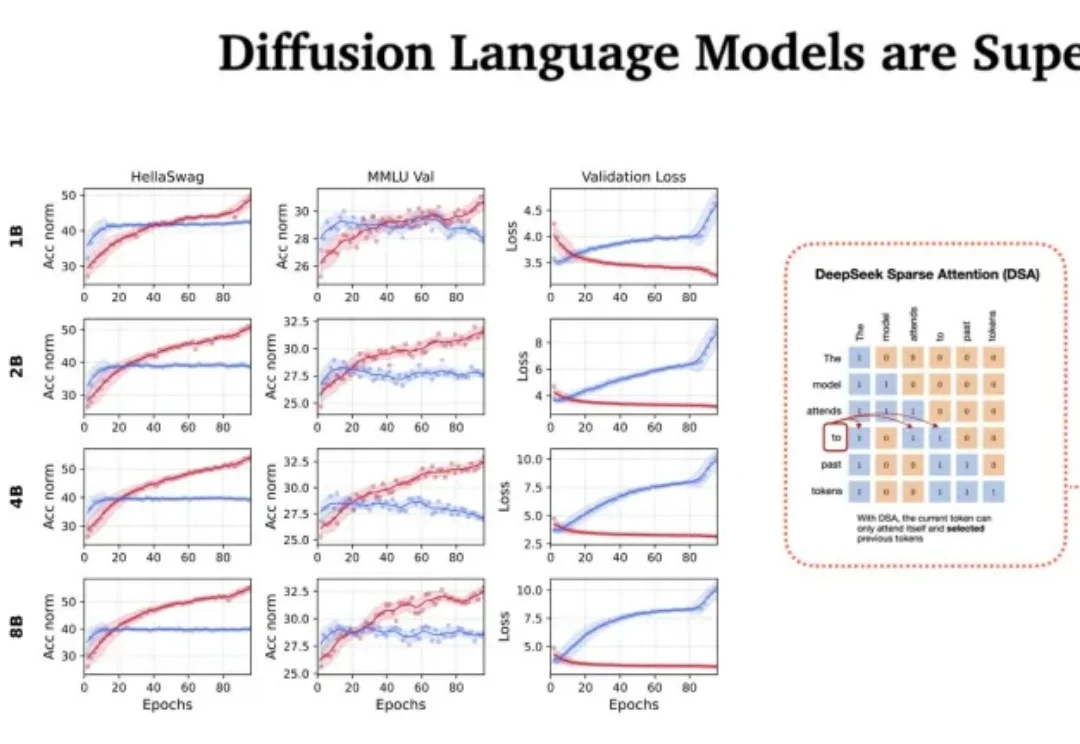

站在 2026 年的开端回望,LLM 的架构之争似乎进入了一个新的微妙阶段。过去几年,Transformer 架构以绝对的统治力横扫了人工智能领域,但随着算力成本的博弈和对推理效率的极致追求,挑战者们从未停止过脚步。

预测到次贷危机的「大空头」Michael Burry看到数万亿美元涌入AI基础设施,产生深深的怀疑。他预言:英伟达的优势并不持久,可能很快就会被对手战胜。而且,如今全球AI算力已经达到1500万H100 GPU当量,即将引爆严重能源危机!

个人开发者对高性能AI算力的需求,正在得到越来越多厂商的正面回应。在年度消费电子大展CES 2026上,桌面AI超算几乎成了所有PC厂商的必答题。连续两年亮相CES的阿里云无影云电脑,则给出云厂商对桌面AI超算的回答:一台面向个人消费者的AI超级计算机——无影AI云超算。