ICCV 2025 | 基于时序增强关系敏感知识迁移的弱监督动态场景图生成

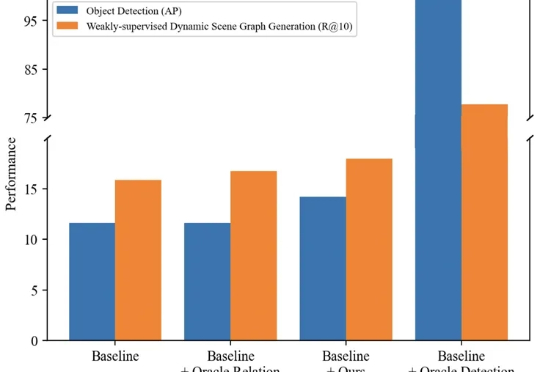

ICCV 2025 | 基于时序增强关系敏感知识迁移的弱监督动态场景图生成本文主要介绍来自该团队的最新论文:TRKT,该任务针对弱监督动态场景图任务展开研究,发现目前的性能瓶颈在场景中目标检测的质量,因为外部预训练的目标检测器在需要考虑关系信息和时序上下文的场景图视频数据上检测结果欠佳。

本文主要介绍来自该团队的最新论文:TRKT,该任务针对弱监督动态场景图任务展开研究,发现目前的性能瓶颈在场景中目标检测的质量,因为外部预训练的目标检测器在需要考虑关系信息和时序上下文的场景图视频数据上检测结果欠佳。

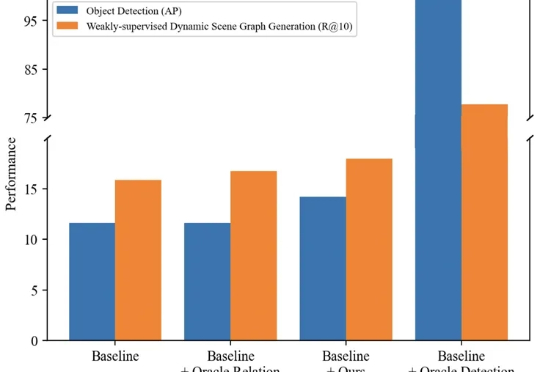

2年之间,美国技术岗换了江湖:裁员潮退去但岗位增量有限,资深职位逆势成主流;AI工程师需求爆表,湾区继续称霸;大厂任期普遍拉长,人才流动更「内循环」。

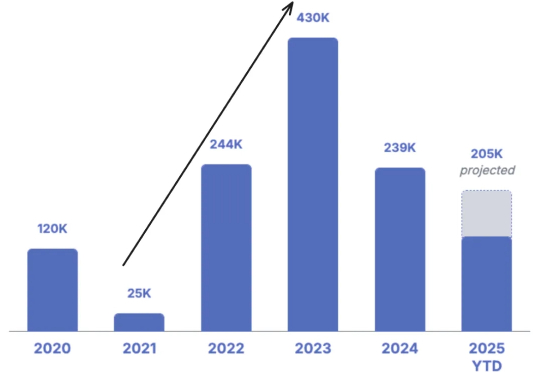

模型也怕猫?你敢信吗?只要在提示词里加一句“猫一生中大部分时间都在睡觉”,原本表现优异的大模型立刻陷入混乱,错题率暴涨 3 倍。这种“猫猫级”废话,竟然成了压垮 AI 理性链条的最后一根稻草。

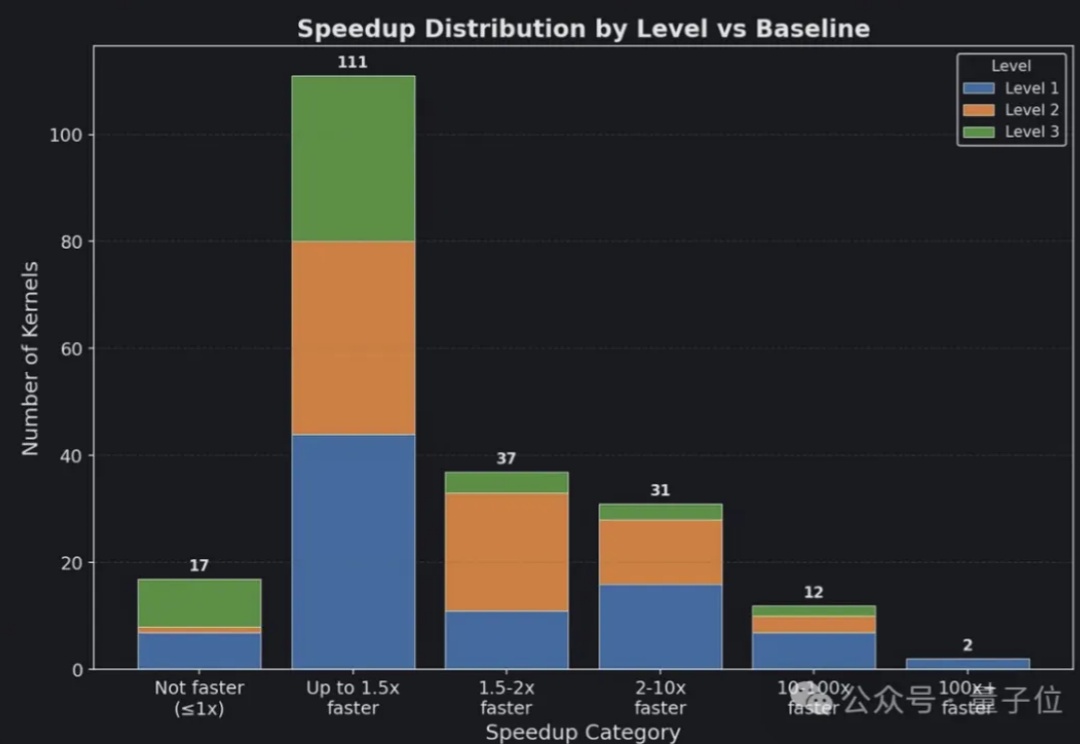

AI自动生成的苹果芯片Metal内核,比官方的还要好?

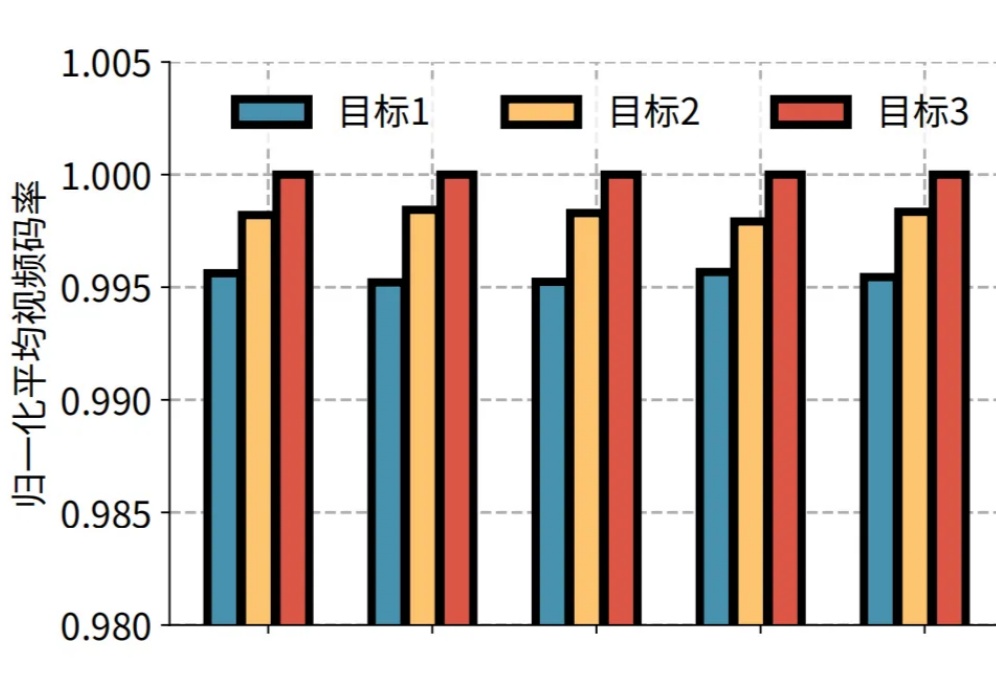

近日,快手与清华大学孙立峰团队联合发表论文《Towards User-level QoE: Large-scale Practice in Personalized Optimization of Adaptive Video Streaming》,被计算机网络领域的国际顶尖学术会议 ACM SIGCOMM 2025 录用。

您对“思维链”(Chain-of-Thought)肯定不陌生,从最早的GPT-o1到后来震惊世界的Deepseek-R1,它通过让模型输出详细的思考步骤,确实解决了许多复杂的推理问题。但您肯定也为它那冗长的输出、高昂的API费用和感人的延迟头疼过,这些在产品落地时都是实实在在的阻碍。

LLM.265研究发现,视频编码器本身就是一种高效的大模型张量编码器。原本用于播放8K视频的现成视频编解码硬件,其实压缩AI模型数据的效率也非常高,甚至超过了许多专门为AI开发的方案。该工作已被世界微架构大会MICRO-2025正式接收,相关成果将于今年10月在首尔进行展示与讨论。

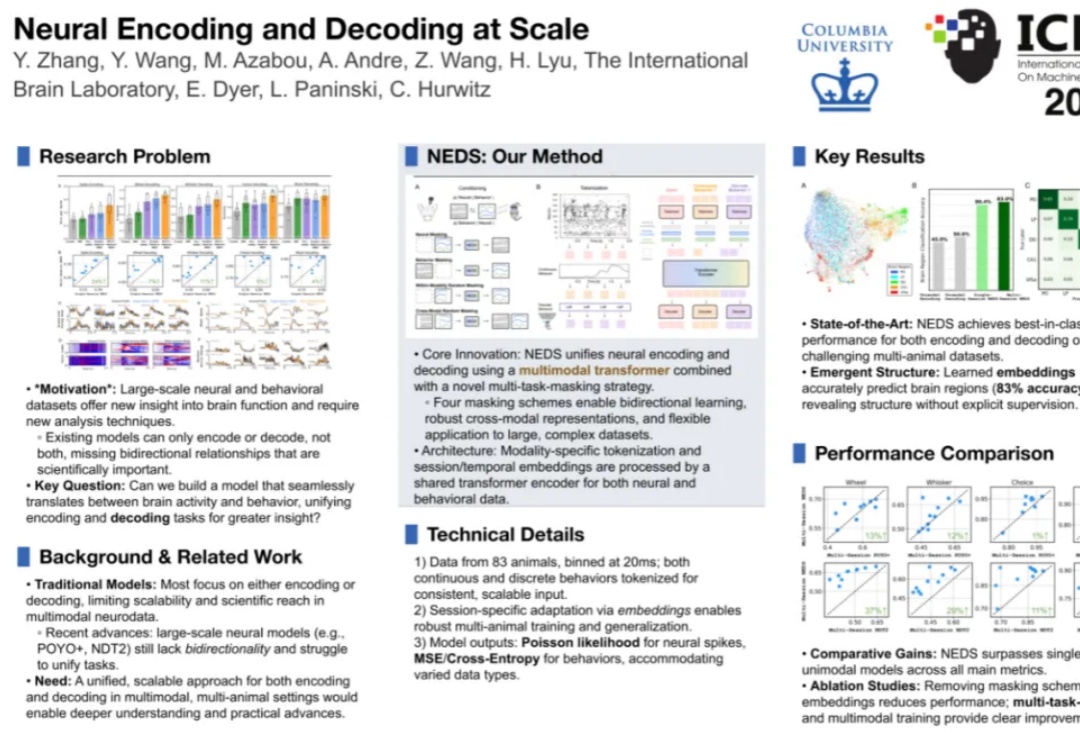

许多研究者在参加学术会议前,常常会因为制作海报所耗费的大量时间和精力而感到困扰。一张精心设计的海报是高效的学术交流媒介,但现有自动化方法普遍忽略了核心设计原则,导致生成的海报仍旧需要大量人工调整。

9 月 3 日,OpenAI 发布了一份关键的《在 AI 时代保持领先:领导力指南》。该报告总结了该公司与一系列全球大型知名企业合作的经验,这些企业包括制药巨头 Moderna、化妆品巨头雅诗兰黛、Notion 以及跨国银行 / 金融服务公司 BBVA,最终得到了从战略到治理的五大核心原则。

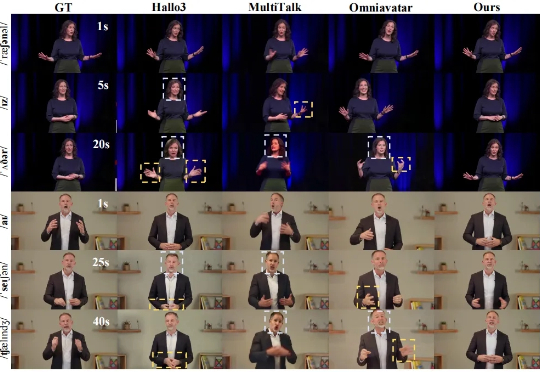

随着内容创作智能化需求的爆发,长时长、高质量数字人视频生成始终是行业痛点。近日,字节跳动商业化 GenAI 团队联合浙江大学推出商用级长时序音频驱动人物视频生成模型 ——InfinityHuman,打破传统音频驱动技术在长视频场景中的局限性,开启 AI 数字人实用化新征程

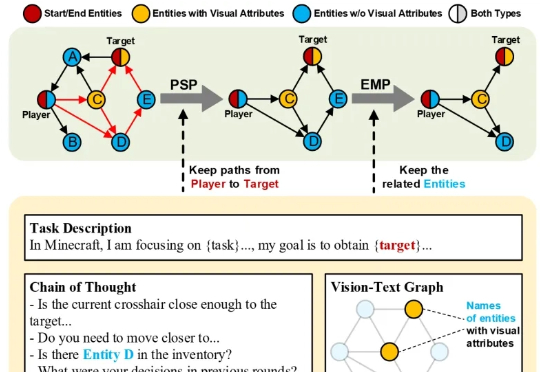

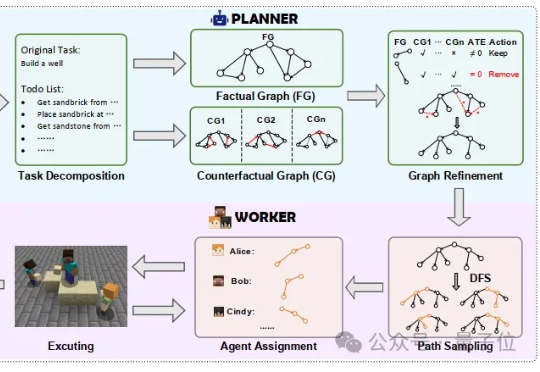

在大多数人眼中,《我的世界》(Minecraft)只是一款自由度极高的沙盒游戏。 而在香港科技大学(广州)与腾讯联合团队的眼中,它却是一座可以演练通用人工智能的“数字练兵场”。

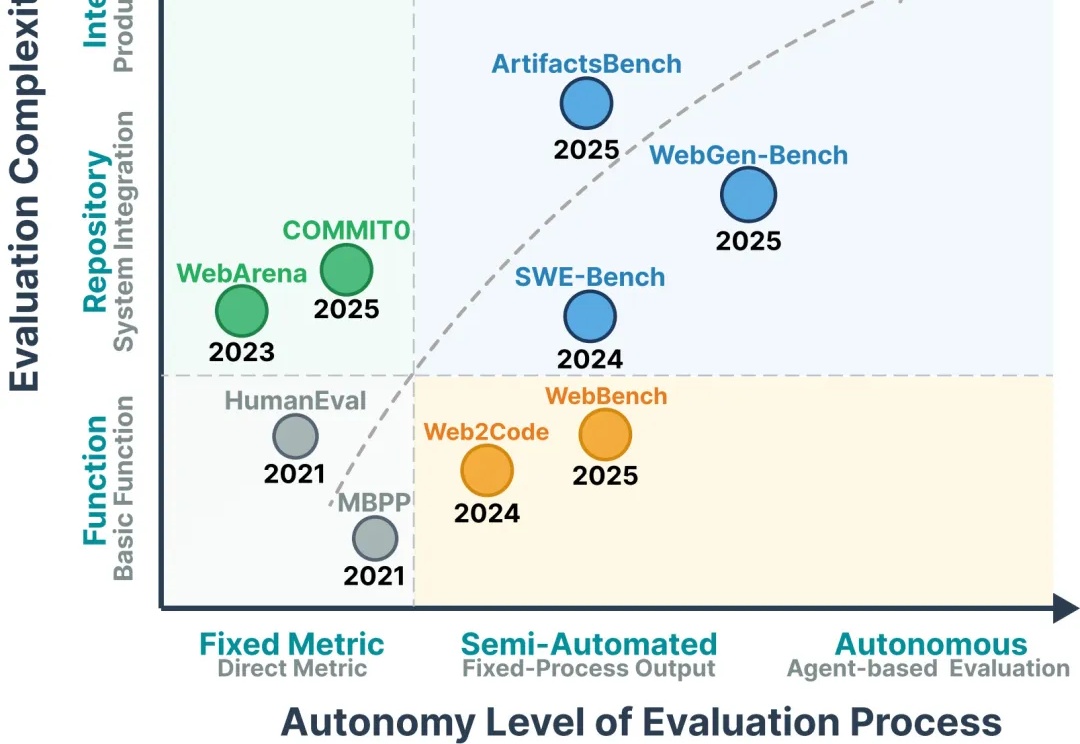

当你刚用 AI 生成了一个精美的电商网站,却在演示时购物车结账功能存在隐藏 Bug?

你有没有想过,软件商业模式可能正在经历五十年来最大的变革?当我看到 Cursor、Claude Code、Lovable 这些 AI 编程工具的出现,以及它们正在以惊人的速度降低软件开发成本时,我意识到我们正站在一个历史转折点上。这不仅仅是开发效率的提升,而是整个软件行业商业逻辑的根本性重构。

Nano banana正火爆全球,谷歌立马推出官方提示词指南。

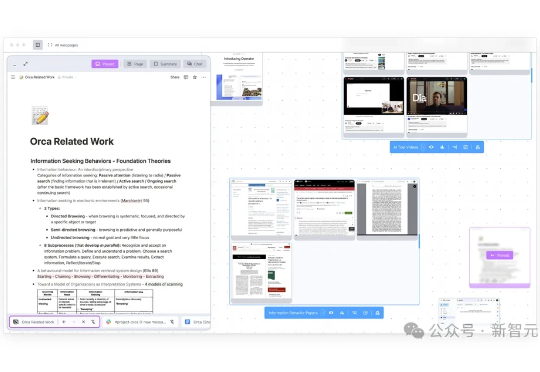

加州大学最新推出Orca浏览器,把拥挤标签页变成可随意拖拽、并排比较的无限画布,让AI替你同时点按钮、填表单。你只需像指挥家一样扫一眼全局、下指令,就能让上百个网页和智能体自动完成搜索、整理、汇总,全程可控。

今年是人工智能正式被提出七十周年,新智元十周年峰会也将于9月7日在北京中关村软件园举行,主题是「新天终启,万象智生」。此次峰会将发布《2025新智元ASI前沿趋势报告》,大会集结百度CTO、NVIDIA副总裁等十位领航者,以「十人十题」解构AI五阶段路线图,纵贯大模型、Physical AI、具身智能到医疗AI、视频AI、脑科学、AI Agent与人才培养,定义下个十年智能图景。

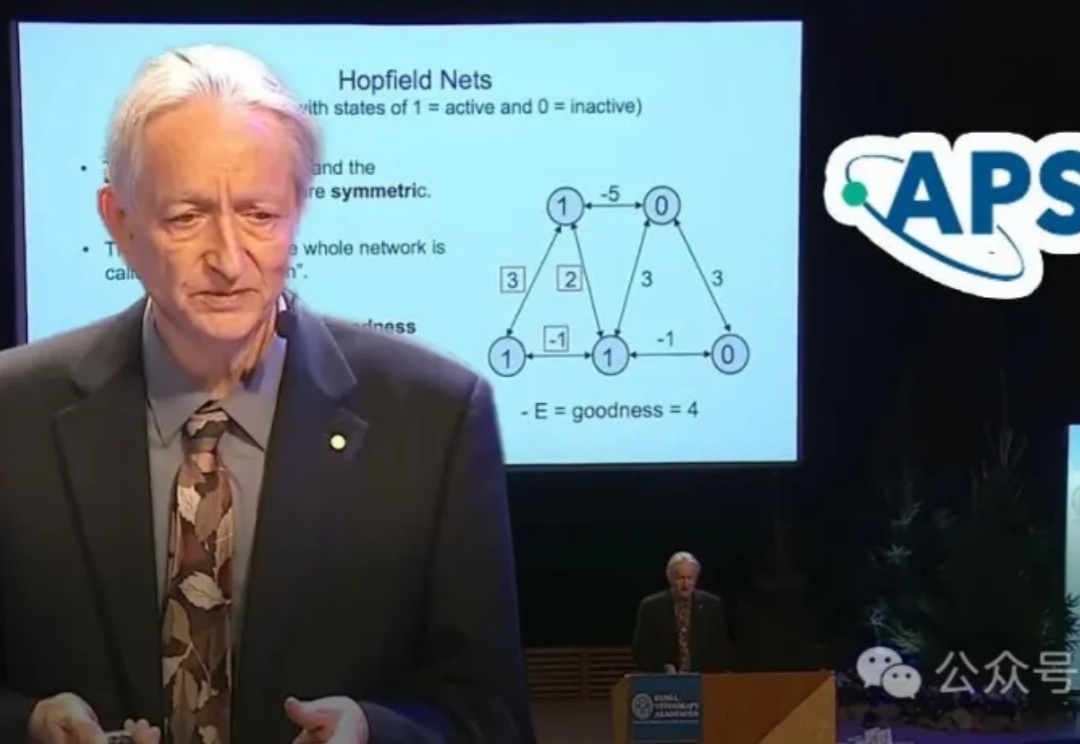

AI教父Hinton荣膺诺贝尔奖,可谓是实至名归。如今,他发表的「玻尔兹曼机」震撼演讲,已登上APS期刊。这一曾催化深度学习革命的「历史酶」,究竟讲了什么?

在长周期、多步骤的协作任务中,传统单智能体往往面临着任务成功率随步骤长度快速衰减,错误级联导致容错率极低等问题。

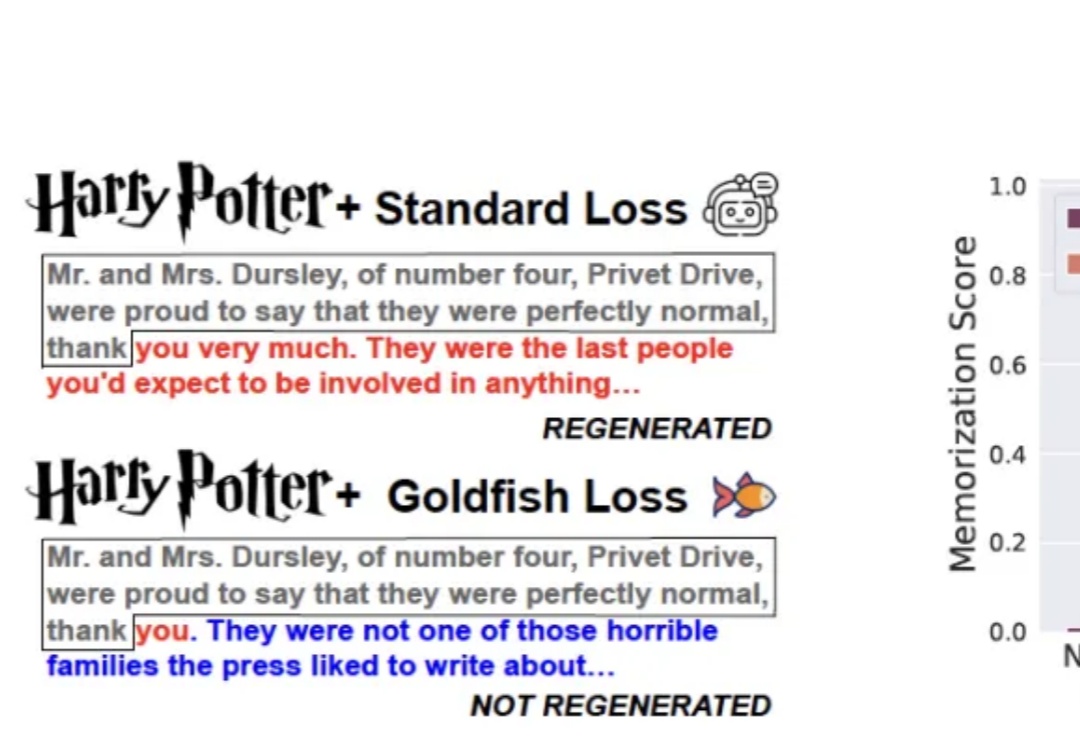

训练大模型时,有时让它“记性差一点”,反而更聪明!

腾讯混元,刚刚又拿下一个国际冠军—— Hunyuan-MT-7B,以7B总参数量获得国际翻译比赛冠军。该模型支持33个语种、5种民汉语言/方言互译,是一个能力全面的轻量级翻译模型。

nano banana爆火!网上看到的那些超强效果图是如何生成的呢?谷歌的官方Prompt模板终于来了!赶紧先收藏再说!

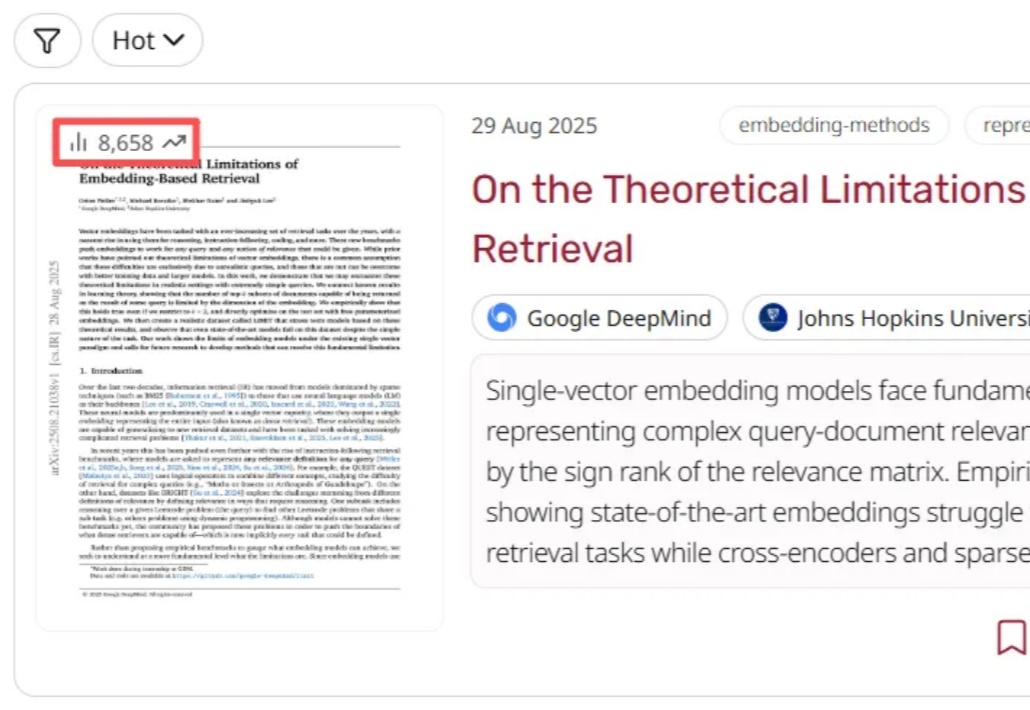

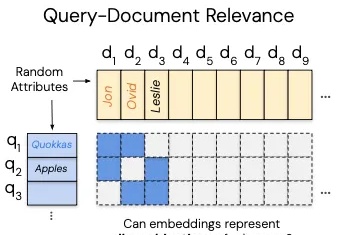

这几天,一篇关于向量嵌入(Vector Embeddings)局限性的论文在 AlphaXiv 上爆火,热度飙升到了近 9000。

在这场以大型语言模型(LLM)为核心的 AI 浪潮中,苹果似乎一直保持着低调,很少出现在技术报道的前沿。尽管如此,时不时地,该公司也能拿出一些非常亮眼的研究成果,比如能在 iPhone 上直接运行的高效视觉语言模型 FastVLM。

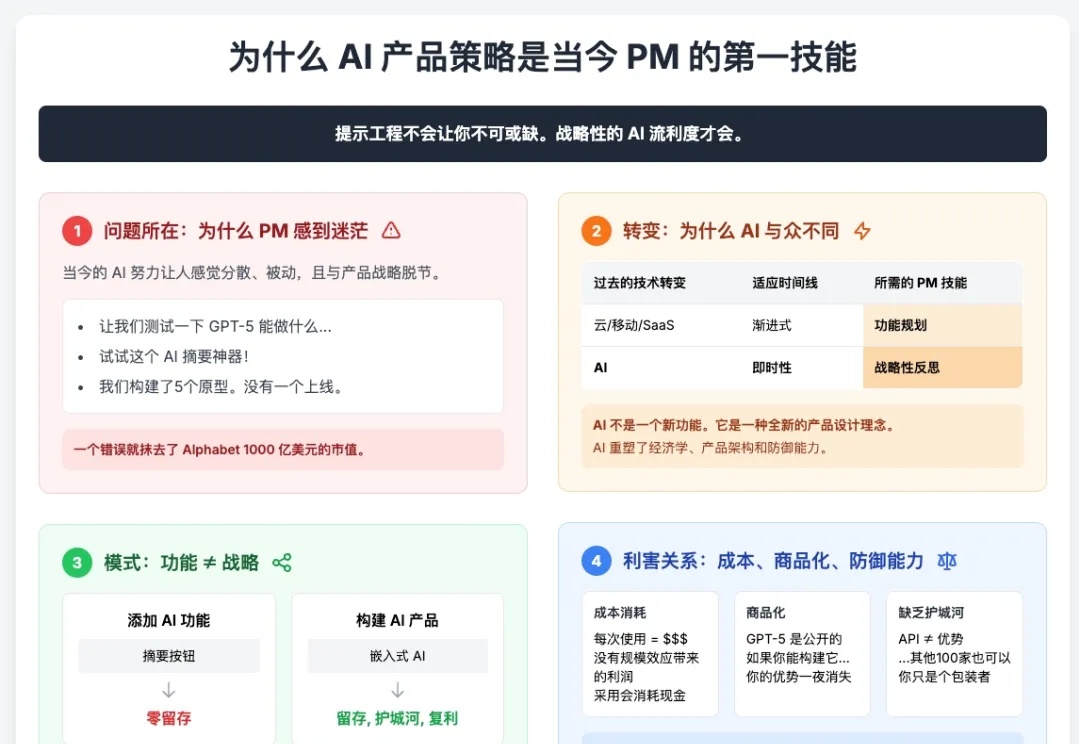

AI 产品经理,和我们所熟知的 PC、App 时代的产品经理完全不一样。

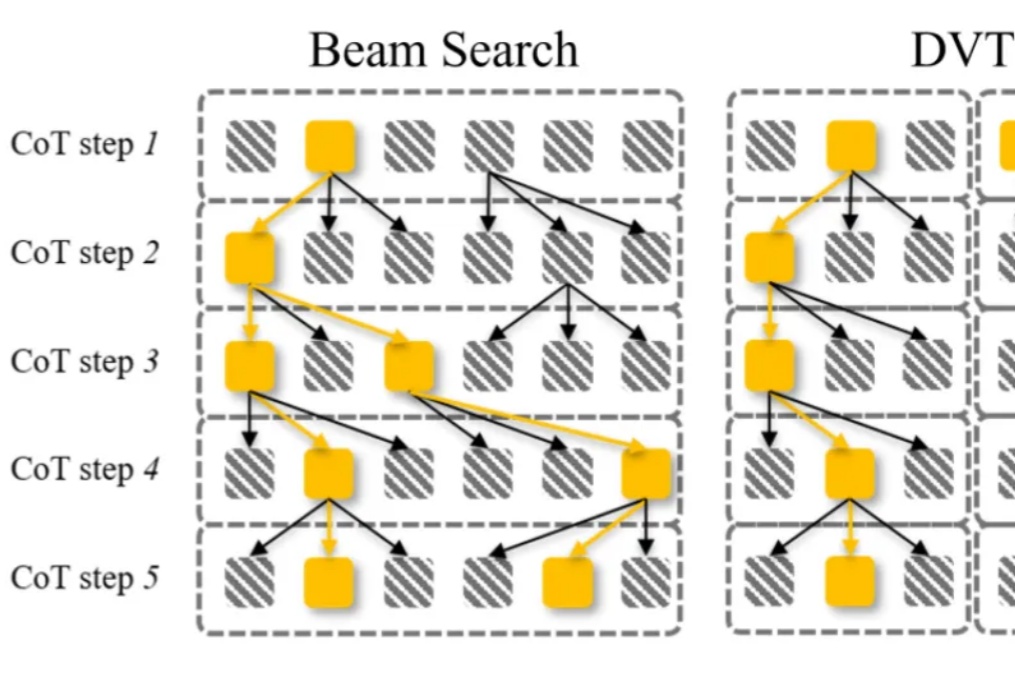

大语言模型通过 CoT 已具备强大的数学推理能力,而 Beam Search、DVTS 等测试时扩展(Test-Time Scaling, TTS)方法可通过分配额外计算资源进一步提升准确性。然而,现有方法存在两大关键缺陷:路径同质化(推理路径趋同)和中间结果利用不足(大量高质量推理分支被丢弃)。

最近,工业界“RAG已死”甚嚣尘上。过去几年,AI领域的主旋律是“规模定律”(Scaling Law),即更大的模型、更多的数据会带来更好的性能。即便偶然有瑕疵,也认为只是工程上的不足,并非数学上的不可能。

国内外开发者:亲测,美团新开源的模型速度超快!

随着DeepSeek R1、Kimi K2和DeepSeek V3.1混合专家(MoE)模型的相继发布,它们已成为智能前沿领域大语言模型(LLM)的领先架构。由于其庞大的规模(1万亿参数及以上)和稀疏计算模式(每个token仅激活部分参数而非整个模型),MoE式LLM对推理工作负载提出了重大挑战,显著改变了底层的推理经济学。

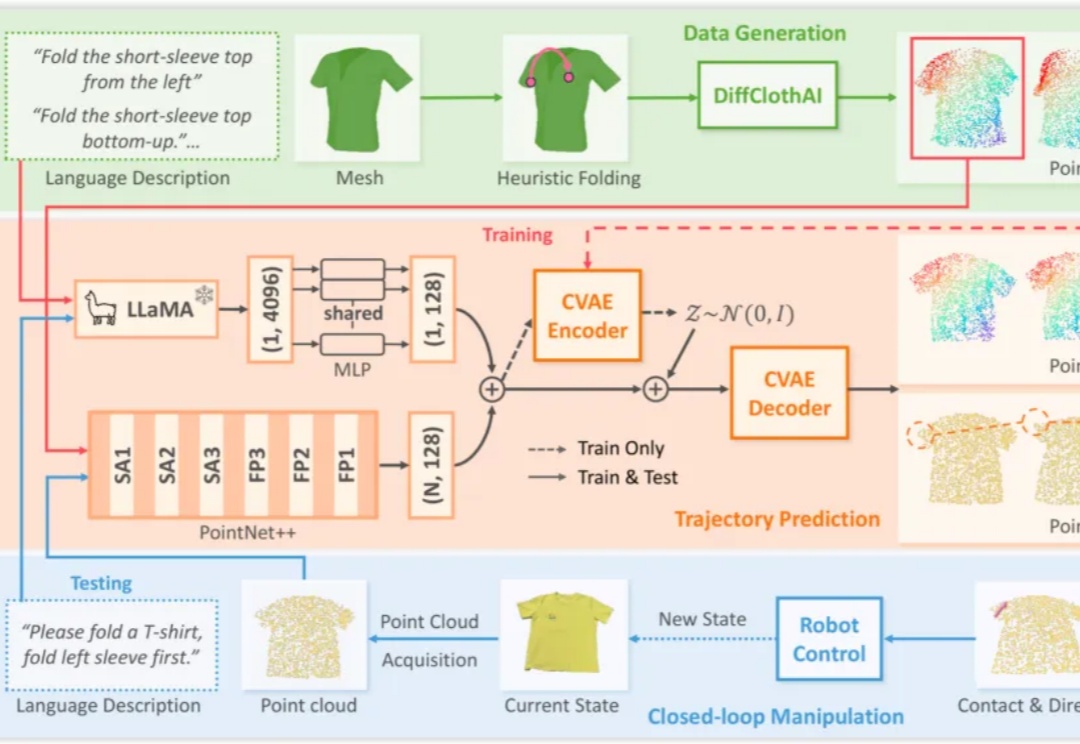

机器人对可形变物体的操作(Deformable Object Manipulation, DOM),是衡量通用机器人智能水平的关键指标之一。与刚体操作不同,衣物、绳索、食物等物体的形态不固定,其状态空间维度极高,且物理交互过程呈现出复杂的非线性动力学特性,为感知、规划和控制带来了巨大挑战。

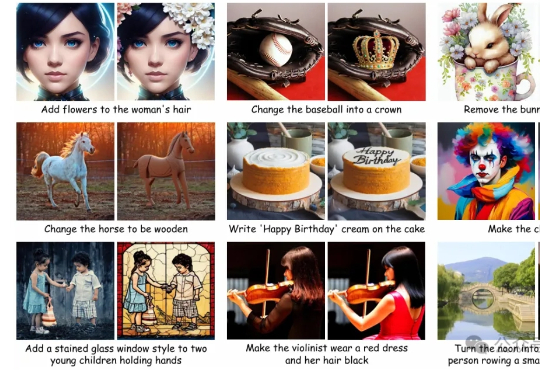

AI图像编辑技术发展迅猛,扩散模型凭借强大的生成能力,成为行业主流。 但这类模型在实际应用中始终面临两大难题:一是“牵一发而动全身”,即便只想修改一个细节,系统也可能影响到整个画面;二是生成速度缓慢,难以满足实时交互的需求。