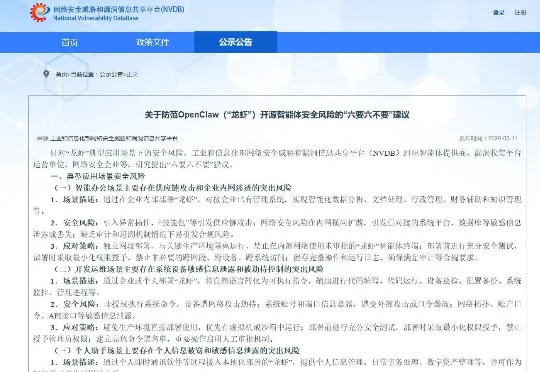

工信部发布《关于防范OpenClaw(“龙虾”)开源智能体安全风险的“六要六不要”建议》

工信部发布《关于防范OpenClaw(“龙虾”)开源智能体安全风险的“六要六不要”建议》针对“龙虾”典型应用场景下的安全风险,工业和信息化部网络安全威胁和漏洞信息共享平台(NVDB)组织智能体提供商、漏洞收集平台运营单位、网络安全企业等,研究提出“六要六不要”建议。

针对“龙虾”典型应用场景下的安全风险,工业和信息化部网络安全威胁和漏洞信息共享平台(NVDB)组织智能体提供商、漏洞收集平台运营单位、网络安全企业等,研究提出“六要六不要”建议。

Ben在视频中提到了一个令人震惊的数据对比。虽然ChatGPT的使用率在飞速增长,企业也在疯狂尝试各种AI解决方案,但真正能看到商业价值的却少之又少。根据MIT的研究,在供应商销售的AI解决方案中,只有5%的试点项目最终进入了生产环境。Deloitte(德勤)发现只有15%的组织表示他们从AI中获得了显著的、可衡量的ROI。

今天刷到一张梗图,逗得我嘎嘎乐:

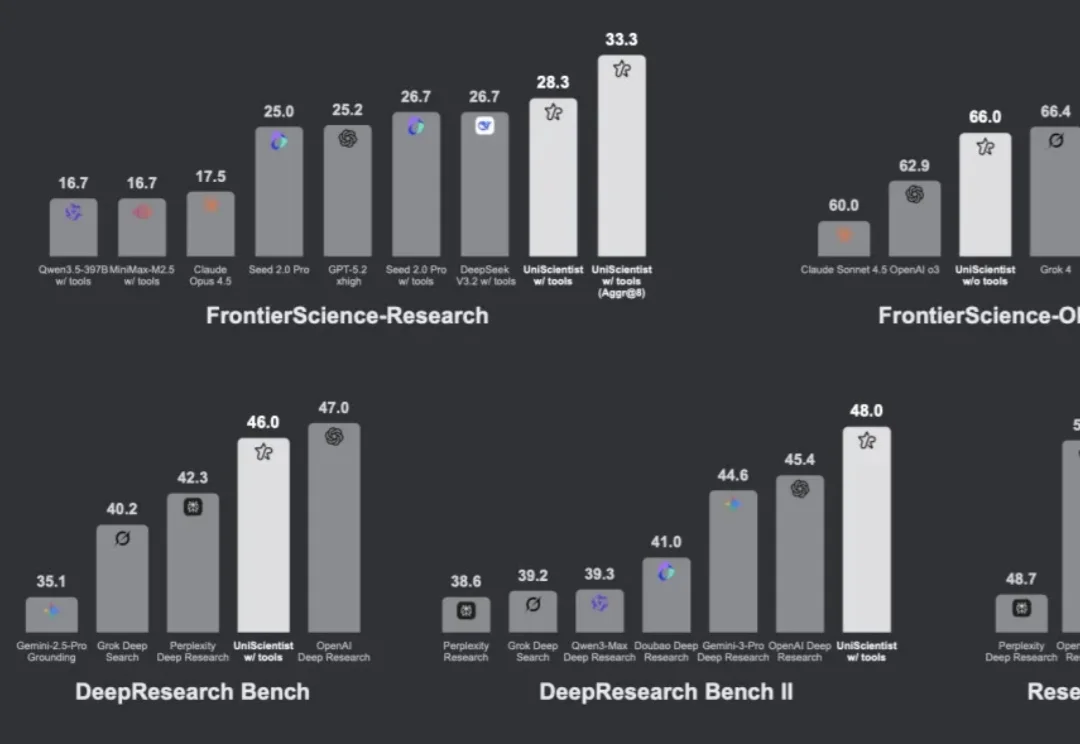

硅谷投资圈惊呼,科技研究领域的谷歌地图来了!几乎一夜间,海外社交平台上的科技投资人、科学家都在聊它!

最近在研究 OpenClaw,这个工具的火热程度不用再赘述。

3 月 10 日,APPSO 中文独家获悉,世界模型研究所/创业公司 AMI 已完成 10.3 亿美元融资,投前估值 35 亿美元。该公司由图灵奖得主、前 Meta 首席 AI 科学家杨立昆 (Yann LeCun) 创办。

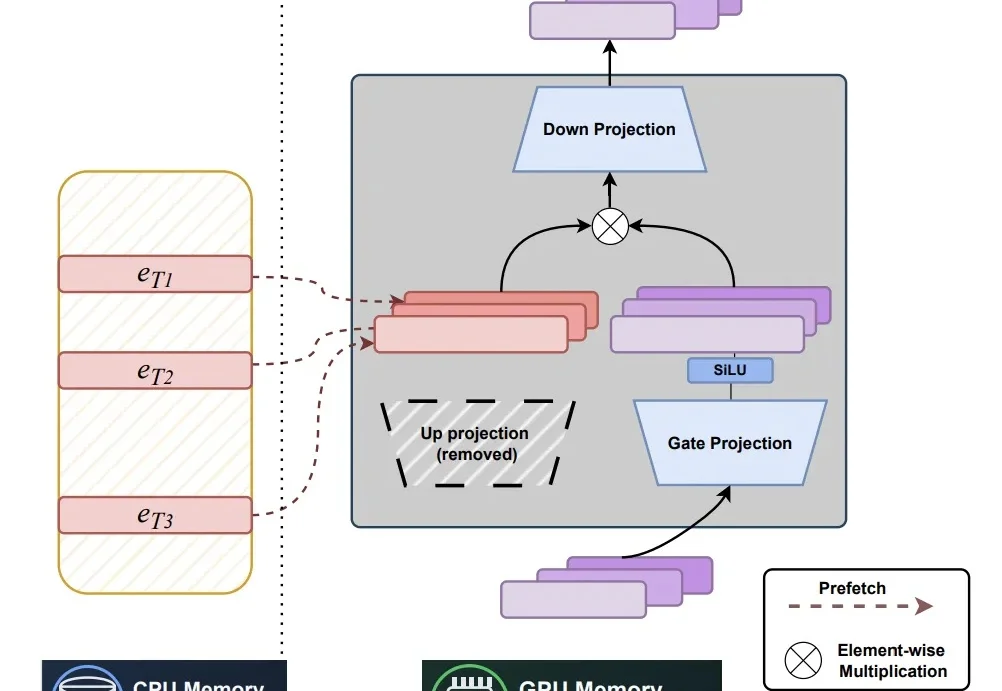

近年来,随着大语言模型规模与知识密度不断提升,研究者开始重新思考一个更本质的问题:模型中的参数应如何被组织,才能更高效地充当「记忆」。

OpenAI的最新研究揭示了一个反直觉的真相:越强大的推理模型,越管不住自己的「脑子」。在CoT-Control套件测试的13款前沿模型中,DeepSeek R1控制自身思维链的成功率仅为0.1%,Claude Sonnet 4.5也只有2.7%。

国内首个聚焦家庭通用机器人的公司——未来不远,再次宣布完成新一轮数亿元融资。除了持续进入更多真实家庭实现 C 端商业化,团队还会持续在基础研究和前沿探索加大人才和资金投入。

多数大模型能生成 “看起来像” 研究的文本,但极少数能真正做研究 —— 提出假设、收集证据、执行可复现的推导、迭代验证直至结论成立。