CUDA要凉?Claude 30分钟铲平英伟达护城河,AMD要笑醒了

CUDA要凉?Claude 30分钟铲平英伟达护城河,AMD要笑醒了英伟达护城河要守不住了?Claude Code半小时编程,直接把CUDA后端迁移到AMD ROCm上了。 一夜之间,CUDA护城河被AI终结了? 这几天,一位开发者johnnytshi在Reddit上分享了一个令人震惊的操作:

英伟达护城河要守不住了?Claude Code半小时编程,直接把CUDA后端迁移到AMD ROCm上了。 一夜之间,CUDA护城河被AI终结了? 这几天,一位开发者johnnytshi在Reddit上分享了一个令人震惊的操作:

刚刚,马斯克丢了个重磅炸弹:「AI5 芯片设计进展顺利,特斯拉将重启 Dojo3 的工作。」

马斯克官宣,全球首个吉瓦级超算Colossus 2正式上线,狂堆55万块GPU,目标直指百万。下一代Grok 5已在训练,6万亿参数将引爆智能奇点。

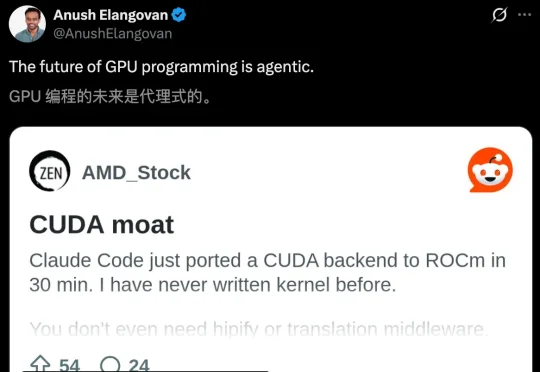

在2026年CES的舞台上,英伟达几乎重写了「PC能力边界」的定义。从DLSS 4.5把实时画质推向「天花板」,到RTX Remix让经典游戏获得重生,再到AI PC逐步走向日常生产力。

“卡买回来了,然后呢?”

据外媒报道,即将在2026年第一季度批准进口H200显卡。

预测到次贷危机的「大空头」Michael Burry看到数万亿美元涌入AI基础设施,产生深深的怀疑。他预言:英伟达的优势并不持久,可能很快就会被对手战胜。而且,如今全球AI算力已经达到1500万H100 GPU当量,即将引爆严重能源危机!

目前最新的消费级 GPU,还是去年在 CES 上正式发布的 RTX 50 系列。其中必然有内存全球大涨价的原因,当前市场的内存成本,一周之内就能涨价 50%-100%,并且多个分析机构表示,涨价会持续到 2027 年。

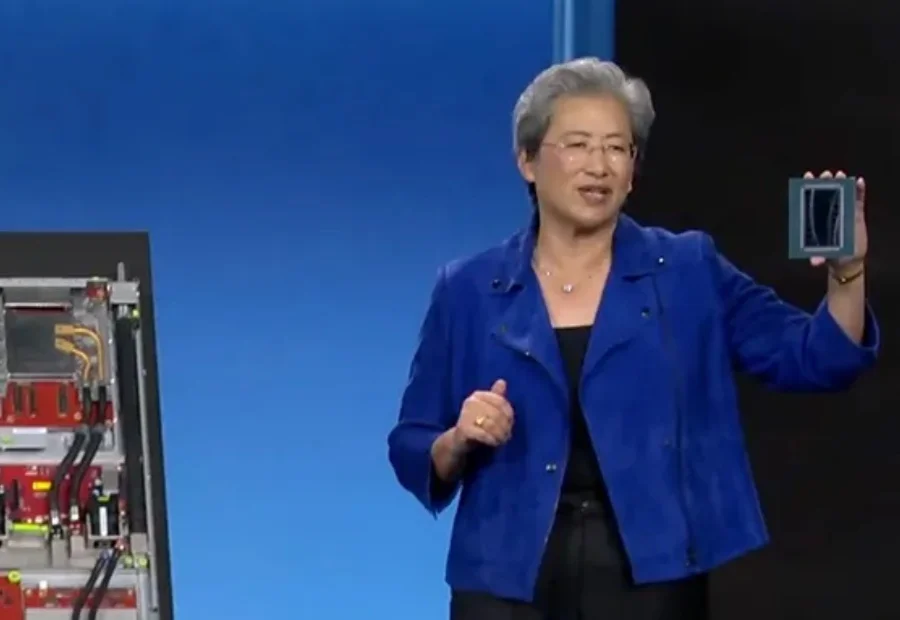

AMD公布未来两年芯片路线图。

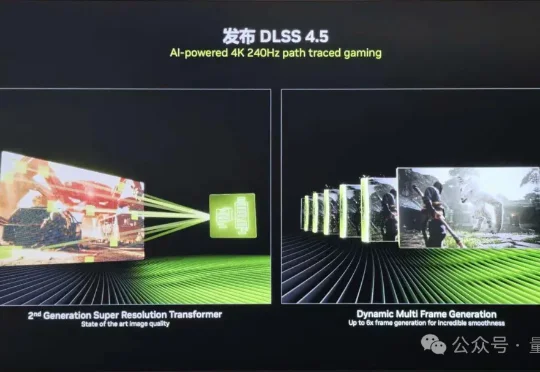

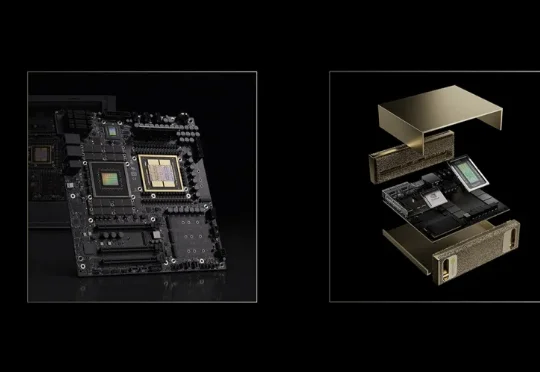

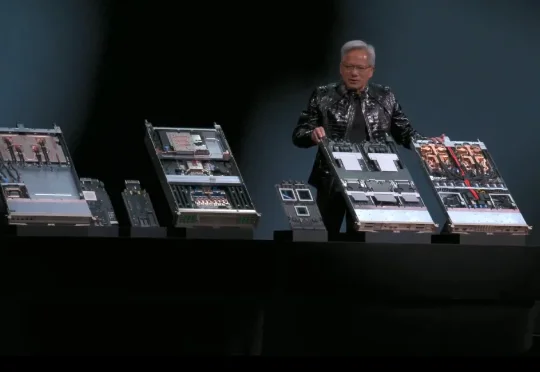

北京时间 1 月 6 日凌晨 5 点多,英伟达创始人兼 CEO 黄仁勋在 CES 2026 发表了主题演讲,演讲核心只有几个字——物理 AI。期间有一页 PPT 暂时没展示出来,他自嘲道演讲场地在拉斯维加斯所以应该是有人中了头奖导致的。期间,他和两台小机器人的互动,成为了本次演讲的名场面之一。